News und Artikel durchsuchen

{{#data.error.root_cause}}

{{/data.error}}

{{^data.error}}

{{#texts.summary}}

[{{{type}}}] {{{reason}}}

{{/data.error.root_cause}}{{texts.summary}} {{#options.result.rssIcon}} RSS {{/options.result.rssIcon}}

{{/texts.summary}} {{#data.hits.hits}}

{{#_source.featured}}

FEATURED

{{/_source.featured}}

{{#_source.showImage}}

{{#_source.image}}

{{/_source.image}}

{{/_source.showImage}}

{{/data.hits.hits}}

{{{_source.title}}} {{#_source.showPrice}} {{{_source.displayPrice}}} {{/_source.showPrice}}

{{#_source.showLink}} {{/_source.showLink}} {{#_source.showDate}}{{{_source.displayDate}}}

{{/_source.showDate}}{{{_source.description}}}

{{#_source.additionalInfo}}{{#_source.additionalFields}} {{#title}} {{{label}}}: {{{title}}} {{/title}} {{/_source.additionalFields}}

{{/_source.additionalInfo}}

AI

-

Pixar-Lampe trifft KI-PC: Lenovos AI Workmate Concept denkt lokal und projiziert auf den Tisch

Auf dem Mobile World Congress 2026 in Barcelona hat Lenovo neben Laptops und Tablets sowie verschiedenen Konzeptgeräten auch das wohl ungewöhnlichste Gerät der Messe präsentiert: das AI Workmate Concept. Dabei handelt es sich um einen kleinen Tischroboter mit animierten Augen, einem eingebauten Projektor und der Rechenleistung eines vollwertigen PCs, der als immer eingeschalteter KI-Assistent auf dem Schreibtisch sitzt. Das Gerät ist... [mehr]

Auf dem Mobile World Congress 2026 in Barcelona hat Lenovo neben Laptops und Tablets sowie verschiedenen Konzeptgeräten auch das wohl ungewöhnlichste Gerät der Messe präsentiert: das AI Workmate Concept. Dabei handelt es sich um einen kleinen Tischroboter mit animierten Augen, einem eingebauten Projektor und der Rechenleistung eines vollwertigen PCs, der als immer eingeschalteter KI-Assistent auf dem Schreibtisch sitzt. Das Gerät ist... [mehr] -

Milliardenschwere KI-Partnerschaft: Amazon und OpenAI verkünden strategische Partnerschaft

OpenAI und Amazon haben am Freitag eine weitreichende strategische Partnerschaft verkündet, deren Gesamtvolumen sich in einer Dimension bewegt, die selbst im Maßstab des KI-Booms beispiellos ist. Amazon investiert 50 Milliarden US-Dollar direkt in OpenAI – zunächst 15 Milliarden US-Dollar sofort, gefolgt von weiteren 35 Milliarden US-Dollar, sobald vertraglich vereinbarte Bedingungen erfüllt sind. Gleichzeitig erweitern OpenAI und Amazon Web... [mehr]

OpenAI und Amazon haben am Freitag eine weitreichende strategische Partnerschaft verkündet, deren Gesamtvolumen sich in einer Dimension bewegt, die selbst im Maßstab des KI-Booms beispiellos ist. Amazon investiert 50 Milliarden US-Dollar direkt in OpenAI – zunächst 15 Milliarden US-Dollar sofort, gefolgt von weiteren 35 Milliarden US-Dollar, sobald vertraglich vereinbarte Bedingungen erfüllt sind. Gleichzeitig erweitern OpenAI und Amazon Web... [mehr] -

KI-Boom und Speicherknappheit: DRAM-Markt wächst um fast 30 Prozent

Trotz oder gerade wegen des KI-Hypes und der Engpässe bei Speicher ist der globale DRAM-Markt im vierten Quartal 2025 stark gewachsen. Das geht aus dem neusten Marktforschungsbericht von TrendForce hervor. Demnach belief sich der Gesamtumsatz der DRAM-Branche im letzten Jahresviertel 2025 auf 53,578 Milliarden US-Dollar – ein Plus von 29,4 % gegenüber dem dritten Quartal 2025, welches bereits mit ca. 41,399 Milliarden US-Dollar ebenfalls... [mehr]

Trotz oder gerade wegen des KI-Hypes und der Engpässe bei Speicher ist der globale DRAM-Markt im vierten Quartal 2025 stark gewachsen. Das geht aus dem neusten Marktforschungsbericht von TrendForce hervor. Demnach belief sich der Gesamtumsatz der DRAM-Branche im letzten Jahresviertel 2025 auf 53,578 Milliarden US-Dollar – ein Plus von 29,4 % gegenüber dem dritten Quartal 2025, welches bereits mit ca. 41,399 Milliarden US-Dollar ebenfalls... [mehr] -

KI statt Redaktion: Metacritic löscht mutmaßlich gefälschtes Review zu Resident Evil Requiem

Der KI-Hype fordert immer mehr Tribut. Nachdem zunächst Lieferengpässe für drastisch gestiegene Hardwarepreise sorgten, Unternehmen, deren Geschäftsmodell vermeintlich durch KI ersetzt werden kann, an der Börse abgestraft wurden und mit Block die erste Branchengröße fast die Hälfte ihrer Belegschaft ersetzen wird, machen sich wenig überraschend entsprechend generierte Inhalte auch im Journalismus breit. Nach Recherchen von Kotaku... [mehr]

Der KI-Hype fordert immer mehr Tribut. Nachdem zunächst Lieferengpässe für drastisch gestiegene Hardwarepreise sorgten, Unternehmen, deren Geschäftsmodell vermeintlich durch KI ersetzt werden kann, an der Börse abgestraft wurden und mit Block die erste Branchengröße fast die Hälfte ihrer Belegschaft ersetzen wird, machen sich wenig überraschend entsprechend generierte Inhalte auch im Journalismus breit. Nach Recherchen von Kotaku... [mehr] -

Jack Dorsey halbiert Block: KI macht über 4.000 Mitarbeiter überflüssig

Der KI-Hype sorgt nicht nur für Engpässe bei Hardware und Speicher und treibt damit vor allem die Preise, sondern lässt auch ganze Unternehmen an den Börsen abstürzen, wie zuletzt IBM oder Duolingo. Dass dabei auch der eine oder andere Job ersetzt werden würde, war eigentlich nur eine Frage der Zeit. Beim Zahlungsdienstleister Block fallen jetzt weltweit über 40 % der Stellen weg und werden durch KI ersetzt. Das gab Jack Dorsey,... [mehr]

Der KI-Hype sorgt nicht nur für Engpässe bei Hardware und Speicher und treibt damit vor allem die Preise, sondern lässt auch ganze Unternehmen an den Börsen abstürzen, wie zuletzt IBM oder Duolingo. Dass dabei auch der eine oder andere Job ersetzt werden würde, war eigentlich nur eine Frage der Zeit. Beim Zahlungsdienstleister Block fallen jetzt weltweit über 40 % der Stellen weg und werden durch KI ersetzt. Das gab Jack Dorsey,... [mehr] -

Alternative zu Openclaw: Multi-Agenten-Framework Perplexity Computer angekündigt

Perplexity AI hat am Mittwochabend mit Perplexity Computer überraschend eine Vielzahl neuer Funktionen vorgestellt, die für komplexe Workflows und mit einer Vielzahl spezialisierter KI-Modelle auf sich aufmerksam macht und unter anderem in Konkurrenz zu Openclaw treten dürfte. Dabei handelt es sich nicht um einen weiteren KI-Chatbot, dem man Fragen stellt und Antworten erhält. Stattdessen arbeitet das System eigenständig – es... [mehr]

Perplexity AI hat am Mittwochabend mit Perplexity Computer überraschend eine Vielzahl neuer Funktionen vorgestellt, die für komplexe Workflows und mit einer Vielzahl spezialisierter KI-Modelle auf sich aufmerksam macht und unter anderem in Konkurrenz zu Openclaw treten dürfte. Dabei handelt es sich nicht um einen weiteren KI-Chatbot, dem man Fragen stellt und Antworten erhält. Stattdessen arbeitet das System eigenständig – es... [mehr] -

Millionen Blackwell- und Rubin-GPUs: Meta bestellt im Milliardenwert AI-Infrastruktur bei NVIDIA

Meta, der Mutterkonzern hinter Facebook, Instagram und WhatsApp, hat den Kauf von Millionen von KI-Beschleunigern von NVIDIA angekündigt. Über die genaue Anzahl oder den finanziellen Umfang der Kooperation machen Meta und NVIDIA keinerlei Angaben. Laut Reuters könnte der Deal einen Umfang von 50 Milliarden US-Dollar umfassen. Die Partnerschaft wird über mehrere Jahre laufen und umfasst die aktuelle Blackwell-Generation ebenso wie die... [mehr]

Meta, der Mutterkonzern hinter Facebook, Instagram und WhatsApp, hat den Kauf von Millionen von KI-Beschleunigern von NVIDIA angekündigt. Über die genaue Anzahl oder den finanziellen Umfang der Kooperation machen Meta und NVIDIA keinerlei Angaben. Laut Reuters könnte der Deal einen Umfang von 50 Milliarden US-Dollar umfassen. Die Partnerschaft wird über mehrere Jahre laufen und umfasst die aktuelle Blackwell-Generation ebenso wie die... [mehr] -

ChatGPT: OpenAI startet Werbeeinblendungen für Free- und Go-Nutzer

OpenAI wird in ChatGPT künftig Werbung einblenden und beginnt damit bei Nutzern der kostenlosen Variante sowie des erst Mitte Januar eingeführten und günstigeren Abotarifs ChatGPT Go. Zunächst startet der Testlauf in den USA. Dort sollen Nutzer in beiden Tarifen bei passenden Suchanfragen erste Anzeigen ausgespielt bekommen. Bislang setzte OpenAI zur Monetarisierung vorwiegend auf Abo-Modelle wie Plus-, Pro-, Business- oder... [mehr]

OpenAI wird in ChatGPT künftig Werbung einblenden und beginnt damit bei Nutzern der kostenlosen Variante sowie des erst Mitte Januar eingeführten und günstigeren Abotarifs ChatGPT Go. Zunächst startet der Testlauf in den USA. Dort sollen Nutzer in beiden Tarifen bei passenden Suchanfragen erste Anzeigen ausgespielt bekommen. Bislang setzte OpenAI zur Monetarisierung vorwiegend auf Abo-Modelle wie Plus-, Pro-, Business- oder... [mehr] -

AORUS AI Box: Externe Thunderbolt-GPUs starten ab 800 Euro in den Markt

Die AORUS RTX 5090 AI BOX und die AORUS RTX 5060 Ti AI BOX wurden bereits zur Computex 2025 im Juni angekündigt, starten nun aber offiziell in den deutschen Markt. Als externe GPU-Lösungen zielen sie vorrangig auf Nutzer von Ultrabooks und Mini-PCs ab, die Desktop-Leistung für ihren Schreibtisch nachrüsten wollen. Die kompaktere AORUS RTX 5060 Ti AI BOX wird hierzulande aktuell ab rund 806 Euro bei Amazon gelistet, bei anderen Händlern aus... [mehr]

Die AORUS RTX 5090 AI BOX und die AORUS RTX 5060 Ti AI BOX wurden bereits zur Computex 2025 im Juni angekündigt, starten nun aber offiziell in den deutschen Markt. Als externe GPU-Lösungen zielen sie vorrangig auf Nutzer von Ultrabooks und Mini-PCs ab, die Desktop-Leistung für ihren Schreibtisch nachrüsten wollen. Die kompaktere AORUS RTX 5060 Ti AI BOX wird hierzulande aktuell ab rund 806 Euro bei Amazon gelistet, bei anderen Händlern aus... [mehr] -

Spieleentwicklung mit KI: Project Genie

Mit einem knapp zwei Minuten langen Video hat Google internationale Gamesbranche und vor allem ihre Aktienmärkte deutlich erschüttert. Der Clip stellt das sogenannte Google Project Genie vor. Dabei handelt es sich um ein experimentelles KI-Tool der Google Labs. Vor allem die Branchengrößen hat es teilweise hart getroffen. Ironischerweise blieb Electronic Arts verschont, da eine Übernahme zum Festpreis ansteht. Roblox hat allerdings... [mehr]

Mit einem knapp zwei Minuten langen Video hat Google internationale Gamesbranche und vor allem ihre Aktienmärkte deutlich erschüttert. Der Clip stellt das sogenannte Google Project Genie vor. Dabei handelt es sich um ein experimentelles KI-Tool der Google Labs. Vor allem die Branchengrößen hat es teilweise hart getroffen. Ironischerweise blieb Electronic Arts verschont, da eine Übernahme zum Festpreis ansteht. Roblox hat allerdings... [mehr] -

Gereizte KI-Blase: NVIDIA, OpenAI, Oracle und Co. zeigen sich auffällig bemüht

In den vergangenen Tagen zeigten sich einige Zerwürfnisse oder womöglich auch nur Fehler in der Kommunikation und Informationen, die falsch interpretiert wurden. Aber es wird auch einmal mehr deutlich, wie empfindlich die Märkte und beteiligten Unternehmen sind, wenn die gewaltigen und gegenseitigen Investitionen hinterfragt werden. Wir wollen einmal versuchen, das Geschehene etwas besser einzuordnen. Bei seinem Besuch in Taiwan reagierte... [mehr]

In den vergangenen Tagen zeigten sich einige Zerwürfnisse oder womöglich auch nur Fehler in der Kommunikation und Informationen, die falsch interpretiert wurden. Aber es wird auch einmal mehr deutlich, wie empfindlich die Märkte und beteiligten Unternehmen sind, wenn die gewaltigen und gegenseitigen Investitionen hinterfragt werden. Wir wollen einmal versuchen, das Geschehene etwas besser einzuordnen. Bei seinem Besuch in Taiwan reagierte... [mehr] -

NPU für den Pi 5: Raspberry Pi AI HAT+ 2 angekündigt

Der Raspberry Pi 5 bekommt mit dem Raspberry Pi AI HAT+ 2 ein auf generative KI und moderne Edge-Anwendungen zugeschnittenes NPU-Upgrade, das den Einplatinenrechner leistungsmäßig in die Nähe aktueller KI-PC mit integrierter NPU rücken soll. Bis zu 40 TOPs und damit genug Reserven für Sprach-, Bild- und Mutimodal-Modelle soll die kleine Zusatzplatine bieten und damit deutlich mehr als das Vorgängermodell, welches bereits im Juni 2024... [mehr]

Der Raspberry Pi 5 bekommt mit dem Raspberry Pi AI HAT+ 2 ein auf generative KI und moderne Edge-Anwendungen zugeschnittenes NPU-Upgrade, das den Einplatinenrechner leistungsmäßig in die Nähe aktueller KI-PC mit integrierter NPU rücken soll. Bis zu 40 TOPs und damit genug Reserven für Sprach-, Bild- und Mutimodal-Modelle soll die kleine Zusatzplatine bieten und damit deutlich mehr als das Vorgängermodell, welches bereits im Juni 2024... [mehr] -

750 MW und 10 Milliarden US-Dollar: OpenAI und Cerebras verkünden Partnerschaft

OpenAI holt den nächsten Hardwarepartner ins Boot und verkündet nun auch mit Cerebras eine sogenannte strategische Partnerschaft. Diese umfasst eine Investitionssumme von 10 Milliarden US-Dollar und ein Installationsvolumen an Hardware mit einem Verbrauch von 750 MW. Mit Cerebras hat man damit den dritten Hardware-Partner im Bereich der KI-Beschleuniger. Die Vereinbarungen mit AMD und NVIDIA sind allerdings auch um Größenordnungen größer. So... [mehr]

OpenAI holt den nächsten Hardwarepartner ins Boot und verkündet nun auch mit Cerebras eine sogenannte strategische Partnerschaft. Diese umfasst eine Investitionssumme von 10 Milliarden US-Dollar und ein Installationsvolumen an Hardware mit einem Verbrauch von 750 MW. Mit Cerebras hat man damit den dritten Hardware-Partner im Bereich der KI-Beschleuniger. Die Vereinbarungen mit AMD und NVIDIA sind allerdings auch um Größenordnungen größer. So... [mehr] -

Dells Eingeständnis: Kunden kaufen nicht wegen KI-Funktionalität

Anhand der Reaktionen in den Kommentaren zeichnete sich für uns bereits folgendes Bild: Dedizierte KI-Hardware spielt für die allermeisten Hardwareluxx-Nutzer keinerlei Rolle. Kaufentscheidungen werden (noch) nicht anhand der TOPS von GPU und NPU gefällt. Und dennoch konzentrieren sich die Hardware-Hersteller in ihren Präsentationen und dem Marketing-Materie zu 95 % auf das Thema KI. Besonders auffällig war dies nun auch wieder in den Keynotes... [mehr]

Anhand der Reaktionen in den Kommentaren zeichnete sich für uns bereits folgendes Bild: Dedizierte KI-Hardware spielt für die allermeisten Hardwareluxx-Nutzer keinerlei Rolle. Kaufentscheidungen werden (noch) nicht anhand der TOPS von GPU und NPU gefällt. Und dennoch konzentrieren sich die Hardware-Hersteller in ihren Präsentationen und dem Marketing-Materie zu 95 % auf das Thema KI. Besonders auffällig war dies nun auch wieder in den Keynotes... [mehr] -

MSI-Displays auf der CES 2026: QD-OLED-Display mit AI-Support und 5K-Gaming

Mit dem MPG 341CQR QD-OLED X36 hat MSI auf der CES 2026 ein großformatiges Gaming-Display vorgestellt, das bereits auf der fünften QD-OLED-Generation basiert und dank des neuen RGB-Stripe-Layouts mit einer deutlich verbesserten Schriftdarstellung aufwarten soll. Natürlich hat MSI aber nicht nur ein neues Display mit nach Las Vegas gebracht. Es gibt ein neues MEG-Display, das KI-Funktionen und die neueste QD-OLED-Technik verbindet, aber... [mehr]

Mit dem MPG 341CQR QD-OLED X36 hat MSI auf der CES 2026 ein großformatiges Gaming-Display vorgestellt, das bereits auf der fünften QD-OLED-Generation basiert und dank des neuen RGB-Stripe-Layouts mit einer deutlich verbesserten Schriftdarstellung aufwarten soll. Natürlich hat MSI aber nicht nur ein neues Display mit nach Las Vegas gebracht. Es gibt ein neues MEG-Display, das KI-Funktionen und die neueste QD-OLED-Technik verbindet, aber... [mehr] -

Für 20 Milliarden US-Dollar: NVIDIA kauft Inference-Spezialisten Groq

Kurz vor Weihnachten machte sich NVIDIA den Inferencing-Spezialisten Groq selbst zum Geschenk gemacht und das Start-up für 20 Milliarden US-Dollar übernommen. Groq soll als Marke wohl unabhängig bleiben, wird aber dennoch nicht mehr als eine Hülle und ein Markenname bleiben, denn neben Groqs CEO Jonathan Ross sollen auch viele Mitarbeiter zu NVIDIA wechseln. Bisher gilt der Kauf des Netzwerk-Spezialisten Mellanox für etwa 7 Milliarden als... [mehr]

Kurz vor Weihnachten machte sich NVIDIA den Inferencing-Spezialisten Groq selbst zum Geschenk gemacht und das Start-up für 20 Milliarden US-Dollar übernommen. Groq soll als Marke wohl unabhängig bleiben, wird aber dennoch nicht mehr als eine Hülle und ein Markenname bleiben, denn neben Groqs CEO Jonathan Ross sollen auch viele Mitarbeiter zu NVIDIA wechseln. Bisher gilt der Kauf des Netzwerk-Spezialisten Mellanox für etwa 7 Milliarden als... [mehr] -

Offiziell komplett KI-generiert: Codex Mortis als Demo auf Steam erschienen

Aktuell ist der Einsatz von generativer KI in der Spieleentwicklung immer wieder ein heiß diskutiertes Thema. So hatten zuletzt sowohl Fortnite als auch Call of Duty mit dem Vorwurf zu kämpfen, KI ohne Kennzeichnung einzusetzen. Ein geplantes Spiel im Postal-Universum wurde ganz eingestellt, nachdem die Entwickler den Einsatz von KI zuerst geleugnet und dann doch zugegeben hatten. Ganz anders geht hier Codex Mortis vor. Der... [mehr]

Aktuell ist der Einsatz von generativer KI in der Spieleentwicklung immer wieder ein heiß diskutiertes Thema. So hatten zuletzt sowohl Fortnite als auch Call of Duty mit dem Vorwurf zu kämpfen, KI ohne Kennzeichnung einzusetzen. Ein geplantes Spiel im Postal-Universum wurde ganz eingestellt, nachdem die Entwickler den Einsatz von KI zuerst geleugnet und dann doch zugegeben hatten. Ganz anders geht hier Codex Mortis vor. Der... [mehr] -

Studioschließung nach KI-Eklat: Aus für Postal Bullet Paradise

Die Postal-Reihe lebt von jeher von Kontroversen. Das erste Spiel erschien schon 1997 und wurde in Deutschland indiziert. Das Schicksal betraf auch die beiden Nachfolger von 2003 und 2004. Ein vierter Teil erschien 2022. Während die Spiele von Running With Scissors entwickelt wurden, sollte bei dem neuesten Ableger der Reihe ein neues Studio namens Goonswarm Games für das Spiel verantwortlich sein. Running With Scissors wollte als Publisher... [mehr]

Die Postal-Reihe lebt von jeher von Kontroversen. Das erste Spiel erschien schon 1997 und wurde in Deutschland indiziert. Das Schicksal betraf auch die beiden Nachfolger von 2003 und 2004. Ein vierter Teil erschien 2022. Während die Spiele von Running With Scissors entwickelt wurden, sollte bei dem neuesten Ableger der Reihe ein neues Studio namens Goonswarm Games für das Spiel verantwortlich sein. Running With Scissors wollte als Publisher... [mehr] -

KI-Vorwürfe: Neue Fortnite-Season sorgt für Unmut

Nachdem zuletzt noch die Fortnitemares Einzug in den Shooter von Epic hielten, folgte mit den Simpsons eine Mini-Season. Auch diese ist nun vorbei und am 1. Dezember 2025 startete nicht nur eine neue Season, sondern auch das mittlerweile siebte Kapitel. Unter dem Namen Pacific Break führt dieses eine ganz neue Karte ein. Die Goldene Küste ist an die amerikanische Westküste angelehnt und bietet Sehenswürdigkeiten wie den Battlewood... [mehr]

Nachdem zuletzt noch die Fortnitemares Einzug in den Shooter von Epic hielten, folgte mit den Simpsons eine Mini-Season. Auch diese ist nun vorbei und am 1. Dezember 2025 startete nicht nur eine neue Season, sondern auch das mittlerweile siebte Kapitel. Unter dem Namen Pacific Break führt dieses eine ganz neue Karte ein. Die Goldene Küste ist an die amerikanische Westküste angelehnt und bietet Sehenswürdigkeiten wie den Battlewood... [mehr] -

China könnte das KI-Rennen gewinnen: NVIDIA baut politischen Druck auf

Trotz der Milliarden und Abermilliarden an US-Dollar, die aktuell in KI-Infrastruktur in den USA gesteckt werden, zeigt sich NVIDIAs CEO Jensen Huang skeptisch, dass die USA das Rennen gegen China gewinnen werden. Dabei spielen hier nun mehrere Aspekte eine Rolle: Aktuell kämpft NVIDIA mit den Behörden darum, dass man KI-Chips auf Basis der Blackwell-Architektur nach China exportieren darf. Dazu hat man angepasste Single-Die-Varianten mit nur... [mehr]

Trotz der Milliarden und Abermilliarden an US-Dollar, die aktuell in KI-Infrastruktur in den USA gesteckt werden, zeigt sich NVIDIAs CEO Jensen Huang skeptisch, dass die USA das Rennen gegen China gewinnen werden. Dabei spielen hier nun mehrere Aspekte eine Rolle: Aktuell kämpft NVIDIA mit den Behörden darum, dass man KI-Chips auf Basis der Blackwell-Architektur nach China exportieren darf. Dazu hat man angepasste Single-Die-Varianten mit nur... [mehr] -

KI erleben: Erster Intel Experience Store in München eröffnet

Intel hat am Donnerstag seinen ersten Experience Store in Deutschland im Erdgeschoss des Louis Hotel am Münchener Viktualienmarkt eröffnet. Es ist einer von fünf Pop-Up-Stores weltweit – in den kommenden Wochen werden auch in Paris, London, New York und Soul entsprechende Ladenflächen eröffnen. Das Konzept sieht allerdings kein klassisches Einzelhandelsgeschäft vor, sondern versteht sich als "Markenplattform im physischen Raum"... [mehr].

Intel hat am Donnerstag seinen ersten Experience Store in Deutschland im Erdgeschoss des Louis Hotel am Münchener Viktualienmarkt eröffnet. Es ist einer von fünf Pop-Up-Stores weltweit – in den kommenden Wochen werden auch in Paris, London, New York und Soul entsprechende Ladenflächen eröffnen. Das Konzept sieht allerdings kein klassisches Einzelhandelsgeschäft vor, sondern versteht sich als "Markenplattform im physischen Raum"... [mehr]. -

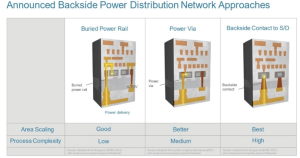

Für Feynman: NVIDIA soll erster Kunde für A16-Fertigung mit Backside-Power von TSMC sein

Das taiwanesische Branchenmagazin Commercial Times berichtet, dass NVIDIA mit dem KI-Chip der übernächsten Generation namens Feynman der erst Kunde von TSMC sein soll, der auf die Fertigung im A16-Prozess setzt. Dies stellt eine besondere Herausforderung dar, da die Chiphersteller für die allerneusten Prozesse üblicherweise auf deutlich kleinere Chips setzen. Ein Blick auf die aktuellen KI-Chips bei NVIDIA zeigt: Man nutzt auf die... [mehr]

Das taiwanesische Branchenmagazin Commercial Times berichtet, dass NVIDIA mit dem KI-Chip der übernächsten Generation namens Feynman der erst Kunde von TSMC sein soll, der auf die Fertigung im A16-Prozess setzt. Dies stellt eine besondere Herausforderung dar, da die Chiphersteller für die allerneusten Prozesse üblicherweise auf deutlich kleinere Chips setzen. Ein Blick auf die aktuellen KI-Chips bei NVIDIA zeigt: Man nutzt auf die... [mehr] -

Rackscale KI-Lösung: Qualcomm stellt AI200- und AI250-Hardware vor

Schon 2019 stellte Qualcomm seine erste dedizierte AI-Beschleunigerhardware vor. Die Cloud-AI-100-Hardware kam aber allenfalls im Edge-Segment zum Einsatz und spielt für den aktuellen KI-Hype quasi keinerlei Rolle. Nun hat Qualcomm nicht nur neue KI-Beschleuniger vorgestellt, sondern will diese ab dem kommenden Jahr auch gleich als komplette Rackscale-Lösung anbieten. AI200 lautet der Name einer ersten, neuen Generation auf... [mehr]

Schon 2019 stellte Qualcomm seine erste dedizierte AI-Beschleunigerhardware vor. Die Cloud-AI-100-Hardware kam aber allenfalls im Edge-Segment zum Einsatz und spielt für den aktuellen KI-Hype quasi keinerlei Rolle. Nun hat Qualcomm nicht nur neue KI-Beschleuniger vorgestellt, sondern will diese ab dem kommenden Jahr auch gleich als komplette Rackscale-Lösung anbieten. AI200 lautet der Name einer ersten, neuen Generation auf... [mehr] -

Es ist offiziell: OpenAI und Broadcom arbeiten für KI-Beschleuniger zusammen

OpenAI und Broadcom haben eine mehrjährige Zusammenarbeit angekündigt, die unter anderem die Bereitstellung und Entwicklung von eigens entwickelten KI-Beschleunigern beinhaltet. Bereits mehrfach wurden Berichte öffentlich, die besagten, dass OpenAI an Broadcom herangetreten ist, um dort seinen ersten eigenen KI-Beschleuniger entwickeln zu lassen. Nun hat man diese Zusammenarbeit offiziell angekündigt. Broadcom soll laut Vereinbarung für OpenAI... [mehr]

OpenAI und Broadcom haben eine mehrjährige Zusammenarbeit angekündigt, die unter anderem die Bereitstellung und Entwicklung von eigens entwickelten KI-Beschleunigern beinhaltet. Bereits mehrfach wurden Berichte öffentlich, die besagten, dass OpenAI an Broadcom herangetreten ist, um dort seinen ersten eigenen KI-Beschleuniger entwickeln zu lassen. Nun hat man diese Zusammenarbeit offiziell angekündigt. Broadcom soll laut Vereinbarung für OpenAI... [mehr] -

Leistungs- und TCO-Einschätzung: SemiAnalysis wiederholt Benchmarks täglich

Die Analysten von SemiAnalysis haben in Zusammenarbeit mit AMD, NVIDIA, Microsoft, OpenAI, Together AI, CoreWeave, Nebius, PyTorch Foundation, Supermicro, Crusoe, HPE, Tensorwave, VLLM, SGLang und einigen mehr ein neues Open-Source-Werkzeug entwickelt, welches die Inferencing-Leistung der aktuellen Hardware beleuchten soll. InferenceMAX lautet der Name der Vergleichs-Plattform. Tokens pro Sekunde, Tokens je GPU, Tokens pro Watt, aber auch... [mehr]

Die Analysten von SemiAnalysis haben in Zusammenarbeit mit AMD, NVIDIA, Microsoft, OpenAI, Together AI, CoreWeave, Nebius, PyTorch Foundation, Supermicro, Crusoe, HPE, Tensorwave, VLLM, SGLang und einigen mehr ein neues Open-Source-Werkzeug entwickelt, welches die Inferencing-Leistung der aktuellen Hardware beleuchten soll. InferenceMAX lautet der Name der Vergleichs-Plattform. Tokens pro Sekunde, Tokens je GPU, Tokens pro Watt, aber auch... [mehr] -

NVIDIA und OpenAI: Hardware für 10 GW und 100 Milliarden US-Dollar an Investitionen

NVIDIA und OpenAI haben heute eine strategische Partnerschaft angekündigt, die einerseits die Auslieferung von KI-Hardware im Umfang von 10 Gigawatt durch NVIDIA an OpenAI und andererseits eine Investition von bis zu 100 Milliarden US-Dollar durch NVIDIA in OpenAI vorsieht. Laut beider Unternehmen entspräche die Installation von Hardware mit einer Leistungsaufnahme von 10 GW mehreren Millionen GPUs. Konkret an Hardware genannt wird die... [mehr]

NVIDIA und OpenAI haben heute eine strategische Partnerschaft angekündigt, die einerseits die Auslieferung von KI-Hardware im Umfang von 10 Gigawatt durch NVIDIA an OpenAI und andererseits eine Investition von bis zu 100 Milliarden US-Dollar durch NVIDIA in OpenAI vorsieht. Laut beider Unternehmen entspräche die Installation von Hardware mit einer Leistungsaufnahme von 10 GW mehreren Millionen GPUs. Konkret an Hardware genannt wird die... [mehr] -

10-Milliarden-Auftrag für Broadcom: KI-Chip von OpenAI soll 2026 kommen

Bereits mehrfach wurde über Pläne berichtet, OpenAI würde zusammen mit Broadcom an einem eigenen KI-Chip arbeiten. Ähnliche wie Amazon für die Graviton- und Tranium-Chips und Google mit den eigenen TPUs will man sich damit unabhängiger von NVIDIA machen und kann die Hardware zudem besser auf die eigenen Anwendungen anpassen. Google entwickelte seine TPU gemeinsam mit Broadcom, die bei solchen Projekten über die entsprechende Expertise und IP... [mehr]

Bereits mehrfach wurde über Pläne berichtet, OpenAI würde zusammen mit Broadcom an einem eigenen KI-Chip arbeiten. Ähnliche wie Amazon für die Graviton- und Tranium-Chips und Google mit den eigenen TPUs will man sich damit unabhängiger von NVIDIA machen und kann die Hardware zudem besser auf die eigenen Anwendungen anpassen. Google entwickelte seine TPU gemeinsam mit Broadcom, die bei solchen Projekten über die entsprechende Expertise und IP... [mehr] -

Einsteiger Workstation-Lösung: Intel Arc Pro B50 im Test

Mit der Vorstellung der ersten Arc-Grafikkarten auf Basis der Battlemage-Architektur, genauer gesagt der Arc B580 (Test), konnte Intel zumindest durch Preis und Speicherausstattung überzeugen. Auch die Effizienz der Battlemage-Architektur konnte verbessert werden und zusammen mit den weiteren Verbesserungen von Xe2 ergibt sich ein rundes Gesamtbild, auch wenn Intel auch mit der zweiten Generation nicht nach der Leistungskrone greifen konnte... [mehr].

Mit der Vorstellung der ersten Arc-Grafikkarten auf Basis der Battlemage-Architektur, genauer gesagt der Arc B580 (Test), konnte Intel zumindest durch Preis und Speicherausstattung überzeugen. Auch die Effizienz der Battlemage-Architektur konnte verbessert werden und zusammen mit den weiteren Verbesserungen von Xe2 ergibt sich ein rundes Gesamtbild, auch wenn Intel auch mit der zweiten Generation nicht nach der Leistungskrone greifen konnte... [mehr]. -

NUC 14 Pro AI: ASUS startet Mini-PC mit Copilot+

Der neue NUC 14 Pro AI aus dem Hause ASUS soll einen neuen Wegpunkt im Bereich der Mini-PCs markieren. Mit den neuesten Intel Core Ultra-Prozessoren der Serie 2 integriert das Gerät CPU-, GPU- und NPU-Architekturen in einer einzigen Plattform. Mit 120 Plattform-TOPS und 48 NPU-TOPS erreicht es dabei gut die dreifache KI-Leistung gegenüber den Vorgängermodellen und ist damit für Edge-Computing, IoT-Anwendungen sowie den professionellen... [mehr]

Der neue NUC 14 Pro AI aus dem Hause ASUS soll einen neuen Wegpunkt im Bereich der Mini-PCs markieren. Mit den neuesten Intel Core Ultra-Prozessoren der Serie 2 integriert das Gerät CPU-, GPU- und NPU-Architekturen in einer einzigen Plattform. Mit 120 Plattform-TOPS und 48 NPU-TOPS erreicht es dabei gut die dreifache KI-Leistung gegenüber den Vorgängermodellen und ist damit für Edge-Computing, IoT-Anwendungen sowie den professionellen... [mehr] -

Ultrabook mit aktualisierter Technik: XMGs EVO 15 ist mit vier AMD-CPUs konfigurierbar

Auch 2025 erneuert der Notebook-Hersteller XMG seine EVO-15-Reihe mit aktualisierter Technik. Im Gegensatz zur EVO-14-Serie geht XMG sogar noch einen Schritt weiter und stellt für das EVO 15 (2025) vier verschiedene AMD-Prozessoren und eine Intel-CPU zur Auswahl. Als größte AMD-CPU kommt im E25-Modell der Ryzen AI 9 HX 370 zur Verwendung. Wenn es ein Intel-Prozessor sein soll, bleibt einzig und allein der Core Ultra 7 255H... [mehr]

Auch 2025 erneuert der Notebook-Hersteller XMG seine EVO-15-Reihe mit aktualisierter Technik. Im Gegensatz zur EVO-14-Serie geht XMG sogar noch einen Schritt weiter und stellt für das EVO 15 (2025) vier verschiedene AMD-Prozessoren und eine Intel-CPU zur Auswahl. Als größte AMD-CPU kommt im E25-Modell der Ryzen AI 9 HX 370 zur Verwendung. Wenn es ein Intel-Prozessor sein soll, bleibt einzig und allein der Core Ultra 7 255H... [mehr] -

Geekom A9 Max: Neues Spitzenmodell mit Ryzen AI 9 HX 370

Bislang stellte der Geekom A8 auf Basis eines AMD Ryzen 9 8945HS das Spitzenmodell unter den Mini-PCs des Herstellers mit AMD-Plattform dar und wurde erst zu Beginn des Jahres um eine Max-Version mit größerem Gehäuse für eine bessere Kühlung und höhere Performance aufgewertet. Nun erfolgt der Schwenk auf AMDs Ryzen-AI-Chips. Herzstück des neuen Geekom A9 Max ist ein AMD Ryzen AI 9 HX 370 aus der Strix-Point-Generation. Er kombiniert zwölf... [mehr]

Bislang stellte der Geekom A8 auf Basis eines AMD Ryzen 9 8945HS das Spitzenmodell unter den Mini-PCs des Herstellers mit AMD-Plattform dar und wurde erst zu Beginn des Jahres um eine Max-Version mit größerem Gehäuse für eine bessere Kühlung und höhere Performance aufgewertet. Nun erfolgt der Schwenk auf AMDs Ryzen-AI-Chips. Herzstück des neuen Geekom A9 Max ist ein AMD Ryzen AI 9 HX 370 aus der Strix-Point-Generation. Er kombiniert zwölf... [mehr] -

Risiko und Chance zugleich: AI-PCs vor dem Durchbruch?

Wann immer bei uns das Thema Copilot+ oder AI-PC auftaucht, stellen wir uns selbst die Frage, wie viel Relevanz die entsprechenden Hardware-Voraussetzungen haben. Während sich AMD hier streng an die Vorgaben seitens Microsofts Copilot+-Programm hält (Ryzen-AI-Serie), hat sich Intel eigene Vorgaben geschaffen. Der AI-PC wird seitens Intels wie folgt definiert: Eine Hardware-Architektur bestehend aus CPU, GPU und NPU, welche KI-Workloads lokal... [mehr]

Wann immer bei uns das Thema Copilot+ oder AI-PC auftaucht, stellen wir uns selbst die Frage, wie viel Relevanz die entsprechenden Hardware-Voraussetzungen haben. Während sich AMD hier streng an die Vorgaben seitens Microsofts Copilot+-Programm hält (Ryzen-AI-Serie), hat sich Intel eigene Vorgaben geschaffen. Der AI-PC wird seitens Intels wie folgt definiert: Eine Hardware-Architektur bestehend aus CPU, GPU und NPU, welche KI-Workloads lokal... [mehr] -

Acer TravelMate P6 14 AI im Test: Gutes Business-Gerät für das Wesentliche

Ein kompaktes und leichtes 14-Zoll-Format, ein schneller Core-Ultra-200V-Prozessor von Intel sowie ein stabiles Gehäuse mit Karbonfaser und einer Magnesium-Aluminium-Legierung sollen das Acer TravelMate P6 14 AI zu einem leistungsstarken und portablen Alltagsbegleiter speziell für das Business-Umfeld machen. Wie sich das Gerät im Praxisalltag schlägt, das erfährt man in diesem Hardwareluxx-Artikel. Wir haben eine mittlere Konfiguration für... [mehr]

Ein kompaktes und leichtes 14-Zoll-Format, ein schneller Core-Ultra-200V-Prozessor von Intel sowie ein stabiles Gehäuse mit Karbonfaser und einer Magnesium-Aluminium-Legierung sollen das Acer TravelMate P6 14 AI zu einem leistungsstarken und portablen Alltagsbegleiter speziell für das Business-Umfeld machen. Wie sich das Gerät im Praxisalltag schlägt, das erfährt man in diesem Hardwareluxx-Artikel. Wir haben eine mittlere Konfiguration für... [mehr] -

Geekom IT15 Mini AI im Test: Intel Core Ultra 9 285H im Kleinformat

Der Geekom IT15 Mini AI ist der erste Mini-PC des Herstellers, der auf der neuen Arrow-Lake-Plattform aufbaut und damit zu den schnellsten Intel-Lösungen des Hauses gehören möchte. Wie sich das Spitzenmodell im weniger ikonischen Gehäuse schlägt, das erfährt man pünktlich zum Launch in diesem Hardwareluxx-Artikel. Wir haben den rund 1.199 Euro teuren Kompaktrechner durch unseren Benchmark-Parcours geschickt. Der neue Geekom IT15 Mini AI hat... [mehr]

Der Geekom IT15 Mini AI ist der erste Mini-PC des Herstellers, der auf der neuen Arrow-Lake-Plattform aufbaut und damit zu den schnellsten Intel-Lösungen des Hauses gehören möchte. Wie sich das Spitzenmodell im weniger ikonischen Gehäuse schlägt, das erfährt man pünktlich zum Launch in diesem Hardwareluxx-Artikel. Wir haben den rund 1.199 Euro teuren Kompaktrechner durch unseren Benchmark-Parcours geschickt. Der neue Geekom IT15 Mini AI hat... [mehr] -

Instinct-MI350-Beschleuniger: AMD mit kleinen Schritten zum großen Ziel

Im Rahmen des "Advancing AI 2025"-Events hat AMD mit der Instinct-MI350-Serie die nächste Generation seiner Instinct-Beschleuniger vorgestellt, die auf Basis der CDNA-4-Architektur in zahlreichen Bereichen Verbesserungen vorzuweisen haben, die AMD näher an den großen Konkurrenten NVIDIA bringen sollen. Ob dies gelungen ist, hängt von zahlreichen Faktoren ab. AMD hatte für die Instinct-MI350-Serie allerdings einige selbst gesteckte... [mehr]

Im Rahmen des "Advancing AI 2025"-Events hat AMD mit der Instinct-MI350-Serie die nächste Generation seiner Instinct-Beschleuniger vorgestellt, die auf Basis der CDNA-4-Architektur in zahlreichen Bereichen Verbesserungen vorzuweisen haben, die AMD näher an den großen Konkurrenten NVIDIA bringen sollen. Ob dies gelungen ist, hängt von zahlreichen Faktoren ab. AMD hatte für die Instinct-MI350-Serie allerdings einige selbst gesteckte... [mehr] -

4K Webcams mit KI-Unterstützung: Insta360 Link 2 & Insta360 Link 2C

Insta360 wurde erst 2015 gegründet. Seither hat man sich auf die Entwicklung und den Verkauf von Action-Kameras und Webcams spezialisiert. Mittlerweile verfügt man über Filialen in Los Angeles, Tokio, Berlin, Shenzhen und Hong Kong. Nun hat Insta 360 mit der Link 2 und der Link 2C die neuesten 4K-Webcams des Unternehmens vorgestellt. Die beiden Kameras setzen auf KI-Unterstützung. So wird auch die Rauschunterdrückung bei Audio-Aufnahmen durch... [mehr]

Insta360 wurde erst 2015 gegründet. Seither hat man sich auf die Entwicklung und den Verkauf von Action-Kameras und Webcams spezialisiert. Mittlerweile verfügt man über Filialen in Los Angeles, Tokio, Berlin, Shenzhen und Hong Kong. Nun hat Insta 360 mit der Link 2 und der Link 2C die neuesten 4K-Webcams des Unternehmens vorgestellt. Die beiden Kameras setzen auf KI-Unterstützung. So wird auch die Rauschunterdrückung bei Audio-Aufnahmen durch... [mehr] -

Acer Predator Helios und Triton 14 AI: Zwei ähnliche, aber doch unterschiedliche Modelle

Das Predator Helios Neo 14 AI und das Predator Triton 14 AI sind auf den ersten Blick zwei sehr ähnliche Mobilgeräte, die Acer im Vorfeld der Computex 2025 in Taipeh angekündigt hat. Tatsächlich fallen die Unterschiede größer aus als zunächst angenommen. Während das Helios mit etwas leistungsstärkerer Hardware überwiegend Spieler anspricht, richtet sich das Triton mit Ultra-Low-Voltage-CPU, besserem Display und Touchfunktionen eher an... [mehr]

Das Predator Helios Neo 14 AI und das Predator Triton 14 AI sind auf den ersten Blick zwei sehr ähnliche Mobilgeräte, die Acer im Vorfeld der Computex 2025 in Taipeh angekündigt hat. Tatsächlich fallen die Unterschiede größer aus als zunächst angenommen. Während das Helios mit etwas leistungsstärkerer Hardware überwiegend Spieler anspricht, richtet sich das Triton mit Ultra-Low-Voltage-CPU, besserem Display und Touchfunktionen eher an... [mehr] -

MSI Titan 18 HX AI im Test: Mehr Power und Ausstattung gehen nicht

MSI geht bei seinem Titan 18 HX AI keinerlei Kompromisse bei der Ausstattung ein: So verbaut man mit Arrow Lake und Blackwell nicht nur die schnellsten Komponenten für Spieler, sondern auch reichlich Speicher und vor allem eine mechanische Tastatur, eine leistungsstarke Kühlung und ein hochwertiges Display. Das Gesamtpaket lässt man sich mit einem Preis von deutlich über 6.000 Euro aber auch teuer bezahlen. Wie sich das Gaming-Monster... [mehr]

MSI geht bei seinem Titan 18 HX AI keinerlei Kompromisse bei der Ausstattung ein: So verbaut man mit Arrow Lake und Blackwell nicht nur die schnellsten Komponenten für Spieler, sondern auch reichlich Speicher und vor allem eine mechanische Tastatur, eine leistungsstarke Kühlung und ein hochwertiges Display. Das Gesamtpaket lässt man sich mit einem Preis von deutlich über 6.000 Euro aber auch teuer bezahlen. Wie sich das Gaming-Monster... [mehr] -

Milliarden-Kooperation: HUMAIN kauft Hardware von AMD, NVIDIA, Qualcomm und Co

Das vom Public Investment Fund (PIF) des Staates Saudi-Arabien finanzierte Unternehmen HUMAIN (nicht zu verwechseln mit Humane, dem Hersteller des gescheiterten AI Pin), hat während des Besuchs des US-Präsidenten zahlreiche Investitionen bekanntgegeben. Hunderttausende KI-Beschleuniger, Prozessoren und Netzwerk-Equipment von AMD, NVIDIA und Qualcomm sollen in den kommenden Jahren gekauft werden. Vor Ort waren die CEOs Dr. Lisa Su (AMD),... [mehr]

Das vom Public Investment Fund (PIF) des Staates Saudi-Arabien finanzierte Unternehmen HUMAIN (nicht zu verwechseln mit Humane, dem Hersteller des gescheiterten AI Pin), hat während des Besuchs des US-Präsidenten zahlreiche Investitionen bekanntgegeben. Hunderttausende KI-Beschleuniger, Prozessoren und Netzwerk-Equipment von AMD, NVIDIA und Qualcomm sollen in den kommenden Jahren gekauft werden. Vor Ort waren die CEOs Dr. Lisa Su (AMD),... [mehr] -

Neue Geräte für die Mittelklasse: Acer ergänzt die Nitro-Familie

Acer ergänzt ab Juli seine Nitro-Familie um weitere Modelle, die sich mit einem Startpreis ab 1.299 Euro im mittleren Preissegment einfinden werden. Alle Geräte kombinieren einen Ryzen-Prozessor mit einer GeForce-RTX-50-Grafik, wobei diese je nach Gehäusegröße unterschiedlich schnell ausfallen. Während sich das Acer Nitro AI 18 und das Nitro AI 16 bis hin zu einem AMD Ryzen AI 9 365 und einer NVIDIA GeForce RTX 5070 Ti konfigurieren lassen,... [mehr]

Acer ergänzt ab Juli seine Nitro-Familie um weitere Modelle, die sich mit einem Startpreis ab 1.299 Euro im mittleren Preissegment einfinden werden. Alle Geräte kombinieren einen Ryzen-Prozessor mit einer GeForce-RTX-50-Grafik, wobei diese je nach Gehäusegröße unterschiedlich schnell ausfallen. Während sich das Acer Nitro AI 18 und das Nitro AI 16 bis hin zu einem AMD Ryzen AI 9 365 und einer NVIDIA GeForce RTX 5070 Ti konfigurieren lassen,... [mehr] -

Quake 2: Microsoft lässt Shooter von KI neu erstellen

Aktuell hält der Hype um das Thema Künstliche Intelligenz weiter an. Auch im Bereich Gaming finden sich immer wieder neue Ansätze, verschiedene generative KIs einzusetzen. Wie viele der großen Konzerne hat auch Microsoft selbst eine hauseigene KI. Bekannt ist hier vor allem der Copilot, der unter anderem in Office-Anwendungen und auch in der Bing-Suche zum Einsatz kommt. Der Konzern nutzt aber auch andere Modelle. Darunter das “World and Human... [mehr]

Aktuell hält der Hype um das Thema Künstliche Intelligenz weiter an. Auch im Bereich Gaming finden sich immer wieder neue Ansätze, verschiedene generative KIs einzusetzen. Wie viele der großen Konzerne hat auch Microsoft selbst eine hauseigene KI. Bekannt ist hier vor allem der Copilot, der unter anderem in Office-Anwendungen und auch in der Bing-Suche zum Einsatz kommt. Der Konzern nutzt aber auch andere Modelle. Darunter das “World and Human... [mehr] -

Llama 4: Metas neue KI-Modelle werden noch komplexer

Meta hat mit der Llama 4-Serie eine neue Generation multimodaler Sprachmodelle vorgestellt, die sich durch technische Innovationen und hohe Effizienz auszeichnen wollen. Das Einstiegsmodell Llama 4 Scout nutzt dabei 17 Milliarden aktive Parameter, die auf 16 Experten verteilt sind, und kann dank seiner Architektur vollständig auf einer einzigen NVIDIA H100 GPU betrieben werden. Es unterstützt eine kontextuelle Eingabelänge von bis zu 10... [mehr]

Meta hat mit der Llama 4-Serie eine neue Generation multimodaler Sprachmodelle vorgestellt, die sich durch technische Innovationen und hohe Effizienz auszeichnen wollen. Das Einstiegsmodell Llama 4 Scout nutzt dabei 17 Milliarden aktive Parameter, die auf 16 Experten verteilt sind, und kann dank seiner Architektur vollständig auf einer einzigen NVIDIA H100 GPU betrieben werden. Es unterstützt eine kontextuelle Eingabelänge von bis zu 10... [mehr] -

Für Arbeitsabläufe in Fabriken: Microsoft stellt KI-Assistenten für Industrie vor

Auf der Hannover Messe steht in diesem Jahr Künstliche Intelligenz im Mittelpunkt zahlreicher Innovationen. Auch Microsoft, als starker Investor in diesem Bereich, präsentiert mit dem "Factory Operations Agent" einen neuen KI-gestützten Assistenten, der industrielle Prozesse effizienter gestalten soll. Diese Lösung will es Arbeitskräften ermöglichen, Maschinendaten durch einfache Abfragen in natürlicher Sprache analysieren zu können... [mehr].

Auf der Hannover Messe steht in diesem Jahr Künstliche Intelligenz im Mittelpunkt zahlreicher Innovationen. Auch Microsoft, als starker Investor in diesem Bereich, präsentiert mit dem "Factory Operations Agent" einen neuen KI-gestützten Assistenten, der industrielle Prozesse effizienter gestalten soll. Diese Lösung will es Arbeitskräften ermöglichen, Maschinendaten durch einfache Abfragen in natürlicher Sprache analysieren zu können... [mehr]. -

Intel CEO Lip-Bu Tan: Intel bestätigt Pläne für Panther Lake, Nova Lake, Clearwater Forest und Intel 18A

In seiner neuen Position als CEO bei Intel hat Lip-Bu Tan in einem Brief an die Aktionäre (PDF) die Ausrichtung des "neuen Intel" bestärkt und die Pläne im Hinblick auf die Roadmap für den Client- und Datacenter-Markt bestätigt. Im Endkunden-Bereich sieht man sich aktuell schon recht gut aufgestellt, will die eigene Position mit Panther Lake in der zweiten Jahreshälfte aber weiter verbessern. Panther Lake wird eines der "lead products" für die... [mehr]

In seiner neuen Position als CEO bei Intel hat Lip-Bu Tan in einem Brief an die Aktionäre (PDF) die Ausrichtung des "neuen Intel" bestärkt und die Pläne im Hinblick auf die Roadmap für den Client- und Datacenter-Markt bestätigt. Im Endkunden-Bereich sieht man sich aktuell schon recht gut aufgestellt, will die eigene Position mit Panther Lake in der zweiten Jahreshälfte aber weiter verbessern. Panther Lake wird eines der "lead products" für die... [mehr] -

DGX Spark und DGX Station: KI-Workstation für KI-Entwickler

Auf der CES Anfang Januar noch als Project DIGITS bezeichnet hat NVIDIA auf der GTC nun mit DGX Spark den finalen Namen der KI-Mini-PCs mit GB10-Chip vorgestellt. DGX-Spark-Systeme soll es aber nicht nur von NVIDIA direkt geben, sondern auch von ASUS, Dell, HP und Lenovo. Der für DGX Spark verwendete GB10-Chip ist ein SoC mit 20 ARM-Kernen auf Basis des Grace-Designs. Diesem zur Seite gestellt wird eine Blackwell-GPU, deren Ausbaustufe... [mehr]

Auf der CES Anfang Januar noch als Project DIGITS bezeichnet hat NVIDIA auf der GTC nun mit DGX Spark den finalen Namen der KI-Mini-PCs mit GB10-Chip vorgestellt. DGX-Spark-Systeme soll es aber nicht nur von NVIDIA direkt geben, sondern auch von ASUS, Dell, HP und Lenovo. Der für DGX Spark verwendete GB10-Chip ist ein SoC mit 20 ARM-Kernen auf Basis des Grace-Designs. Diesem zur Seite gestellt wird eine Blackwell-GPU, deren Ausbaustufe... [mehr] -

GTC25: NVIDIAs Hausmesse als Startpunkt für Blackwell Ultra

Bereits gestern startete die diesjährige GTC als "GTC AI Conference" mit einem Vorab-Programm, bevor NVIDIAs CEO Jensen Huang heute in wenigen Stunden die Bühne betreten und seine Keynote abhalten wird. Das, was 2009 als GPU Technology Conference begann, entwickelte sich über die Jahre zur mehr als nur NVIDIAs Hausmesse. CUDA entwickelte sich zu einer Compute-Plattform mit GPU-Beschleunigung, aus NVIDIA – der "Gaming Company" – wurde ein... [mehr]

Bereits gestern startete die diesjährige GTC als "GTC AI Conference" mit einem Vorab-Programm, bevor NVIDIAs CEO Jensen Huang heute in wenigen Stunden die Bühne betreten und seine Keynote abhalten wird. Das, was 2009 als GPU Technology Conference begann, entwickelte sich über die Jahre zur mehr als nur NVIDIAs Hausmesse. CUDA entwickelte sich zu einer Compute-Plattform mit GPU-Beschleunigung, aus NVIDIA – der "Gaming Company" – wurde ein... [mehr] -

KI-Forschung: OpenAI ist Mitgründer des NextGenAI-Konsortiums

Der Softwareentwickler OpenAI hat sich der Forschung und Entwicklung im KI-Bereich verschrieben. Am bekanntesten ist die Firma wahrscheinlich für ChatGPT und Dall-E. In einer MItteilung hat man nun bekannt gegeben, dass OpenAI Mitgründer eines neuen Konsortiums zur Förderung von Forschung und Bildung mit KI ist. Dieses trägt den Namen NextGenAI. Zur Gründung steuert OpenAI 50 Millionen US-Dollar an Finanzmitteln und Tools bei. Insgesamt... [mehr]

Der Softwareentwickler OpenAI hat sich der Forschung und Entwicklung im KI-Bereich verschrieben. Am bekanntesten ist die Firma wahrscheinlich für ChatGPT und Dall-E. In einer MItteilung hat man nun bekannt gegeben, dass OpenAI Mitgründer eines neuen Konsortiums zur Förderung von Forschung und Bildung mit KI ist. Dieses trägt den Namen NextGenAI. Zur Gründung steuert OpenAI 50 Millionen US-Dollar an Finanzmitteln und Tools bei. Insgesamt... [mehr] -

Framework Desktop Mainboard: Cluster-Aufbau für KI-Forscher möglich

Das für den Framework Desktop gestern vorgestellte und mit den Ryzen-AI-Max-Prozessoren ausgestattete Mainboard kann natürlich auch einzeln bestellt und verwendet werden. Als Mini-ITX-Mainboard kann es demnach in einem beliebigen Gehäuse untergebracht werden, der Kühlkörper ist direkt montiert und kann mit einem ebenso beliebigen Lüfter bestückt werden. Wird noch eine NVMe-SSD in einem der beiden M.2-Slots montiert und ein Netzteil... [mehr]

Das für den Framework Desktop gestern vorgestellte und mit den Ryzen-AI-Max-Prozessoren ausgestattete Mainboard kann natürlich auch einzeln bestellt und verwendet werden. Als Mini-ITX-Mainboard kann es demnach in einem beliebigen Gehäuse untergebracht werden, der Kühlkörper ist direkt montiert und kann mit einem ebenso beliebigen Lüfter bestückt werden. Wird noch eine NVMe-SSD in einem der beiden M.2-Slots montiert und ein Netzteil... [mehr] -

Gameplay durch KI: Xbox stellt Muse vor

In den letzten Jahren halten verschiedene KI-Anwendungen immer mehr Einzug in verschiedene Bereiche. So gab es auch schon einen Streik der Hollywood-Autoren, da man fürchtete, der Einsatz von künstlicher Intelligenz würde die Jobs in der Branche gefährden. Nun scheint es, dass auch Microsoft über den Einsatz solcher Anwendungen bei der Spieleentwicklung nachdenkt. Der Konzern hat heute Muse vorgestellt. Entwickelt wurde das System von... [mehr]

In den letzten Jahren halten verschiedene KI-Anwendungen immer mehr Einzug in verschiedene Bereiche. So gab es auch schon einen Streik der Hollywood-Autoren, da man fürchtete, der Einsatz von künstlicher Intelligenz würde die Jobs in der Branche gefährden. Nun scheint es, dass auch Microsoft über den Einsatz solcher Anwendungen bei der Spieleentwicklung nachdenkt. Der Konzern hat heute Muse vorgestellt. Entwickelt wurde das System von... [mehr] -

Elon Musk gegen Sam Altman: Investorengruppe bietet 100 Milliarden für OpenAI-Übernahme

Der Streit zwischen Elon Musk und OpenAI scheint zunehmend zu eskalieren und um den Rechtsweg gegen seinen Konkurrenten zu umgehen, hat Musk offenbar eine Investorengruppe um sich geschart, um OpenAI für 100 Milliarden US-Dollar zu übernehmen, bzw. die Kontrolle zu erhalten. Das Wall Street Journal berichtete über ein Übernahmeangebot, welches sich direkt an den Verwaltungsrat von OpenAI richtete. Eine direkte Bestätigung seitens OpenAI gab es... [mehr]

Der Streit zwischen Elon Musk und OpenAI scheint zunehmend zu eskalieren und um den Rechtsweg gegen seinen Konkurrenten zu umgehen, hat Musk offenbar eine Investorengruppe um sich geschart, um OpenAI für 100 Milliarden US-Dollar zu übernehmen, bzw. die Kontrolle zu erhalten. Das Wall Street Journal berichtete über ein Übernahmeangebot, welches sich direkt an den Verwaltungsrat von OpenAI richtete. Eine direkte Bestätigung seitens OpenAI gab es... [mehr]