Werbung

Die Analysten von SemiAnalysis haben in Zusammenarbeit mit AMD, NVIDIA, Microsoft, OpenAI, Together AI, CoreWeave, Nebius, PyTorch Foundation, Supermicro, Crusoe, HPE, Tensorwave, VLLM, SGLang und einigen mehr ein neues Open-Source-Werkzeug entwickelt, welches die Inferencing-Leistung der aktuellen Hardware beleuchten soll. InferenceMAX lautet der Name der Vergleichs-Plattform.

Tokens pro Sekunde, Tokens je GPU, Tokens pro Watt, aber auch Details wie Tokens pro Sekunde je Nutzer im Verhältnis von Tokens pro Sekunde je GPU sind wichtige Metriken, um die Leistung der Hardware beurteilen zu können. Die MLCommons bietet ebenfalls Inferencing-Benchmarks, auf deren Basis wir dann regelmäßig eine Leistungseinschätzung der Hardware versuchen. Unterschieden wird hier zwischen dem Inferencing im Rechenzentrum und im Edge-Segment. Allerdings werden diese Benchmarks nur alle sechs Monate erneuert.

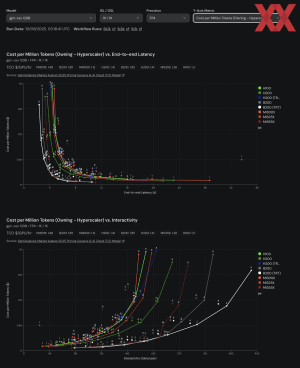

Für InferenceMAX laufen die Server mit NVIDIAsGB200 NVL72, B200, H200, H100 und AMDs Instinct MI355X, MI325X sowie MI300X KI-Beschleuniger ständig und führen die Benchmarks auch ständig neu aus. Wichtig ist dies, da auch das Software-Ökosystem ständigen Optimierungen unterzogen wird. Software wie SGLang, vLLM, TensorRT-LLM, CUDA und ROCm ändert sich beinahe täglich und baut aufeinander auf.

Diese ständigen Verbesserungen werden in den sechsmonatigen Benchmarks nicht reflektiert und können daher auch nur einen Ist-Zustand abbilden, der im Zweifel schon einige Monate alt ist.

Die täglich erneut ausgeführten Benchmarks verwenden die LLMs Llama 3.3 70B, gpt-oss 120B und DeepSeek R1 0528. Für die Abbildung eines Inferencing-Workloads für einen einfachen Chat sieht SemiAnalysis 1.024 Input- und Output-Tokens vor. Für ein Reasoning sind ebenfalls 1.024 Input-Tokens vorgesehen, die Ausgabe erfolgt in Form von 8.192 Tokens. Für eine Zusammenfassung oder die Erfassung von Inhalten arbeitet InferenceMAX mit 8.129 Input-Tokens und wiederum 1.024 Output-Tokens.

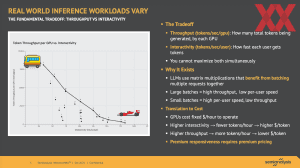

Die einfache Angabe der Rechenleistung in theoretischen FP8-Operationen oder dergleichen entsprechen nicht dem, wie man eine solche Hardware in der Praxis beurteilen sollte. Je nachdem, welche Anforderungsprofil der Besitzer/Anwender der Hardware hat, kann er diese auf einen möglichst hohen Durchsatz, eine geringe Latenz und hohe Interaktivität auslegen. Den idealen Betriebspunkt zu finden, ist also gar nicht so einfach bzw. sehr individuell. Hinzu kommt die TCO-Bewertung (total cost of ownerchip), die neben dem Kaufpreis auch die Betriebskosten und den Verbrauch mit einbeziehen musss. Auch hier soll InferenceMAX die entsprechenden Werte bieten können.

Unter www.inferencemax.ai sind die Ergebnisse abrufbar. Gebühren oder dergleichen fallen nicht an. Die Hardwarehersteller haben die Systeme und KI-Beschleuniger zur Verfügung gestellt. Sämtliche Software ist als Open-Source verfügbar.

In Kürze sollen neben den erwähnten KI-Beschleunigern auch die TPUs von Google und der Trainium-Chip von AWS enthalten sein.