Werbung

Bisher kennen wir nur viele Videos, eine Tech-Demo (Star Wars: Reflections) und viele Ankündigungen zu Spielen mit RTX- bzw. DXR-Unterstützung. Im Falle von Battlefield V konnten wir uns auf der GamesCom die RTX-Alpha bereits anschauen. Darüber hinaus halten sich die Erfahrungen mit den Ray-Tracing-Effekten aber in Grenzen.

So fehlt es bisher auch an Erkenntnissen, welche Leistung die Aktivierung von RTX kosten wird. Dies wird sicherlich zunächst einmal stark davon abhängig sein, wie viele Effekte umgesetzt wurden. Sprechen wir von Reflexionen, Refraktionen, Schatten Ambient Occlusion und/oder Global Illumination? Die Komplexität der Effekte wird hier also eine wichtige Rolle spielen. Eine weitere Komponente wird die Auflösung sein. Mit Auflösung ist aber nicht nur die Darstellungsauflösung gemeint (zum Beispiel 1.920 x 1.080 oder 3.840 x 2.160 Pixel), sondern auch die Tiefe des Ray Tracings für die einzelnen Effekte. Ein Ray Tracing kann von einem Sample pro Pixel bis zu mehreren hundert Samples pro Pixel reichen und somit ist auch schnell erkennbar, dass die Komplexität hier rasant ansteigt.

Auf der GPU Technology Conference in München haben die Entwickler von Remedy anhand der eigenen Northlight-Engine gezeigt, welchen Einfluss das Ray Tracing haben kann. Präsentiert wurde die bekannte Ray-Tracing-Demo auf einer Geforce RTX 2080 Ti.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen

Die Kollegen von Golem haben dem Vortrag von Juha Sjoholm, Senior Devtech Engineer bei NVIDIA, in München gelauscht und daraus folgende Informationen gewonnen.

Die bekannte Tech-Demo wurde in 1.920 x 1.080 Pixel auf einer GeForce RTX 2080 Ti ausgeführt und verwendete Schatten, Reflexionen und eine sogenannte Indirect Diffuse Illumination. Anstatt tricksen zu müssen sind die Beleuchtungseffekte laut Aussage von Golem tatsächlich deutlich realistischer und detaillierter. Der Aufwand dazu soll aber enorm sein.

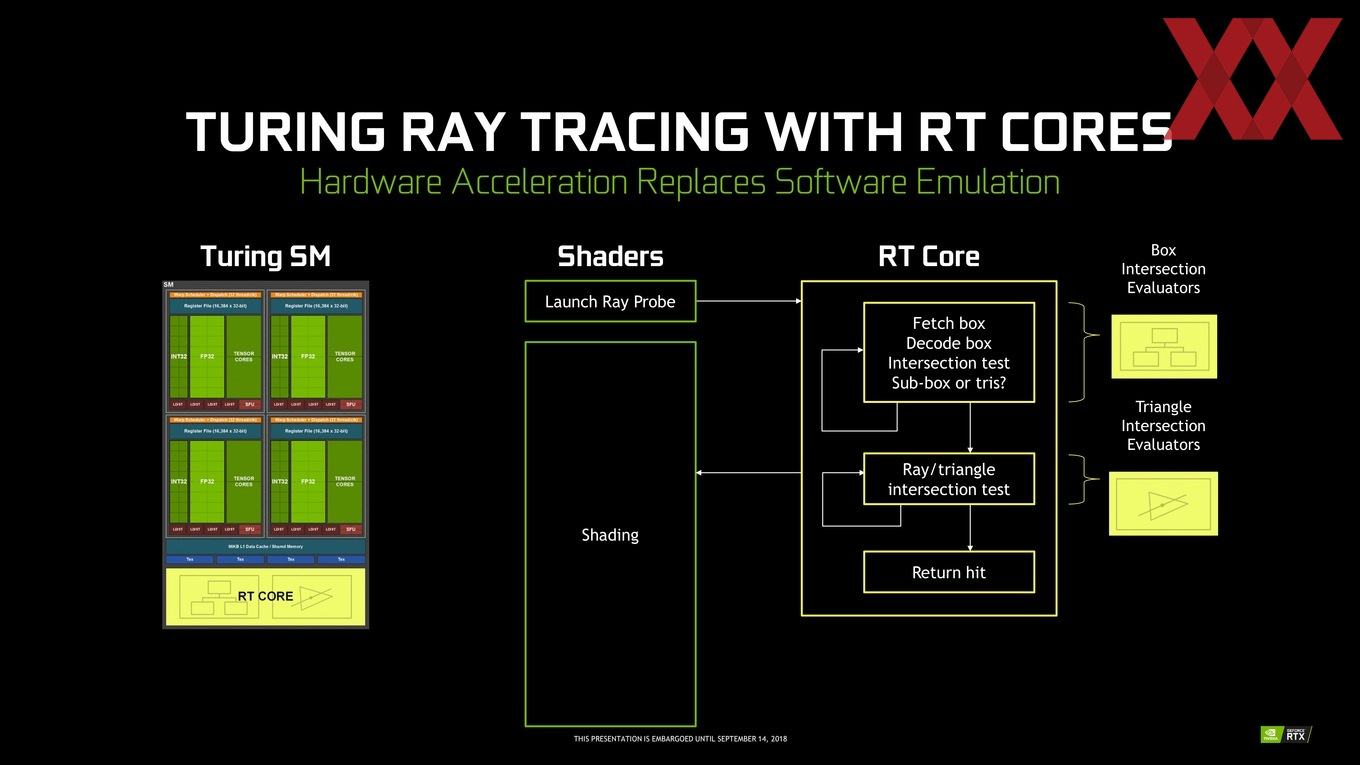

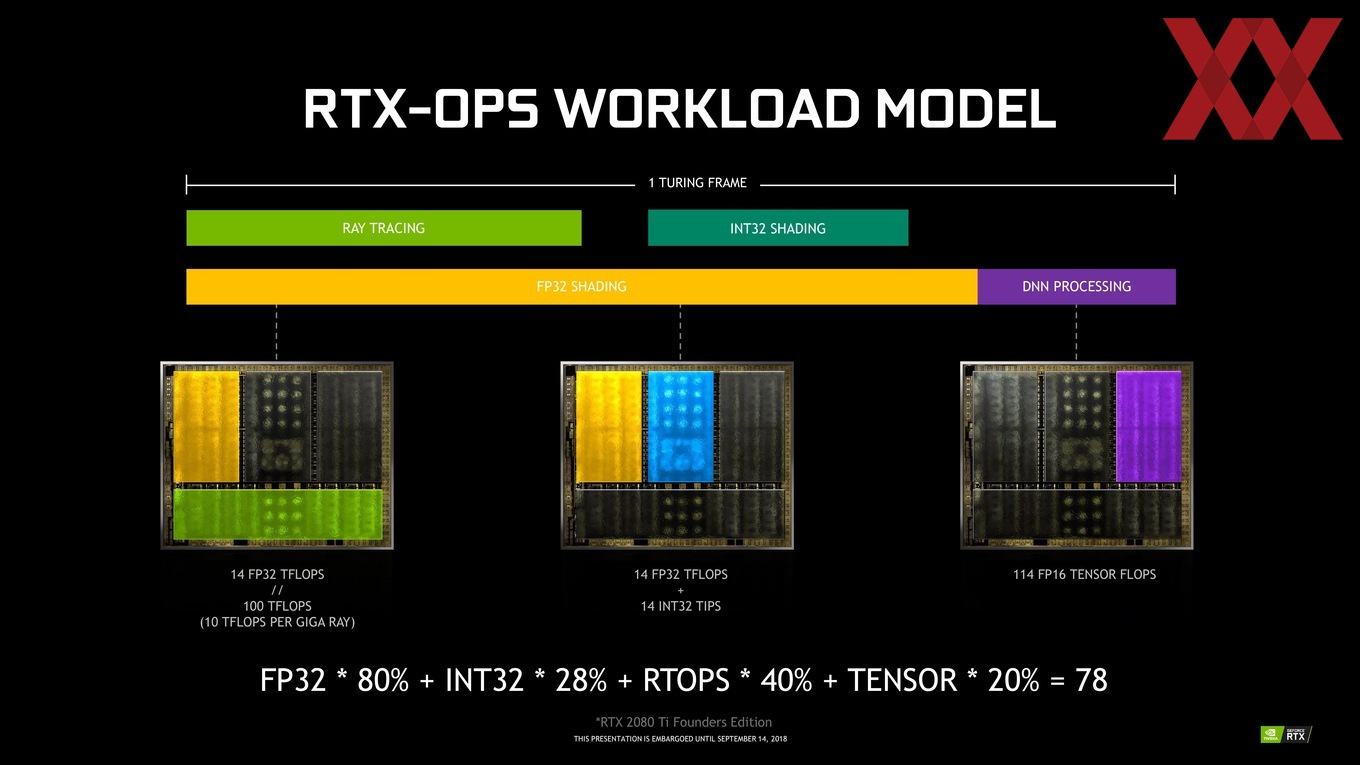

Für zwei Samples bzw. Strahlen pro Pixel für die Schatteneffekte benötigte die GeForce RTX 2080 Ti inklusive Entrauschen 2,3 ms pro Frame und die Reflektionen kommen auf 4,4 ms. Kommt noch eine Global Illumination wieder mit Denoising hinzu, dauert das Rendering eines Frames noch einmal 2,5 ms länger. Insgesamt sprechen wir also von einer Rechenzeit von 9,2 ms für die erwähnten Berechnungen. Gehen wir also von 33 ms pro Frame für 30 FPS aus, brechen diese auf 23 FPS ein. Allerdings wäre hier die mögliche asynchrone Berechnung nicht mit inbegriffen. Shader und RT Cores können aber mit gewissen Abhängigkeiten zueinander in gewisser Weise unabhängig voneinander arbeiten.

Dies bedeutet aber nicht, dass die Leistung immer um diesen Faktor verringert wird. Einerseits ist die Dauer der einzelnen Schritte bei gleicher Komplexität stabil, ausgehend von mehr FPS für die restlichen Berechnungen, fallen die 9,2 ms aber weniger stark ins Gewicht bzw. werden mehr oder weniger ausgeglichen. Zum Anderen hat sich Remedy nicht zum möglichen Optimierungspotenzial geäußert. Wir sind daher gespannt, wie sich die Leistung auf den neuen Karten mit dem RTX-Patch für Shadow of the Tomb Raider sowie in Battlefield V auswirken wird.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen