Werbung

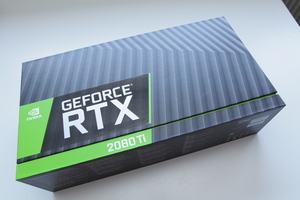

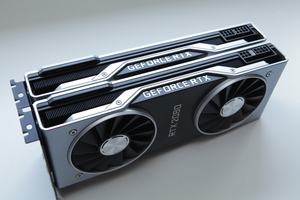

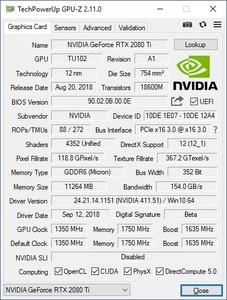

Die Geschichte rund um Verzögerungen in der Auslieferung der GeForce RTX 2080 Ti in der Founders Edition geht weiter. Bereits mehrfach gab es Verzögerungen, dabei wurden die Karten teilweise direkt nach der Vorstellung Ende August vorbestellt.

Nun gibt es neue Informationen, die vermutlich auch interessierte Kunden in Deutschland betreffen. Im Support-Forum hat sich NVIDIA wie folgt geäußert:

"Today we began shipping GeForce RTX 2080 Ti Founders Edition to those who pre-ordered from NVIDIA.com and had an original ship date in September. These will all ship by October 5th.

GeForce RTX 2080 Ti Founders Edition pre-orders on NVIDIA.com with an original ship date in October will ship by October 10, 2018."

Alle, die noch im September bestellt haben, sollen in den kommenden Tagen ihre Lieferung erhalten. Die Auslieferung soll am morgigen 5. Oktober stattfinden. Wer bis zum aktuellen Zeitpunkt bestellt hat, soll seine Lieferung ab dem 10. Oktober erhalten.

Erstmals äußert sich NVIDIA auch zu möglichen Gründen in den Verzögerungen:

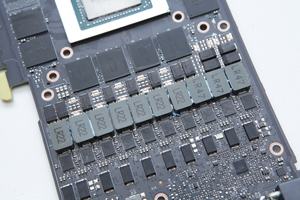

"Our supply chain challenges are resolved, and we will have cards in your hands as soon as possible."

Offenbar gab es Schwierigkeiten bzw. Herausforderungen in der Lieferkette. Wo genau diese zu suchen sind und in welcher Form NVIDIA diese lösen konnte, wird nicht erwähnt.

Update:

Die GeForce RTX 2080 Ti Founders Edition kann ab sofort wieder für 1.259 Euro direkt im Online-Shop von NVIDIA gekauft werden. NVIDIA spricht von einer Lieferung in 1-3 Werktagen. Man darf gespannt sein, ob die Karte nun auch lieferbar bleibt.