Werbung

Mit dem Fortschritt von den ersten LLMs über feinabgestimmte Modelle (Fine-tuning), Mixture-of-Experts-Architekturen (MoEs) und den ersten Reasoning-Modellen hin zu leistungsfähigen KI-Agents werden Anfragen kontinuierlich komplexer. Die Aufgaben verlangen immer größere Kontextfenster, mehr Token und steigende Rechenleistung – wodurch der Energiebedarf der Systeme stetig wächst.

Moderne KI-Modelle benötigen zunehmend längere Kontext-Fenster, die bis zu einer Million Tokens reichen. Beispiele für solche Anwendungen sind Enterprise-Chatbots und Textzusammenfassung mit bis zu 256.000 Tokens in einer Session, das Wipe Coding mit 100.000+ Codezeilen oder Videobearbeitung in entsprechender Auflösung und Länge, wo schnell 1.000.000+ Tokens erreicht werden.

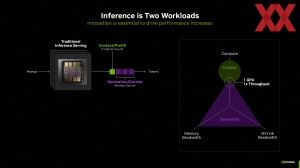

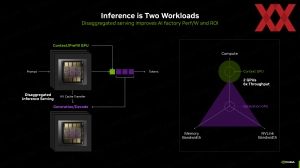

Das Inferencing eines KI-Modells besteht aus zwei Workloads: Context/Prefill ist rechenlastig und wird durch schnelle Compute-Einheiten beschleunigt. Generation/Decode ist eher speicherbandbreitegebunden und benötigt schnelle und große Speicherzugriffe. Um diese beiden Aufgabenbereiche für das Inferencing zu trennen, ermöglicht es NVIDIA bereits den Context/Prefill-Anteil auf einer GPU auszuführen, der zum Prompt dazugehörige KV Cache wird an eine zweite GPU übertragen und dort wird Generation/Decode-Anteil berechnet. Am Ende wird beides wieder zusammengeführt und die Tokens werden ausgegeben.

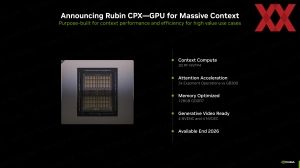

Um dies zu vereinfachen, stellt NVIDIA nun die Rubin-CPX-GPU vor. Diese basiert auf der Rubin-Architektur und dem gleichnamigen Chip, den NVIDIA in mehreren Ausführungen verwenden wird. Genau wie bei Blackwell, gibt es eine Blackwell-GPU, von denen für die Blackwell-Beschleuniger gleich zwei GPUs in einem Package sitzen. Analog wird dies für Rubin der Fall sein.

Im Falle der Rubin-CPX-GPU allerdings verwendet NVIDIA nur eine Rubin-GPU, also ein monolithisches Design. Diese kommt laut NVIDIA auf eine Rechenleitung von 30 PetaFLOPS im NVFP4-Datenformat. Die 128 GB GDDR7 sollen die notwendigen Daten aufnehmen können. Wie breit NVIDIA den Speicher anbindet, ist allerdings nicht bekannt. Man kann hier allerdings von einem 512 Bit breiten Speicherinterface ausgehen und damit dürfte die Speicherbandbreite im Bereich von 1,8 TB/s liegen.

Laut NVIDIA ist die Rubin-CPX-GPU für das Inferencing mit großen Kontext-Fenstern ausgelegt und soll darin um den Faktor drei schneller als der GB300-Beschleuniger sein. Zudem verfügt die GPU über jeweils vier NVENC- und NVDEC-Video-DE/Encoder, was im Hinblick auf die Videobearbeitung wichtig ist.

Ab Ende 2026 soll die Rubin-CPX-GPU zur Verfügung stehen, so dass NVIDIA hier einen längerfristigen Ausblick auf die kommenden Produkte gibt. Die Rubin-GPU hat vor wenigen Wochen den Tape-Out bei TSMC vollzogen.

Vera Rubin NVL144 und Vera Rubin NVL144 CPX

Während NVIDIA ab dem zweiten Halbjahr 2025 die Blackwell-Ultra-Beschleuniger als eine Art Refesh mit mehr Speicher und optimierter KI-Rechenleistung ausliefern will, wird ab der zweiten Jahreshälfte 2026 dann mit der Rubin-GPU, bzw. den Vera-Rubin-Beschleunigern gerechnet. Vera wird das neue CPU-Design sein, welches als Host und Bindeglied für die neue GPUs dient.

Im Zuge des AI Infra Summit wiederholt NVIDIA noch einmal die Grundspezifikationen für Vera Rubin. Die Racklösung Vera Rubin NVL144 soll auf eine Rechenleistung von 3,5 ExaFLOPS an NVFP4-Rechenleistung kommen und damit um den Faktor 3,3 schneller als die GB300-NVL72-Lösung sein. Sowohl das Training als auch das Inferencing sollen mittels Vera Rubin NVL144 bedient werden. Nicht verwirren lassen sollte man sich durch die Zählweise. Für die Blackwell-Systeme zählt NVIDIA die Anzahl der Blackwell-(Ultra)-Packages im Rack. Für GB200/GB300 sind dies 72 GPU-Packages mit insgesamt 144 GPUs darin. Mit Rubin wechselt die Zählweise auf einzelne GPUs. Somit kommt ein Vera-Rubin-NVL144-Rack weiterhin auf 144 GPUs.

Zudem bietet das komplette Rack 1,4 PB/s an HBM4-Speicherbandbreite und 75 TB an schnellen Speicher. Für den schnellen Speicher fasst NVIDIA den HBM4 der Rubin-GPUs und den LPDDR der Vera-CPUs zusammen. Ein GB300-NVL72-Rack kommt auf 40 TB an schnellem Speicher und eine Speicherbandbreite von 576 TB/s. Kombiniert wird die Beschleuniger-Hardware mit den dann ebenfalls neuen ConnectX-9-Netzwerklösungen.

Die Vera-Rubin-NVL144-Racks sollen ab der zweiten Jahreshälfte 2026 ausgeliefert werden.

Die Rubin-CPX-GPU wird es vermutlich als einzelne Beschleuniger, aber auch als Rack-Lösung geben. Im Compute-Tray befinden sich also nicht nur zwei Vera-Rubin-Beschleuniger, sondern auch gleich vier Rubin-CPX-GPUs. In dieser Konfiguration spricht NVIDIA von 8 ExaFLOPS an NVFP4-Rechenleistung, 1,7 PB/s an Speicherbandbreite und 100 TB an verfügbarem schnellem Speicher.

Die Vera-Rubin-NVL144-CPX-Racks werden Ende 2026 zur Verfügung stehen und bedient vor allem KI-Anwendungsbereiche mit großem Kontext-Fenster.

Schlussendlich sollen sich die beiden Rack-Lösungen kombinieren lassen. Dazu stehen die Vera-Rubin-NVL144-CPX- und -NVL144-Racks nebeneinander. Die Rechenleistung und Speicherbandbreite gibt NVIDIA in dieser Form identisch zum einzelnen Vera-Rubin-NVL144-CPX-Rack an, was sich uns nicht ganz erschließt. Beim Speicher spricht NVIDIA von dann zusammengenommen 150 TB.

Die Vera Rubin CPX Dual Rack Solution soll ebenefalls gegen Ende 2026 zur Verfügung stehen.

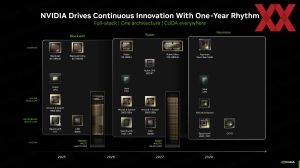

Roadmap-Innovation

Die Roadmap für die kommenden drei Jahre zeigte NVIDIA bereits auf der GTC 2025 auf, fügt dieser nun aber auch die Rubin-CPX-GPUs hinzu.

Mit der Rubin-Generation geht ein Wechsel auf NVLink der sechsten Generation einher. Der Durchsatz verdoppelt sich gegenüber der Blackwell-Generation auf 3.600 GB/s je Beschleuniger. In dieser Generation hält dann die Vera-CPU Einzug, zu der wir noch recht wenig wissen. Zudem wird die Netzwerkanbindung mittels der Spectrum-6-Chips doppelt so schnell und soll als Co-Packages Optics deutlich effizienter werden.

Mit Rubin-Ultra packt NVIDIA nicht mehr nur zwei, sondern bis zu vier GPUs in ein Package. Damit würde aus einem NVL144- theoretisch ein NVL288-System, allerdings will NVIDIA in seinen neuen Kyper-Racks doppelt so viele Beschleuniger wie aktuell unterbringen. Daher wird die Rack-Lösung als Vera Rubin Ultra NVL576 bezeichnet werden. Zudem wird die Rubin-Ultra-Generation auf HBM4E mit doppelt so vielen Stack setzen und damit die Kapazität noch einmal erhöhen. Rubin Ultra ist für 2027 vorgesehen.

Der Nachfolger Feynman soll dann 2028 erscheinen. Die Vera-CPU soll beibehalten werden. Für den schnellen HBM spricht NVIDIA nut von "Next-Gen HBM". Die Netzwerk- und Interconnect-Lösungen werden auf NVLink 8, Spectrum-7 und ConnnectX-10 setzen.