Werbung

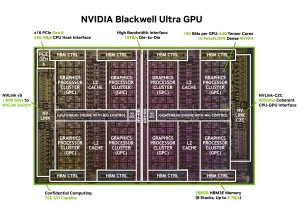

NVIDIA hat in seinem Blog sowie im Whitepaper zur Blackwell-Architektur (PDF) weitere Details zur Blackwell-Ultra-Generation der KI-Beschleuniger veröffentlicht. Darin wird nun auch deutlich, welche Änderungen NVIDIA auf Ebene der Hardware vorgenommen hat, denn diese sind weitreichender, als bisher vermutet.

So kamen die Blackwell-Chips der ersten Generation auf 144 Streaming Multiprozessoren (SM), während es bei Blackwell Ultra derer nun 160 sind. NVIDIA verwendet also einen abermals komplexeren Chip, macht bisher aber keinerlei Angaben zur Größe oder der Anzahl der Transistoren. Etwa 800 mm² oder etwas darüber sollten es aber sein und damit bewegt sich NVIDIA weiterhin am Limit dessen, was sich aktuell an Chips zu fertigen lässt.

Zudem sind je SM-Partition 256 KB an sogenanntem Tensor Memory (TMEM) vorhanden, der Speicherzugriffe auf den externen HBM3E reduzieren soll. Hinzu kommen noch weitere Special Function Units (SFUs) für transzendentale Mathematik und spezielle Operationen, die in KI-Kerneln verwendet werden. Die SFUs waren auch bei der Blackwell-GPU der ersten Generation bereits vorhanden.

Eine der zweiten offenkundigen Änderungen mit Blackwell Ultra ist der Einsatz von 12-Hi-HBM3E mit nun insgesamt 288 GB anstatt wie bisher 186 GB. Die Speicherbandbreite verbleibt bei 8 TB/s. Durch die höhere Kapazität wird aber bereits einer dieser Beschleuniger in die Lage versetzt, größere KI-Modelldaten zu fassen – gar nicht zu sprechen von den NVL72-Systemen, die auf 20,7 TB an HBM3E kommen.

| GB300 Grace Blackwell Ultra | GB200 Grace Blackwell | |

| GPU | Blackwell Ultra | Blackwell |

| CPU | Grace-Superchip (72 ARM-Kerne) | Grace-Superchip (72 ARM-Kerne) |

| CPU-Speicher | 480 GB LPDDR5X mit 512 GB/s | 480 GB LPDDR5X mit 512 GB/s |

| FP4 Tensor Core (Dense/Sparse) | 15 / 20 PFLOPS | 10 / 20 PFLOPS |

| FP8/FP6 Tensor Core (Dense/Sparse) | 5 / 10 PFLOPS | 5 / 10 PFLOPS |

| INT8 Tensor Core (Dense/Sparse) | 157,5 / 315 TFLOPS | 105 / 210 TFLOPS |

| FP16/BF16 Tensor Core (Dense/Sparse) | 2,5 / 5 PFLOPS | 2,5 / 5 PFLOPS |

| TF32 Tensor Core (Dense/Sparse) | 1,25 / 2,5 PFLOPS | 1,25 / 2,5 PFLOPS |

| FP32 | 80 TFLOPS | 80 TFLOPS |

| FP64 Tensor Core (Dense) | 1,3 TFLOPS | 40 TFLOPS |

| FP64 | 1,3 TFLOPS | 40 TFLOPS |

| HBM | 288 GB (HBM3E) | 186 GB (HBM3E) |

| Speicherbandbreite | 8 TB/s | 8 TB/s |

| NVLink-Interface | 1,8 TB/s | 1,8 TB/s |

| PCIe-Interface | PCIe 6.0 | PCIe 5.0 |

| TDP | 1.400 W | 1.200 W |

| Server-Option | GB300 NVL72 | GB200 NVL72 |

| HBM-Gesamtkapazität | 20,7 TB (HBM3E) | 13,5 TZB (HBM3E) |

| HBM-Gesamtbandbreite | 576 TB/s | 576 TB/s |

Auffällig sind vor allem die Punkte, dass Blackwell Ultra für die FP4-Rechenleistung deutlich schneller sein soll, was vermutlich mit der Einführung eines neuen Datenformats namens NVFP4 zu tun hat. Dazu kommen wir gleich noch. Allerdings scheint die INT8-Rechenleistung für Blackwell Ultra deutlich, genauer gesagt um den Faktor 32 geringer, auszufallen. Dies gilt auch für die FP64-Rechenleistung, die bei Blackwell im Vergleich zum Vorgänger Hopper schon gering war, mit Blackwell Ultra aber abermals reduziert wurde.

Die unterschiedliche Kapazität des HBM3E haben wir bereits angesprochen. Mit den Änderungen an der Hardware geht eine Erhöhung der TDP von 1.200 auf 1.400 W einher. Die Anbindung zwischen GPU und CPU erfolgt mit Blackwell Ultra nun mittels 16 PCI-Express-6.0-Lanes und somit 256 GB/s. Bei Blackwell war es mit PCI-Express 5.0 und 128 GB/s die Hälfte.

Neues NVFP4-Datenformat

Das NVFP4 Datenformat kombiniert eine zweistufige Skalierung – eine FP8 (E4M3)-Mikroblockskalierung, die auf 16-Wert-Blöcke angewendet wird, plus eine FP32-Skalierung auf Tensorebene. Damit wird eine hardwarebeschleunigte Quantisierung mit deutlich geringeren Fehlerraten als bei Standard-FP4 ermöglicht. Diese Tensor-Core-Funktion liefert eine Genauigkeit, die nahezu der von FP8 entspricht (mit einer Abweichung von oft weniger als einem Prozent), während der Speicherbedarf im Vergleich zu FP8 um etwa das 1,8-fache und im Vergleich zu FP16 um bis zu Faktor 3,5 reduziert werden kann.

Die Rechenleistung des Blackwell Ultra für das neue Datenformat NVFP4 bietet eine erhebliche Leistungssteigerung gegenüber der ursprünglichen Blackwell-GPU. Während die Basisarchitektur eine NVFP4-Leistung von 10 PFLOPS liefert, steigert Blackwell Ultra dies auf 15 PFLOPS.

Weitere Details zur Funktionsweise und Leistungssteigerung durch NVFP4 hat NVIDIA in einem gesonderten Beitrag veröffentlicht.

Die weitere Reduzierung der FP64-Rechenleistung lässt sich damit begründen, dass die Blackwell-Ultra-Beschleuniger ausschließlich für das Training, viel mehr noch für das Inferencing ausgelegt sind. FP64-Berechnungen sind in diesem Segment nicht notwendig.

Blackwell Ultra in Kürze verfügbar

Die Systeme mit Blackwell Ultra sollen sich bereits in der Massenproduktion befinden und werden bereits an die ersten Kunden ausgeliefert. Der Nachfolger Rubin soll vor wenigen Tagen oder Wochen den Tape-Out geschafft haben.