Werbung

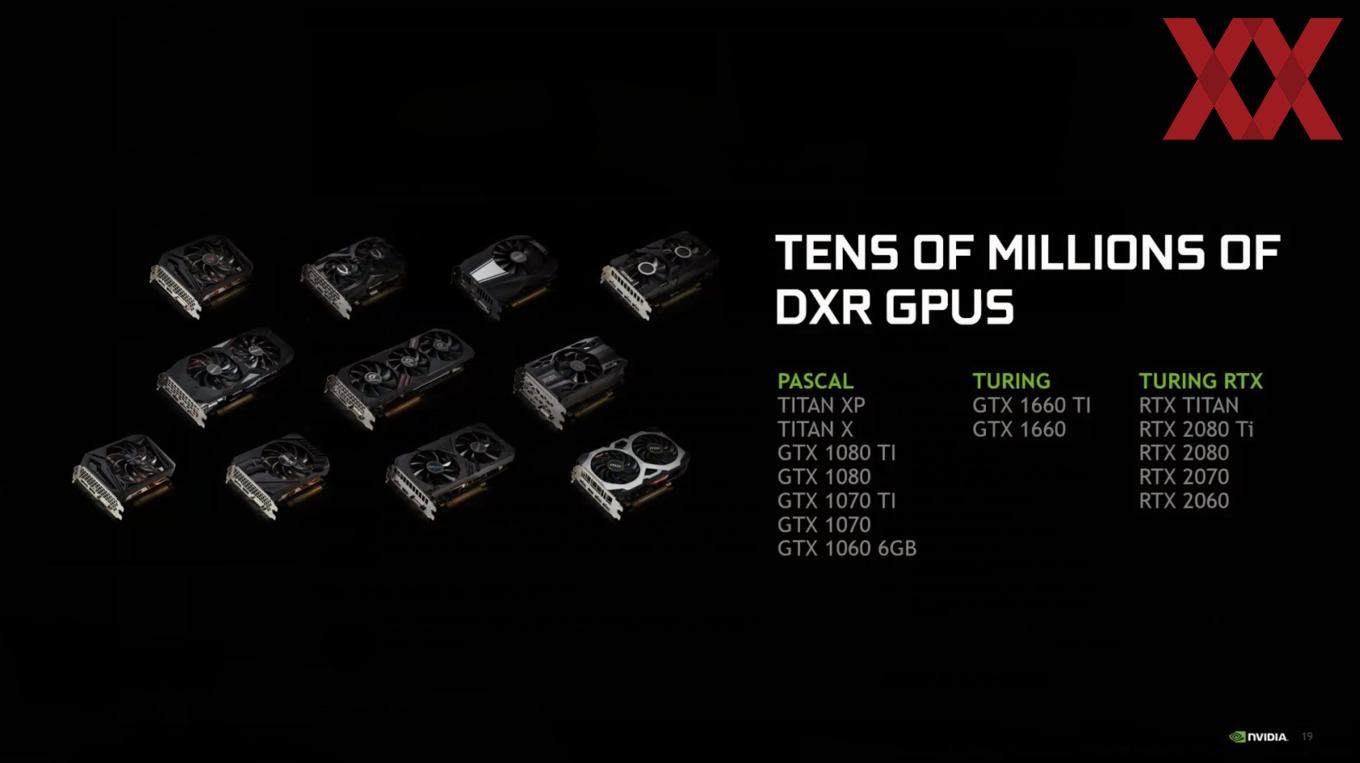

Wie üblich nutzen auch die Hardware-Hersteller die Game Developer Conference um ein paar Neuigkeiten unter die Entwickler und Endverbraucher zu streuen. Im Falle von NVIDIA ist der wichtigste Punkt die Tatsache, dass man mit einem Treiber-Update im April auch den Grafikkarten mit Pascal-GPU die Möglichkeiten einräumen wird, die DXR-Schnittstelle von Microsoft anzusprechen.

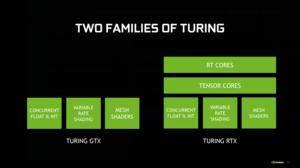

Im Falle der GeForce-RTX-GPUs geschieht dies über die RTX-Schnittstelle von NVIDIA. Die RT Cores dienen hier der Hardwarebeschleunigung. Alle GeForce-GTX-Karten (und auch solche anderer Herstellen) können die DXR-Softwareschnittstelle von Microsoft per Fallback aber auch anderweitig ansprechen. Eben diese Optionen bietet NVIDIA ab April für einige Karten auf Basis der Pascal-Architektur. Auch die Titan V und damit die einzige Desktop-Hardware auf Basis der Volta-Architektur wird unterstützt werden.

Dazu gehören die folgenden Modelle:

- Titan V

- Titan XP

- Titan X

- GeForce GTX 1080 Ti

- GeForce GTX 1080

- GeForce GTX 1070 Ti

- GeForce GTX 1070

- GeForce GTX 1060 6 GB

- GeForce GTX 1660 Ti

- GeForce GTX 1660

Mit Erscheinen des Treibers werden wir uns die DXR-Leistung der GeForce-GTX-Karten in den verschiedenen Spielen anschauen. Man darf gespannt sein, ob es den Karten überhaupt möglich sein wird, in bestimmten Auflösungen und mit den zur Verfügung stehenden DXR-Einstellungen auch flüssige Frameraten zu erreichen.

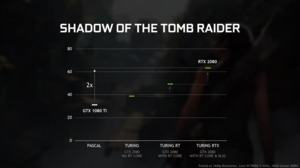

Für NVIDIA ist die GDC zudem eine gute Gelegenheit die Vorteile von DXR und RTX herauszustellen. Neben dem eher unbekannten Dragon Hound hat man aber wenige Neuankündigungen in dieser Richtung zu machen. Der DXR-Patch für Shadow of the Tomb Raider zur Berechnung von Schatten mittels Ray Tracing scheint aber kurz bevor zu stehen. Ebenfalls bereits bekannt ist, dass die Unreal Engine und Unity die DXR-Schnittstelle nativ werden ansprechen können. Somit profitieren auch die GeForce-RTX-Karten, denn hier dann eine Hardwarebeschleunigung über die RT Cores statt.

NVIDIA rechtfertigt Entwicklung der Turing-Architektur

Viel Kritik gab und gibt es an der aktuellen Turing-Generation von NVIDIA. Die Menge an Grafikspeicher ist nicht gestiegen, wenngleich hier gerne die deutlich gestiegene Speicherbandbreite ignoriert wird. Weiterhin ist die Leistung von Generation zu Generation für viele nicht in dem Maße gestiegen, wie sie dies erwartet haben.

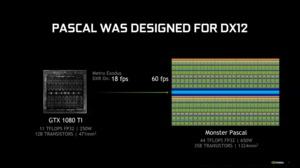

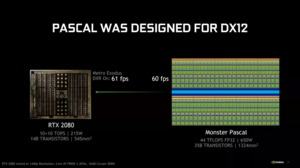

Offenbar sieht sich NVIDIA dazu berufen, die Entscheidungen hinter der Entwicklung der Turing-Architektur noch einmal zu begründen. Während die Pascal-Architektur auf klassische Shaderleistung ausgelegt war, wurde Turing klar auf die Ray-Tracing-Funktionen hin optimiert. Hätte man die Pascal-Architektur auf die dazu notwendige Leistung bringen wollen, wäre eine hypothetische Pascal-GPU mit 35 Milliarden Transistoren und einer Chipfläche von 1.324 mm² technisch nicht umsetzbar gewesen. Der Stromverbrauch hätte sich mit 650 W ebenso in einem unverhältnismäßig hohen Rahmen bewegt.

Stattdessen hat man die Turing-Architektur entwickelt. Die TU102-GPU erreicht auf 545 mm² und mit 14 Milliarden Transistoren bei 215 W eine ebenso hohe Rechenleistung.

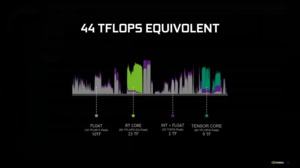

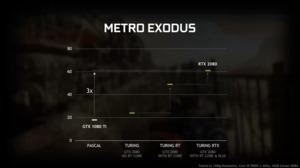

Um dies vergleichen zu können, muss man sich jedoch auch die Art und Weise der Berechnungen anschauen, die für ein Spiel mit DXR-Effekten notwendig sind. NVIDIA tut dies am Beispiel eines Frames in Metro: Exodus. Alleine schon das mit der Turing-Architektur eingeführte Hybrid-Shading durch die parallele Verwendung von Fließkomma- (FP32) und Integer-Berechnungen (INT32) verbessert die Leistung für Ray-Tracing-Berechnungen deutlich.

Der Einsatz der RT Cores für die Berechnung der Bounding Volume Hierarchy (BVH) sowie der Tensor Cores hat die Zeit zur Berechnung eines Frames erst in Bereiche drücken können, in denen flüssig Frameraten umgesetzt werden konnten.

Die Ray-Tracing-Berechnungen auf "alten" GeForce-GTX-Karten (Pascal und älter) sind demnach deutlich langsamer als auf den neuen GeForce-RTX-Karten. Umso erstaunlicher ist es, dass NVIDIA überhaupt die Option anbieten wird, per Treiber das DXR auch auf älteren Karten zu ermöglichen.

Für NVIDIA aber dürfte es wichtig sein die notwenige Basis für die Entwickler zu schaffen, denn nur mittels der vorhandenen GeForce-RTX-Karten ist diese noch nicht groß genug, um mehr und mehr Entwickler auch davon zu überzeugen, auf DXR-Effekten zu setzen und diese einzubauen. Es dürfte aber auch wichtig sein, dass weitere Hersteller mitspielen und dazu gehört vor allem zunächst einmal AMD. Ob wir bereits auf der diesjährigen GDC eine Ankündigung sehen werden, bleibt abzuwarten.