Niftu Cal

Enthusiast

- Mitglied seit

- 02.12.2018

- Beiträge

- 5.167

Eher die 7950 XT, mindestens. Oder willst du daran glauben dass mehr als die dreifache Menge Shader, vierfacher Infinity cache und 50 % mehr Speicherinterface nicht mindestens doppelt so viel Leistung bringen?Also, wenn ich dich richtig verstehe, gehst du davon aus, dass die 7900XT im Vergleich zur 6900XT doppelt so flott sein wird?

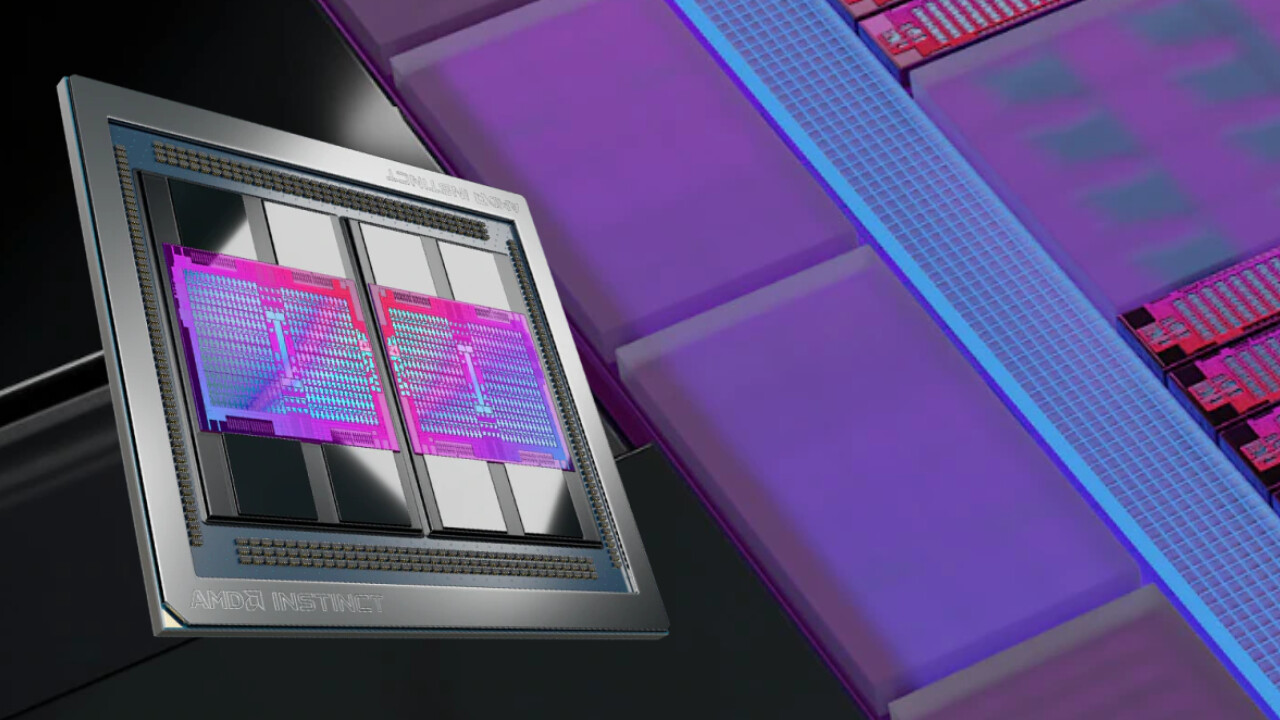

Der Hauptgrund ist allerdings die MCM-Architektur, schau dir einfach mal Zen 1 an und den damit verbundenen Leistungszuwachs an. AMD gelang es damals in einem Schlag einigermaßen mit Intel in Sachen singlethread aufzuholen (was angesichts der grausamen FX-Prozessoren wie eine Auferstehung war) und lieferte im Multithread mehr Leistung und bessere Effizienz als die teuren HEDT-Modelle zu einem vernünftigen Preis. Das wäre ohne MCM nie möglich gewesen. Genauso der Threadripper oder EPYC. Wenn die das richtig umsetzen sehen wir vielleicht bald endlich wieder höhere zweistellige Leistungszuwächse.