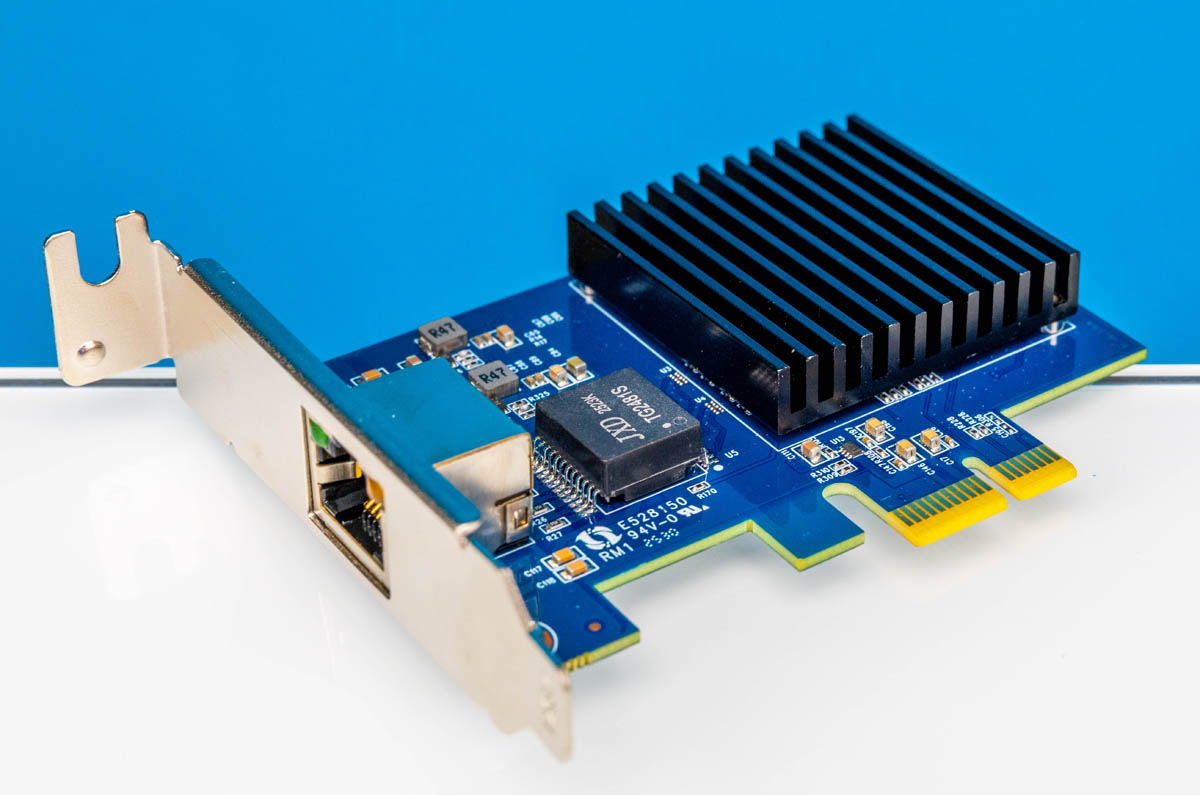

Eines ist jedenfalls klar. Wenn man die Vorteile eines 10 GBit/s Netzwerks nutzen möchte, braucht man wenige große Dateien. Und nicht Zillionen kleiner Dateien...

Bei Backups packe ich viele kleine Dateien in eine oder mehrere große Backup-Dateien. Dann kann man auch gut komprimieren. Da ich unter Linux arbeite, verwendet ich dafür tar. Solche Programme gibt es aber bestimmt auch unter Windows.

Auch unter Linux gibt es Backup-Programme, die für Backups Kopien von einzelnen Dateien erstellen, zumindest bei dem ersten Aufruf. Bei späteren Durchläufen werden nur Kopien von Dateien angelegt, die sich geändert haben. Diese Programme nutzt man aber typischerweise nichts übers Netzwerk. Und wenn doch, dann lässt man sie automatisch im Hintergrund laufen. Dann stören auch ein paar Stunden Zeitbedarf nicht.

Bei Backups packe ich viele kleine Dateien in eine oder mehrere große Backup-Dateien. Dann kann man auch gut komprimieren. Da ich unter Linux arbeite, verwendet ich dafür tar. Solche Programme gibt es aber bestimmt auch unter Windows.

Auch unter Linux gibt es Backup-Programme, die für Backups Kopien von einzelnen Dateien erstellen, zumindest bei dem ersten Aufruf. Bei späteren Durchläufen werden nur Kopien von Dateien angelegt, die sich geändert haben. Diese Programme nutzt man aber typischerweise nichts übers Netzwerk. Und wenn doch, dann lässt man sie automatisch im Hintergrund laufen. Dann stören auch ein paar Stunden Zeitbedarf nicht.

Zuletzt bearbeitet: