Liebe Community,

ich habe mich schon sehr auf diesen Test gefreut! Als das Paket für den Lesertest von Synology aus Düsseldorf ankam, brachte es 4 Kilogramm auf die Waage. Mich juckte es natürlich sofort in den Fingern, also geht's direkt zum Unboxing.

Die Synology ActiveProtect DP320 erinnert äußerlich stark an andere DiskStation-Modelle - und außen enden die Gemeinsamkeiten nicht. Es handelt sich um ein kompaktes 2-Bay-Gerät, mitgeliefert werden zwei Synology HAT3310-8T-Festplatten mit jeweils 8 TB Kapazität. In den Käuferinformationen wird die DP320 für Umgebungen mit einem maximalen Datenbestand von 5 TB im Cluster mit bis zu 2.500 weiteren Appliances als Follower-Node empfohlen.

Beim Auspacken fällt mir das 65-Watt-Netzteil ins Auge. Der Stromanschluss sieht proprietär aus. Hier hätte es durchaus auch ein USB-C und womöglich GAN-Netzteil sein können, wobei wahrscheinlich Stabilität und Zuverlässigkeit den Ausschlag gegeben haben.

Wirft man einen Blick auf das Innere der DP320, fallen die Gemeinsamkeiten mit der DiskStation DS723+ auf. Der wesentliche Unterschied liegt im neuen ActiveProtect Betriebssystem, das erst Ende 2024 in Version 1.0 released wurde und seitdem zwei kleine Updates erhalten hat.

Eingeführt wurde GBit-Ethernet übrigens 1999. Damals war Windows 98 der neuste Schrei

Ein Blick auf die Kompatibilitätsliste offenbart zudem, dass nur sehr wenig Zubehör mit der DP320 kompatibel ist – ausschließlich USV-Systeme. Auch bei den Festplatten gibt es keine Wahlfreiheit; unterstützt werden ausschließlich die proprietären Synology-Laufwerke, die bei 8 TB Volumen mit einem Mehrpreis von 40-50 Euro gegenüber der Konkurrenz einhergehen. Neben BTRFS, das viele Funktionen der DP320 von Haus aus mitbringt, etwa Prüfsummen zur Konsistenznutzung, und auf der Appliance zum Einsatz kommt, schützt weiterhin ECC-Speicher vor potentiell katastrophalen Speicherfehlern. Auch dies ist ein Unterschied zur Consumer-Reihe, die ECC zwar unterstützt aber zumeist ohne ihn ausgeliefert wird.

Der R1600 wird seit Februar 2020 verkauft und gehört zur ersten Ryzen-Generation, noch aus 14nm-Fertigung - damit ist auch er gut abgehangen. Betrachtet man die Entwicklung der Ryzen-Reihe, wäre eine aktuellere CPU hinsichtlich des Stromverbrauchs erfreulich, hinsichtlich der Anforderungen allerdings auch unterfordert gewesen. Vergleicht man die Rohleistung des R1600 mit der des Intel N100 von 2023 mit 6 Watt TDP, ist letzterer knapp 80% schneller, kommt allerdings auch ohne ECC. Wie bereits festgestellt wäre die Mehrleistung kaum relevant, die höhere Effizienz wurmt jedoch etwas.

Ersatzteile sind direkt bei Synology erhältlich und wirken erschwinglich.

Ein kleines Hindernis für Linux-Nutzer: Den Synology Assistant gibt es offiziell nur für Debian-basierte Systeme. Für mein Fedora 42 musste ich ihn mittels alien in eine RPM-Datei umwandeln - schade, weil es etwa den Synology Active Backup for Business Agent auch nativ für Fedora gibt. Dazu allerdings später mehr...

Die Installation des Betriebssystems selbst verlief danach problemlos. Die Einrichtung erinnert stark an den DSM-Installationsprozess, wobei das ActiveProtect Manager (APM) Interface in geschäftlichem Grau statt dem bekannten DSM-Blau gehalten ist. Nach der Grundkonfiguration erhält man Zugriff auf zwei unterschiedliche Useroberfläche: Den ActiveProtect Manager (Port 443) für die Backup-Funktionen und die Management Console (Port 5001) für systemnahe Einstellungen - zunächst durchaus verwirrend, allerdings lassen sich mit dem APM auch bis zu 2.500 DP320 in einem Verbund einsetzen und zentral steuern, was bei einer einzelnen Maschine hinfällig ist.

Wake on LAN funktioniert über den Synology Assistant problemlos und ermöglicht das Ein- und Ausschalten über das Netzwerk. Eine Automatisierungsfunktion dafür habe ich nicht gefunden - die Festplatten sind allerdings ohnehin für den Dauerbetrieb ausgelegt.

Im Vergleich zu klassischen Synology NAS-Geräten mit DSM fehlen der DP320 einige Netzwerkfunktionen wie beispielsweise die WireGuard-Unterstützung. Dafür bietet sie Konfigurationsmöglichkeiten für Air-Gapped-Backups mit Allow- und Blocklisten, die nachführend noch genauer beleuchtet werden.

Die grundlegenden Optionen bieten wenig Überraschungen. Das RAID-Level kann nicht geändert werden – die DP320 ist fest auf RAID 1 eingestellt, auch die Einrichtung eines SSD-Caches ist nicht möglich. Ersteres ist logisch, letzteres beim 1 GBit-Port und im Backup-Szenario ohnehin nur begrenzt sinnvoll. Das Gerät ist eben eine Appliance und weniger auf Flexibilität als auf eine vordefinierte, ausdokumentierte (siehe etwa Knowledge Center und Software Specs) und zuverlässige Funktionalität ausgelegt.

Was ihr an Funktionen gegnüber hausgemachten Lösungen mit Duplicati, BorgBackup, Restic, Kopia oder rsync abgeht, macht sie durch Zuverlässigkeit wieder wett.

Während der Installation fällt auf, dass der Agent auf Kernel-Ebene installiert wird und damit tiefgehende Systemrechte benötigt – ein zweischneidiges Schwert. Einerseits ermöglicht das vollständige Backups des Systems, andererseits stellt sich die Frage, ob man wirklich Integration auf Kernelebene wünscht, da dies potentiell schwerwiegende Sicherheitslücken öffnet, falls der Client selbst kompromittiert werden sollte.

Positiv fällt die Robustheit der Backups auf: Bei einer LAN-Unterbrechung lief der Prozess im Hintergrund weiter und wurde auch nach einem Neustart des Rechners automatisch vervollständigt.

Es können mehrere Pläne parallel bedient werden - etwa wöchentliche und tägliche.

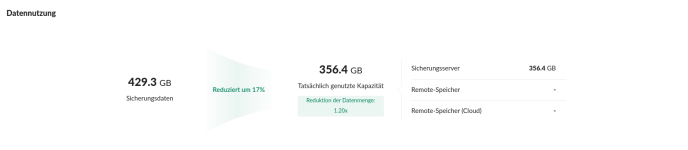

Die DP320 erreichte einen Deduplizierungsfaktor von 1,2 - es wurden also nur 352 GB auf den Festplatten belegt. Der R1600 dümpelte während der Sicherung bei etwa 30% Auslastung, hätte also durchaus Kapazität für eine stärkere Komrimierung gehabt. BTRFS bietet hierfür Optionen, auch die Wahl der entsprechenden Algorithmen. Schade, dass diese nicht wählbar sind - es wurde wohl ein sicherer Standard zugunsten der Stabilität gewählt.

Nach dem ersten Backup zog ich eine 8,5 GB große Steam-Installation von "Supreme Commander: Forged Alliance" (Shoutout an das Community-Projekt Forged Alliance Forever - FAF) auf das C-Laufwerk. Das anschließende Backup belegte wie erwartet nur den zusätzlichen Speicher dieser Installation. Praktisch für Umgebungen mit vielen ähnlichen Systemen!

Der ActiveProtect Agent bietet die Möglichkeit, die maximale Übertragungsgeschwindigkeit zu begrenzen – auch zeitabhängig. So kann man die Netzwerkbelastung während der Arbeitszeiten reduzieren und intensive Backup-Aktivitäten in die Nacht verlagern. Möglich ist dies auch zentral über den Manager.

Für vollständige System- oder Volume-Wiederherstellungen wird das Recovery-Tool benötigt. Dieses ist nicht remote nutzbar, sondern erfordert das Booten vom erstellten Wiederherstellungsmedium. Das Wiederherstellungstool lädt erstmal eine gesamte Windows-PE-Installation herunter, was unter Windows einen Neustart und ca. 8 GB an Downloads erfordert. Etwas nervig für einen USB-Stick, der nur ca. 1 GB Speicher belegt und keine WLAN-Treiber mitbringt. Die Automatische Datenträgerzuordnung während der Wiederherstellung ("Bestimmtes Volume wiederherstellen") ordnete meine Festplatten zudem falsch zu und wollte das D-Laufwerk überschreiben, sodass ich letztendlich die Wiederherstellung des gesamten Systems auswählte.

Diese Lief problemlos und dauerte etwa 58 Minuten, wobei der R1600 sich bei ca. 28% Auslastung langweilte. Eine verpasste Chance: warum kommt die Deduplikation nur beim Backup und nicht bei der Wiederherstellung zum Einsatz, damit nur nicht-identische Blöcke wiederhergestellt werden? Die Wiederherstellung nutzt derzeit Brute-Force und schont damit die CPU-Leistung, verschwendet aber überflüssig Netzwerkbandbreite und Zeit -schade, das geht raffinierter.

Mit dem Recovery Media Creator lassen sich auch ganze Wiederherstellungsmedien erstellen, wobei sich die Anleitung für Linux etwas gruselig liest

Notfallszenarien wie einen Ausfall habe ich mir eher bei den Backups angeschaut, da die Wiederherstellungen eben vor allem vollständig erfolgen - hier ist ein Systemabsturz natürlich katastrophal, bzw. muss die Wiederherstellung danach erneut angestoßen werden.

Man hat häufig so lange ein Backup, bis man es testet. Der ActiceProtect Manager bietet hierfür Test-Optionen, wobei jene für Virtuelle Maschinen hervorzuheben sind, die testweise gebooted und dabei per Video aufgezeichnet werden können.

Der Idle-Betrieb sieht so aus:

Lüfter semi-passiv, idle

Lüfter niedrig, idle

Lüfter hoch, idle

Lüfter niedrig, load

Die Wärmeentwicklung bleibt auch unter Volllast im moderaten, handwarmen Bereich. Auch die integrierten Temperatursensoren zeigen unkritische Werte, die Festplatten verbleiben weit unter 40 Grad.

Bei einem Strompreis von 30 Cent und einem von sieben Tagen, an dem Backups laufen, ergeben sich jährliche Stromkosten von 65,70 Euro. Als Privatutzer fehlen mir hier von klassischen NAS bekannte Energiesparfunktionen wie Spin-down oder WakeOnLAN - wie schon angemerkt gehen diese allerdings auf Kosten der HDD-Lebenszeit, auch wenn es durchaus interessante Berichte von Anwendern gibt, die genau das seit zehn Jahren mit ZFS auf Consumer-Platten ohne Datenverlust umsetzen.

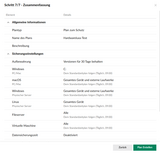

Weiterhin lassen sich flexible Aufbewahrungsrichtlinien konfigurieren, um etwa regulatorische Anforderungen zu erfüllen. Außerdem lassen sich Snapshots der Sicherungen erstellen, die einen punktuellen Zustand des Backups bewahren und später wiederhergestellt werden können.

Die Ratio dahinter ist wahrscheinlich, dass man im Fall der Fälle schnell wieder handlungsfähig sein will. Verschlüsselung kommt nur bei der Übertragung von Backup-Kopien zu externen Speichern wie ActiveProtect Vault, C2 Object Storage oder Amazon S3 zum Einsatz.

Die sogenannten "Verbindungsschlüssel", die bei der Konfiguraton des Clients zum Einsatz kommen, dienen lediglich zur Authentifizierung der Verbindung zwischen dem ActiveProtect-Agent und dem Backup-Server. Diese Verbindung widerum wird per https mit einem einstellbaren Zertifikat abgesichert. Es gibt also eine Transportverschlüsselung.

Je nach Umgebung, in der die DP320 zum Einsatz kommt, sorgt dies dafür, dass weitere Sicherheitsmanahmen wie ein physischer Schutz des Gerätes umgesetzt werden müssen. So ist es ratsam, die Systeme bereits vor dem Backup zu verschlüsseln und die Admin-Accounts unbedingt und auf jeden Fall mit Zwei-Faktor-Authentifizierung abzusichern.

Die Usereroberfläche ist in zwei Komponenten unterteilt:

Im Vergleich zum vielseitigen DSM ist der APM sehr reduziert. Es gibt kein Package Center für zusätzliche Anwendungen, keine Medienserver-Funktionen und keine Virtualisierungsoptionen abseits der Backupprüfung. Es handelt sich eben um eine Backup-Appliance und kein NAS. Die Fokussierung trägt allerdings zur Stabilität und Sicherheit bei und vereinfacht die Administration für weniger erfahrene User. Der APM bietet:

Interessant ist auch die Replikationsfunktion, mit der Backups automatisch auf andere Synology-Geräte oder Cloud-Speicher gespiegelt werden können. Das hilft für eine 3-2-1-Backup-Strategie mit mehreren Speicherorten.

Für die Remote-Verwaltung stehen keine Apps zur Verfügung, der Zugriff erfolgt ausschließlich über die Weboberfläche.

Seit Release am 19. Dezember 2024 gab es zwei Updates - für ein Betriebssystem erscheint mir das recht selten, es entspricht allerdings dem DSM-Rhythmus. Der Track record bezüglich Sicherheit des DSM sieht ordentlich aus. ActiveProtect ist noch ziemlich neu und ich konnte keine Angaben zur Dauer des Supports finden, was mich überrascht hat. Typisch für Synology wären mindestens fünf Jahre, wobei es im Business-Bereich auch länger sein könnte.

Es gibt allerdings auch deutliche Schwachpunkte: - Ach, Moment, jetzt klingelt gerade das Telefon. Ah, es sind die 2000er, die gerne ihren LAN-Anschluss zurück hätten. Aber wo war ich? - Der 1-GBit-Port ist anachronistisch und bei diesem Preis eine Zumutung, wenn 2,5GBit 5er Switches wie das UniFiSwitch Flex Mini schon für 55,- Euro zu haben sind. Es ist unverständlich, warum Synology hier nicht wenigstens 2,5 GBit spendiert hat, zumal der verbaute R1600 deutlich mehr könnte und das nächst-größere Modell direkt einen Sprung auf 10GBit macht. Auch die fehlende Verschlüsselung der Backups irritiert.

Zudem ist der Vendor Lock-in unübersehbar: durch ein Software-lock werden nur Synology-eigene Festplatten unterstützt. Im Vergleich zu DSM-basierten Systemen fehlt es an Flexibilität. Mit 23-24 Watt im Leerlauf ist der Stromverbrauch für einen Mini-Server ebenfalls recht hoch.

Für wen ist das Gerät also geeignet? Aus meiner Sicht für kleine bis mittlere Unternehmen und besonders solche mit homogenen Microsoft-Umgebungen, die eine schlüsselfertige Backup-Lösung ohne tiefes technisches Know-how suchen. Und diese werden mit der DP320 auch gut bedient. Sie bietet Planbarkeit und professionellen Support, was für viele KMUs entscheidend ist.

Für technisch versierte Heimanwender ist sie mit rund 1.700 Euro zu teuer bei zu wenig Flexibilität. Ein klassisches NAS, etwa mit DSM, bietet hier deutlich mehr Spielraum. Für Umgebungen mit strengeren Sicherheitsanforderungen hinsichtlich Verschlüsselung sind möglicherweise DSM-basierte Lösungen mit Active Backup for Business und zusätzlichen Verschlüsselungsfunktionen die bessere Wahl.

Vielen lieben Dank an Hardwareluxx und Synology für die Möglichkeit zu diesem Test! Ich hoffe, er war interessant.

Fragen? Fragen!

ich habe mich schon sehr auf diesen Test gefreut! Als das Paket für den Lesertest von Synology aus Düsseldorf ankam, brachte es 4 Kilogramm auf die Waage. Mich juckte es natürlich sofort in den Fingern, also geht's direkt zum Unboxing.

1. Einrichtung und Grundfunktionen

Unboxing und Ersteindruck

Aus meiner Sicht bringen die Synology-Geräte optisch immer wieder ein gutes Gleichgewicht aus Eleganz und Schlichtheit mit. Auch wenn das Gehäuse aus Plastik besteht, verleihen das kantige Design und das matte Anthrazit dem Gerät ein wohnzimmertaugliches Understatement - typisch Synology.Die Synology ActiveProtect DP320 erinnert äußerlich stark an andere DiskStation-Modelle - und außen enden die Gemeinsamkeiten nicht. Es handelt sich um ein kompaktes 2-Bay-Gerät, mitgeliefert werden zwei Synology HAT3310-8T-Festplatten mit jeweils 8 TB Kapazität. In den Käuferinformationen wird die DP320 für Umgebungen mit einem maximalen Datenbestand von 5 TB im Cluster mit bis zu 2.500 weiteren Appliances als Follower-Node empfohlen.

Beim Auspacken fällt mir das 65-Watt-Netzteil ins Auge. Der Stromanschluss sieht proprietär aus. Hier hätte es durchaus auch ein USB-C und womöglich GAN-Netzteil sein können, wobei wahrscheinlich Stabilität und Zuverlässigkeit den Ausschlag gegeben haben.

Wirft man einen Blick auf das Innere der DP320, fallen die Gemeinsamkeiten mit der DiskStation DS723+ auf. Der wesentliche Unterschied liegt im neuen ActiveProtect Betriebssystem, das erst Ende 2024 in Version 1.0 released wurde und seitdem zwei kleine Updates erhalten hat.

Ausstattung und technische Daten

- Prozessor: AMD Ryzen Embedded R1600, 2C/4T, 2.60-3.10GHz, 4MiB+1MiB Cache, 15W TDP, 12-25W cTDP, Codename "Banded Kestrel (Raven2)" (Zen 1, GF 14nm)

- Arbeitsspeicher: 8GB DDR4 ECC SO-DIMM (2x 4GB)

- Speicher: 16TB (2x 8TB Synology HAT3310-8T HDDs im RAID 1) (Festplattenkompatibilität laut Synology)

- Netzwerk: 1x RJ-45 (1000Base-T, Datenübertragung), 1x RJ-45 (1000Base-T, Management-Port)

- Anschlüsse: 1x USB 3.0 (5Gb/s)

- Abmessungen: 106 x 166 x 223 mm (BxHxT)

- Lüfter: 1x 92mm

- Gewicht: 2,9 kg

- Besonderheiten: Kensington Security Slot, Synology ActiveProtect Manager

- Garantie: 36 Monate

Eingeführt wurde GBit-Ethernet übrigens 1999. Damals war Windows 98 der neuste Schrei

Ein Blick auf die Kompatibilitätsliste offenbart zudem, dass nur sehr wenig Zubehör mit der DP320 kompatibel ist – ausschließlich USV-Systeme. Auch bei den Festplatten gibt es keine Wahlfreiheit; unterstützt werden ausschließlich die proprietären Synology-Laufwerke, die bei 8 TB Volumen mit einem Mehrpreis von 40-50 Euro gegenüber der Konkurrenz einhergehen. Neben BTRFS, das viele Funktionen der DP320 von Haus aus mitbringt, etwa Prüfsummen zur Konsistenznutzung, und auf der Appliance zum Einsatz kommt, schützt weiterhin ECC-Speicher vor potentiell katastrophalen Speicherfehlern. Auch dies ist ein Unterschied zur Consumer-Reihe, die ECC zwar unterstützt aber zumeist ohne ihn ausgeliefert wird.

Der R1600 wird seit Februar 2020 verkauft und gehört zur ersten Ryzen-Generation, noch aus 14nm-Fertigung - damit ist auch er gut abgehangen. Betrachtet man die Entwicklung der Ryzen-Reihe, wäre eine aktuellere CPU hinsichtlich des Stromverbrauchs erfreulich, hinsichtlich der Anforderungen allerdings auch unterfordert gewesen. Vergleicht man die Rohleistung des R1600 mit der des Intel N100 von 2023 mit 6 Watt TDP, ist letzterer knapp 80% schneller, kommt allerdings auch ohne ECC. Wie bereits festgestellt wäre die Mehrleistung kaum relevant, die höhere Effizienz wurmt jedoch etwas.

Ersatzteile sind direkt bei Synology erhältlich und wirken erschwinglich.

Installation und erste Inbetriebnahme

Die Festplatteninstallation ist identisch zu anderen Synology-Geräten und erfolgt werkzeuglos und komfortabel über die bekannten Trays, was problemlos und angenehm von der Hand geht. Ich benötigte etwa 30 Minuten bis zur vollständigen Betriebsbereitschaft inklusive Erstinstallation des Betriebssystems. Unerwartet war die erfolglose Netzwerkerkennung: Weder über find.synology.com noch über activeprotect:5000, wie im Handbuch angegeben, war das Gerät auffindbar, was höchstwahrscheinlich an meiner Netzkonfiguration liegt. Synology bietet für diesen Fall den Synology Assistant an, aber natürlich wäre das auch über meinen Router oder Netzwerk-Pings möglich gewesen.Ein kleines Hindernis für Linux-Nutzer: Den Synology Assistant gibt es offiziell nur für Debian-basierte Systeme. Für mein Fedora 42 musste ich ihn mittels alien in eine RPM-Datei umwandeln - schade, weil es etwa den Synology Active Backup for Business Agent auch nativ für Fedora gibt. Dazu allerdings später mehr...

Die Installation des Betriebssystems selbst verlief danach problemlos. Die Einrichtung erinnert stark an den DSM-Installationsprozess, wobei das ActiveProtect Manager (APM) Interface in geschäftlichem Grau statt dem bekannten DSM-Blau gehalten ist. Nach der Grundkonfiguration erhält man Zugriff auf zwei unterschiedliche Useroberfläche: Den ActiveProtect Manager (Port 443) für die Backup-Funktionen und die Management Console (Port 5001) für systemnahe Einstellungen - zunächst durchaus verwirrend, allerdings lassen sich mit dem APM auch bis zu 2.500 DP320 in einem Verbund einsetzen und zentral steuern, was bei einer einzelnen Maschine hinfällig ist.

Management Console

Nach der Installation bin ich erstmal die Management-Konsole der Appliance durchgegangen, die etwas versteckt auch via APM erreichbar ist. Die Einstellungsmöglichkeiten sind sehr umfangreich und dadurch etwas verschachtelt.Netzwerk-Konfiguration und Limitierungen

Die DP320 verfügt über zwei 1-Gigabit-Ethernet-Anschlüsse, wobei einer ausschließlich für Management-Zwecke vorgesehen ist und der andere für die Datenübertragung. Auf meine Anfrage beim Synology-Support erhielt ich die Bestätigung, dass Link Aggregation von der DP320 nicht unterstützt wird und diese Funktion nur bei DP-Modellen mit mehreren Datenübertragungsports verfügbar ist, was allein auf das größte Modell der Reihe, die DP7200, zutrifft - ärgerlich! Im Handbuch las sich das etwas anders. Die Supportanfrage verlangte von mir das Anlegen eines Kontos, wurde dann allerdings auch innerhalb weniger Stunden beantwortet. Ein Umstand, den Unternehmen sehr wertschätzen dürften.Wake on LAN funktioniert über den Synology Assistant problemlos und ermöglicht das Ein- und Ausschalten über das Netzwerk. Eine Automatisierungsfunktion dafür habe ich nicht gefunden - die Festplatten sind allerdings ohnehin für den Dauerbetrieb ausgelegt.

Im Vergleich zu klassischen Synology NAS-Geräten mit DSM fehlen der DP320 einige Netzwerkfunktionen wie beispielsweise die WireGuard-Unterstützung. Dafür bietet sie Konfigurationsmöglichkeiten für Air-Gapped-Backups mit Allow- und Blocklisten, die nachführend noch genauer beleuchtet werden.

Die grundlegenden Optionen bieten wenig Überraschungen. Das RAID-Level kann nicht geändert werden – die DP320 ist fest auf RAID 1 eingestellt, auch die Einrichtung eines SSD-Caches ist nicht möglich. Ersteres ist logisch, letzteres beim 1 GBit-Port und im Backup-Szenario ohnehin nur begrenzt sinnvoll. Das Gerät ist eben eine Appliance und weniger auf Flexibilität als auf eine vordefinierte, ausdokumentierte (siehe etwa Knowledge Center und Software Specs) und zuverlässige Funktionalität ausgelegt.

Was ihr an Funktionen gegnüber hausgemachten Lösungen mit Duplicati, BorgBackup, Restic, Kopia oder rsync abgeht, macht sie durch Zuverlässigkeit wieder wett.

2. Backup-Funktionen und ActiveProtect Manager

Client-Software und Kompatibilität

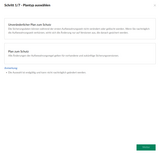

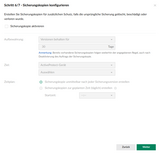

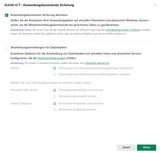

Die Sicherung von Systemen abseits von Servern mit Dateifreigaben erfolgt über eine Client-Software. Die Installation des Synology ActiveProtect Agent verläuft unter Windows unkompliziert und intuitiv. Für Linux-Systeme bietet Synology RPM- und DEB-Pakete an, allerdings mit erheblichen Einschränkungen. Aktuelle Linux-Versionen wie Fedora ab Version 41 werden nicht unterstützt (nur bis Kernel 6.8 von März 2024). Mobile Plattformen (iOS/Android) werden gar nicht bedient. Das hatte ich nicht erwartet.Während der Installation fällt auf, dass der Agent auf Kernel-Ebene installiert wird und damit tiefgehende Systemrechte benötigt – ein zweischneidiges Schwert. Einerseits ermöglicht das vollständige Backups des Systems, andererseits stellt sich die Frage, ob man wirklich Integration auf Kernelebene wünscht, da dies potentiell schwerwiegende Sicherheitslücken öffnet, falls der Client selbst kompromittiert werden sollte.

Positiv fällt die Robustheit der Backups auf: Bei einer LAN-Unterbrechung lief der Prozess im Hintergrund weiter und wurde auch nach einem Neustart des Rechners automatisch vervollständigt.

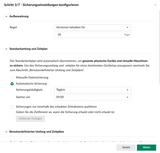

Es können mehrere Pläne parallel bedient werden - etwa wöchentliche und tägliche.

Backup-Performance und Deduplizierung

In meinem Test habe ich ein C-Laufwerk mit 422,5 GB Belegung von einer NVMe-SSD per LAN gesichert. Die Sicherung kann entweder zentral vom ActiveProtect Manager "eingesammelt" oder von der Client-Software aus angestoßen werden. Erwartungsgemäß wurde die Ethernet-Schnittstelle konstant ausgereizt, weshalb die Sicherung etwa 50 Minuten dauerte und sich eine Datenrate von 118 MB/s ergibt.Die DP320 erreichte einen Deduplizierungsfaktor von 1,2 - es wurden also nur 352 GB auf den Festplatten belegt. Der R1600 dümpelte während der Sicherung bei etwa 30% Auslastung, hätte also durchaus Kapazität für eine stärkere Komrimierung gehabt. BTRFS bietet hierfür Optionen, auch die Wahl der entsprechenden Algorithmen. Schade, dass diese nicht wählbar sind - es wurde wohl ein sicherer Standard zugunsten der Stabilität gewählt.

Nach dem ersten Backup zog ich eine 8,5 GB große Steam-Installation von "Supreme Commander: Forged Alliance" (Shoutout an das Community-Projekt Forged Alliance Forever - FAF) auf das C-Laufwerk. Das anschließende Backup belegte wie erwartet nur den zusätzlichen Speicher dieser Installation. Praktisch für Umgebungen mit vielen ähnlichen Systemen!

Der ActiveProtect Agent bietet die Möglichkeit, die maximale Übertragungsgeschwindigkeit zu begrenzen – auch zeitabhängig. So kann man die Netzwerkbelastung während der Arbeitszeiten reduzieren und intensive Backup-Aktivitäten in die Nacht verlagern. Möglich ist dies auch zentral über den Manager.

Wiederherstellungsoptionen und simulierte Notfallszenarien

Für einzelne Dateien und Ordner bietet die DP320 ein Wiederherstellungsportal, über das User ihre Daten herunterladen können. Mit entsprechenden Berechtigungen können diese auch im Self-Service auf ihre Backups zugreifen. Eine direkte Wiederherstellung am ursprünglichen Speicherort, auch aus der Ferne, ist nicht möglich. Ein Admin kann Dateien also nicht zurück auf den Rechner zaubern. Hier hatte ich erwartet, dass man Backups direkt zum Client "schieben" kann, doch das System setzt auf einen Ansatz, der bei größeren Datenmengen umständlich sein kann.Für vollständige System- oder Volume-Wiederherstellungen wird das Recovery-Tool benötigt. Dieses ist nicht remote nutzbar, sondern erfordert das Booten vom erstellten Wiederherstellungsmedium. Das Wiederherstellungstool lädt erstmal eine gesamte Windows-PE-Installation herunter, was unter Windows einen Neustart und ca. 8 GB an Downloads erfordert. Etwas nervig für einen USB-Stick, der nur ca. 1 GB Speicher belegt und keine WLAN-Treiber mitbringt. Die Automatische Datenträgerzuordnung während der Wiederherstellung ("Bestimmtes Volume wiederherstellen") ordnete meine Festplatten zudem falsch zu und wollte das D-Laufwerk überschreiben, sodass ich letztendlich die Wiederherstellung des gesamten Systems auswählte.

Diese Lief problemlos und dauerte etwa 58 Minuten, wobei der R1600 sich bei ca. 28% Auslastung langweilte. Eine verpasste Chance: warum kommt die Deduplikation nur beim Backup und nicht bei der Wiederherstellung zum Einsatz, damit nur nicht-identische Blöcke wiederhergestellt werden? Die Wiederherstellung nutzt derzeit Brute-Force und schont damit die CPU-Leistung, verschwendet aber überflüssig Netzwerkbandbreite und Zeit -schade, das geht raffinierter.

Mit dem Recovery Media Creator lassen sich auch ganze Wiederherstellungsmedien erstellen, wobei sich die Anleitung für Linux etwas gruselig liest

Notfallszenarien wie einen Ausfall habe ich mir eher bei den Backups angeschaut, da die Wiederherstellungen eben vor allem vollständig erfolgen - hier ist ein Systemabsturz natürlich katastrophal, bzw. muss die Wiederherstellung danach erneut angestoßen werden.

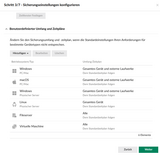

Unterstützte Backup-Quellen

- Windows-, macOS- und Linux-Clients

- Physische Server (Windows und Linux)

- File-Server, einschließlich Synology NAS-Systeme

- Virtuelle Maschinen (VMware vSphere, Microsoft Hyper-V)

- Datenbanken (Microsoft SQL Server, Oracle)

- Microsoft 365-Dienste

Man hat häufig so lange ein Backup, bis man es testet. Der ActiceProtect Manager bietet hierfür Test-Optionen, wobei jene für Virtuelle Maschinen hervorzuheben sind, die testweise gebooted und dabei per Video aufgezeichnet werden können.

3. Performance und Alltagstauglichkeit

Datenübertragungsraten im Netzwerk

Wie schon hinlänglich beklagt, wird die Übertragungsrate der DP320 durch ihren antiken 1-GBit-Port begrenzt. In meinen Tests erreichte ich Geschwindigkeiten nahe am theoretischen Maximum. Diese hält das System auch bei längeren Übertragungen und ohne nennenswerte Einbrüche bei kleinen Dateien. Für kleine bis mittlere Datenmengen ist diese Geschwindigkeit akzeptabel. Bitter ist jedoch die Erkenntnis, dass 62% der theoretischen Festplattenleistung brach liegen, weil auf einen wenige Cent teureren 2,5-GBit-Port verzichtet wurde.CPU- und Speicherauslastung unter Last

Wie schon erwähnt wurde der R1600 während Backups zu ca. 30% und während der Wiederherstellung zu ca. 28% ausgelastet, was einigen Raum für zusätzliche Bandbreite oder Komprimierung bieten würde. Auch der RAM wurde nur zu ca. 30% ausgelastet, was sich bei höheren Speichermengen ändern wird. Von NAS kennt man die Faustregel "1 GB RAM pro 1 TB Speicher", er scheint also ausreichend dimensoniert zu sein und ist darüber hinaus nachrüstbar.Der Idle-Betrieb sieht so aus:

Geräuschentwicklung und Wärmeabgabe

Für den Lüfter stehen drei Modi zur Verfügung: semi-passiv, niedrig und hoch. Als Geräuschquellen kommen die HAT3310-HDDs mit 31 dB idle und 35 dB load hinzu. In Kombination mit den nicht verfügbaren Optionen für ein automatisiertes Wake-on-LAN war mir das für's Wohnzimmer deutlich zu laut und wäre es auch für's Büro, aber hört selbst. Aufgenommen mit einem Pixel 7 aus ca. 20 cm Entfernung:Lüfter semi-passiv, idle

Lüfter niedrig, idle

Lüfter hoch, idle

Lüfter niedrig, load

Die Wärmeentwicklung bleibt auch unter Volllast im moderaten, handwarmen Bereich. Auch die integrierten Temperatursensoren zeigen unkritische Werte, die Festplatten verbleiben weit unter 40 Grad.

Stromverbrauch und Leistungsaufnahme

- Laut englischem Datenblatt: 21 Watt bei Zugriffen

- Im Leerlauf extern gemessen: 23-24 Watt

- Während einer Sicherung gemessen: 33-35 Watt (durchschnittlich 34 Watt, maximal 38 Watt)

- Bei Wiederherstellungen: 28-31 Watt (durchschnittlich 30 Watt)

Bei einem Strompreis von 30 Cent und einem von sieben Tagen, an dem Backups laufen, ergeben sich jährliche Stromkosten von 65,70 Euro. Als Privatutzer fehlen mir hier von klassischen NAS bekannte Energiesparfunktionen wie Spin-down oder WakeOnLAN - wie schon angemerkt gehen diese allerdings auf Kosten der HDD-Lebenszeit, auch wenn es durchaus interessante Berichte von Anwendern gibt, die genau das seit zehn Jahren mit ZFS auf Consumer-Platten ohne Datenverlust umsetzen.

4. Datensicherheit und Schutzfunktionen

Immutable Backups und Ransomware-Schutz

Die DP320 unterstützt unveränderliche Backups (Immutable) und WORM-Speicher (Write Once Read Many), was vor Ransomware-Angriffen schützen soll. Die Technologie verhindert, dass gesicherte Daten nachträglich modifiziert oder gelöscht werden können – selbst mit Administratorrechten. Die Backups werden für einen festgelegten Zeitraum "eingefroren" und sind somit gegen Manipulation geschützt. Mit Admin-Rechten auf der DP320 konnte ich die Backups allerdings löschen, aber wenn die Backup-Struktur schon übernommen wurde, ist es eh schon zu spät...Weiterhin lassen sich flexible Aufbewahrungsrichtlinien konfigurieren, um etwa regulatorische Anforderungen zu erfüllen. Außerdem lassen sich Snapshots der Sicherungen erstellen, die einen punktuellen Zustand des Backups bewahren und später wiederhergestellt werden können.

Air-Gapped-Backup-Funktion

Im Air-Gapped-Backup-Betrieb wird das System temporär oder dauerhaft vom Netzwerk isoliert, um es vor Zugriffen von nicht erlaubten oder verbotenen IP-Adressen zu schützen.- Zeitbasierte Isolation: Das System kann zu bestimmten Zeiten automatisch vom Netzwerk getrennt werden

- IP-basierte Zugriffssteuerung: Nur definierte IP-Adressen dürfen auf das System zugreifen

- Firewall-Regeln auf Geräteebene: Feinkörnige Kontrolle des eingehenden und ausgehenden Netzwerkverkehrs

Verschlüsselungsoptionen und Sicherheitsaspekte

Backups werden auf der DP320 standardmäßig unverschlüsselt gespeichert. Erstmal sacken lassen...Die Ratio dahinter ist wahrscheinlich, dass man im Fall der Fälle schnell wieder handlungsfähig sein will. Verschlüsselung kommt nur bei der Übertragung von Backup-Kopien zu externen Speichern wie ActiveProtect Vault, C2 Object Storage oder Amazon S3 zum Einsatz.

Die sogenannten "Verbindungsschlüssel", die bei der Konfiguraton des Clients zum Einsatz kommen, dienen lediglich zur Authentifizierung der Verbindung zwischen dem ActiveProtect-Agent und dem Backup-Server. Diese Verbindung widerum wird per https mit einem einstellbaren Zertifikat abgesichert. Es gibt also eine Transportverschlüsselung.

Je nach Umgebung, in der die DP320 zum Einsatz kommt, sorgt dies dafür, dass weitere Sicherheitsmanahmen wie ein physischer Schutz des Gerätes umgesetzt werden müssen. So ist es ratsam, die Systeme bereits vor dem Backup zu verschlüsseln und die Admin-Accounts unbedingt und auf jeden Fall mit Zwei-Faktor-Authentifizierung abzusichern.

5. Software und Administration

Überblick über die Software und deren Funktionen

Das Herzstück der DP320 ist der Synology ActiveProtect Manager (APM): ein spezialisiertes Backup-Betriebssystem, das sich fundamental vom bekannten DiskStation Manager (DSM) unterscheidet. Der APM konzentriert sich ausschließlich auf Backup- und Wiederherstellungsfunktionen und verzichtet damit bewusst auf die Vielseitigkeit des DSM.Die Usereroberfläche ist in zwei Komponenten unterteilt:

- ActiveProtect Manager Dashboard (Port 443): Die primäre Schnittstelle für alle Backup-bezogenen Aufgaben wie die Konfiguration von Sicherungsplänen, Wiederherstellungen und Überwachung.

- Management Console (Port 5001): Eine DSM-ähnliche Oberfläche für grundlegende Systemeinstellungen wie Netzwerkkonfiguration, User- und Rechteverwaltung sowie Festplattenmanagement.

Im Vergleich zum vielseitigen DSM ist der APM sehr reduziert. Es gibt kein Package Center für zusätzliche Anwendungen, keine Medienserver-Funktionen und keine Virtualisierungsoptionen abseits der Backupprüfung. Es handelt sich eben um eine Backup-Appliance und kein NAS. Die Fokussierung trägt allerdings zur Stabilität und Sicherheit bei und vereinfacht die Administration für weniger erfahrene User. Der APM bietet:

- Richtlinienbasierte Backup-Verwaltung

- Zentrale Überwachung aller Backup-Aktivitäten

- Automatische Erkennung und Integration neuer Workloads

- Detaillierte Berichterstellung und Analyse

- Sandbox-Umgebung für Wiederherstellungstests

Zugriffskontrollen und Userrechte

Die Userverwaltung im APM ist ziemlich umfassend und ermöglicht eine feinkörnige Kontrolle der Zugriffsrechte. Admins können Rollen definieren und festlegen, welche Aktionen einzelne User oder Gruppen ausführen dürfen. Es gibt:- Rollenbasierte Zugriffssteuerung (RBAC) für verschiedene Administrationsebenen

- Integration mit Active Directory und LDAP für zentrale Userverwaltung

- SAML 2.0 für Single Sign-On (SSO)

- Feinkörnige Berechtigungen für Backup-Jobs, Pläne und Wiederherstellungen

Remote-Verwaltung und Einbindung in Netzwerkinfrastrukturen

Für die Integration stehen zur Verfügung:- Diverse Netzwerkprotokolle und -dienste (SMB etc.)

- SNMP-Überwachung zur Integration in zentrale Monitoring-Systeme

- E-Mails bei kritischen Ereignissen

- Remote-Zugriff über die Weboberfläche

Interessant ist auch die Replikationsfunktion, mit der Backups automatisch auf andere Synology-Geräte oder Cloud-Speicher gespiegelt werden können. Das hilft für eine 3-2-1-Backup-Strategie mit mehreren Speicherorten.

Für die Remote-Verwaltung stehen keine Apps zur Verfügung, der Zugriff erfolgt ausschließlich über die Weboberfläche.

Versorgung mit Sicherheitsupdates

Updates können entweder per Updater oder manuell über heruntergeladene Pakete installiert werden. Die Prüfung kann ebenfalls automatisch oder manuell erfolgen, die Installation der Updates ebenso. Eine Planung ist ebenso möglich.Seit Release am 19. Dezember 2024 gab es zwei Updates - für ein Betriebssystem erscheint mir das recht selten, es entspricht allerdings dem DSM-Rhythmus. Der Track record bezüglich Sicherheit des DSM sieht ordentlich aus. ActiveProtect ist noch ziemlich neu und ich konnte keine Angaben zur Dauer des Supports finden, was mich überrascht hat. Typisch für Synology wären mindestens fünf Jahre, wobei es im Business-Bereich auch länger sein könnte.

6. Fazit

Nach meiner Zeit mit der DP320 ist mein Eindruck gemischt. Sie macht genau das, wofür sie gebaut wurde: zuverlässige Backups mit minimaler Konfiguration in homogenen Umgebungen. Die schnelle Einrichtung, zuverlässige Deduplizierung und robuste Backup-Prozesse überzeugen. Ransomware-Schutz, immutable Backups und Air-Gapped-Funktionen sind gut umgesetzt.Es gibt allerdings auch deutliche Schwachpunkte: - Ach, Moment, jetzt klingelt gerade das Telefon. Ah, es sind die 2000er, die gerne ihren LAN-Anschluss zurück hätten. Aber wo war ich? - Der 1-GBit-Port ist anachronistisch und bei diesem Preis eine Zumutung, wenn 2,5GBit 5er Switches wie das UniFiSwitch Flex Mini schon für 55,- Euro zu haben sind. Es ist unverständlich, warum Synology hier nicht wenigstens 2,5 GBit spendiert hat, zumal der verbaute R1600 deutlich mehr könnte und das nächst-größere Modell direkt einen Sprung auf 10GBit macht. Auch die fehlende Verschlüsselung der Backups irritiert.

Zudem ist der Vendor Lock-in unübersehbar: durch ein Software-lock werden nur Synology-eigene Festplatten unterstützt. Im Vergleich zu DSM-basierten Systemen fehlt es an Flexibilität. Mit 23-24 Watt im Leerlauf ist der Stromverbrauch für einen Mini-Server ebenfalls recht hoch.

Für wen ist das Gerät also geeignet? Aus meiner Sicht für kleine bis mittlere Unternehmen und besonders solche mit homogenen Microsoft-Umgebungen, die eine schlüsselfertige Backup-Lösung ohne tiefes technisches Know-how suchen. Und diese werden mit der DP320 auch gut bedient. Sie bietet Planbarkeit und professionellen Support, was für viele KMUs entscheidend ist.

Für technisch versierte Heimanwender ist sie mit rund 1.700 Euro zu teuer bei zu wenig Flexibilität. Ein klassisches NAS, etwa mit DSM, bietet hier deutlich mehr Spielraum. Für Umgebungen mit strengeren Sicherheitsanforderungen hinsichtlich Verschlüsselung sind möglicherweise DSM-basierte Lösungen mit Active Backup for Business und zusätzlichen Verschlüsselungsfunktionen die bessere Wahl.

Vielen lieben Dank an Hardwareluxx und Synology für die Möglichkeit zu diesem Test! Ich hoffe, er war interessant.

Fragen? Fragen!