Werbung

Gestern wurde die aktuelle Runde der Trainings-Ergebnisse im offenen KI-Benchmark MLPerf Training der MLCommons veröffentlicht. Wie nicht anderes zu erwarten, bleibt es in der absoluten Leistung bei einem Zweikampf zwischen AMD und NVIDIA, wenngleich die Voraussetzungen unterschiedlicher nicht sein könnten.

MLCommons ist ein gemeinnütziges Konsortium, das hinter den MLPerf-Benchmarks steht, welche halbjährlich für Training und Inferencing von KI-Modellen veröffentlicht werden. Über 125 Mitglieder, darunter AMD, ARM, Google, Huawei, Intel, NVIDIA, Qualcomm, Samsung und viele weitere, unterstützen das Projekt und übernehmen vor der Veröffentlichung der Resultate auch das Peer Review – also die gegenseitige Kontrolle der Einreichungen.

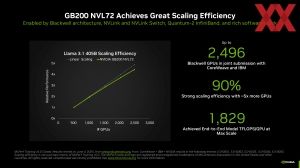

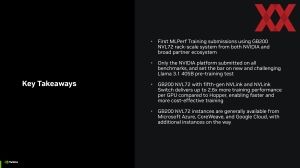

In der Runde Training 5.0 ist das Pre-Training von Llama 3.1 mit 405 Milliarden Parametern. Ein GB200-NVL72-Cluster von NVIDIA benötigte für einen Durchlauf etwa 20 Minuten, was in der ersten Einreichung auch gleich einen Rekord darstellt. Neue Rekorde stellten die GB200-Beschleuniger auch in Stable Diffusion v2, Llama 2 70B LoRA, DLRM v2, R-GAT, BERT und RetinaNet auf. Für NVIDIA lag der Fokus klar auf der Darstellung der Leistung und Skalierbarkeit von GB200 auf Basis der Blackwell-Architektur. B300/GB300 alias Blackwell Ultra spielte in dieser Runde also noch keine Rolle.

Wirft man einen Blick auf die Ergebnisse für das Training 5.0, dann fällt auf, dass NVIDIA und die Partner die GB200-Beschleuniger in verschiedenen Ausbaustufen der Cluster durch alle Benchmarks geschickt haben. Als einziger Hersteller von KI-Beschleunigern ist dies gelungen. Weiterhin auffällig ist das breite Spektrum, von einzelnen Nodes mit acht GB200-Beschleunigern bis hin zu Clustern mit 2.496 Blackwell-GPUs.

Den Vergleich mit dem Konkurrenten AMD stellt NVIDIA gar nicht erst an. Die Zahlen belegen: Mit Blackwell kann NVIDIA die Trainingsleistung gegenüber dem Vorgänger Hopper mehr als verdoppeln. AMD kann mit dem Instinct MI300X/325X in den vergleichbaren Benchmarks (Llama 2 70B) aber nicht mithalten und benötigt mit einem Node mit acht Beschleunigern mehr als doppelt so lange wie Blackwell. Demnach ist AMDs aktuelle Generation allenfalls auf Augenhöhe mit NVIDIAs Hopper-Generation – das bekannte Muster wiederholt sich.

Das Arbeitstier der kommenden Monate und Jahre wird Blackwell sein. Der jährliche Rhythmus für neue Hardware sorgt für eine stetige Weiterentwicklung. Aber genau wie aktuelle noch Ampere und Hopper wird ein Großteil der Arbeit im produktiven Umfeld von den älteren Generationen durchgeführt, die neue Hardware stellt dann immer neue Leistungs-, Effizienz- und Kostenrekorde auf. Die Benchmarks dürfen aber auch nicht darüber hinwegtäuschen, dass NVIDIA nicht konkurrenzlos ist. Der Kostenrahmen sowie die spezifische Anwendungen können bedeuten, dass AMD das bessere Gesamtpaket stellt.

AMD fehlt es vor allem an der notwendigen Scale-Up-Technik – sprich einer Möglichkeit, über einen Knoten mit mehr als acht Beschleunigern hinaus die Leistung sinnvoll zu steigern. Dies hatten wir erst kürzlich thematisiert. Daran wird auch der in diesem Jahr verfügbare Instinct MI355X wohl wenig ändern. Doch alleine eine Alternative zu sein bedeutet für AMD schon, dass das Datacenter-Geschäft aktuell mehr als gut läuft.