Werbung

Mit der GeForce GTX 1660 Ti und GeForce GTX 1660 hat NVIDIA bereits zwei Grafikkarten auf den Markt gebracht, die auf der Turing-Architektur basieren, aber auf die neuen Hardware-Einheiten in Form der Tensor und RT Cores und damit auf das Deep Learning Super Sampling und die RTX-Funktionen verzichten.

Mit der TU116-GPU entbrannte die Frage, warum diese eine Größe von 284 mm² hat und wie groß der Einfluss der Tensor und RT Cores auf die Größe des Chips ist. Der nominelle Vorgänger GP106 hat eine Größe von 200 mm². Die Anzahl der Transistoren steigt von 4,4 auf 6,6 Milliarden. Das Verhältnis aus Größe des Chips und Anzahl der Transistoren steigt für die GP106- auf die TU116-GPU fast linear an.

| Chip | TU102 | TU104 | TU106 | TU116 |

| Chipgröße | 754 mm² | 545 mm² | 445 mm² | 284 mm² |

| Anzahl der Transistoren | 18,6 Milliarden | 13,6 Milliarden | 10,8 Milliarden | 6,6 Milliarden |

| RT Cores | 68 | 46 | 36 | - |

| Tensor Cores | 544 | 368 | 288 | - |

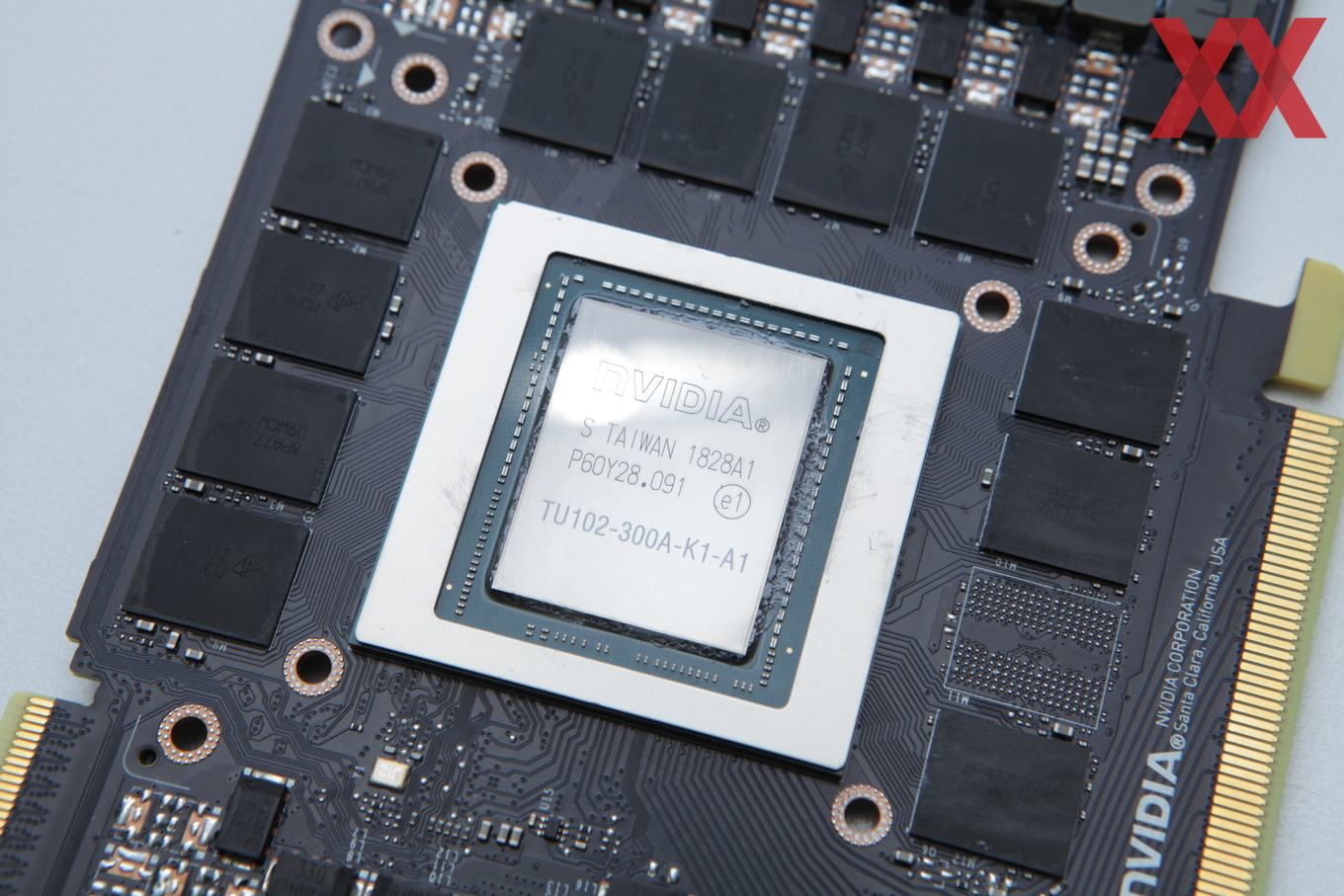

Die Turing-GPUs von NVIDIA werden weiterhin in 12 nm bei TSMC gefertigt und sind im Falle der TU102-GPU mit 754 mm² recht groß geraten. Die TU104- und TU106-GPU skalieren entsprechend ihres Ausbaus an Shadereinheiten sowie der RT und Tensor Cores in ihrer Größe.

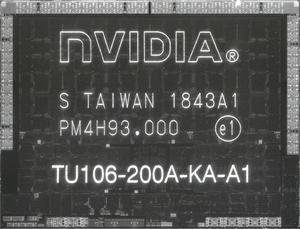

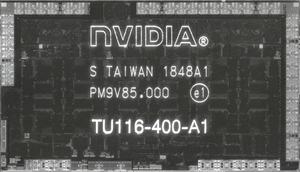

Doch wie groß sind die neuen Hardware-Einheiten der Turing-Architektur? Darüber wollte NVIDIA bisher keinerlei Auskunft geben. Unser Forenmitglied OC_Burner hat auf Flickr wieder einmal neue Die-Shots veröffentlicht. Auch wenn die hochauflösenden Bilder der kompletten GPU mitsamt verschiedener Lichtfilter noch fehlen, erlauben die Fotos der abgeschliffenen TU106- und TU116-GPU einen Vergleich der Chipfläche der Texture Processor Cluster (TPC). Eine TU106-GPU besitzt 18 TPCs – sechs pro Graphics Processing Clusters (GPC).

Messungen auf Basis der veröffentlichen Die-Shots zeigen eine Größe des TPC von 10,89 mm² auf der TU106-GPU, während das Cluster auf der TU116-GPU nur 8,94 mm² groß ist. Der Größenunterschied von 1,95 mm² sollte sich demzufolge auf die fehlenden Tensor und RT Cores zurückführen lassen. Aus früheren Die-Shots zur GV100-GPU auf Basis der Volta-Architektur lässt sich die Größe der Tensor Cores mit 1,25 mm² abschätzen. Bleiben also 0,7 mm² für die fehlenden RT Cores auf der TU116-GPU. Pro TPC sprechen wir von zwei RT Cores, die sich auf 0,7 mm² verteilen und 16 Tensor Cores, die sich in den 1,25 mm² befinden sollten.

Drei Dinge lassen sich nun daraus ableiten:

1. Die Tensor und RT Cores sind weitaus kleiner, als dies im Vorfeld vermutet wurde. Ja, die Turing-GPUs sind keine kleinen und effizient zu fertigenden Chips. Dies liegt aber auch daran, dass NVIDIA an der Fertigung in 12 nm festgehalten und die Anzahl an Funktionseinheiten deutlich gesteigert hat.

2. Auch ohne die Tensor und RT Cores hat NVIDIA die Architektur durch die größeren Caches und dedizierten INT32-Recheneinheiten aufgebläht, sodass die Chips zwangsläufig eine solche Größe erreichen mussten. Zudem dürften die neu organisierten Shadereinheiten einen gewissen Einfluss auf die Größe der Chips gehabt haben.

3. Nach der Veröffentlichung der GeForce GTX 1660 Ti mit der TU116-GPU wurde darüber spekuliert, ob NVIDIA die Tensor Cores als dedizierte FP16-Einheiten verwendet, die in der TU116-GPU zu finden sind. Dies ist offenbar nicht der Fall. In den TU10x-GPUs werden Fließkommaberechnungen für FP16 in den Tensor Cores vorgenommen, doch diese sind bei der TU116-GPU offenbar nicht vorhanden.

Das Argument, NVIDIA könne die Turing-Karten nur so teuer verkaufen, weil die Tensor und RT Cores zu viel Chipfläche belegten, kann also nicht zwangsläufig gelten. Sicherlich wird NVIDIA die Entwicklungskosten in gewisser Weise einfließen lassen. Wie groß dieser Anteil aber ist, lässt sich nur schwer abschätzen.