Dragonheart69

Enthusiast

- Mitglied seit

- 14.04.2006

- Beiträge

- 1.487

- Ort

- Stuttgart

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 9950X3D

- Mainboard

- Asus Crosshair Apex X870e

- Kühler

- Custom Wasserkühlung mit externem Mora 3 420

- Speicher

- gSkill 2x16Gb Trident Z5 6000MHz CL26 Hynix A-Die

- Grafikprozessor

- ASUS 7900 XT

- Display

- HP 22x

- SSD

- WD Black 2x 1TB

- Soundkarte

- onBoard Realtek

- Gehäuse

- Lian Li O11 Dynamic EVO

- Netzteil

- Seasonic Prime TX 1000W

- Keyboard

- Logitech MX Key S

- Mouse

- Logitech MX Master 4

- Betriebssystem

- Windows 11 PRO 64 Bit

- Internet

- ▼200 MBit ▲80 MBit

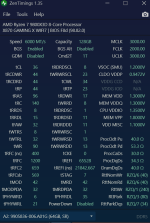

Ja gerne@Dragonheart69 ich hab die erste alpha fertig vom ddr5 timing calculator willst du nen alpha invite ?

Beitrag automatisch zusammengeführt:

@ColinMacLaren

Was hast du den für eine CPU?? Momentan kannst du bei AM5 CU-DIMM nur im bypass verwenden. Aber es hat hier schon jemand CU-DIMM auf AM5 am laufen