Werbung

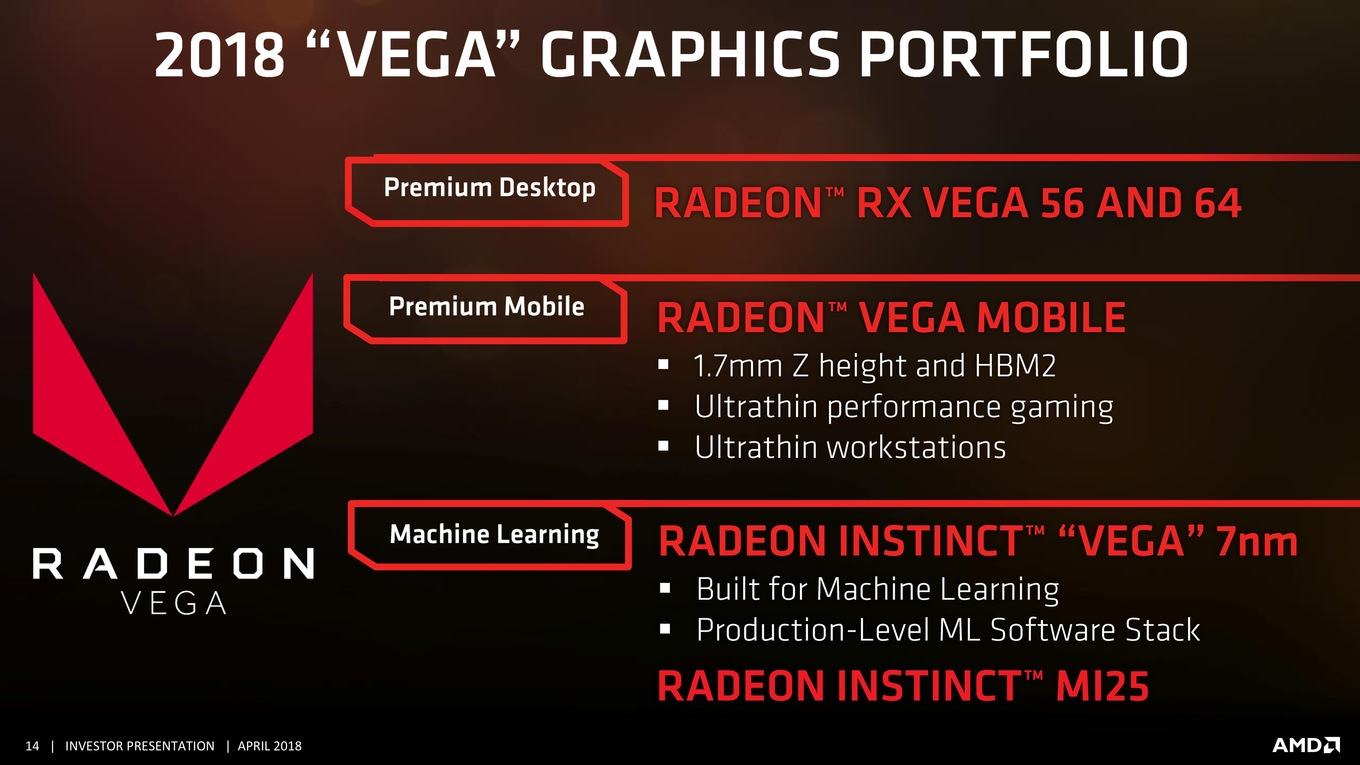

AMD wird das Jahr 2018 auf dem Desktop mit dem bisher bestehenden Produktportfolio aus Radeon RX Vega 64 und Vega 56 bestreiten, im Sommer mobile Varianten einführen und gegen Ende des Jahres einen GPU-Beschleuniger auf Basis von Vega in 7 nm auf den Markt bringen. Damit wird es keinerlei Gaming-Neuheiten mehr von AMD in diesem Jahr geben – zumindest nicht für den Desktop.

Die Hoffnung ist demnach, dass die Navi-Architektur und entsprechende Produkte das Ruder für AMD wieder herumreißen wird können – denn geht es rein um die Leistung im High-End und um Preis/Leistung in der Mittelklasse, tut sich AMD derzeit sehr schwer. Gegen die GeForce GTX 1080 Ti ist derzeit kein Herankommen und auch wenn eine Radeon RX Vega 56 auf Effizienz getrimmt eine sehr gute Karte ist, die Erwartungen an diese Generation konnten sicherlich nicht erfüllt werden. In der Mittelklasse sieht es zwar etwas besser aus, das Re-Re-Branding für OEM-Hersteller in Form der Desktop- und Mobile-Radeon-RX-500X-Serie zeigt das Dilemma aber recht deutlich.

Nun vermelden die Kollegen von Fudzilla.com, dass Navi zwar weiterhin für 2019 geplant ist, dies aber wohl nicht der erneute Versuch, die Leistungskrone für sich zu gewinnen, sein wird. Stattdessen soll sich AMD wie auch schon mit der Polaris-Generation auf die Mittelklasse konzentrieren. Die Argumentation für ein solches Vorgehen ist recht einfach: Die Mittelklasse ist wirtschaftlich der sogenannte Sweet Spot, also der Punkt, an dem hohe Stückzahlen abgesetzt und mit entsprechender Marge auch hohe Gewinne erzielt werden. Im High-End-Segment ist die Marge pro Stück zwar höher, dafür sind die Stückzahlen deutlich geringer und das Budget für die Entwicklung solcher Hardware ungleich höher. Mit der Polaris-Architektur hat AMD gezeigt, dass es sinnvoll sein kann, sich auf dieses Segment zu konzentrieren, um wirtschaftlich weiterhin auf gesunden Füßen zu stehen. Das R&D-Budget von zwei Milliarden US-Dollar für die Entwicklung einer Architektur (NVIDIA hat nach eigenen Angaben so viel für die Entwicklung der Volta-Architektur ausgegeben), hat AMD einfach nicht.

Sollten sich die Gerüchte bewahrheiten, wäre auch 2019 kein High-End-Ableger von AMD zu erwarten. Damit überließe AMD dem Konkurrenten NVIDIA vollständig das Spielfeld, denn im Spätsommer soll der Pascal-Nachfolger Turing erscheinen. Selbst wenn NVIDIA hier nur den üblichen Leistungssprung von 20 bis 30 % macht, hieße das, dass sich der Abstand zwischen AMD und NVIDIA vergrößern würde.

Eine Mittelklasse auf Basis der Navi-Architektur bei gleichzeitiger Verkleinerung der Fertigung in 7 nm hat zumindest das Potential ein großer Sprung im Bereich der Grafikkarten von 200 bis 400 zu sein. Zugleich bedeutet dies aber, dass vor 2020 kein neues High-End-Produkt von AMD in Sicht ist.

Vega in 7 nm wird keine Rolle spielen

Da in den vergangenen Tagen vermehrt über eine mögliche Gaming-GPU auf Basis von Vega in 7 nm spekuliert wurde, wollen wir noch einmal betonen, dass AMD derzeit keinerlei Pläne in diese Richtung hat. Wann immer AMD die Vega-Architektur in 7 nm in den Mund nahm, fielen die Worte Machine Learning und Radeon Instinct. Selbst wenn AMD eine Radeon RX Vega mit einer solchen GPU auf den Markt bringen wollte, wäre dies nicht vor 2019 möglich.

Die angekündigte Radeon Instinct mit Vega in 7 nm wird ein reiner GPU-Beschleuniger sein. Denkbar wäre eine Art Frontier Edition dieser Karte, die dann mit entsprechendem Treiber auch Spiele ausführen kann, aufgrund der wohl recht teuren Fertigung und dem Zusammenspiel von mindestens 16 GB an HBM2 dürfte eine solche Karte aber alles andere als billig werden. Vermutlich lässt sich diese recht gut mit der NVIDIA Titan V vergleichen, die zwar auch auf Spielen eine ansprechende Leistung bietet, die mit einem Preis von 3.100 Euro aber eher in anderen Anwendungsbereichen zu Hause ist und somit für den Gaming-Markt kaum eine Rolle spielt.