Werbung

Auch wenn wir bereits im Vorfeld einige News zu den Ankündigungen und Details zur konkreten Umsetzung von NVLink Fusion und Silicon Photonics, bzw. Co-Packaged Optics veröffentlicht hatten, ist die Hot-Chips-Konferenz erst gestern Abend eröffnet worden. Die Tutorial-Sessions beschäftigen sich allesamt mit den Herausforderungen der Rack-Scale-Lösungen. Egal ob NVIDIA mit den aktuellen Oberon- und zukünftigen Kyper-Racks, AMD mit den für 2026 geplanten Helios-AI-Racks oder die Custom-Lösungen von Google und Meta – allesamt kämpfen die KI-Hardware-Anbieter damit, die zahlreichen technischen Hürden zu umgehen.

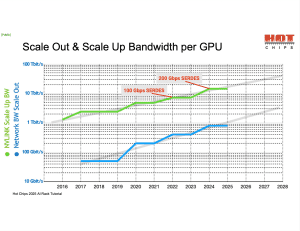

Schnelle Interconnects sollen eine Vielzahl an KI-Beschleunigern geneinsam an einer Aufgabe (speziell dem Training von KI-Modellen) arbeiten lassen. NVIDIA setzt dazu auf NVLink und fasst damit aktuell bis zu 72 KI-Beschleuniger in einer Domäne zusammen. AMD ist via Infinity Fabric auf acht Beschleuniger beschränkt und verwendet für ein Scale Out Ethernet, bzw. Ultra Ethernet.

Mit der Instinct-MI400-Generation soll AMD auf Ultra Accelerator Link (UALink) wechseln. Es kursieren bereits Gerüchte über ein Rack-System namens MI450X IF128, das in der zweiten Hälfte 2026 erscheinen soll. Der Zusatz „IF128“ weist auf die Verwendung von Infinity Fabric hin und nennt zugleich die Zahl der direkt verbundenen GPUs. Der Infinity-Fabric-Verbund soll dabei eine bidirektionale Bandbreite von 1,8 TB/s ermöglichen. Das Konkurrenzmodell VR200 NVL144 verbindet ebenfalls 72 GPUs, wobei je zwei Rubin-Chips in einem Package sitzen.

Nach Informationen von SemiAnalysis plant AMD innerhalb dieser Racklösung mehrere Varianten, bei denen je GPU unterschiedlich viele Pensando-800GbE-Netzwerkkarten genutzt werden. Je nach gewählter Ausführung lassen sich so die vollen 1,8 TB/s Bandbreite zwischen den GPUs erreichen.

Zusätzlich zur Maximalausführung MI450X IF128 mit 128 GPUs wird AMD laut SemiAnalysis eine Single-Rack-Variante unter dem Namen MI450X IF64 mit 64 GPUs anbieten. Innerhalb eines Racks und bei der IF128-Konfiguration über zwei Racks hinweg setzt AMD dabei auf Flat-Copper-Technik mit passiven Komponenten.

NVIDIA: GB200/300 NVL72 und Meta mit eigenem GB200-NVL36x2-Design

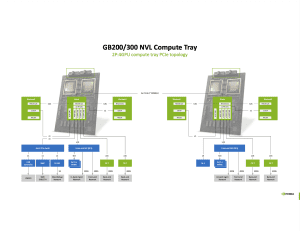

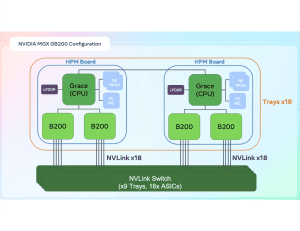

NVIDIA präsentierte seine aktuelle Rack-Scale-Lösung GB200/GB300 NVL72, die mit 120 bis 150 kW pro Rack bereits sämtliche bisher bekannten Grenzen in der Rechenzentrumsarchitektur sprengen. Die Integrationsdichte in den Bereichen Stromversorgung, Netzwerk und Kühlung ist bereits enorm. NVIDIA packt in der Referenzlösung für die GB200/GB300-NVL72-Racks 18 Compute-Trays mit insgesamt 72 Grace-CPUs und 144 Blackwell-GPUs, neun NVLink-Switch-Trays, eingefasst von den notwendigen Netzteilen sowie den Ethernet- oder InfiniBand-Switches, welche das Rack mit der restlichen Rechenzentrums-Infrastruktur verbinden.

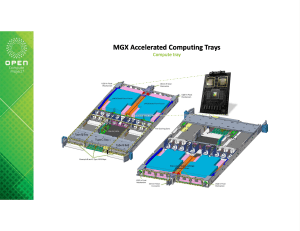

Aber NVIDIA ermöglicht seinen Partnern auch gewisse Anpassungen an diesem Design. NVIDIA hat auf der Hot Chips eine Art "offene" MGX-Compute-Tray-Architektur vorgestellt. An der Vorderseite des Trays ist ein Steckplatz für Hyperscaler vorgesehen, um das Design anzupassen – beispielsweise durch den Einbau von eigener Netzwerk-Hardware. Anstelle von vier ConnectX-7/8-Backend-Netzwerkkarten nutzt AWS diesen Platz für neun 200-GbE-Netzwerkkarten. Eine davon ist für das Frontend vorgesehen, die anderen acht für das Backend der vier GB200-Beschleuniger im Tray. Aktuell ist AWS jedoch der einzige Hyperscaler, der die Backend-NICs in dieser Form anpasst.

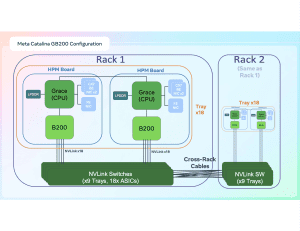

Meta passt seine GB200/GB300-NVL72-Racks in anderer Form an, damit diese in den Standard-Rechenzentren des Unternehmens untergebracht werden können. Auch hinsichtlich der Auslegung der Hardware gibt es Anpassungen, zu denen wir nun kommen werden.

Die Leistungsdichte und damit die Stromversorgung sowie das enorme Gewicht der Rack-Scale-Lösung von NVIDIA (und später auch AMD) sind die größten Herausforderungen für den Einsatz in bestehenden Rechenzentren. Die Traglast der Böden ist meist nicht darauf ausgelegt und wenn 120 bis 150 kW an elektrischer Leistung zum Rack geführt werden, muss diese Abwärme wieder abtransportiert werden.

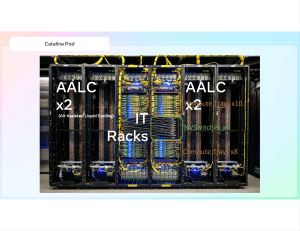

Meta hat ein eigenes GB200-NVL36x2-Design entworfen, welches in luftgekühlten Rechenzentren mit 20 kW je Rack verwendet werden kann. Die Rechenhardware verteilt Meta dazu schon einmal auf zwei Racks. Zudem werden rechts und links dieser beiden Racks jeweils zwei Racks zur Umsetzung der Kühlung verwendet. Dieses Air Assisted Liquid Cooling (AALC) ermöglicht den Einsatz eines GB200-NVL72-Systems mit 120 kW in einem typischen Rechenzentrum, in dem nur 20 kW je Rack realisiert werden können.

Meta nimmt allerdings auch Änderungen an der Compute-Hardware vor. Statt einer Grace-CPU immer zwei Blackwell-GPUs zuzuordnen verwendet das GB200-NVL36x2-Design je Blackwell-GPU auch eine Grace-CPU. Meta erhöht damit den zur Verfügung stehenden LPDDR-Speicher und damit die Gesamtkapazität des zur Verfügung stehenden Speichers.

Google: Aufwändiges 3D-Torus-Design

Google kann sich mit seinen eigenen Tensor Processing Units (TPU) bis zu einem gewissen Grad von NVIDIAs KI-Übermacht unabhängig machen. Im Frühjahr 2025 wurden die aktuellen Ironwood-TPUs vorgestellt, die für das Inferencing von Large Language Models (LLMs), Mixture of Experts (MoEs) und hier eben konkret auch für den Google-Service Gemini verwendet werden.

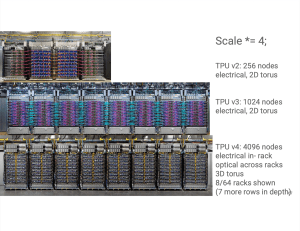

Auf der Hot Chips präsentierte Google den Aufbau des Ironwood-Superpod und des Max-Scale-Cluster, wie man es in den eigenen Rechenzentren zum Einsatz bringt. Mit 9.216 Chips je Superpod, organisiert in nebeneinander und hintereinander stehenden Racks, verwendet Google ein komplexes 3D-Torus-Layout für die optischen Verbindungen innerhalb der Pods und Racks.

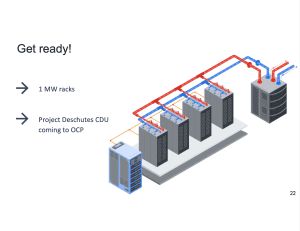

Entscheidend ist aber auch, dass Google nach eigener Aussage führend im Bereich der Wasserkühlung im Rechenzentrum ist und dies schon seit 2018 zum Einsatz bringt. Eigens entwickelte CDUs (Cooling Distribution Untis) sollen Google hier einen gewissen Praxis-Vorteil in der Umsetzung aufwändiger Wasserkühlungs-Lösungen verschafft haben. In etwa 20 der eigenen Rechenzentren setzt man bereits auf eine Wasserkühlung und hat hier mehr als 1 GW an Kühlungs-Infrastruktur installiert. Derzeit arbeitet man an der fünften Generation der eigenen CDUs, die es dann ermöglichen sollen, bis zu 1 MW an Abwärme aus einem Rack zu befördern.