Werbung

Wir hatten die Möglichkeit, den im Januar dieses Jahres offiziell in Betrieb genommenen Supercomputer Hunter des HLRS (Höchstleistungsrechenzentrum Stuttgart) in Stuttgart zu besuchen. Hunter ist ein sogenanntes Übergangssystem zu Herder, dem für 2027 geplanten Supercomputer, der die Schwelle von einem 1 EFLOPs an Rechenleistung nehmen soll. Hunter kommt auf eine FP64-Rechenleistung von 48,1 PFLOPS, was ihn aktuell auf Platz 54 der Top500-Liste bringt.

Dabei verwendet Hunter, genau wie die zwei schnellsten Systeme El Capitan und Frontier, in 188 GPU-Rechenknoten die Instinct-MI300A-Beschleuniger von AMD. Hinzu kommen reine CPU-Rechenknoten mit insgesamt 512 AMD Epyc 9374F mit jeweils 32 Kernen und 256 MB an L3-Cache.

Der Aufbau von Hunter

Die Installation von Hunter bzw. die Integration auf Rack-Level hat HPE übernommen. Hier kommt die Cray-EX4000-Lösung zum Einsatz, die neben den Compute-Blades auch die Netzwerk-Komponenten, Stromversorgung und auch die CDUs (Cooling Distribution Unit) beinhaltet. Für Hunter befinden sich die CPU- und GPU-Rechenknoten in drei Racks. Aufgrund des großen Gewichts stehen die Compute-Racks nicht direkt nebeneinander, sondern haben etwas Luft zwischen sich. Dies tut man aufgrund der Gewichtsbelastung des Gebäudes, in dem Hunter steht. In den Räumen wurde bisher Hawk betrieben.

Hunter ist komplett wassergekühlt. Dies betrifft nicht nur die Compute-Racks, sondern auch die Stromversorgung und Netzwerk-Komponenten. Theoretisch wäre Hunter somit im Raum fast komplett lautlos – wären die nicht die weiteren Komponenten wie die Speicherracks. 99,9 % der Abwärme werden also aus dem Raum geführt. Theoretisch würde sich ein Raum, in dem nur die Compute-Racks von Hunter stehen, nicht aufheizen. Dies erinnert uns an die Cold Boxes von Diggers, die wir beim Co-Location-Anbieter Exoscale gesehen haben.

Hunter übernimmt vorerst also nicht nur die Anwendungen und Anwender vom inzwischen größtenteils demontierten Supercomputer Hawk, sondern steht auch in dessen Räumlichkeiten. Dieser wurde im Oktober 2020 in Betrieb genommen und setzte auf Epyc-Prozessoren der zweiten Generation (Rome). Die KI-Erweiterung mit A100-Beschleunigern von NVIDIA bleibt vorerst in Betrieb. Nutzer (intern und extern) können ihre Anwendungen noch zwei Jahre auf Hawk kaufen lassen, müssen aber spätestens 2027 auf Hunter bzw. dann Herder migrieren.

Neben den Compute-Racks befinden sich auch noch drei Speicherracks auf Basis der Lustre-Lösungen von HPE. Sogenanntes Hot Data wird hier nahe der Compute-Racks gespeichert. Für die Auswertung der Daten werden diese aber in andere Speicherracks übertragen. Länger nicht benötigte Daten landen sogar auf einem sogenannten Cold Storage mit Magnetspeicherbändern.

Die Abwärme wird genutzt

Bereits mit Hawk wurde die Abwärme des Systems in das Fernwärmesystem der Universität Stuttgart eingespeist. Mit Hunter wird man dies fortsetzen, wenngleich die Abwärme mit etwa 600 kW im Durchschnitt deutlich niedriger ausfällt, als dies bei Hawk mit 3.000 kW der Fall war. Die Einspeisung in ein Fernwärmenetz ist aber alles andere als einfach. Beim Hunter-Vorgänger Hawk war das Kühlwasser, welches den Supercomputer bzw. die Kühlung verlassen hat, gerade einmal 27 °C warm. Mit 27 °C warmen Wasser lassen sich gerade ältere Gebäude aber natürlich nicht heizen und so kamen Wärmepumpen zum Einsatz, welche die Temperatur angehoben haben, was natürlich einen weiteren Energieaufwand bedeutet.

Auch beim finalen System Herder wird das warme Wasser nach der Kühlung des Supercomputers ebenfalls durch Wärmepumpen auf etwa 90 °C erwärmt und dann in das Fernwärmenetz eingespeist. Oben eingeblendet seht ihr die Kontrolleinheit von HPE, welche die Kühlung des Storage-Systems von Hunter darstellt. Fast 37 kW fallen hier an, für ein Compute-Rack von Hunter sprechen wir von 220 bis 230 kW pro Rack.

Vergleichsweise günstige Rechenleistung

Das HLRS ist ein durch öffentliche Gelder finanziertes Supercomputing-Center und macht die Rechenleistung einerseits den Forschungseinrichtungen und andererseits auch der Industrie zugänglich. Wichtig an dieser Stelle: Das HLRS darf mit Hunter kein Geld verdienen und so bekommen die Kunden aus der Industrie den Zugang vergleichsweise günstig. Die anfallenden Unkosten zahlen die Partner aus der Industrie natürlich. Ihre Anwendungen füllen aber auch nur die Lücken, die zwischen den wissenschaftlichen Anwendungen vorhanden sind.

Somit erreicht das HLRS eine relativ hohe Auslastung von Hunter. Diese soll bei etwa 90 % liegen, was deutlich höher als bei vergleichbaren Systemen ist. Die Kunden aus der freien Wirtschaft freuen sich über die vergleichsweise günstige Rechenleistung – zumeist günstiger, als wenn sie sich diese bei den klassischen Cloud-Service-Providern beschaffen. Das HLRS kann aber auch so günstig sein, weil man im Hinblick auf die Ausfallsicherheit geringere Ansprüche als ein CSP. So gibt es im Falle eines Stromausfalls keinerlei Notstromversorgung. Diese bereitzuhalten sorgt für zusätzliche Kosten, die sich das HLRS erspart.

Während in der Vergangenheit ein Supercomputer mit seinen HPC-Anwendungen immer mit einer FP64-Rechenleistung assoziiert wurde und sich dies auch in der Auflistung der Top500 widerspiegelt, sind solche Systeme heutzutage nicht mehr nur rein auf eine möglichst hohe FP64-Rechenleistung ausgelegt. So forschen die Entwickler von Seedbox.ai an destillierten LLMs.

TRUMPF profitiert vom HLRS

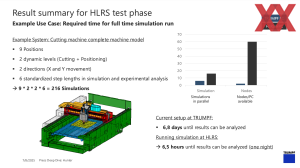

Ebenfalls ein Kunde der frei zugänglichen Rechenleistung von Hunter sind die Laser-Spezialisten von TRUMPF. Doch schon vor Hunter hat man auf die Rechenleistung des HLRS zurückgegriffen. Vor rund 18 Monaten hat man bei TRUMPF damit begonnen, diese Rechenressource zu nutzen. TRUMPF ist unter anderem für seine Lesertechnik bekannt, die auch in allen EUV- und HighNA-EUV-Systemen von ASML zum Einsatz kommt. Bevor man hier aber mit einem Laser einen Tropfen aus flüssigem Zin beschießt, damit dieser sich anders formt und mit dem zweiten Beschuss verdampfen kann, um das ultraviolette Licht zu erzeugen, simuliert TRUMPF die einzelnen Komponenten und Prozessschritte.

Früher ließ man diese Simulationen auf den Rechnern der Ingenieure laufen. Aufgrund der Komplexität konnte dies aber auch mal mehrere Tage dauern. Durch die Nutzung der Rechenleistung des HLRS wurden die Dauer einer solchen Simulation nun auf wenige Stunden reduziert. Die Simulation kann nun über Nacht laufen, der Ingenieur hat morgens sein Ergebnis und kann gegebenenfalls Änderungen vornehmen, bevor er dann die nächste Simulation startet. Die schnellere Iteration der Simulationen führt zu einer schnelleren Entwicklung des zunächst virtuellen Prototypen.

Aus der Entwicklungsabteilung von TRUMPF heraus kann theoretisch jeder Ingenieur auf die Ressourcen des HLRS zurückgreifen und seine Berechnungen starten. Das von TRUMPF dafür zur Verfügung gestellte Budget für die Rechenleistung am HLRS ist im Vergleich zum gesamten R&D-Budget eher überschaubar und bietet daher viel Potential.

Bei TRUMPF mussten - und müssen noch immer - alle Beteiligten aber auch lernen, dieses Werkzeug zu nutzen. Dies setzt unter anderem einfach zugänglichen Schnittstellen voraus. TRUMPF lagert mit der Nutzung der Supercomputer wie Hunter aber auch ein gewisses Risiko aus, da man die Hardware nicht selbst anschafft, sondern bestehende Infrastruktur nutzt.

TRUMPF ist nur einer von etwa 800 Anwendern aus Forschung und Industrie, der die Rechenkapazitäten des HLRS nutzt. Die Forschung bekommt den primären Zugang. Nur mit diesen Nutzern läge die Auslastung des Systems aber bei nur 50 bis 70 % und so wird externen Kunden wie eben der Industrie auch der Zugang gewährt. Mit der kostendeckenden Nutzung findet hier zudem eine Förderung der lokalen Wirtschaft statt, denn diese Unternehmen müssen sich nicht bei den Cloud-Anbietern einbuchen. Ab einem gewissen Volumen an Rechenleistung bzw. wenn einer der Kunden wie TRUMPF zu viel an Rechenzeit beanspruchen würde, ist dies aber auch ein Grund für das HLRS, das Gesuch abzulehnen.

Die größten Kunden des HLRS sind Porsche, Daimler / Mercedes-Benz, Bosch, Airbus, MTU Aero Engines, das DLR, MAN, EnBW, Siemens Energy, BASF und einige mehr.

Emulated FP64, APUs und die Zukunft

Wir haben bereits den Umstand angesprochen, dass neue Supercomputer in den seltensten Fällen rein auf eine möglichst hohe FP64-Rechenleistung ausgelegt sind. Mit der Blackwell-Architektur reduziert NVIDIA die Anzahl der vorhandenen FP64-Recheneinheiten um ein Achtel. Selbst über die Tensor-Kerne geht die FP64-Rechenleistung im Vergleich zur Hopper-Architektur zurück. Bei den neuen Instinct-MI355X-Beschleunigern von AMD stagniert die FP64-Rechenleistung – immerhin nur eine Stagnation.

Mixed Precision Supercomputing heißen die Zauberworte. Systeme wie Hunter müssen mehr können als nur gut in FP64-Berechnungen sein. Bestimmte Anwendungen verlangen nicht nach dieser hohen Präzision, bei KI-Anwendungen sind wir sogar schon bei FP4 angekommen.

Bei NVIDIA verzichtet man auf die nativen FP64-Recheneinheiten, weil diese vergleichsweise viel Platz auf dem Chip einnehmen. Da die KI-Anwendungen diese Genauigkeit nicht brauchen, erhöht NVIDIA die Rechenleistung, indem man FP64- durch FP16/INT16-Einheiten ersetzt. Zusammen mit den Tensor-Kernen können die Blackwell-GPUs daher eine gigantische Anzahl an FP8-Berechnungen durchführen. Mit abnehmender Genauigkeit nimmt der Durchsatz immer weiter zu, da eine FP8-Recheneinheit auch zweimal FP4 gleichzeitig berechnen kann.

Aber auch in die andere Richtung ist dies möglich. Zweimal FP32 können auch eine FP64-Berechnung übernehmen. Noch trickreicher wird die Sache mit einer Emulation von FP64 nach dem Ozaki-Schema. Das Ozaki-Schema beschreibt eine Methode, bei der Matrix-Matrix-Multiplikationen mit hoher Genauigkeit über Maxtrix-Operationen mit niedriger Genauigkeit emuliert werden. Auch wenn dieser Weg deutlich mehr arithmetische Operationen im Vergleich zu einer DGEMM-Umsetzung mit WMAA/MFMA-Instruktionen voraussetzt, so ließe sich damit dennoch eine gewisse FP64-Rechenleistung erzeugen.

Ob eine Emulation von FP64 ein Weg für zukünftige Beschleuniger und die Auslegung der Supercomputer ist, wird sich noch zeigen müssen. Eine FP64-Rechenleistung ist sicherlich nicht für jede Anwendung wichtig und dennoch scheint es nicht so, als wolle sich die Wissenschaft mit ihren Berechnungen allzu schnell davon verabschieden. Gegenkonzepte sehen vor, dass reduzierte Modelle mit KI-Unterstützung an den Simulationen arbeiten und nur noch einzelne Schritte per FP64-Genauigkeit überprüft werden. Stimmen das Modell und die Überprüfung überein, wird mit niedriger Genauigkeit weiter simuliert.

Setzt Herder noch auf APUs?

Bisher hat das HLRS nicht enthüllt, welche Hardware für Herder zum Einsatz kommen wird. Einen Nachfolger der Instinct-MI300A-Beschleuniger als Kombination aus Zen-Kernen und CDNA-Architektur gibt es bisher nicht. Dabei gibt es mit der Zen-5-Architektur und CDNA 4 einen jeweiligen Nachfolger.

Ob es einen Instinct MI400A geben wird, lassen sowohl AMD wie auch das HLRS offen. Dabei wird zumindest eines der beteiligten Unternehmen wissen, ob es einen solchen Beschleuniger geben wird.

Der Direktor des HLRS, Prof. Dr. Michael Resch, sagte auf der Veranstaltung, das man nun ohnehin schon an einem eventuellen Instinct-MI500- oder gar MI600-Beschleuniger interessiert sei. Die Entscheidung für Herder dürfte demnach schon zumindest intern in groben Zügen gefallen sein.