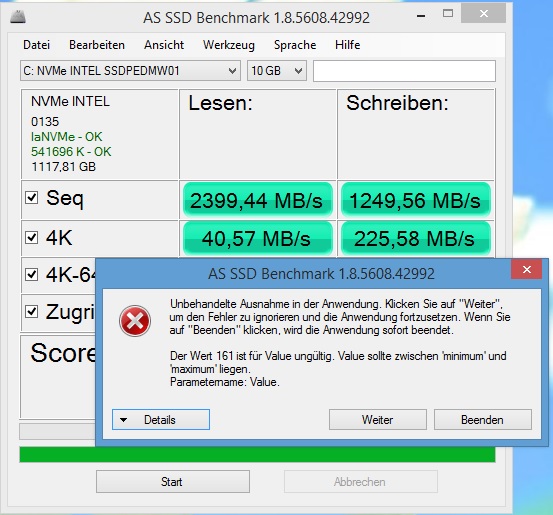

zugriffszeit im 10gb write leider durch diesen error total kaputt... unbrauchbar so. mir werden statt 0.018ns aus dem 1gb test hier 0.218ms angezeigt und das erscheint mir als fehlerhaft. read hingegen normal.

Das glaube ich nicht, bei Write muss ja im Bereich des Testfiles geschrieben werden, sonst würden ja wild irgendwelche Dateien zerstört werden, das wird ja auch nicht auf Low-Level Ebene getestet, bei Lesen kann das schon passen.

Die Fehlermeldung hingegen ist wie du richtig erkannt hast offensichtlich ein Bug, hatte im übrigen die selbe Zugriffszeit im Write

Das ist wohl vom Fortschrittsbalken, da wird wohl ein Wert jenseits von MAX gesetzt, denn kommt typischerweise diese Fehlermeldung.

den einfluss durch die 2.5gb ram der 750 im 1gb vs 10gb test muessen wir jedenfalls verschieben

Wieso? Erstens sind es nur 2GB, es sind zwar 5 512MB Chips, aber das ist eben ECC RAM und dem hat Intel daher einen Chip mehr spendiert:

Und der Einfluss könnte durchaus bei der Zugriffszeit Schreibend zu finden sein, obwohl sich auch die 4k Schreibend bei 10GB schlechter sein dürften, aber zumindest die Intel DC 3700 ist ja bei Zugriffen unter 4k sehr schwach weil extrem auf Zugriffe ab 4k optimiert.

- - - Updated - - -

Hier hat webmi auch einen Benchmark von HD Tune seiner 750, wie man sieht kommt sie bei belegten LBAs nur knapp über 1000MB/s, bei unbelegten LBAs knapp auf 2000MB/s, weil HD Tune ja standardmäßig mit 64k Zugriffen bencht. Das zeigt auch gut, warum das Ermitteln der Zugriffszeit durch zufälliges Lesen von LBAs über den ganzen Adressbereich so komplett sinnfrei und irreführend ist.

- - - Updated - - -

nsa666, wie Du die LBAs ermittels, kannst Du dem Quellcode von

Trimcheck oder eben der Microsoftdokumentation entnehmen. Die werden gerade bei einer vollen Sandforce dann besser sein, weil die Sandforce beim Benchen über einen kleineren Adressbereich besser sein als bei einer vollen SSD über den vollen Adressbereich, da die dann mehr IOPS bieten, was man den alten Datenblättern von SF-SSD, z.B. von OCZ damals, auch entnehmen kann. OCZ hat damals die IOPS über 8GB und über 80 oder 85% ermittelt und da waren die Unterschied teils recht deutlich. Der SF hat ja nur ein fixes SRAM als Cache und kein externes DRAM welches entsprechend der Kapazität größer ausgelegt werden kann.

Werde es mal schnell testen.

Werde es mal schnell testen.