Werbung

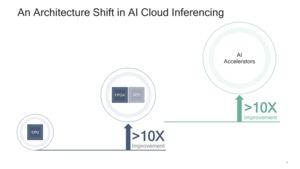

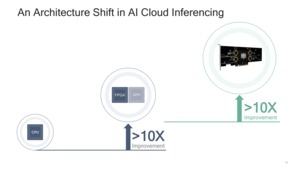

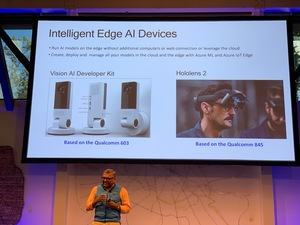

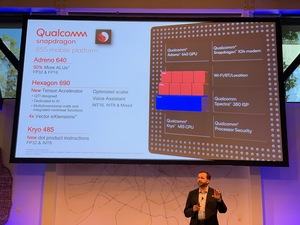

In seinen eigenen SoCs verbaut Qualcomm schon seit geraumer Zeit dedizierte Inferencing-Hardware und beschleunigt damit beispielsweise Mechanismen zur Verbesserung von Bildern, der Spracherkennung und in weiteren Anwendungsbereichen. Doch nun scheint Qualcomm einen Schritt weiter gehen zu wollen und kündigt auf dem AI Day in San Francisco dedizierte Inferencing-Hardware für 2020 an.

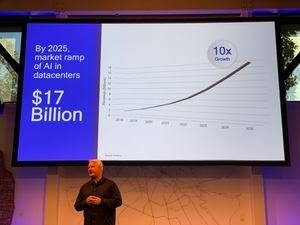

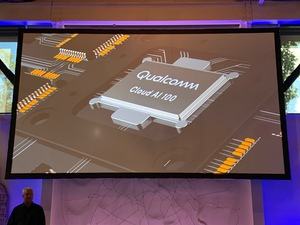

Qualcomm sieht in diesem Markt ein Potential von 17 Milliarden US-Dollar für das Jahr 2025. Dementsprechend will man auch mit eigener Hardware präsent sein. Für die Hardware kann Qualcomm dabei auf die bisherigen Erfahrungen durch die eigenen SoCs zurückgreifen. Dies spielt zudem für die Softwareunterstützung eine Rolle. Dies alles soll den Mobilechip-Riesen dabei unterstützen, im Jahre 2020 mit der Cloud-AI-100-Serie konkurrenzfähig zu sein.

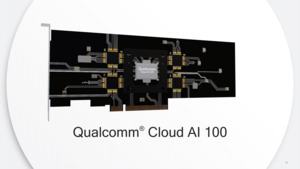

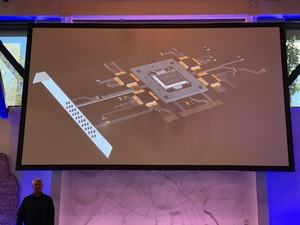

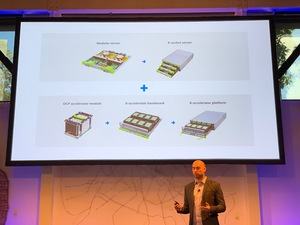

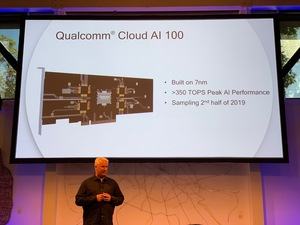

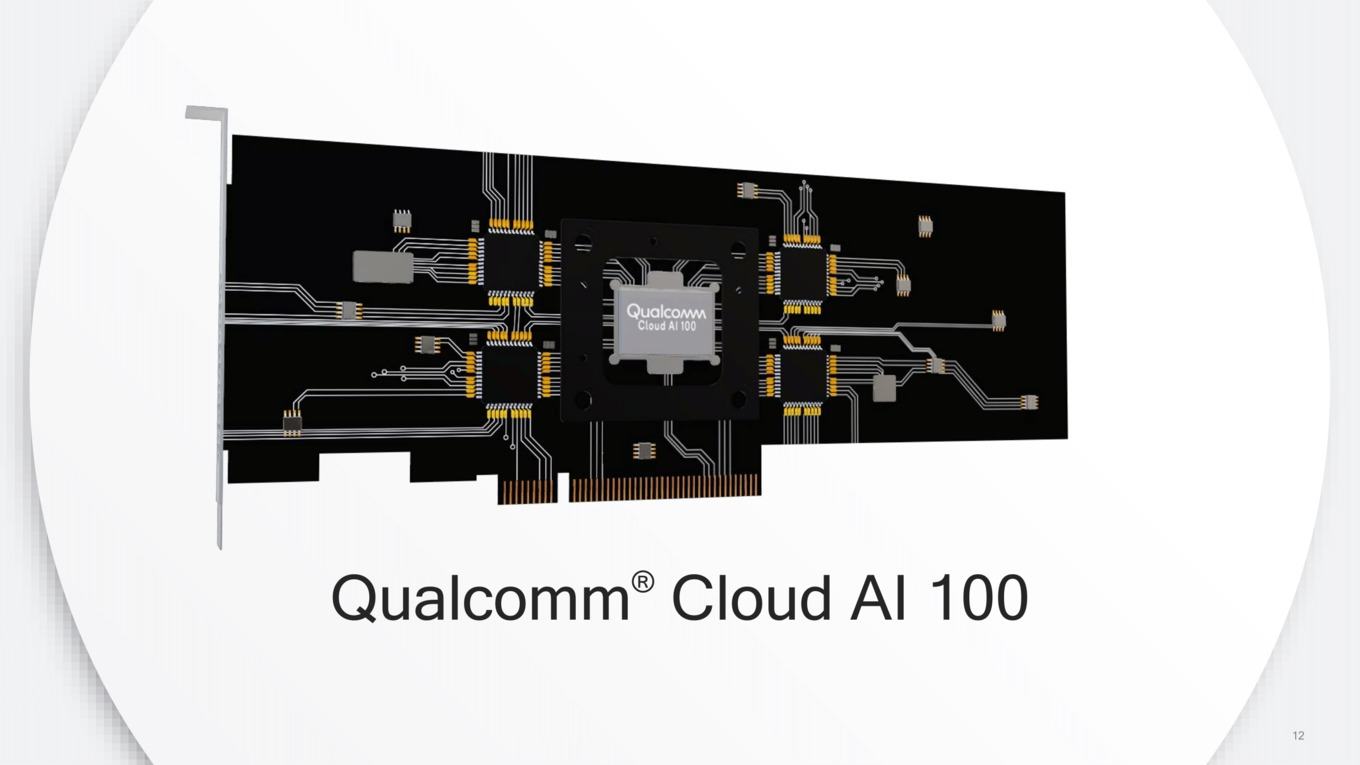

Bereits in diesem Jahr soll es erste Samples der Cloud-AI-100-Hardware geben. Diese besteht aus einer Steckkarte, die im Datacenter eingesetzt wird. Es soll aber verschiedene Varianten geben, die sich hinsichtlich ihrer Leistung, der Bauform und der Thermal Design Power unterscheiden. Gefertigt werden sollen die ASICs (Application Specific Integrated Circuit) in 7 nm – wahrscheinlich im 7-nm-HPC-Verfahren bei TSMC. Weitere technische Daten gibt es nicht. So ist nicht bekannt, ob Qualcomm nur einen Chip entwirft oder es verschiedene Ausbaustufen geben wird.

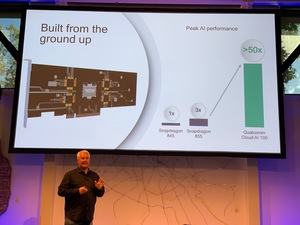

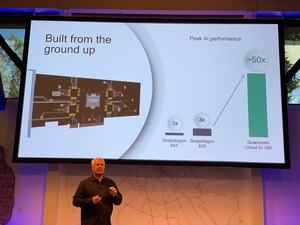

Das Design der Cloud-AI-100-Hardware soll von Grund auf neu entwickelt werden. Auch wenn man aus den Snapdragon-SoCs bereits einiges an Erfahrung mit AI-Hardware sammeln konnte, soll es sich nicht um eine hochskalierte Variante dieser Architektur handeln. Qualcomm startet also mit einem vollständig neuen Ansatz für die Architektur.

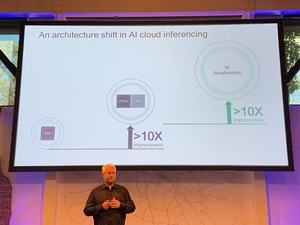

Auffallend: Qualcomm legt sich auf den Begriff Inferencing-Hardware fest. Damit richtet man die Hardware explizit in eine Richtung aus. Das Training von Deep-Learning-Netzwerken wird auf der Cloud-AI-100-Hardware entsprechend nicht möglich sein. Sie ist damit eher mit den Tensor Processing Units (TPU) von Google zu vergleichen, als mit NVIDIAs GPU-Beschleunigern, die sich hinsichtlich ihrer Ausrichtung unterscheiden – Volta-Architektur als Hybrid für das Training sowie das Inferencing (Tesla V100) und die Turing-Architektur rein für das Inferencing (Tesla T4).

Eine kleine Vorschau gibt Qualcomm auf die geplante Leistung. So soll die Cloud-AI-100-Hardware etwa 17 mal schneller als ein Snapdragon 855 sein. Der Snapdragon 820 bildet die Basis für die Benchmarks, ist aber nur 1/50 so schnell. Weitere Details gibt es zum aktuellen Zeitpunkt nicht. Im Verlauf der kommenden 12 Monate wird Qualcomm aber sicherlich immer wieder weitere Details veröffentlichen.

Qualcomm gegen NVIDIA und Intel

Der Markt der Trainings- und Inferencing-Hardware wird zunehmend schwerer umkämpft sein. Aktuell wird er von NVIDIA dominiert, in einigen Teilaspekten hat Google sich mit den TPUs eigene Hardware in die Rechenzentren gestellt und NEC hat mit den SX Aurora TSUBASA spezielle Vektorbeschleuniger, die ebenfalls in diesem Bereich eingesetzt werden können. Auch AMD spielt mit den Radeon-Instinct-Karten mit, der Marktanteil ist aufgrund der fehlenden Softwareunterstützung für alle Konkurrenten von NVIDIA aber gering. Hier hat man sich in mehr als zehn Jahren ein Software-Ökosystem auf Basis von CUDA aufgebaut, welches von 90 % aller Entwickler verwendet wird. AMD ist mit ROCm in dieser Hinsicht bisher gescheitert und dementsprechend gering ist der Marktanteil.

Genau dies wird die Aufgabe von Qualcomm und auch Intel sein – ein Software-Ökosystem zu schaffen, in das Entwickler und Partner auch eintauchen wollen, ohne auf allzu große Hürden zu stoßen. Die Entwicklung der Hardware kann man beiden Unternehmen zutrauen, bei der Software wird bei Intel vor allem die Durchsetzungskraft durch eine breite Hardwarebasis eine entscheidende Rolle spielen. Qualcomm wird es da schon deutlich schwerer haben.