Werbung

Nach Monaten der Gerüchte ist es nun offiziell: Intel greift für die integrierte Grafik einiger Core-Prozessoren der H-Serie auf das Wissen und die Technologie von AMD zurück. Beide Unternehmen haben dies in einer offiziellen Pressemitteilung bestätigt. Die dabei zum Einsatz kommende Fertigungstechnik namens Embedded Multi-Die Interconnect Bridge (EMIB) soll dabei helfen zukünftige Prozessoren in den Notebooks deutlich leistungsstärker zu machen. Zugleich sollen noch dünnere Notebook-Designs möglich werden.

Die Core-H-Prozessoren sind teil der 8. Core-Generation und vereinen die CPU-Technologie von Intel mit einer Grafikeinheit von AMDs Radeon Technologies Group – gepaart mit High Bandwidth Memory der zweiten Generation (HBM2). Es soll sich bei der Grafikeinheit um einen neuen "Semi-Custom Graphics Chip" handeln. Genaue technische Details, beispielsweise welche Architektur zum Einsatz kommt, gibt es nicht. Aufgrund des HBM2 dürften wir hier aber von der Vega-Architektur sprechen.

Unbekannt ist derzeit auch, welche CPU-Architektur seitens Intel zum Einsatz kommt. All diese Informationen sollen zu einem späteren Zeitpunkt bekanntgemacht werden.

Wichtiges Element für die Core-H-Prozessoren ist laut Intel die Entwicklung der Embedded Multi-Die Interconnect Bridge. Diese beschreibt den Aufbau verschiedener Dies auf einem Trägersubstrat. Dieses sogenannte 2,5D-Design kann die verschiedensten Dies untereinander verbinden und stellt dank Through Silicon Vias (TSVs) einen schnellen Interconnect her. Nebenbei erhöht sich natürlich die Packdichte für die einzelnen Komponenten, was den Platzbedarf auf dem PCB verringert und hier für mehr Flexibilität sorgt.

Ähnliche Argumente gibt es bereits im Zusammenspiel mit High Bandwidth Memory, der ebenfalls direkt mit dem Prozessor auf einem Interposer untergebracht wird und mittels Through Silicon Vias (TSVs) verbunden wird. Der schnelle Speicher setzt einen ebenso schnellen Interconnect voraus – dies gilt auch bei den Intel-Core-H-Prozessoren. Mit der EMIB-Technologie lassen sich Dies mit unterschiedlichen Fertigungsgrößen gemeinsam unterbringen. So wäre es möglich die CPU-Part in 10 nm zu fertigen, die GPU aber kommt weiterhin in 14 oder 12 nm von Globalfoundries. Zudem reduziert die Technik im Vergleich zum Silicon-Interposer deutlich die Kosten. Weitere Details zu EMIB hat Intel auf dem letzten Meeting der Technology and Manufacturing Group verraten.

Die zusätzliche Komponente, also der eigentliche CPU-Part, wird von Intel aber nicht nur hinsichtlich der Fertigung eingebunden, sondern auch auf Ebene der Software bzw. des Treibers. Die richtige Balance für die Leistungsaufnahme zwischen CPU und GPU ist wichtig und entscheidend für die Leistung des Gesamtsystems. Die Zuteilung der Leistung mit eventuell vorhandenen Reserven in den Boost-Mechanismen soll aber nicht nur automatisch möglichst ideal erfolgen, sondern sich auch manuell einstellen lassen.

Heute kündigen beide Unternehmen ihre Zusammenarbeit an, ohne konkrete Produkte vorzustellen. Dies soll im ersten Quartal 2018 geschehen.

Stellungnahme von AMD

“Our collaboration with Intel expands the installed base for AMD Radeon GPUs and brings to market a differentiated solution for high-performance graphics,” sagt Scott Herkelman, Vice President und General Manager, AMD Radeon Technologies Group. “Together, we are offering gamers and content creators the opportunity to have a thinner-and-lighter PC capable of delivering discrete performance-tier graphics experiences in AAA games and content creation applications. This new semi-custom GPU puts the performance and capabilities of Radeon graphics into the hands of an expanded set of enthusiasts who want the best visual experience possible.”

Wenige technische Details bekannt

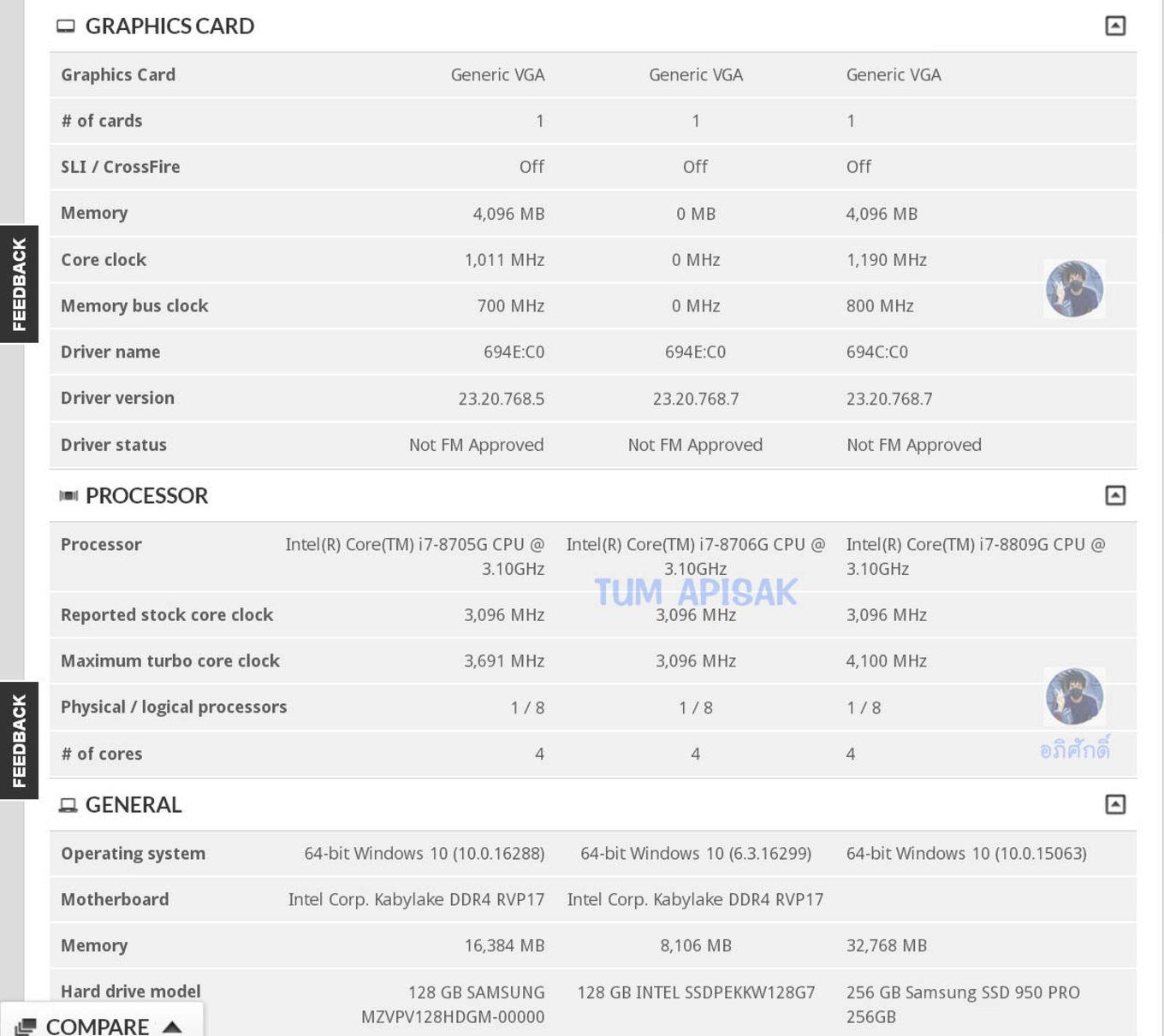

Bisher sind nur wenige technische Details bekannt. Von Intel und AMD gibt es wie gesagt noch gar keine offiziellen Angaben. Aus zahlreichen Leaks scheint aber klar zu sein, dass es mindestens drei Prozessoren der Core-H-Serie geben wird. Diese hören auf den Namen Core i7-8705G, i7-8706G und i7-8809G. Allesamt sollen diese über vier Kerne verfügen. Unterschiede soll es bei der Taktung der CPU-Kerne geben, die von 3,6 bis 4,1 GHz reicht.

Die integrierte Grafikeinheit arbeitet mit 1,0 bis 1,2 GHz. An Speicher stehen offenbar 4 GB zur Verfügung, die mit 700 und 800 MHz arbeiten. Aber auch 8 GB wären denkbar. Leider gibt es derzeit keinerlei Informationen darüber, wie viele Compute Units AMD verbaut und als Custom-Design an Intel liefert.

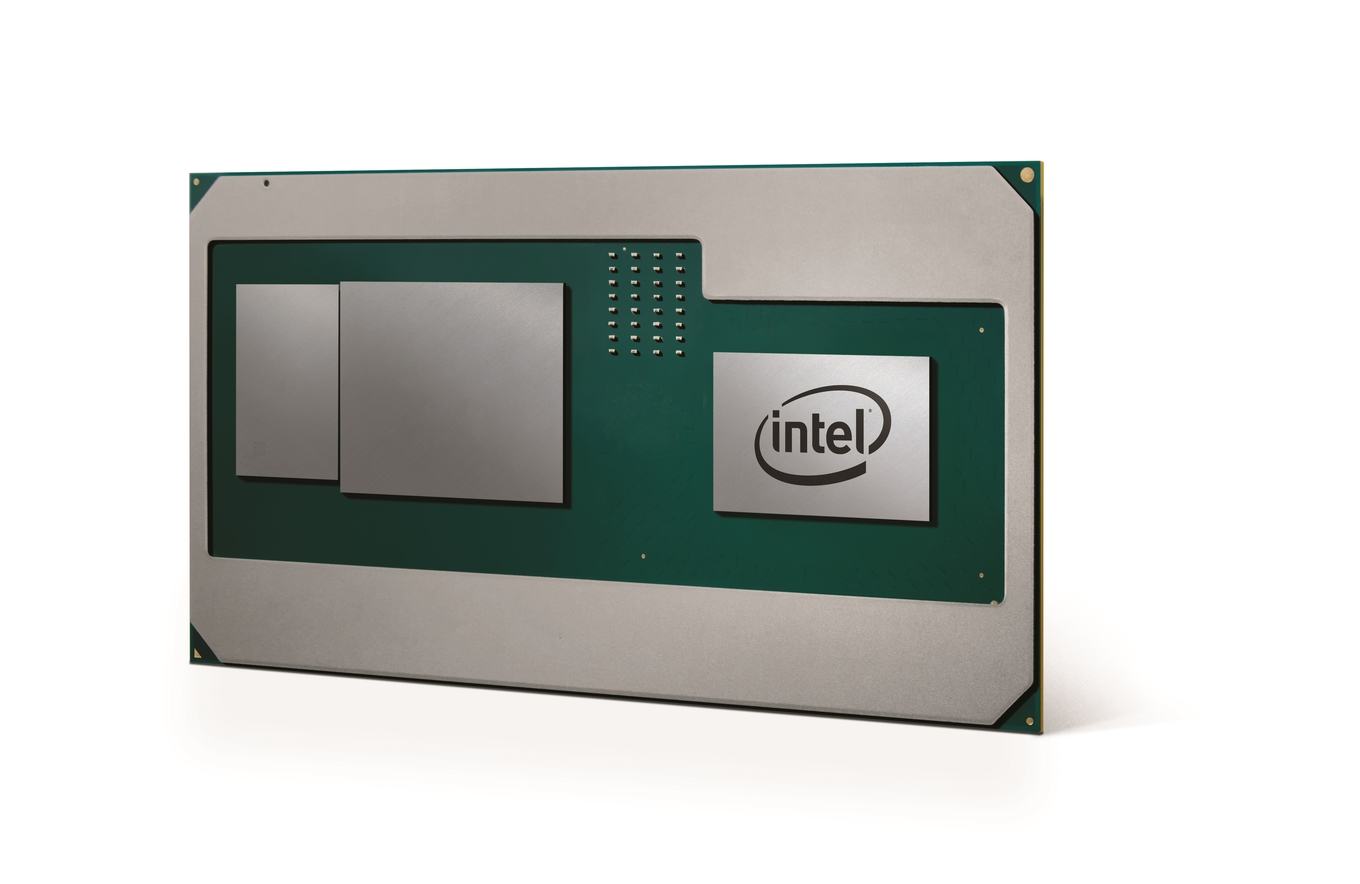

In obigem Bild haben wir die Rendering von Intel einmal entsprechend beschriftet. Ganz rechts ist die CPU von Intel zu sehen. In der Mitte befindet sich die GPU von AMD und links ist der HBM2 angedeutet, der vermutlich in zwei Stacks ausgeführt ist.

In den kürzlich von AMD angekündigten Ryzen-Mobile-Prozessoren alias Raven Ridge, in denen AMD die Zen-CPU-Architektur mit der Vega-GPU-Architektur vereint, verbaut AMD acht bzw. 10 CUs, demzufolge 512 oder 640 Shadereinheiten. Dies dürfte bei den Intel-Prozessoren recht ähnlich sein.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen

Update:

Datenschutzhinweis für Twitter

An dieser Stelle möchten wir Ihnen einen Twitter Feed zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Twitter setzt durch das Einbinden des Applets Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf diesen Feed. Der Inhalt wird anschließend geladen und Ihnen angezeigt.Ihr Hardwareluxx-Team

Tweets ab jetzt direkt anzeigen

Es ist ein erstes echtes Foto und kein 3D-Rendering eines Core H aufgetaucht. Auf dem Bild ist der Chip sozusagen kopfüber zu sehen. Von links nach rechts zu sehen ist die CPU, in der Mitte folgt die GPU und ganz rechts ist der HBM2-Speicherstack platziert. Links und unter dem Chip-Package sind die Spannungsphasen der Strom- und Spannungsversorgung zu sehen. Diese wirkt recht ähnlich zu dem, was wir von den Radeon-RX-Vega-Karten kennen.