Werbung

Android N, Android Wear 2.0 oder Daydream, das waren die oberflächlichen Themen der gestrigen Eröffnungsveranstaltung der Google I/O 2016. Doch wie so oft sind die kleinen, nebensächlichen Erwähnungen der interessante Teil einer solchen Präsentation und dies war auch am gestrigen Abend der Fall. Der Sieg von AlphaGo gegen seinen menschlichen Gegner zeigte zuletzt, dass Google große Ambitionen beim Machine Learning hegt.

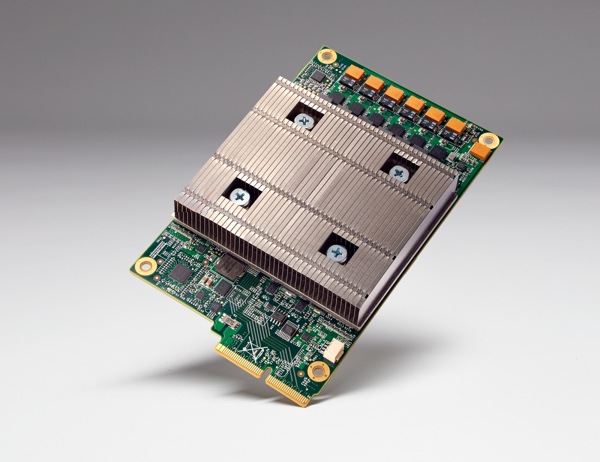

Gestern präsentierte Google nun die bisher geheime Entwicklung einer Tensor Processing Unit (TPU). Dabei handelt es sich um einen Custom-ASIC (Application Specific Integrated Circuit), der speziell auf das Machine Learning mittels TensorFlow zugeschnitten ist. Das bisher geheime Projekt wird bereits seit Jahren bei Google ausgeführt, die Hardware läuft bereits seit mehr als einem Jahr in den eigenen Data-Centern. Die Rechenleistung bzw. das Verhältnis aus Rechenleistung und Leistungsaufnahme soll dabei um Größenordnungen besser sein, als der Einsatz anderer Hardware. Laut eigenen Angaben ist man der übrigen Hardware um sieben Jahre voraus – oder anders gesagt drei Generationen von Moore's Law.

Die TPU ist wie gesagt speziell auf das Training und die Auswertung von Deep-Learning-Netzwerken hin ausgelegt. Dazu ist eine weitaus geringere Genauigkeit notwendig, als dies bei sonst üblichen Compute-Anwendungen erforderlich ist. FP16-Berechnungen sind dafür besonders wichtig und eben darauf ist die TPU von Google ausgelegt. Das Board der Tensor Processing Unit ist dabei nur so groß wie eine 2,5-Zoll-SSD.

Laut Google ist die TPU auch ein gutes Beispiel dafür, wie schnell heutzutage die Entwicklung einer solchen Hardware ablaufen kann. Vom Test des ersten Chips nach den Tape Out bis zur aktuellen Anwendung in den eigenen Rechenzentren sollen gerade einmal 22 Monate vergangen sein. Dabei setzt Google die TPU bereits in zahlreichen Anwendungen ein. Dazu gehört unter anderem RankBrain, ein Netzwerk welches die Auswertung der Resultate in Google Street View und die Navigation übernimmt. Außerdem wurden die Deep-Learning-Netzwerke von AlphaGo auf diesen TPUs trainiert.

Die Hard- und Software für solche Deep-Leaning- oder Machine-Learning-Netzwerke wird immer wichtiger und in Zukunft werden unsere Systeme auch immer abhängiger von solchen Netzwerken. NVIDIA adressiert das Thema bereits seit einigen Jahren und hat spätestens mit der GPU Technology Conference 2015 die Entwicklung der eigenen Hardware auf diese Bedürfnisse umgestellt. In diesem Jahre präsentierte man mit dem Tesla P100 GPU-Beschleuniger die wohl potenteste Hardware für Deep-Leaning-Netzwerke. Die dort verwendete GP100-GPU basiert auf der Pascal-Architektur, die auch bei der GeForce GTX 1080 und GTX 1070 verwendet wird und wird zudem in 16 nm gefertigt. 15,3 Milliarden Transistoren und der Einsatz von HBM2 haben die Rechenleistung auf ein neues Niveau gehoben. Allerdings kann NVIDIA die eigne Hardware und vor allem die Architektur nicht nur auf das Deep Learning ausrichten und somit werden Custom-Chips, wie eben die TPU von Google, in Zukunft eine immer wichtigere Rolle spielen.