Werbung

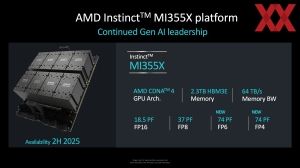

Auf dem "Advancing AI 2024"-Event im vergangenen Herbst stellte AMD mit dem Instinct MI325X den aktuellen KI-Beschleuniger vor, der in diesem Jahr von der nächsten Generation Instinct MI355X ersetzt werden soll. Während NVIDIA den Markt der KI-Beschleuniger dominiert, läuft aber auch das Geschäft bei AMD nicht schlecht, denn das Datacenter-Geschäft machte zuletzt einen Umsatz von 3,67 Milliarden US-Dollar mit einem Plus von 57 % gegenüber dem Vorjahr. Mit 35,6 Milliarden US-Dollar setzte NVIDIA allerdings auch zehnmal so viel um.

Doch während Intel bei den KI-Beschleunigern quasi gar nicht existent ist, bietet AMD zumindest auf dem Papier eine Alternative an. Doch wie SemiAnalysis anmerkt, fällt das Interesse offenbar geringer aus, als man dies erwarten würde. Der MI325X-Beschleuniger sollte das Gegenstück des H200-Beschleunigers werden, ist mit der aktuellen Verfügbarkeit im zweiten Quartal 2025 aber zu spät dran und muss daher eher gegen NVIDIAs Blackwell-Beschleuniger antreten.

Der MI355X-Beschleuniger sollte in der GPU-zu-GPU-Leistung etwas besser gegen die Blackwell-Beschleuniger bestehen könnte, hat aber einen Flaschenhals in der Skalierbarkeit. AMDs Infinity Fabric erlaubt nur die direkte Anbindung von bis zu acht GPUs – sowohl für die MI325X-Beschleuniger wie auch MI355X-Beschleuniger. NVIDIA hingegen kann mit einem GB200-NVL72-Rack 72 Blackwell-GPUs direkt per NVLink miteinander verbinden. Die 13,5 TB HBM3E und 17 TB LPDDR5X erlauben das Training und Inferencing von großen KI-Modellen. Abseits der High-End-Konfiguration dürfte AMD mit dem MI355X-Beschleuniger gegen NVIDIAs HGX B200 NVL8 und HGX B300 NVL16 antreten können.

Wie gut sich die MI355X-Beschleuniger gegen die Konkurrenz von NVIDIA wird schlagen können hängt aber auch davon ab, wie gut AMD hinsichtlich des Software-Ökosystems aufgestellt ist und welchen Preis man aufrufen wird. TCO (Total Cost of Ownership) und die Verfügbarkeit könnten AMD in die Hände spielen – zumindest in einem gewissen Maße wie auch aktuell schon.

MI400X: Aufspaltung in HPC und KI

Mit der Vorstellung der Blackwell-GPU und Architektur ist das Fehlen einer signifikanten FP64-Rechenleistung auffällig. Auf der anderen Seite hat AMD die MI300X-Serie genau dahingehend ausgelegt, was auch dazu führt, dass man bei den schnellsten Supercomputern deutlich besser dasteht als NVIDIA. Auf der anderen Seite hat NVIDIA offenbar den richtigen Riecher gehabt, denn KI-Hardware (egal ob für das Training, zukünftig aber vielmehr noch für das Inferencing) ist gefragt wie niemals zuvor.

Datenschutzhinweis für Twitter

An dieser Stelle möchten wir Ihnen einen Twitter Feed zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Twitter setzt durch das Einbinden des Applets Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf diesen Feed. Der Inhalt wird anschließend geladen und Ihnen angezeigt.Ihr Hardwareluxx-Team

Tweets ab jetzt direkt anzeigen

Laut SemiAnalysis soll sich dies im zweiten Halbjahr 2026 mit der CDNA-Next-Architektur ändern. AMD soll hier eine Aufspaltung der MI400X-Serie in HPC und KI planen. Für HPC mit hoher FP64-Rechenleistung sind die Instinct-MI430X-Beschleuniger vorgesehen, für KI-Anwendungen ist es der MI450X-Beschleuniger.

Aufgrund der in 2026 noch nicht verfügbaren Switches für Ultra Accelerator Link (UALink) wird AMD sich mit einem Instinct MI430X UL4 auf Beschleunigerknoten mit vier GPUs konzentrieren, die direkt miteinander verbunden sind. Für die KI-Variante Instinct MI450X wird Ultra Ethernet zum Einsatz kommen. Per Ultra Ethernet will AMD das Scale Up für große KI-Systeme ermöglichen.

Während die Entwicklung von Ultra Ethernet als offener Standard aber zumindest absehbare Einsatzmöglichkeiten haben wird, scheint genau das bei UALink nicht der Fall zu sein. Broadcom und Astera Labs arbeiten an Switches für UALink, diese dürften aber 2026 noch nicht zur Verfügung stehen. Daher konzentriert sich AMD auf den Instinct MI430X UL4, der sein eigenes kleines Mesh als Interconnect verwenden kann. AMD hat laut SemiAnalysis schlichtweg nicht die Ressourcen für eine eigenen Entwicklung bei UALink. Anders ist dies bei Ultra Ethernet, wo man mit Pensando auch einen entsprechenden Zukauf im Netzwerkbereich gemacht hat.

Wir sind gespannt wie sich AMD mit der Instinct-MI400-Serie aufstellen wird. Zumindest für kleinere KI-Systeme ist man mit dem MI355X-Beschleuniger offenbar ganz gut aufgestellt, für die gigantischen KI-Supercomputer bietet NVIDIA mit dem GB200 NVL72 aber die bessere Lösung – wenngleich deutlich teurer.

Update: Informationen zur Racklösung MI450X IF128

Bisher ist AMD in der Anbindung der Beschleuniger auf jeweils acht GPUs per Infinity Fabric beschränkt. Alles darüber hinaus muss bisher über Ethernet laufen. Der Trend zu kompletten Racklösungen hat AMD dazu veranlasst, ZT Systems zu kaufen. Früchte tragen soll dies ab dem Instinct-MI450X-Beschleuniger, der gegen NVIDIA's VR200 NVL144 antreten wird.

Datenschutzhinweis für Twitter

An dieser Stelle möchten wir Ihnen einen Twitter Feed zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Twitter setzt durch das Einbinden des Applets Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf diesen Feed. Der Inhalt wird anschließend geladen und Ihnen angezeigt.Ihr Hardwareluxx-Team

Tweets ab jetzt direkt anzeigen

In der zweiten Jahreshälfte 2026 soll das Rack-System MI450X IF128 auf den Markt kommen. "IF128" steht dabei für Infinity Fabric und die Zahl gibt die Anzahl der miteinander verbundenen GPUs an. Der Infinity-Fabric-Interconnect kommt dabei auf eine bidirektionale Bandbreite von 1,8 TB/s. Das Gegenstück VR200 NVL144 verbindet 72 GPUs (mit jeweils zwei Rubin-GPUs in einem Package) miteinander.

In der Racklösung wird AMD laut SemiAnalysis verschiedene Konfigurationen anbieten, bei denen eine unterschiedliche Anzahl an AMDs Pensando 800GbE NICs pro GPU vorhanden sind. Je nach Konfiguration können besagte 1,8 TB/s zwischen den GPUs erreicht werden.

Datenschutzhinweis für Twitter

An dieser Stelle möchten wir Ihnen einen Twitter Feed zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Twitter setzt durch das Einbinden des Applets Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf diesen Feed. Der Inhalt wird anschließend geladen und Ihnen angezeigt.Ihr Hardwareluxx-Team

Tweets ab jetzt direkt anzeigen

Neben der vollen Ausbaustufe von MI450X IF128 mit 128 GPUs wird AMD laut SemiAnalysis auch eine Single-Rack-Variante alias MI450X IF64 mit 64 GPUs anbieten. Innerhalb eines Racks und auch in der IF128-Konfiguration über zwei Racks nutzt AMD eine Flat-Copper-Technologie mit passiven Komponenten.