Werbung

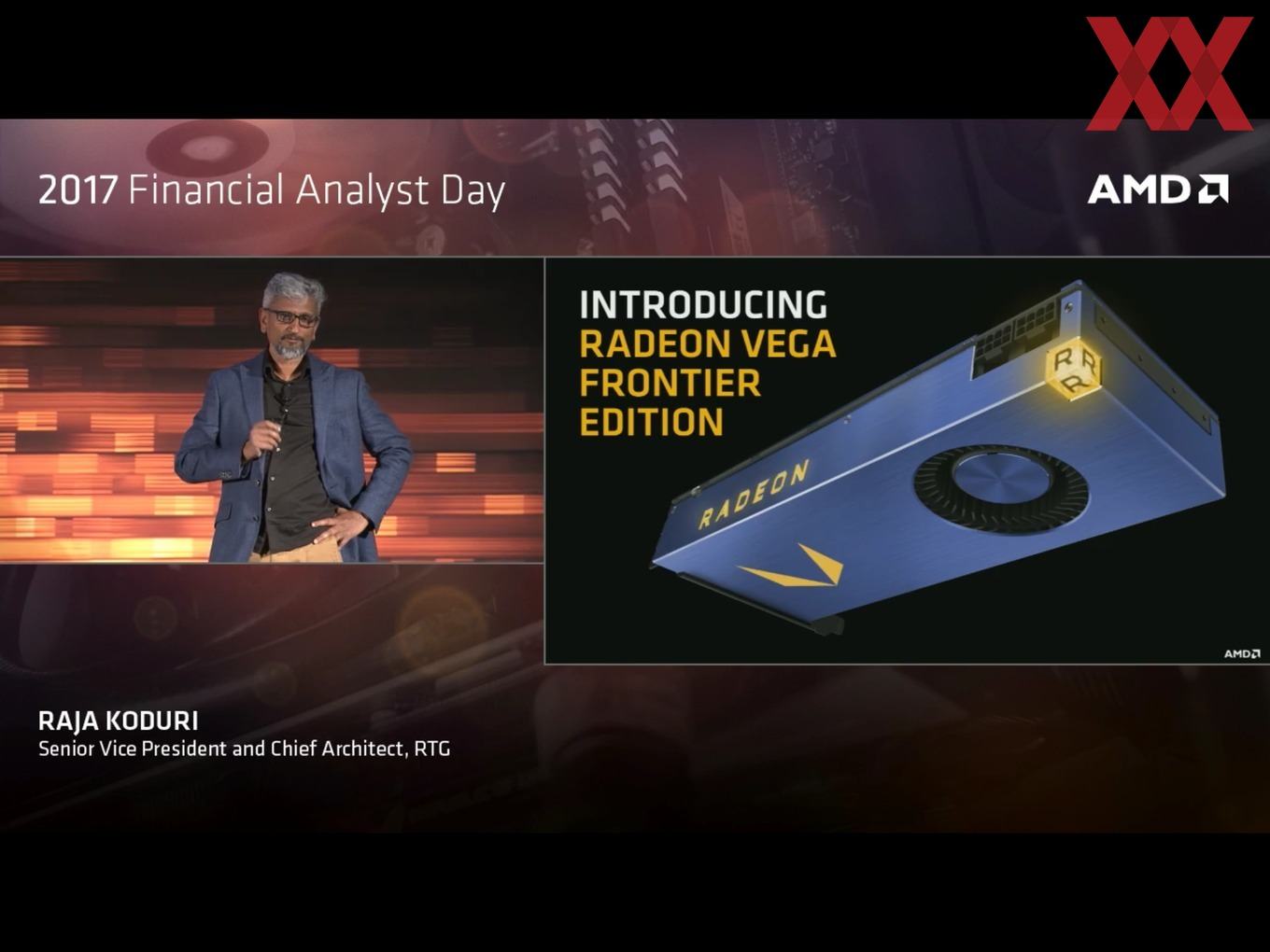

Auf dem 2017 Financial Analyst Day von AMD hat der Gafikkarten-Hersteller nicht nur den ersten GPU-Beschleuniger mit Vega-GPU vorgestellt, sondern auch gleich einige Benchmarks geliefert. Demnach soll die Radeon Vega Frontier Edition mit 16 GB HBM2 um den Faktor 1,5 mal schneller sein als eine NVIDIA Tesla P100. Die Kollegen der c't-Redaktion, genauer gesagt Kollege Andreas Stiller, der sich auf die Analyse von Prozessor-Architekturen und dem High Performance Computing spezialisiert hat, haben sich die von AMD präsentierten Ergebnisse einmal etwas genauer angeschaut.

Doch zunächst einmal zu dem Vergleich, den AMD zum Start der Radeon Vega Frontier Edition präsentiert hat. Man will sich mit Intels Xeon Phi Knights Landing 7250 und NVIDIAs Tesla M40 bzw. Tesla P100 vergleichen. So ganz fair ist dieser Vergleich jedoch nicht, da NVIDIA mit der Tesla P40 bereits vor einiger Zeit einen Nachfolger der kleineren Karte vorgestellt hatte. Außerdem stellte NVIDIA vor etwa zwei Wochen die Tesla V100 auf Basis der neuen Volta-Architektur vor. Hier allerdings kann AMD sicherlich aus Mangel an der notwendigen Hardware noch keine Vergleiche anstellen.

Jeder Hersteller will bestmöglich dastehen

Zunächst einmal aber zur allgemeinen Einschätzung von Benchmarks, die vom Hersteller präsentiert werden. Jedem sollte klar sein, dass jeder Hersteller sich bestmöglich darstellen möchte. Daher werden die Benchmarks meist so ausgewählt, dass die eigene Hardware ihre Stärken ausspielen kann. Während dies bei den Spielen noch recht einfach aussehen kann und beinahe jedes Entwicklerstudio sich seinen Partner, egal ob AMD oder NVIDIA, sucht, können die Benchmarks im professionellen Bereich durch unterschiedliche Compiler und Bibliotheken derart optimiert werden, dass dies auf den ersten Blick gar nicht so ersichtlich ist.

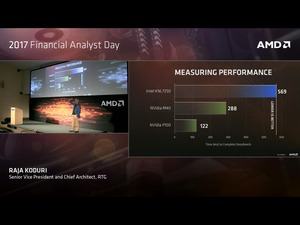

AMD hat in seinem ersten Leistungsvergleich den DeepBench verwendet. Dieser kennt Werte wie sie AMD angibt (Millisekunden) eigentlich gar nicht. AMD hat hier offenbar einen Teil der Benchmarks-Suite verwendet, der als Convolution bezeichnet wird. Diese besteht aus 36 Einzelbenchmarks und die Ergebnisse werden eigentlich in TFLOPS ausgegeben.

Wie dies aussehen kann, zeigt Intel im Graphen unter diesem Textabschnitt. AMD hingegen hat die Einzelzeiten einfach aufaddiert, was man in diesem Fall aber nicht so einfach tun kann. Manche Teilbenchmarks benötigen mehrere hundert Millisekunden, andere wiederum sind in einigen Mikrosekunden erledigt. Selbst das Bilden eines geometrischen Mittels ist hier keine geeignete Maßnahme.

Aber auch beim einfachen Aufaddieren scheint es Unstimmigkeiten zu geben. Laut c't stimmen nicht alle Werte mit dem überein, was in der Datenbank zu finden ist. Eine Randnotiz ist, dass AMD offenbar die PCI-Express-Variante der Tesla P100 verwendet hat, was im Hinblick auf die Radeon Vega Frontier Edition, die ebenfalls eine PCI-Express-Karte ist, aber sinnvoll erscheint.

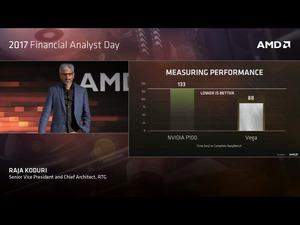

Die c't hat die Werte der Github-Seite Baidu-Research einmal aufbearbeitet und eine andere Darstellung gewählt. Dabei hat man die DeepBench-Werte im geometrischen Mittel genommen und die Leistungswerte aufgelistet. Demnach ist eine NVIDA Titan Xp um den Faktor 2,75 mal schneller als eine Intel Xeon Phi 7250, die als Basiswert genommen wurde. Eine NVIDIA Tesla P100 ist 1,83 mal schneller als der Intel-GPU-Beschleuniger und die AMD Radeon Vega Frontier Edition ist doppelt so schnell wie die Xeon Phi. Der Abstand zwischen der NVIDIA Tesla P100 und Radeon Vega Frontier Edition schrumpft im Vergleich zu der Aufarbeitung von AMD aber deutlich zusammen.

In den von Intel präsentierten Werten wird außerdem deutlich, wie groß der Einfluss verschiedener Bibliotheken ist. NVIDIA optimiert beispielsweise CudaDNN auf bestimmte Algorithmen, solche Optimierungen fehlen dann bei Intel und AMD möglicherweise. Bei AMD ist nur bekannt, dass der Treiber ROCm 1.5 eingesetzt wurde. Einzelheiten über die verwendeten Bibliotheken und Algorithmen kennt man jedoch nicht. AMD verwendet in diesem Bereich unterschiedliche Bibliotheken, mal bis Graphics Core Next 3 (Fiji-GPU) und mal bis GCN4 (Polaris-GPU) optimiert.

Noch einmal sei an dieser Stelle betont, dass die Hersteller allesamt in einem möglichst guten Licht darstehen möchten und dementsprechend auch solche Leistungsangaben wählen. Hier immer mal wieder einen kritischen Blick darauf zu werfen kann aber nicht schaden, wie die Ergebnisse der c't zeigen.