Werbung

Mit der GeForce GTX 1080 Ti kündigte NVIDIA zu Beginn des Monats seine bislang schnellste GeForce-Grafikkarte an. Während die Founders Edition schon seit ein paar Tagen mehr oder weniger zu einem Preis ab 819 Euro erhältlich ist, lassen die Custom-Karten der Boardpartner noch immer auf sich warten. Zwar wurden schon etliche Modelle von ASUS, MSI, Gigabyte, EVGA, Inno3D, ZOTAC und Co. angekündigt und von uns übersichtlich in einer Tabelle vorgestellt, in den Handel geschafft hat es laut Preisvergleich bislang allerdings noch kein einziges Modell. Viele Hersteller verzichten sogar noch auf nähere Angaben zur Strom- und Spannungsversorgung und schweigen sich gar über die finalen Taktraten ihrer kommenden Eigenlösungen noch aus. Als einer der ersten Hersteller konnte uns nun aber ASUS mit einem ersten Modell versorgen. Heute erreichte die ASUS ROG GeForce GTX 1080 Ti Strix OC die Redaktion.

Sie hat mit der bereits getesteten Founders Edition von NVIDIA nicht mehr viel gemein. Unter der Haube des eigenen 2,5-Slot-Kühlers gibt es zwar weiterhin den 12 Milliarden Transistoren starken GP102-Chip mit seinen 3.584 Rechenwerken und dem 11 GB großen GDDR5X-Videospeicher, das PCB wurde allerdings deutlich aufgewertet. Zur Verfügung stehen dem Grafikprozessor satte zehn Phasen, während die Speicherchips über zwei eigene Phasen mit Strom versorgt werden. Statt des zusätzlichen 6- und 8-Pin-PCI-Express-Stromsteckers wie noch bei der Founders Edition gibt es gleich zwei 8-Pin-Stecker, womit das ASUS-Topmodell theoretisch bis zu 375 W aus der Steckdose bzw. dem Netzteil ziehen könnte. Die maximale Leistungsaufnahme dürfte aufgrund des Taktplus aber nur geringfügig oberhalb der von NVIDIA spezifizierten 250 W liegen.

Eigenes Layout, höhere Taktraten

Apropos Taktraten: Während sich die NVIDIA-Vorlage mit einem Basis- und Boost-Takt von 1.480 bzw. mindestens 1.582 MHz ans Werk macht, bringt es die ASUS ROG GeForce GTX 1080 Ti Strix OC auf 1.594 bzw. 1.708 MHz. Die OC-Taktraten müssen allerdings erst über das ASUS-eigene Tool "GPU Tweak II" freigeschaltet werden, im Gaming-Modus arbeitet der 3D-Beschleuniger – zumindest auf dem Papier – etwas langsamer.

In ersten Tests erreicht unser Testmuster aufgrund der starken Kühlung sogar Geschwindigkeiten von über 1.900 MHz und überflügelt damit die Werte der Founders Edition mit Leichtigkeit. Hinzu kommt, dass die Taktraten über einen längeren Zeitraum gehalten werden können, was die Performance in Spielen deutlich verbessert.

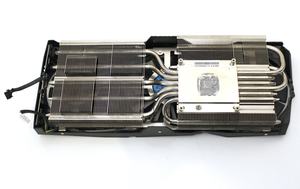

Die Kühlung im Vergleich zum kleinen Schwestermodell will ASUS weiter verbessert haben. So wollen die Taiwaner die Wärmeabfuhr aufgrund einer planeren Oberfläche der Kupferplatte, auf der die dicken Heatpipes direkt aufliegen, verbessert haben. Hinzu kommen ein überarbeitetes Rotor-Design der drei 90-mm-Lüfter sowie 40 % mehr Aluminiumfinnen, was letztendlich den Anstieg der Bauhöhe auf 2,5 Slots zur Folge hat. Trotzdem will ASUS ausreichend Platz gelassen haben, um ein SLI-System aufziehen zu können.

Um die Kühlung zu verbessern, gibt es zudem wieder die Möglichkeit, zwei Gehäuse-Lüfter direkt an die Grafikkarte anzuschließen, die dann in Abhängigkeit der GPU-Temperatur automatisch geregelt werden. Das Aura-Beleuchtungssystem mit zahlreichen RGB-LEDs ist natürlich auch beim Topmodell wieder mit von der Partie. Gesteuert werden kann alles zentral über hauseigene ASUS-Tools. Einstellbar sind neben Farbe und Beleuchtungseffekt, auch die verschiedenen Betriebsmodi für die Grafikkarte (Gaming, OC) und natürlich die Lüftersteuerung. Ein Auslesen der wichtigsten Paramter ist ebenfalls möglich.

Eine weitere Besonderheit: ASUS wird für seine neue Strix-Grafikkarte ein Silent-BIOS zum Download anbieten, welches die Lüftergeschwindigkeiten von maximal rund 1.600 RPM auf 1.300 RPM reduziert und somit die Lautstärke weiter verringert. Dafür steigt das Temperatur-Target von etwa 70 auf 75 °C an.

Unter der Haube gibt es außerdem hochwertige Bauteile, die für eine längere Lebensdauer und gleichzeitig niedrigere Temperaturen sowie für ein größeres Overclocking-Potential sorgen sollen.

| Modell: | ASUS ROG GeForce GTX 1080 Ti Strix OC | NVIDIA GeForce GTX 1080 Ti Founders Edition | |

| Straßenpreis: | noch nicht verfügbar | 819 Euro | |

| Webseite: | www.asus.com | www.nvidia.de | |

| Technische Daten | |||

|---|---|---|---|

| GPU: | GP102 | GP102 | |

| Fertigung: | 16 nm | 16 nm | |

| Transistoren: | 12 Milliarden | 12 Milliarden | |

| GPU-Takt (Basis): | 1.594 MHz | 1.480 MHz | |

| GPU-Takt (Boost): | 1.708 MHz | 1.582 MHz | |

| Speichertakt: | 1.388 MHz | 1.375 MHz | |

| Speichertyp: | GDDR5X | GDDR5X | |

| Speichergröße: | 11 GB | 11 GB | |

| Speicherinterface: | 352 Bit | 352 Bit | |

| Bandbreite: | 486,5 GB/s | 484 GB/s | |

| DirectX-Version: | 12 | 12 | |

| Shadereinheiten: | 3.584 | 3.584 | |

| Textureinheiten: | 224 | 224 | |

| ROPs: | 88 | 88 | |

| Typische Boardpower: | 250 W | 250 W | |

| SLI/CrossFire | SLI | SLI | |

Wie sich die ASUS ROG GeForce GTX 1080 Ti Strix OC als erste Custom-Karte des neuen NVIDIA-Flaggschiffs schlagen wird, werden wir exklusiv in den kommenden Tagen in einem ausführlichen Review aufzeigen dürfen. Wir schnallen unser Testmodell schon einmal in das Testsystem!