News und Artikel durchsuchen

{{#data.error.root_cause}}

{{/data.error}}

{{^data.error}}

{{#texts.summary}}

[{{{type}}}] {{{reason}}}

{{/data.error.root_cause}}{{texts.summary}} {{#options.result.rssIcon}} RSS {{/options.result.rssIcon}}

{{/texts.summary}} {{#data.hits.hits}}

{{#_source.featured}}

FEATURED

{{/_source.featured}}

{{#_source.showImage}}

{{#_source.image}}

{{/_source.image}}

{{/_source.showImage}}

{{/data.hits.hits}}

{{{_source.title}}} {{#_source.showPrice}} {{{_source.displayPrice}}} {{/_source.showPrice}}

{{#_source.showLink}} {{/_source.showLink}} {{#_source.showDate}}{{{_source.displayDate}}}

{{/_source.showDate}}{{{_source.description}}}

{{#_source.additionalInfo}}{{#_source.additionalFields}} {{#title}} {{{label}}}: {{{title}}} {{/title}} {{/_source.additionalFields}}

{{/_source.additionalInfo}}

Inferencing

-

Leistungs- und TCO-Einschätzung: SemiAnalysis wiederholt Benchmarks täglich

Die Analysten von SemiAnalysis haben in Zusammenarbeit mit AMD, NVIDIA, Microsoft, OpenAI, Together AI, CoreWeave, Nebius, PyTorch Foundation, Supermicro, Crusoe, HPE, Tensorwave, VLLM, SGLang und einigen mehr ein neues Open-Source-Werkzeug entwickelt, welches die Inferencing-Leistung der aktuellen Hardware beleuchten soll. InferenceMAX lautet der Name der Vergleichs-Plattform. Tokens pro Sekunde, Tokens je GPU, Tokens pro Watt, aber auch... [mehr]

Die Analysten von SemiAnalysis haben in Zusammenarbeit mit AMD, NVIDIA, Microsoft, OpenAI, Together AI, CoreWeave, Nebius, PyTorch Foundation, Supermicro, Crusoe, HPE, Tensorwave, VLLM, SGLang und einigen mehr ein neues Open-Source-Werkzeug entwickelt, welches die Inferencing-Leistung der aktuellen Hardware beleuchten soll. InferenceMAX lautet der Name der Vergleichs-Plattform. Tokens pro Sekunde, Tokens je GPU, Tokens pro Watt, aber auch... [mehr] -

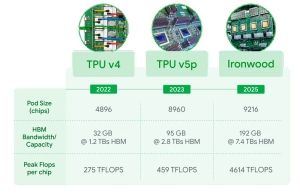

Google TPU Ironwood: Google bereitet sich auf den Inferencing-Boom vor

Auf der Google Cloud Next 25 hat der Internetriese Google oder besser die Cloud-Sparte die nächste Generation seiner eigenen Tensor Processing Unit (TPU) präsentiert. Der Ironwood genannte Prozessor bietet eine Spitzen-Rechenleistung von 4.614 TFLOPs an FP8-Rechenleistung. Nach NVIDIA und AMD richtet Google die eigene Hardware klar auf das Inferencing von KI-Modellen aus. Die Hardware kommt also weniger für das Training neuer Modelle zum... [mehr]

Auf der Google Cloud Next 25 hat der Internetriese Google oder besser die Cloud-Sparte die nächste Generation seiner eigenen Tensor Processing Unit (TPU) präsentiert. Der Ironwood genannte Prozessor bietet eine Spitzen-Rechenleistung von 4.614 TFLOPs an FP8-Rechenleistung. Nach NVIDIA und AMD richtet Google die eigene Hardware klar auf das Inferencing von KI-Modellen aus. Die Hardware kommt also weniger für das Training neuer Modelle zum... [mehr] -

MTIAv2: Meta präsentiert die nächste Generation seines eigenen Inferencing-Chips

Meta hat die zweite Generation seines MTIA (Meta Training and Inference Accelerator) präsentiert. Erst Anfang Februar hatte ma verkündet, dass der MTIAv2 in die eigenen Rechenzentren wandert, nun nennt man technische Details. Je nach Datentyp hat Meta die Rechenleistung des MTIA vervierfacht. Gefertigt wird der neue Chip in 5 nm bei TSMC. Die 2,35 Milliarden Transistoren kommen auf eine Chipfläche von 25,6 x 16,4 mm... [mehr]

Meta hat die zweite Generation seines MTIA (Meta Training and Inference Accelerator) präsentiert. Erst Anfang Februar hatte ma verkündet, dass der MTIAv2 in die eigenen Rechenzentren wandert, nun nennt man technische Details. Je nach Datentyp hat Meta die Rechenleistung des MTIA vervierfacht. Gefertigt wird der neue Chip in 5 nm bei TSMC. Die 2,35 Milliarden Transistoren kommen auf eine Chipfläche von 25,6 x 16,4 mm... [mehr] -

MLPerf 0.7 Inferencing zeigt NVIDIAs aktuellen Vorsprung auf

MLPerf hat sich zum Ziel gesetzt, eine bessere Vergleichbarkeit für die Bestimmung und den Vergleich von Rechenleistung im AI-, bzw. ML-Bereich herzustellen. Neben den großen Chip-Herstellern Intel und NVIDIA sind auch ARM, Google, Intel, MediaTek, Microsoft und viele anderen Unternehmen daran beteiligt und ermöglichen somit eine bessere Vergleichbarkeit der Leistung in diesem Bereich. Nachdem bereits vor einiger Zeit die Resultate... [mehr]

MLPerf hat sich zum Ziel gesetzt, eine bessere Vergleichbarkeit für die Bestimmung und den Vergleich von Rechenleistung im AI-, bzw. ML-Bereich herzustellen. Neben den großen Chip-Herstellern Intel und NVIDIA sind auch ARM, Google, Intel, MediaTek, Microsoft und viele anderen Unternehmen daran beteiligt und ermöglichen somit eine bessere Vergleichbarkeit der Leistung in diesem Bereich. Nachdem bereits vor einiger Zeit die Resultate... [mehr]