Werbung

Am Sonntag wird die diesjährige Hot-Chips-Konferenz starten. Auf dieser werden zahlreiche Halbleiterhersteller über ihre aktuellen und zukünftigen Chips und Entwicklungen sprechen. Teilweise werden hier Details verraten, die man an anderer Stelle nicht in Erfahrung bringen kann. Im Programm zur Hot Chips 2025 wird bereits aufgeführt, welche Vorträge gehalten werden.

Bereits im Vorfeld hat NVIDIA einige Details zu den geplanten Vorträgen verraten. Je nach Inhalt dieser werden wir die weiteren Details daraus in gesonderten Meldungen aufbereiten.

Bereits am Sonntag gibt es eine Tutorial-Runde, in der NVIDIA über die eigenen Racklösung GB200 NVL72 sprechen wird. Die wichtigsten Details zum GB200 NVL72 finden sich bereits bei uns. Auch ein weiterer Vortrag richtet sich an Blackwell-Hardware. In der Präsentation namens "RTX 5090: Designed for the Age of Neural Rendering" spricht NVIDIA über die Arbeit im Hinblick auf die Zukunft des Neural-Renderings.

Da NVIDIA bisher noch nicht in aller Ausführlichkeit über den GB10-Superchip gesprochen hat und dieser anders als versprochen bisher noch nicht in Systemen verfügbar ist, schauen viele sicherlich gespannt auf "NVIDIA’s GB10 SoC: AI Supercomputer On Your Desk".

Die Netzwerkhardware und das Netzwerkdesign eines Rechenzentrums werden vor allem bei großen KI-Systemen immer wichtiger. Mit "NVIDIA ConnectX-8 SuperNIC: A Programmable RoCE Architecture for AI Data Centers" und "Co-Packaged Silicon Photonics Switches for Gigawatt AI Factories" adressiert NVIDIA auch diesen Themenbereich.

Spectrum-XGS verbindet ganze Rechenzentren miteinander

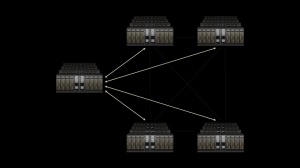

Aber es gibt bereits einige Ankündigungen aus den Vorträgen der Hot Chips. So wird NVIDIA neben den Ethernet-Switches Spectrum-X künftig Lösungen anbieten, die komplette Rechenzentren untereinander verbinden sollen. Aktuell konzentriert sich beim Bau neuer Rechenzentren vieles darauf, einzelne Rechenzentren so groß wie möglich zu dimensionieren, um sogenannte KI-Gigarechenzentren aufzubauen. Natürlich sind Rechenzentren bereits heute miteinander verbunden, allerdings sorgen Einschränkungen in der Bandbreite, den Latenzen oder weitere Faktoren dafür, dass gewisse Anwendungen nicht gemeinsam auf der Hardware mehrerer Rechenzentren bearbeitet werden können.

Mit Spectrum-XGS Ethernet will NVIDIA die Hürden und Limitierung in der Verbindung mehrerer Rechenzentren eliminieren. Spectrum-XGS Ethernet ist vollständig in die Spectrum-X-Plattform integriert und verfügt über Algorithmen, die das Netzwerk dynamisch an die Entfernung zwischen den Rechenzentrumsanlagen anpassen sollen. Themen wie Auto-adjusted Distance Congestion Control, Precision Latency Management und eine Ende-zu-Ende-Telemetrie werden entsprechend optimiert, so dass es zumindest die Option geben wird, mehrere KI-Rechenzentren miteinander zu verbinden und diese gemeinsam an einer Aufgabe arbeiten zu lassen.

CoreWeave wird als einer der ersten Cloud-Provider auf Spectrum-XGS Ethernet setzen, um mehrere Rechenzentren miteinander zu verbinden.

Weitere Details werden im Rahmen der Hot Chips erwartet.