News und Artikel durchsuchen

{{#data.error.root_cause}}

{{/data.error}}

{{^data.error}}

{{#texts.summary}}

[{{{type}}}] {{{reason}}}

{{/data.error.root_cause}}{{texts.summary}} {{#options.result.rssIcon}} RSS {{/options.result.rssIcon}}

{{/texts.summary}} {{#data.hits.hits}}

{{#_source.featured}}

FEATURED

{{/_source.featured}}

{{#_source.showImage}}

{{#_source.image}}

{{/_source.image}}

{{/_source.showImage}}

{{/data.hits.hits}}

{{{_source.title}}} {{#_source.showPrice}} {{{_source.displayPrice}}} {{/_source.showPrice}}

{{#_source.showLink}} {{/_source.showLink}} {{#_source.showDate}}{{{_source.displayDate}}}

{{/_source.showDate}}{{{_source.description}}}

{{#_source.additionalInfo}}{{#_source.additionalFields}} {{#title}} {{{label}}}: {{{title}}} {{/title}} {{/_source.additionalFields}}

{{/_source.additionalInfo}}

HBM4

-

HBM4, C-HBM4 und SPHBM4: Weitere Variante reduziert Breite des Speicherinterface

Ab dem kommenden Jahr werden alle neuen KI-Beschleuniger auf den schnelleren HBM4 setzen. Dieser erhöht nicht nur die Speicherbandbreite im Vergleich zum HBM3E, sondern auch in der Kapazität werden die Beschleuniger noch einmal deutlich zulegen. So werden die Instinct-MI400-Beschleuniger von AMD auf 432 GB an Kapazität und eine Speicherbandbreite von 19,6 TB/s kommen. In ähnliche Dimensionen wird NVIDIA mit der Rubin-Generation vorstoßen,... [mehr]

Ab dem kommenden Jahr werden alle neuen KI-Beschleuniger auf den schnelleren HBM4 setzen. Dieser erhöht nicht nur die Speicherbandbreite im Vergleich zum HBM3E, sondern auch in der Kapazität werden die Beschleuniger noch einmal deutlich zulegen. So werden die Instinct-MI400-Beschleuniger von AMD auf 432 GB an Kapazität und eine Speicherbandbreite von 19,6 TB/s kommen. In ähnliche Dimensionen wird NVIDIA mit der Rubin-Generation vorstoßen,... [mehr] -

TSMC 3DFabric und C-HBM4E: Advanced Packaging und (Custom) Base-Dies für HBM4(E)

Neben der Fertigung von Chips in den aktuellsten Herstellungsprozessen gehört das Advanced Packaging zu den Aushängeschildern von TSMC und ist für die allermeisten Chips auch unabdingbar. Entsprechend baut TSMC nicht nur die Kapazitäten seiner Fabs weitreichend aus, sondern auch die für das Advanced Packaging. Auf die Weiterentwicklungen in diesem Bereich kommen wir später. Im Rahmen des Advanced Packaging und der Integration von HBM4 wird den... [mehr]

Neben der Fertigung von Chips in den aktuellsten Herstellungsprozessen gehört das Advanced Packaging zu den Aushängeschildern von TSMC und ist für die allermeisten Chips auch unabdingbar. Entsprechend baut TSMC nicht nur die Kapazitäten seiner Fabs weitreichend aus, sondern auch die für das Advanced Packaging. Auf die Weiterentwicklungen in diesem Bereich kommen wir später. Im Rahmen des Advanced Packaging und der Integration von HBM4 wird den... [mehr] -

Advanced Silicon, Stacking und Packaging: TSMC baut weiter auf drei Säulen

Auf dem Open Innovation Platform Ecosystem Forum hat TSMC weite Teile seiner Pläne in den verschiedenen Bereichen wiederholt bzw. detaillierter ausgeführt. Natürlich kommt auch TSMC nicht daran vorbei, den aktuellen KI-Hype zu adressieren. Dabei sieht TSMC sowohl das Training, als auch das Inferencing von KI-Modellen gleichermaßen als wichtig an – entsprechend der Verteilung an Chips, welche von den Kunden bei TSMC in Auftrag... [mehr]

Auf dem Open Innovation Platform Ecosystem Forum hat TSMC weite Teile seiner Pläne in den verschiedenen Bereichen wiederholt bzw. detaillierter ausgeführt. Natürlich kommt auch TSMC nicht daran vorbei, den aktuellen KI-Hype zu adressieren. Dabei sieht TSMC sowohl das Training, als auch das Inferencing von KI-Modellen gleichermaßen als wichtig an – entsprechend der Verteilung an Chips, welche von den Kunden bei TSMC in Auftrag... [mehr] -

300 und noch einmal 410 Milliarden US-Dollar: Samsung und SK Hynix investieren kräftig in Speicherfertigung

Während man in Europa bereits glücklich darüber ist, wenn Halbleiterunternehmen Inventionen in Milliardenhöhe tätigen, man in den USA inzwischen in mehreren Phasen immerhin ein paar Dutzend Milliarden US-Dollar je Chipfabrik vorsieht, ist man im asiatischen Raum in ganz anderen Dimensionen angekommen. Im südkoreanischen Yongin soll ein Semiconductor-Cluster entstehen, an dem unter anderem Samsung und SK Hynix beteiligt sind. Alleine SK Hynix... [mehr]

Während man in Europa bereits glücklich darüber ist, wenn Halbleiterunternehmen Inventionen in Milliardenhöhe tätigen, man in den USA inzwischen in mehreren Phasen immerhin ein paar Dutzend Milliarden US-Dollar je Chipfabrik vorsieht, ist man im asiatischen Raum in ganz anderen Dimensionen angekommen. Im südkoreanischen Yongin soll ein Semiconductor-Cluster entstehen, an dem unter anderem Samsung und SK Hynix beteiligt sind. Alleine SK Hynix... [mehr] -

TGP- und HBM-Stellschrauben: AMD und NVIDIA spielen bei KI-Beschleunigern Katz und Maus

Aktuell scheint NVIDIA mit der Blackwell-Ultra-Generation die Nase vor AMD und der Instinct-MI350-Serie zu haben. Doch AMD sitzt dem KI-Riesen NVIDIA offenbar im Nacken und so gab es bereits Anpassungen an der Auslegung der zukünftigen Generationen der KI-Beschleuniger. Laut SemiAnalysis soll AMD die TGP des Instinct MI450X von 2.300 W auf 2.500 W angehoben haben. NVIDIA hat angeblich bereits vor zwei Monaten die TGP des... [mehr]

Aktuell scheint NVIDIA mit der Blackwell-Ultra-Generation die Nase vor AMD und der Instinct-MI350-Serie zu haben. Doch AMD sitzt dem KI-Riesen NVIDIA offenbar im Nacken und so gab es bereits Anpassungen an der Auslegung der zukünftigen Generationen der KI-Beschleuniger. Laut SemiAnalysis soll AMD die TGP des Instinct MI450X von 2.300 W auf 2.500 W angehoben haben. NVIDIA hat angeblich bereits vor zwei Monaten die TGP des... [mehr] -

HBM4 von Micron: 11 GBit/s werden erreicht und TSMC fertigt den Base-Die

Nachdem SK Hynix bereits in der vergangenen Woche die Massenproduktion von HBM4 mit 10 GBit/s und mehr angekündigt hat und damit die Anforderungen von NVIDIA erfüllt, zog nun auch Micron nach. Im Rahmen der Bekanntgabe der Zahlen für das dritte Quartal 2025 widersprach der Speicherspezialist den Gerüchten der vergangenen Tage, der HBM4 von Micron könnte die geforderte Datenraten nicht erreichen. Laut Hersteller hat man allerdings bereits... [mehr]

Nachdem SK Hynix bereits in der vergangenen Woche die Massenproduktion von HBM4 mit 10 GBit/s und mehr angekündigt hat und damit die Anforderungen von NVIDIA erfüllt, zog nun auch Micron nach. Im Rahmen der Bekanntgabe der Zahlen für das dritte Quartal 2025 widersprach der Speicherspezialist den Gerüchten der vergangenen Tage, der HBM4 von Micron könnte die geforderte Datenraten nicht erreichen. Laut Hersteller hat man allerdings bereits... [mehr] -

HBM4 von Sk Hynix: Massenfertigung mit 10 GBit/s und mehr kann beginnen

In den vergangenen Tagen verdichteten sich die Hinweise darauf, dass für die Herstellung von HBM4 seitens NVIDIA höhere Datendurchsatzraten der Chips eingefordert würden. Der KI-Riese hat es dabei mit solchen Forderungen recht leicht, denn vom Boom am KI-Markt wollen auch die HBM-Hersteller profitieren und versuchen sich daher auch den Anforderungen anzupassen. Micron, Samsung und Sk Hynix kämpfen hier um die Marktanteile, zuletzt konnte... [mehr]

In den vergangenen Tagen verdichteten sich die Hinweise darauf, dass für die Herstellung von HBM4 seitens NVIDIA höhere Datendurchsatzraten der Chips eingefordert würden. Der KI-Riese hat es dabei mit solchen Forderungen recht leicht, denn vom Boom am KI-Markt wollen auch die HBM-Hersteller profitieren und versuchen sich daher auch den Anforderungen anzupassen. Micron, Samsung und Sk Hynix kämpfen hier um die Marktanteile, zuletzt konnte... [mehr] -

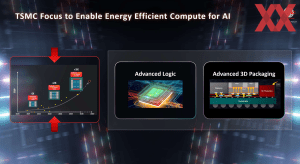

Intel und Sk Hynix: MRDIMM Gen 2 für Diamond Rapids und HBM4 für Jaguar Shores

Auf dem AI Summit von Intel in Seoul hat das Unternehmen zusammen mit einigen seiner Partner über zukünftige Produkte gesprochen. Einer der Partner auf der Bühne war SK Hynix, der neben DRAM auch HBM anbietet – neben Samsung und Micron ist man einer von drei Herstellern für diesen Speichertyp. So wird Intel für Jaguar Shores, dem ursprünglich nach Falcon Shores erwarteten KI-Beschleuniger, HBM4 von SK Hynix zum Einsatz bringen... [mehr].

Auf dem AI Summit von Intel in Seoul hat das Unternehmen zusammen mit einigen seiner Partner über zukünftige Produkte gesprochen. Einer der Partner auf der Bühne war SK Hynix, der neben DRAM auch HBM anbietet – neben Samsung und Micron ist man einer von drei Herstellern für diesen Speichertyp. So wird Intel für Jaguar Shores, dem ursprünglich nach Falcon Shores erwarteten KI-Beschleuniger, HBM4 von SK Hynix zum Einsatz bringen... [mehr]. -

HBM- und KI-Chip-Projektion: Bis zu 15 kW und gigantische HBM-Kapazitäten

Die Universität KAIST (Korea Advanced Institute of Science and Technology) in Südkorea, beziehungsweise das dazugehörige Terala (Terabyte Interconnection and Package Laboratory) hat einen aufsehenerregenden Workshop veranstaltet (PDF bei Google Drive), in dessen Rahmen eine HBM-Roadmap oder besser eine Projektion dessen, was in den kommenden Jahren zu erwarten ist, präsentiert wurde. Die hier genannten Zahlen für Bandbreiten, Kapazitäten,... [mehr]

Die Universität KAIST (Korea Advanced Institute of Science and Technology) in Südkorea, beziehungsweise das dazugehörige Terala (Terabyte Interconnection and Package Laboratory) hat einen aufsehenerregenden Workshop veranstaltet (PDF bei Google Drive), in dessen Rahmen eine HBM-Roadmap oder besser eine Projektion dessen, was in den kommenden Jahren zu erwarten ist, präsentiert wurde. Die hier genannten Zahlen für Bandbreiten, Kapazitäten,... [mehr] -

Advancing AI 2025: AMD nennt erste Details zum Instinct-MI400-Beschleuniger

Neben der Vorstellung der Instinct-MI350-Familie auf Basis der CDNA-4-Architektur gab AMD auf den "Advancing AI 2025"-Event einen Ausblick auf das, was danach kommen soll. Dabei hält AMD an der Kadenz von etwa zwölf Monaten für immer neue Instinct-Generationen fest, denn schon 2026 sollen die Instinct-MI400-Beschleuniger auf den Markt kommen. Bisher kann AMD seine Beschleuniger nur in Gruppen von bis zu acht GPUs über Infinity Fabric... [mehr]

Neben der Vorstellung der Instinct-MI350-Familie auf Basis der CDNA-4-Architektur gab AMD auf den "Advancing AI 2025"-Event einen Ausblick auf das, was danach kommen soll. Dabei hält AMD an der Kadenz von etwa zwölf Monaten für immer neue Instinct-Generationen fest, denn schon 2026 sollen die Instinct-MI400-Beschleuniger auf den Markt kommen. Bisher kann AMD seine Beschleuniger nur in Gruppen von bis zu acht GPUs über Infinity Fabric... [mehr] -

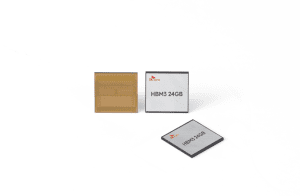

36 GB 12-High: Micron liefert ersten HBM4 aus

Micron hat verkündet, dass man den ersten HBM4 mit 12 DRAM-Stacks und (12-High) und einer Kapazität von 36 GB pro Chip fertigen wird. Erste Samples sollen nun an Kunden ausgeliefert werden. Die wahrscheinlichsten Vertreter sind hier sicherlich NVIDIA und AMD. Die Rubin-GPU wird bei NVIDIA ab der zweiten Jahreshälfte 2026 auf HBM4 setzen. AMD wird vermutlich erst mit der Instinct-MI400-Serie auf HBM4 setzen. Dazu werden wir womöglich in wenigen... [mehr]

Micron hat verkündet, dass man den ersten HBM4 mit 12 DRAM-Stacks und (12-High) und einer Kapazität von 36 GB pro Chip fertigen wird. Erste Samples sollen nun an Kunden ausgeliefert werden. Die wahrscheinlichsten Vertreter sind hier sicherlich NVIDIA und AMD. Die Rubin-GPU wird bei NVIDIA ab der zweiten Jahreshälfte 2026 auf HBM4 setzen. AMD wird vermutlich erst mit der Instinct-MI400-Serie auf HBM4 setzen. Dazu werden wir womöglich in wenigen... [mehr] -

ECTC 2025: Intel stellt EMIB-T für HBM4 erneut ins Schaufenster

Zur Intel Foundry Direct Connect 2025 präsentierte Intel mit EMIB-T eine Erweiterung seines EMIB-Packaging, die sich den Schachstellen der integrierten Silicon-Bridge annehmen soll und somit auch für externe Kunden interessant werden soll. Auf der Electronic Components Technology Conference (ECTC) wiederholte Intel viele der schon auf der Hausmesse genannten Punkte. Die Kollegen von Toms Hardware waren auf der ECTC und bieten die dazugehörigen... [mehr]

Zur Intel Foundry Direct Connect 2025 präsentierte Intel mit EMIB-T eine Erweiterung seines EMIB-Packaging, die sich den Schachstellen der integrierten Silicon-Bridge annehmen soll und somit auch für externe Kunden interessant werden soll. Auf der Electronic Components Technology Conference (ECTC) wiederholte Intel viele der schon auf der Hausmesse genannten Punkte. Die Kollegen von Toms Hardware waren auf der ECTC und bieten die dazugehörigen... [mehr] -

12-Layer HBM4: SK Hynix liefert die ersten Samples aus

Aktuell stürzt sich der Markt auf alles an HBM3(E)-Chips, was von den Herstellern ausgeliefert werden kann. Zusammen mit dem Packaging ist dies einer der größten Flaschenhälse in der Chipfertigung aktuell. Vor allem NVIDIA ist einer der größten Kunden – sowohl in der Fertigung als auch der Verarbeitung der Chips – sprich dem Packaging. SK Hynix hat nun angekündigt, dass man die ersten Samples eines HBM4 mit zwölf Layern an seine Kunden... [mehr]

Aktuell stürzt sich der Markt auf alles an HBM3(E)-Chips, was von den Herstellern ausgeliefert werden kann. Zusammen mit dem Packaging ist dies einer der größten Flaschenhälse in der Chipfertigung aktuell. Vor allem NVIDIA ist einer der größten Kunden – sowohl in der Fertigung als auch der Verarbeitung der Chips – sprich dem Packaging. SK Hynix hat nun angekündigt, dass man die ersten Samples eines HBM4 mit zwölf Layern an seine Kunden... [mehr] -

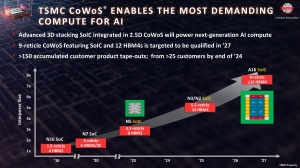

Interposer mit 12x HBM4: TSMC CoWoS soll ab 2027 riesige Packages ermöglichen

Auf dem Open Innovation Platform (OIP) Forum sprach TSMC über seine zukünftigen Pläne hinsichtlich des Packaging, genauer dem Chip-on-Wafer-on-Substrate (CoWoS) und definierte dabei die bisherigen Ziele zur Größe des verwendeten Interposer etwas genauer. Aktuell wird das CoWoS-Packaging im Bereich des dreifachen, des sogenannten Reticle-Limits limitiert, also der maximalen Größe, in der ein monolithischer Chips gefertigt werden kann. In... [mehr]

Auf dem Open Innovation Platform (OIP) Forum sprach TSMC über seine zukünftigen Pläne hinsichtlich des Packaging, genauer dem Chip-on-Wafer-on-Substrate (CoWoS) und definierte dabei die bisherigen Ziele zur Größe des verwendeten Interposer etwas genauer. Aktuell wird das CoWoS-Packaging im Bereich des dreifachen, des sogenannten Reticle-Limits limitiert, also der maximalen Größe, in der ein monolithischer Chips gefertigt werden kann. In... [mehr] -

NVIDIAs Roadmap: NVIDIA präsentiert Blackwell Ultra, Rubin und Rubin Ultra

Auf der Keynote auf der Computex in Taipei gab NVIDIA einen Ausblick auf die zukünftige Datancenter-Roadmap. Die in diesem Jahr vorgestellte Blackwell-GPU mit Blackwell-Architektur wird um Blackwell Ultra ergänzt. Dabei handelt es sich vermutlich um den B200-Beschleuniger mit Blackwell-GPU, aber HBM3e mit 12 Stacks anstatt acht Stacks, wie es im ersten Schritt geplant ist. Damit steigt der Speicherbaus von 192 auf 244 GB an. Die... [mehr]

Auf der Keynote auf der Computex in Taipei gab NVIDIA einen Ausblick auf die zukünftige Datancenter-Roadmap. Die in diesem Jahr vorgestellte Blackwell-GPU mit Blackwell-Architektur wird um Blackwell Ultra ergänzt. Dabei handelt es sich vermutlich um den B200-Beschleuniger mit Blackwell-GPU, aber HBM3e mit 12 Stacks anstatt acht Stacks, wie es im ersten Schritt geplant ist. Damit steigt der Speicherbaus von 192 auf 244 GB an. Die... [mehr] -

HBM4: SK hynix und TSMC vereinbaren Zusammenarbeit

Der Speicherhersteller SK hynix und TSMC haben eine engere Zusammenarbeit in der Entwicklung von HBM4 sowie für zukünftige Packaging-Technologien verkündet. SK hynix plant die Entwicklung von HBM4, der dann sechsten Generation der HBM-Familie, ab 2026 in Serie zu produzieren. Dem südkoreanischen Hersteller geht es vor allem darum, in der Zusammenarbeit zwischen Produktdesign, der Fertigung und dem eigenen Interesse... [mehr]

Der Speicherhersteller SK hynix und TSMC haben eine engere Zusammenarbeit in der Entwicklung von HBM4 sowie für zukünftige Packaging-Technologien verkündet. SK hynix plant die Entwicklung von HBM4, der dann sechsten Generation der HBM-Familie, ab 2026 in Serie zu produzieren. Dem südkoreanischen Hersteller geht es vor allem darum, in der Zusammenarbeit zwischen Produktdesign, der Fertigung und dem eigenen Interesse... [mehr] -

2 TB/s über breiteres Speicherinterface: Samsung will HBM4 schon 2025 einführen

Auch wenn HBM (High Bandwidth Memory) bei Endkundenhardware kaum mehr eine Rolle spielt, so ist dieser schnelle Speichertyp aus dem Datacenter und hier der Beschleunigerhardware kaum mehr wegzudenken. Entsprechend schritt die Entwicklung in den vergangenen 24 Monaten schnell voran. Nachdem die ersten Beschleuniger mit HBM3 in diesem Jahr ausgeliefert wurden und werden sollen, soll im kommenden Jahr bereits HBM3E zum Einsatz kommen. In der unten... [mehr]

Auch wenn HBM (High Bandwidth Memory) bei Endkundenhardware kaum mehr eine Rolle spielt, so ist dieser schnelle Speichertyp aus dem Datacenter und hier der Beschleunigerhardware kaum mehr wegzudenken. Entsprechend schritt die Entwicklung in den vergangenen 24 Monaten schnell voran. Nachdem die ersten Beschleuniger mit HBM3 in diesem Jahr ausgeliefert wurden und werden sollen, soll im kommenden Jahr bereits HBM3E zum Einsatz kommen. In der unten... [mehr] -

HBM4 von Sk hynix: 2026 soll es mit 32 GB losgehen

Aktuell werden die ersten AI-Beschleuniger mit HBM3 bestückt. Dazu gehören NVIDIAs H100, aber auch der Radeon Instinct MI300A und MI300X von AMD. Lieferanten des schnellen Speichers sind Samsung und Sk hynix – beides in Südkorea ansässige Unternehmen. Laut BusinessKorea hat Sk hynix auf einem Investoren-Event seine Bestrebungen bestätigt, diesen Speicherbereich in diesem und dem kommenden Jahr weiter auszubauen. Zwar macht der HBM... [mehr]

Aktuell werden die ersten AI-Beschleuniger mit HBM3 bestückt. Dazu gehören NVIDIAs H100, aber auch der Radeon Instinct MI300A und MI300X von AMD. Lieferanten des schnellen Speichers sind Samsung und Sk hynix – beides in Südkorea ansässige Unternehmen. Laut BusinessKorea hat Sk hynix auf einem Investoren-Event seine Bestrebungen bestätigt, diesen Speicherbereich in diesem und dem kommenden Jahr weiter auszubauen. Zwar macht der HBM... [mehr]