Werbung

Bereits häufiger haben wir über die Benchmarks und Ranglisten der MLCommons berichtet, da man hier einen unabhängigen Benchmark in unterschiedlichen Kategorien aufbauen wollte, der praxisrelevante Daten zu den AI/ML-Beschleunigern der verschiedenen Hersteller liefert.

Heute nun wurden die Daten zum Training in der Version 1.1 veröffentlicht. Daneben gibt es noch die Kategorien HPC, wo erst vor wenigen Wochen aktualisierte Daten veröffentlicht wurden und die Inference-Resultate. Grundsätzliche ist es eine gute Idee, eine möglichst unabhängige Instanz zu etablieren, die Leistungsdaten zu solchen Spezialbeschleuniger erhebt. Dies ist es auch unabhängig davon zu sehen, dass die Hersteller ihre Ergebnisse selbst einreichen, denn diese können von der Konkurrenz geprüft werden. Einige Vorgaben der MLCommons sollen aber dennoch verhindern, dass es hier zu Optimierungen kommt, die einen direkten Vergleich nicht mehr möglich machen.

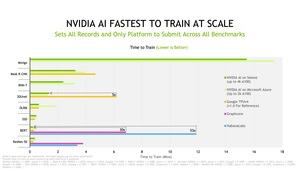

Mit den Werte zu MLPerf Training v1.1 müssen wir die Entwicklung bei MLCommons jedoch kritischer sehen, denn nachdem es hier zu immer mehr Einreichungen und einer immer besseren Vergleichbarkeit kam, ist nun ein gegenteiliger Trend zu beobachten. Im Grund spielen für die Trainingsdaten nur noch NVIDIA, Graphcore und Habana Labs (Intel) eine Rolle, die weitaus meisten Daten aber reicht NVIDIA ein. Google hatte noch Daten für die Version 1.0 eingereicht, verzichtet jetzt allerdings auf eine weitere Teilnahme (zumindest für die Open Section). Ob man zurückkehren wird, bleibt abzuwarten. Immerhin haben Azure und HPE erstmals neue Ergebnisse eingereicht.

Mit der Dominanz durch NVIDIA und den geringeren Einreichungen von Daten wird der Vergleich der Hardware untereinander immer schwieriger. Ohnehin muss man sehr genau hinschauen, denn die Einzelergebnisse werden natürlich von jedem Hersteller anders interpretiert. So wurden hier schon für einen Vergleich Daten aus der "Closed Section" (vorgeschriebene Verarbeitung der Daten) und "Open Section" (der Hersteller kann hier frei optimieren) genommen – diese Datensätze sollte man in dieser Form jedoch nicht untereinander vergleichen.

Die Ergebnisse für das MLPerf Training v1.1 können ab sofort abgerufen werden.

Konkrete Ergebnisse

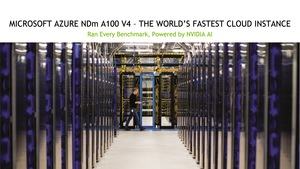

Ein paar Sätze wollen wir dazu aber noch sagen. 19 der eingereichten Ergebnisse wurden von Microsoft Azure erstellt, NVIDIA liefert 20 Ergebnisse. Dell kommt auf derer zwölf, Inspur auf sieben, Lenovo auf drei, Baudi, Fujitsu, HPE und Supermicro kommen auf jeweils zwei. Allesamt verwenden diese A100-GPU-Beschleuniger von NVIDIA.

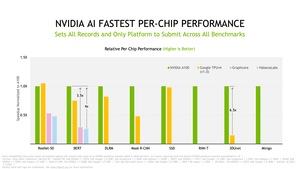

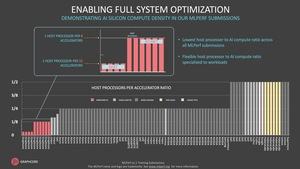

Habana Labs liefert sechs Ergebnisse mit den Gaudi-Beschleunigern und Graphcore sieben mit der Graphcore IPU GC200. Diese zusammengenommen 13 Ergebnisse treten gegen 69 andere an, die allesamt besagte A100-GPU-Beschleuniger von NVIDIA verwenden. Einerseits demonstriert dies die Dominanz, die NVIDIA in diesem Segment aufgebaut hat, andererseits wäre ein ausgewogeneres Verhältnis der Einreichungen wünschenswert.

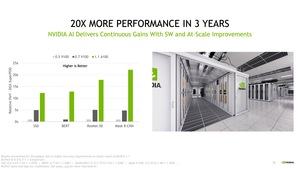

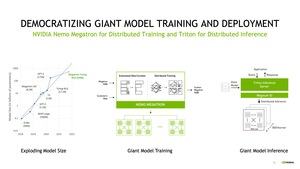

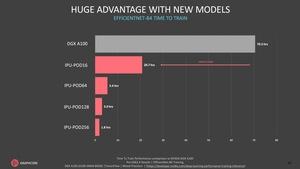

Auf ein paar Punkte wollen wir hier ebenfalls eingehen: NVIDIA liefert Ergebnisse des eigenen Supercomputers Selene mit bis zu 1.080 AMD EPYC 7742 und 4.320 A100 Tensor GPUs. Microsoft bietet bis zu 512 EPYC 7V12 und 2.048 A100 Tensor GPUs auf. Für beide gilt: Durch die hohe Rechenleistung und Skalierung der Systeme können bestimmte Modelle schneller denn je trainiert werden. Dort, wo die Zeit bis zum nächsten trainierten Modell entscheidend ist, hat NVIDIA derzeit die Nase weit vor allen anderen. Wie teuer diese Systeme dann sind, steht auf einem anderen Blatt. NVIDIAs Megatron-Turing NLG (Natural Language Generation) verfügt über 530 Milliarden Parameter und benötigt mehrere Wochen pro Trainingsdurchlauf. Diese Zeiten zu verkürzen, ist natürlich ein Ansporn, die Hardware-Systeme immer größer zu machen.

Ein Selene-Supercomputer von NVIDIA besteht grob gesagt aus 540 DGX A100, die jeweils 300.000 US-Dollar kosten. Alleine die Server kommen also schon auf rund 160 Millionen US-Dollar an Anschaffungskosten – ohne die Infrastruktur für den Aufbau eines solchen Systems mit einzubeziehen.

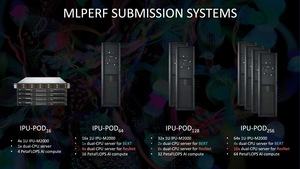

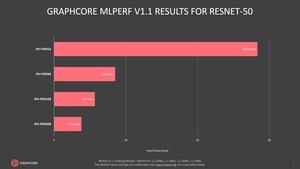

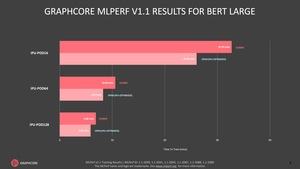

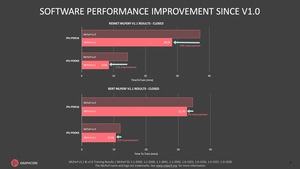

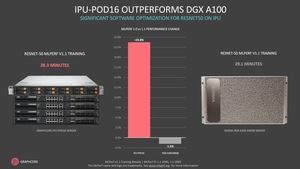

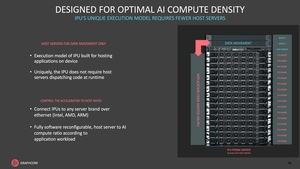

Hersteller wie Graphcore wollen eine Alternative sein. Die Systemkosten sind nur etwa halb so groß. Ein IPU-Pad mit 16 Beschleunigern kostet etwa 150.000 US-Dollar. Dafür aber kann man in der Leistung nicht immer ganz mithalten, obwohl man in der letzten Runde durch einige Optimierungen auf durchaus beachtliche Ergebnisse kommt.

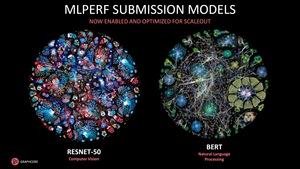

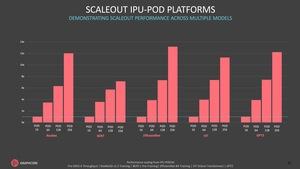

Graphcore liefert in der aktuellen Runde Ergebnisse für IPU-Pods mit 128 und 256 der IPUs – bisher waren die Systeme mit maximal 64 dieser Beschleuniger bestückt. Entsprechend legt Graphcore den Fokus auf die Skalierung seiner Systeme und kommt auf vergleichbar gute Ergebnisse. Schlussendlich interpretiert Graphcore die Ergebnisse für sich als klaren Gewinn im Hinblick auf das Preis-Leistungs-Verhältnis. NVIDIA hält dagegen und sagt "Time to train", also die Zeit wie lange ein solches System rechnet, sei wichtiger und für die Kosten entscheidend.

Am Ende stellt sich einmal mehr die Frage, inwieweit sich die Daten in den Praxiseinsatz übertragen lassen. Außerdem ist offen, ob Firmen und Institute, die eine solche Hardware anschaffen wollen, mit diesen Daten etwas anfangen können, bzw. diese als Entscheidungsgrundlage verwenden. Die Daten der MLCommons sollte eine unabhängige Vergleichsbasis sein. Dazu muss jedoch eine größere Diversität in den Hardware-Konfigurationen gewährleistet sein.

Wir werden uns die kommenden Ergebnisse anschauen und dann entscheiden, ob es Sinn macht, die Daten weiter zu betrachten.