Werbung

In dieser Woche findet die Supercomputing 2021 statt und in dessen Rahmen wurde unter anderem die aktualisierte Liste der Top500-Supercomputer vorgestellt. Für diese wurde der Linpack-Benchmark verwendet, der einzig die FP64-Rechenleistung der Systeme einzuordnen vermag. Zugegebenermaßen ist dies für viele Anwendungen noch immer die wichtigste Kennzahl für die Rechenleistung eines Supercomputers.

In einem sechsmonatigen Rhythmus hat MLCommons die Version 1.0 der HPC-Resultate veröffentlicht. Im HPC-Bereich sind weniger die Hersteller selbst (eine Ausnahme bildet hier NVIDIA) die beitragenden Teilnehmer, als vielmehr die Betreiber der Supercomputer selbst. Zu diesen gehören das Argonne National Laboratory (ANL) in den USA, das Swiss National Supercomputing Centre (CSCS) mit dem Piz Daint, der JUWELS des Forschungszentrum Jülich, der Perlmutter des US-Energieministeriums, der HAL des National Center for Supercomputing Applications und der Frontera des Texas Advanced Computing Center - beide ebenfalls aus den USA. Etwas herausstellen wollen wir noch, dass der weiterhin schnellste Supercomputer, der Fugaku des RIKEN in Japan, Ergebnisse eingereicht hat, genau wie NVIDIA als Hersteller diverser Supercomputer-Hardware mit dem Selene-System.

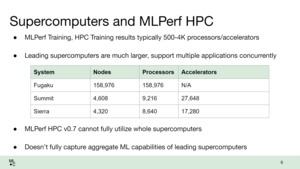

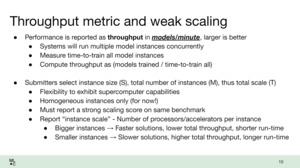

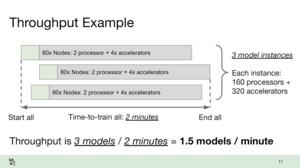

Eine gegenseitige Review-Schleife eröffnet jedem Teilnehmer die Möglichkeit, die Resultate des anderen zu prüfen. MLCommons überprüft die Resultate natürlich ebenfalls. AI- und ML-Benchmarks sind allerdings nicht ganz so einfach, wie der Start eines 3DMark-Durchlaufs oder dergleichen. Schon für unsere Serverbenchmarks ergibt sich in unseren Tests ein gehöriger Aufwand. Für die HPC-Benchmarks ist die Komplexität noch einmal deutlich höher. Daher wird in den Ergebnissen zwischen einer Einreichung in "Strong Scaling" und "Weak Scaling" unterschieden. Für das "Strong Scaling" liegt der Fokus auf der Skalierung der Benchmarks – wie viel besser werden die Ergebnisse, wenn die Anzahl der Prozessoren/GPU-Beschleuniger verdoppelt wird. Das "Weak Scaling" soll aufzeigen, in wie weit die kompletten Supercomputer verwendet werden können, um die Aufgaben zu lösen. Einen Supercomputer mit mehreren tausend Rechenknoten, GPU-Beschleunigern und Millionen von Rechenkernen auszulasten, ist alles andere als einfach.

Die Ergebnisse legen einmal mehr dar, dass es ein Zusammenspiel aus guter Hardware und einer optimierten Software sein muss, um gute Ergebnisse zu erreichen. Systeme mit doppelter Anzahl an Prozessoren/GPU-Beschleunigern müssen nicht auch doppelt so schnell sein. Dennoch aber ist es möglich die Leistung der Hardware zu unterscheiden - und das auf Basis von mehr als einem Linpack-Wert. So benötigt der Fugaku auf 512 seiner Fujitsu-Prozessoren etwa 114 Minuten im CosmoFlow-Benchmark. Der JUWELS kommt mit 512 EPYC-Prozessoren und 1.024 NVIDIA A100 aber auf nur auf rund 16 Minuten.

Imposant aber sind die "Weak Scaling"-Resultate. Hier wurden der Fugaku, JUWELS, Perlmutter und Selene vollständig ausgelastet. Zwischen den zwei hier verwendeten Benchmarks (CosmoFlow und DeepCAM) sind hier durchaus signifikante Unterschiede zu erkennen. Während der Fugaku in CosmoFlow die Nase deutlich vorne hat und doppelt so viele Modelle pro Minute berechnen kann, zeigt NVIDIA in der Optimierung für Selene besonders starke DeepCAM-Resultate.

| CPUs/GPUs | CosmoFlow (Models/Minute) | |

| Fugaku | 82.944x Fujitsu A64FX | 1,29 |

| Perlmutter | 1.280x AMD EPYC 7742 5.120x NVIDIA A100 | 0,68 |

| Selene | 1.024x AMD EPYC 7742 4.096x NVIDIA A100 | 0,73 |

Vor allem aber wird einmal mehr deutlich, dass es eben nicht nur eine Zahl ist, um die Rechenleistung eines Supercomputers zu beurteilen:

| CPUs/GPUs | CosmoFlow (Minuten) | DeepCAM (Minuten) | OpenCatalyst (Minuten) | |

| NVIDIA Selene | 32x AMD EPYC 7742 128x NVIDIA A100 | 8,04 | ||

| 128x AMD EPYC 7742 512x NVIDIA A100 | 2,65 | |||

| 256x AMD EPYC 7742 1.024x NVIDIA A100 | 25,78 | |||

| 512 AMD EPYC 7742 2.048x NVIDIA A100 | 1,67 | |||

| Fugaku | 512x Fujitsu A64FX | 114,35 | ||

| Frontera | 64x IBM Power9 128 NVIDIA V100 | 140,45 | ||

| Theta | 32x AMD EPYC 7742 128x NVIDIA A100 | 256,27 | ||

| Piz Diant | 32x AMD EPYC 7742 64x NVIDIA A100 | 753,11 | ||

| HAL | 64x IBM Power9 128 NVIDIA V100 | 1021,8 | ||

| Perlmutter | 128x AMD EPYC 7742 512x NVIDIA A100 | 111,86 |

Für das "Weak Scaling" gilt: Je weniger Zeit benötigt wurde, desto schneller das System oder besser: Desto besser konnten Hard- und Software zusammenarbeiten. Die kompletten MLPerf-1.0-Resultate können ab sofort hier abgerufen werden und beinhalten noch weitere Datensätze.

Auch wenn sich also vieles auf die Top500-Liste konzentriert, so sollten für eine Gesamtbeurteilung der Leistung der Systeme mehrere Faktoren mit in Betracht gezogen werden. MLPerf bietet eben diese weitere Betrachtungsebene – zusätzlich zum Linpack und HPCG-Benchmark.