Werbung

Neben dem Trainium3, der spezifisch auf das Training und Inferencing großer KI-Modelle ausgelegt ist, hat Amazon auf seiner re:Invite-Konferenz die nächste Generation seiner eigenen CPU vorgestellt. Für diese setzt man auf das Neoverse-V3-Design von ARM. Die insgesamt 192 Kerne haben einen L2-Cache von jeweils 2 MB. Zudem teilen sie sich 192 MB an L3-Cache. Das Speicherinterface unterstützt DDR5-7200 und Amazon plant seine Server für DDR8-8800 (vermutlich MRDIMM) zu validieren. Außerdem bietet der Graviton5 die Unterstützung von PCI-Express 6.0.

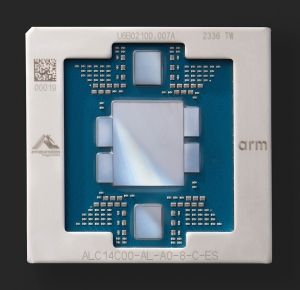

Gefertigt wird der Graviton5 laut Amazon bei TSMC in 3 nm. Unklar ist, ob sich Amazon auf den zentralen Compute-Chiplet bezieht und in welchem Verfahren die übrigen zwei Chiplets (zwei im Norden und Süden sowie jeweils zwei im Osten und Westen des Package) gefertigt werden und welche Funktion sie erfüllen. Anhand des Vorgängers lässt sich vermuten, dass die größeren Chiplets im Norden und Süden die I/O-Chips sind, während die kleineren im Osten und Westen vermutlich die externen Speichercontroller bereitstellen.

Mit dem Sprung von 96 auf 192 Kerne verdoppelt Amazon die pro Sockel zur Verfügung stehenden Kerne. Diese haben zudem einen wesentlich größeren L3-Cache zur Verfügung. Zusammen mit der höheren Speicherbandbreite ergibt sich daraus ein Leistungsplus von 25 % gegenüber dem Vorgänger – bei fast identischer Energieeffizienz.

EC2-M9g/C9g/R9g-Instanzen sollen laut Amazon je nach Anwendung sogar um 35 bis 60 % schneller sein – so zum Beispiel für SAP HANA und Persistency. Die EDA-Tools von Synopsys zeigen um 35 % verbesserte Laufzweiten.

Die M9g-Instanzen sind für General-Purpose-Workloads vorgesehen, währen die C9g-Instanzen auf eine hohe Rechenleistung ausgelegt sind. Speicherintensive Anwendungen sollten auf die R9g-Instanzen verlegt werden. Die M9g-Instanzen sind als Preview bereits verfügbar, während die C9g- und R9g-Instanzen ab 2026 zur Verfügung stehen sollen.