Werbung

Auf der Ignite-Konferenz hat Amazon mit dem Trainium3 die nächste Generation seiner eigenen KI-Hardware präsentiert. Vor genau zwei Jahren wurde mit dem Trainium2 der direkte Vorgänger vorgestellt, der dann in den entsprechenden Trn1-Instanzen auch den Kunden zur Verfügung gestellt wurde.

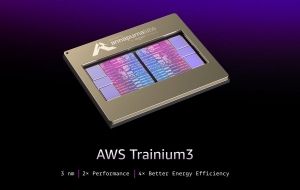

Der Trainium3 ist im Grunde schon die vierte Generation der Trainings-Hardware, die beim Amazon-Zukauf Annapurna Labs entwickelt wurden. Die Fertigung des Chips erfolgt bei TSMC in einem nicht näher bezeichneten 3-nm-Verfahren. Ausgestattet ist der Chip mit 144 GB an HBM3E mit einer Speicherbandbreite von 4,9 TB/s. Damit übertrumpft der Trainium3 seinen Vorgänger in beiden Metriken um mehr als 50 %. Für Berechnungen mit einer Genauigkeit von FP8 kommt der Trainium laut Amazon auf eine Rechenleistung von 2,52 PFLOPS. Zum Vergleich: AMDs Instinct MI355X kommt auf 10,1 PFLOPS, eine Blackwell-GPU bringt es auf 9 PFLOPS.

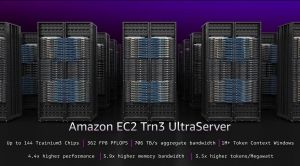

Google trainiert seine KI-Modelle auf den eigenen TPUs. Dem möchte Amazon offenbar in nichts nachstehen und legt den Trainium3 daher auch darauf aus, möglichst gut skalieren zu können. Vier Chips arbeiten in einem Server zusammen. In Form der EC2 Trn3 UltraServer fasst Amazon 144 Trainium3 zusammen und kommt damit auf eine Rechenleistung von 362 PFLOPS. Ein solches Rack von Amazon kommt auf 20,7 TB an HBM3E und eine aggregierte Speicherbandbreite von 706 TB/s. Auch hier ein Vergleich: Das GB300-NVL-System mit 72 Blackwell-GPUs kommt auf 720 PFLOPS.

Laut Amazon bieten die entsprechenden Instanzen eine um den Faktor 4,4 höhere Leistung sowie eine um den Faktor vier höhere Effizienz. Auch in den Metriken wie Tokens pro Megawatt und den Latenzen für ein Inferenzing sieht sich Amazon mit dem Trainium3 gut aufgestellt. Die Instanzen auf Basis des Trainium3 sollen in den kommenden Monaten zur Verfügung gestellt werden.

NVLink Fusion für zukünftige Systeme

Aber auch wenn Trainium3 ein Schritt in Richtung mehr Unabhängigkeit ist, so haben AWS und NVIDIA eine zukünftige Zusammenarbeit angekündigt. So wird AWS einen Custom-Prozessor entwickeln, der als Trainium4 dann per NVLink Fusion die Anbindung von NVIDIA-GPUs ermöglicht. AWS entwickelt Trainium4 für die Integration mit NVLink und NVIDIA MGX, der ersten Zusammenarbeit zwischen NVIDIA und AWS für NVLink Fusion.

Weitere Details zu NVLink Fusion, wo ein NVLink-Chiplet und wo ein NVLink-C2C-PHY eingebaut werden muss, findet ihr im Artikel zur Hot-Chips-Präsentation.