Werbung

AMD Ryzen Threadripper 2990WX und 2970WX können mit ihren 32 bzw. 24 Kernen eine beeindruckende Rohleistung bieten. Längst nicht jede Anwendung kann davon aber voll profitieren. Ein Grundproblem bleibt, dass je nach Anwendung mal der UMA- und mal der NUMA-Modus für mehr Performance sorgt. Ein neuer Dynamic Local Mode soll nun für mehr Komfort ein ein Leistungsplus sorgen.

Bereits erwähnt haben wir den Dynamic Local Mode mit der Ankündigung der Verfügbarkeit des Ryzen Threadripper 2920X und 2970WX mit 12 und 24 Kernen zum 29. Oktober. Nun wollen wir aber noch einmal genauer auf den neuen Software-Modus eingehen.

AMD hat diesen Modus selbst in einem ausführlichen Blogeintrag näher vorgestellt. Der Dynamic Local Mode ist eine Softwarelösung, die den anspruchsvollsten Anwendung automatisch die CPU-Kerne zuweist, die direkt an den Arbeitsspeicher angebunden sind. Genutzt werden kann dieser Modus aber ausschließlich auf Threadripper-Modellen mit vier Dies, also auf dem Ryzen Threadripper 2990WX und dem (erst Ende Oktober verfügbaren) Ryzen Threadripper 2970WX.

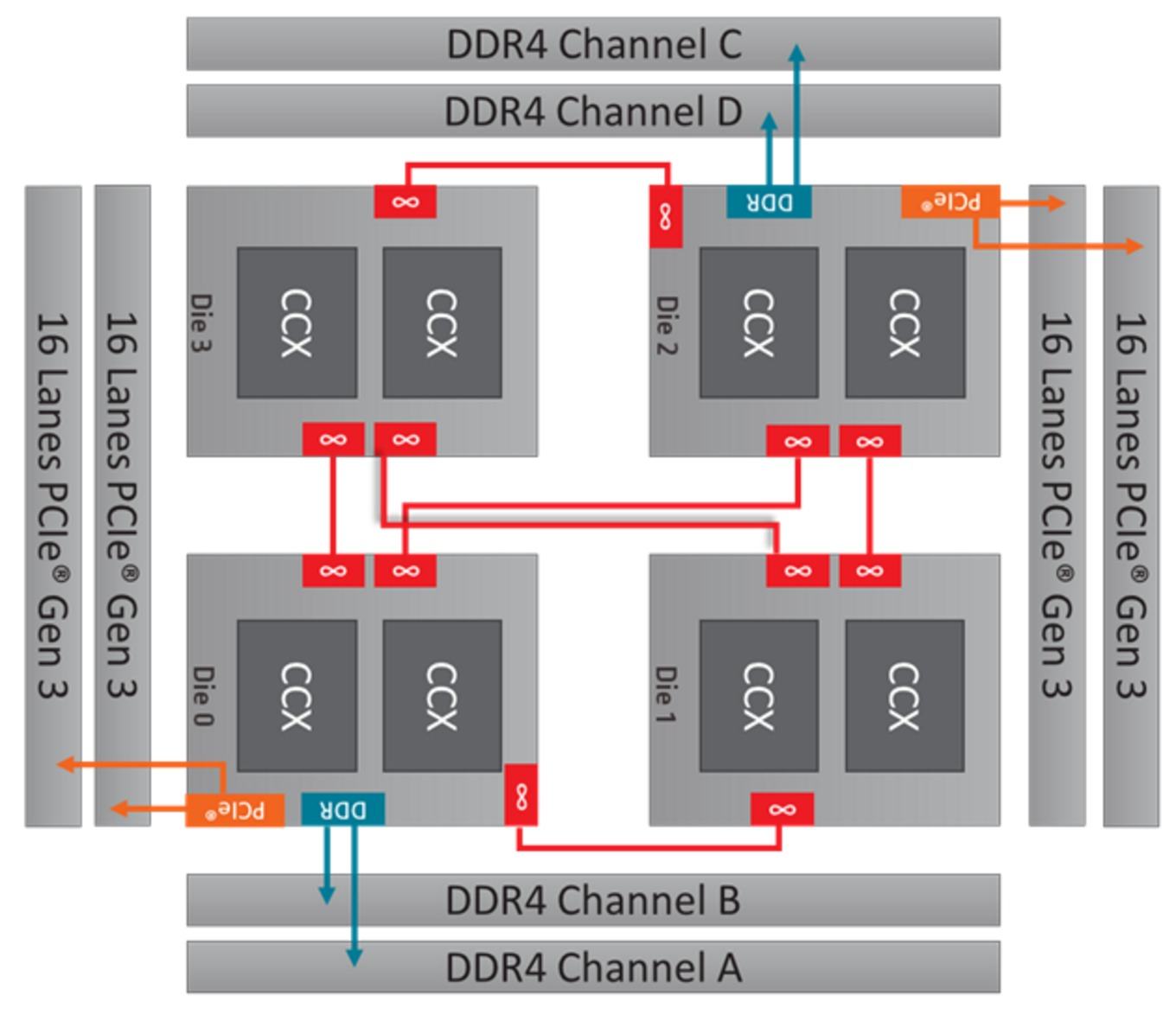

Wie sinnvoll eine solche Lösung sein kann, macht ein Blick auf den Aufbau dieser Prozessoren deutlich. Nur zwei der vier Dies haben eine direkte Anbindung zu den Speicherkanälen. Gerade bei latenzabhängigen Anwendung sinkt die Leistung, wenn sie nicht auf den Kernen mit direkter Speicheranbindung ausgeführt werden. Der NUMA-Modus (Non-Uniform Memory Access, auch Local Mode) weist zwar jedem Die einen festen Speicherbereich zu und senkt so die durchschnittlichen Latenzen, gleichzeitig sinkt aber auch die Speicherbandbreite gegenüber dem UMA-Modus (Uniform Memory Access, auch Distributed Mode). Welche Anwendung nun von welchem Modus mehr profitiert, muss der Nutzer selbst herausfinden. Bisher ist auch der Wechsel zwischen beiden Modi mit einem Neustart verbunden und wenig praktikabel.

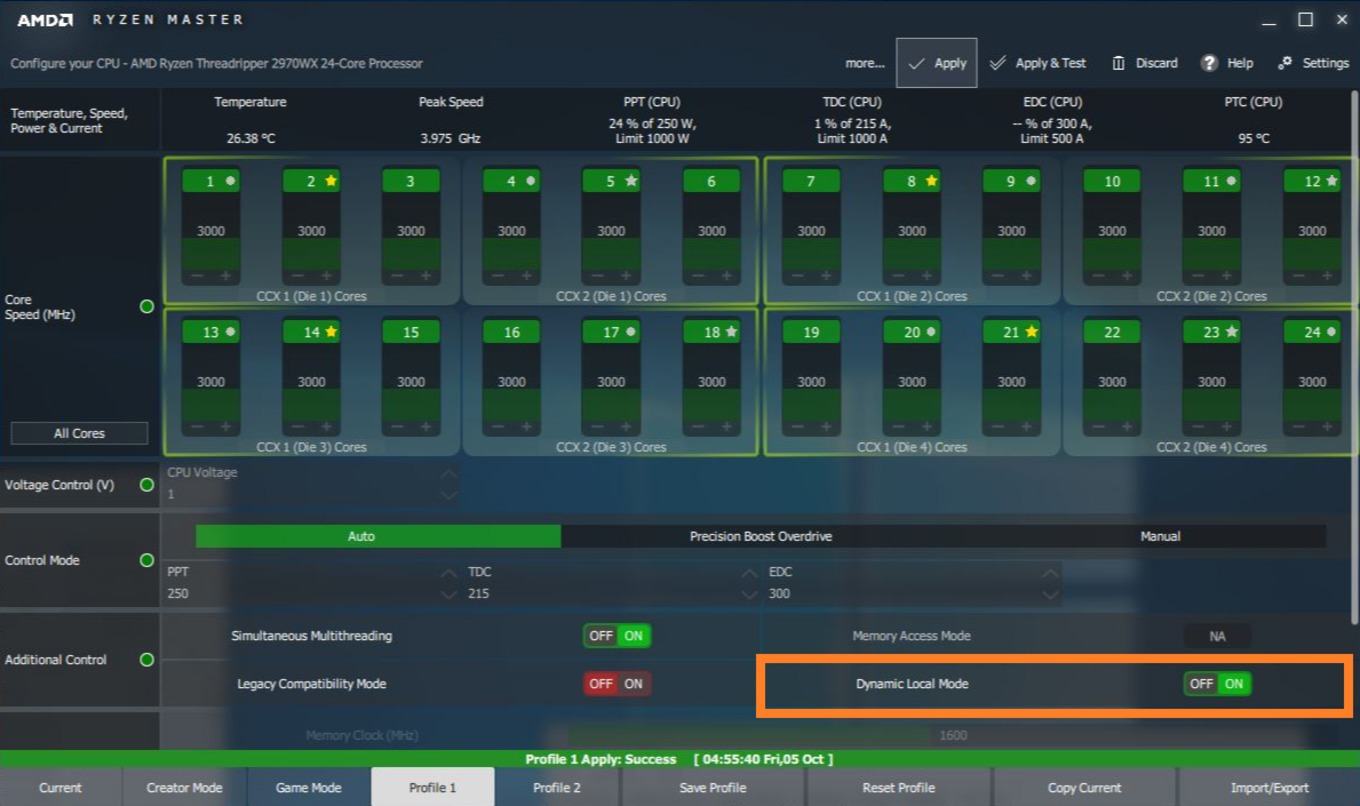

Weil AMD schon den NUMA-Modus als Local Mode bezeichnet, ist der neue Dynamic Local Mode praktisch eine neue und fortschrittlichere Spielart des NUMA-Betriebs. Der Wechsel wird damit im laufenden Betrieb möglich. Umgesetzt wird der Dynamic Local Mode durch einen Windows 10-Hintergrunddienst. Dieser Dienst misst, wieviel CPU-Zeit jeder Thread benötigt. Die Threads werden dementsprechend in eine Rangfolge eingeordnet. Anschließend werden den Dies mit direkter Speicheranbindung automatisch die am meisten fordernden Threads zugewiesen. Die Kontrolle und Zuweisung ist ein dauernder Prozess.

Um den Dynamic Local Mode zu stoppen, kann entweder der Dienst selbst gestoppt oder einfach über Ryzen Master deaktiviert werden. Verfügbar werden soll der neue Modus am 29. Oktober. Dann will AMD eine neue Version von Ryzen Master ausliefern, die auf Systemen mit Ryzen Threadripper 2990WX oder 2970WX automatisch den Dynamic Local Mode aktiviert. In Zukunft soll dieser Modus auch Teil des AMD Chipsatz-Treibers werden und auch ohne die Ryzen Master-Software genutzt werden können.

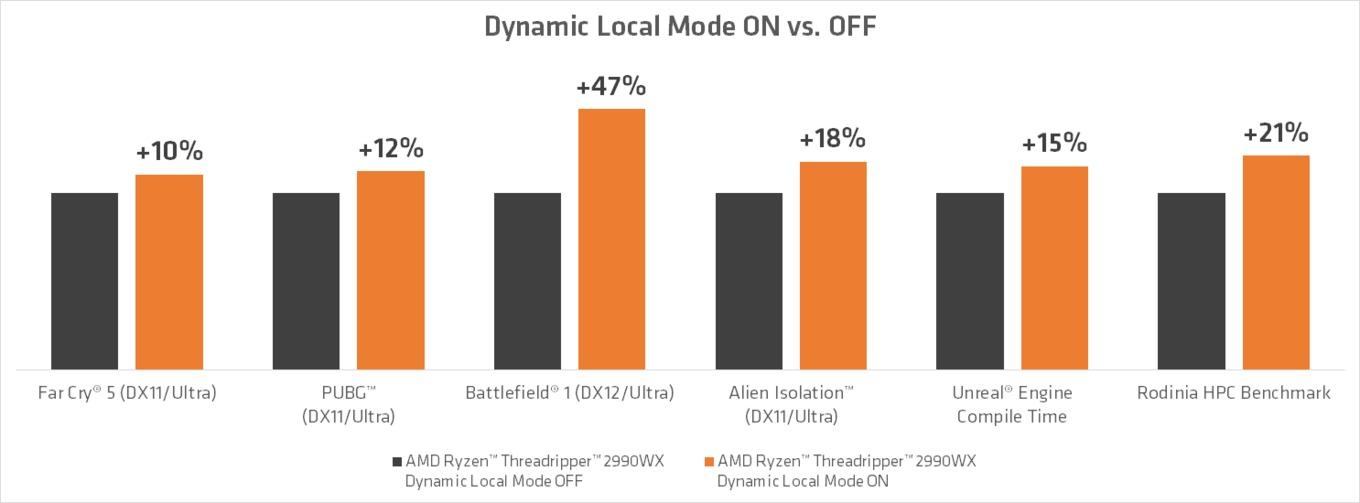

AMD hat selbst Tests durchgeführt, die dem Dynamic Local Mode einen teils deutlichen Performancezuwachs bescheinigen. Es wird zwar nicht ausdrücklich darauf hingewiesen, die Messungen dürften aber im Vergleich zum bisher werkseitig aktiven UMA-Modus durchgeführt worden sein. Die Anwendungen profitieren sehr unterschiedlich vom Dynamic Local Mode. In Battlefield 1 wird mit 47 Prozent der deutlichste Zuwachs erreicht (DirectX 12/Ultra, 136 FPS vs. 200 FPS). Bei den anderen einbezogenen Spielen/Benchmarks variiert der Zuwachs zwischen 10 und 21 Prozent. AMD weist auch darauf hin, dass nicht jede Anwendung vom neuen Modus profitieren wird.