Werbung

Wie auf der Pressekonferenz der Computex 2017 angekündigt hat AMD heute die neuen Serverprozessoren namens EPYC offiziell vorgestellt. Basierend auf der Zen-Architektur sollen sie AMD bei den Servern wieder Marktanteile bescheren. In diesem Bereich spielt AMD derzeit nahezu überhaupt keine Rolle mehr – stattdessen dominieren Intel und für einige Spezialanwendungen auch Hersteller wie IBM.

Bisher waren nur die wichtigsten technischen Daten bekannt. Der wohl stärkste EPYC-Prozessor verfügt über 32 Kerne, kann 64 Threads verbarbeiten und besitzt acht Speichercontroller. Die 2x 4-Channels können mit jeweils acht DIMMs entsprechend mit Speicher bestückt werden. In einem Dual-Socket-System stehen demzufolge 32 DIMMs zur Verfügung, die eine theoretische Bestückung von 4 TB an Speicher ermöglichen.

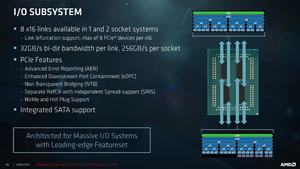

AMD möchte den Single- und Dual-Sockel-Markt aufmischen. 128 PCI-Express-3.0-Lanes stehen ebenfalls zur Verfügung. Die EPYC-Strategie zielt auf mehr Kerne, mehr Speicherbandbreite und eine größere Speicherbestückung ab. Dies gilt für Single- und Dual-Socket-Server.

12 neue Serverprozessoren vorgestellt

Zum heutigen offiziellen Start der EPYC-Serverprozessoren stellt AMD gleich zwölf Modelle vor. Neun davon richten sich an Dual-Docket-Server und damit den High-End-Bereich. Drei weitere sollen sich für Single-Socket-Server eignen und den Rest wird AMD Ende Juli offiziell vorstellen.

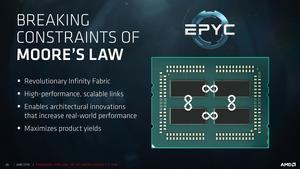

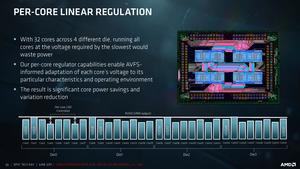

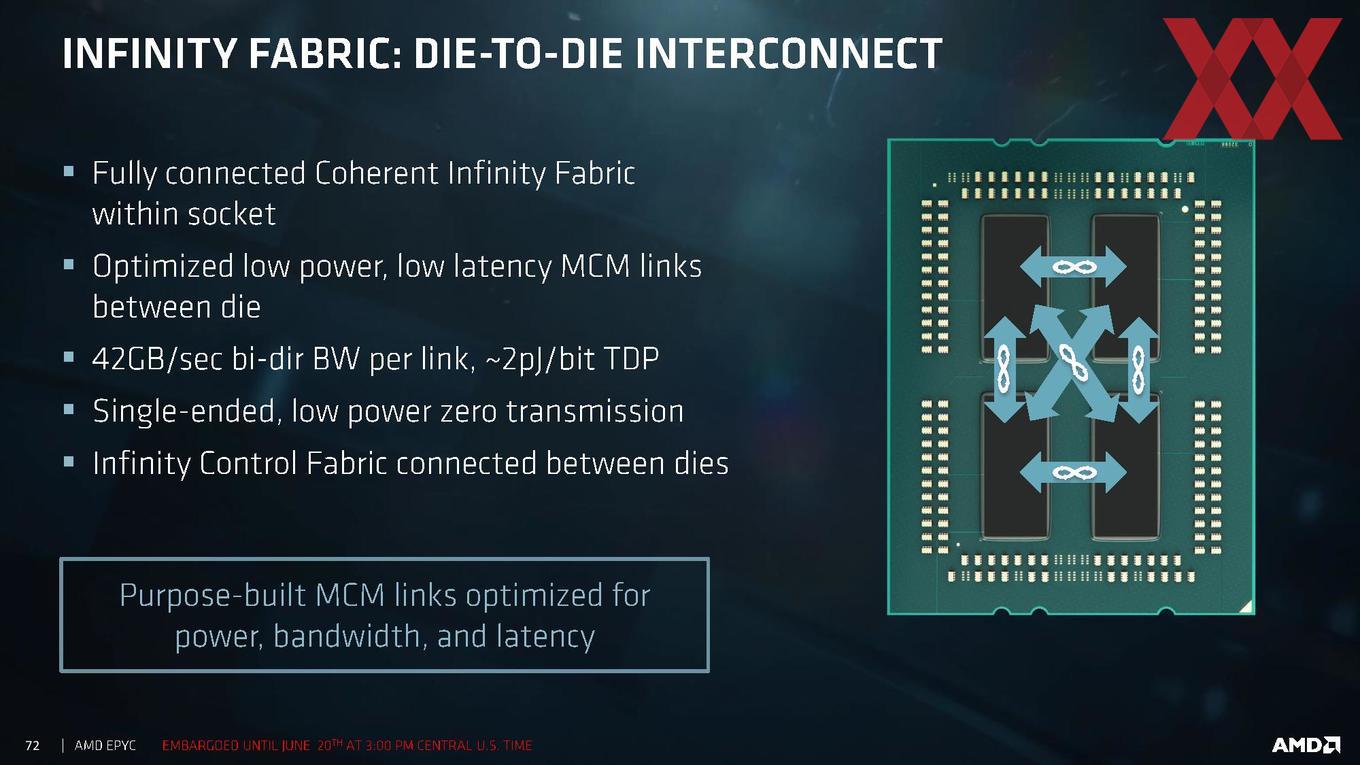

Allen Prozessoren gemein ist der grundsätzliche Aufbau. Sie bestehen aus vier Zeppelin-Chips, die wiederum in einem MCP (Multi Chip Package) zusammengefasst sind. Jeder der Zeppelin-Chips verfügt über acht Kerne und besteht aus zwei CPU Complexen. Miteinander verknüpft sind diese Prozessoren über den neuen Interconnect, der bei allen aktuellen AMD-Chips zum Einsatz kommt: Dem Infinity Fabric.

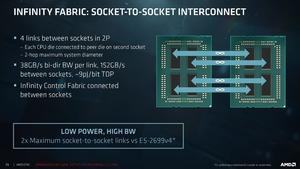

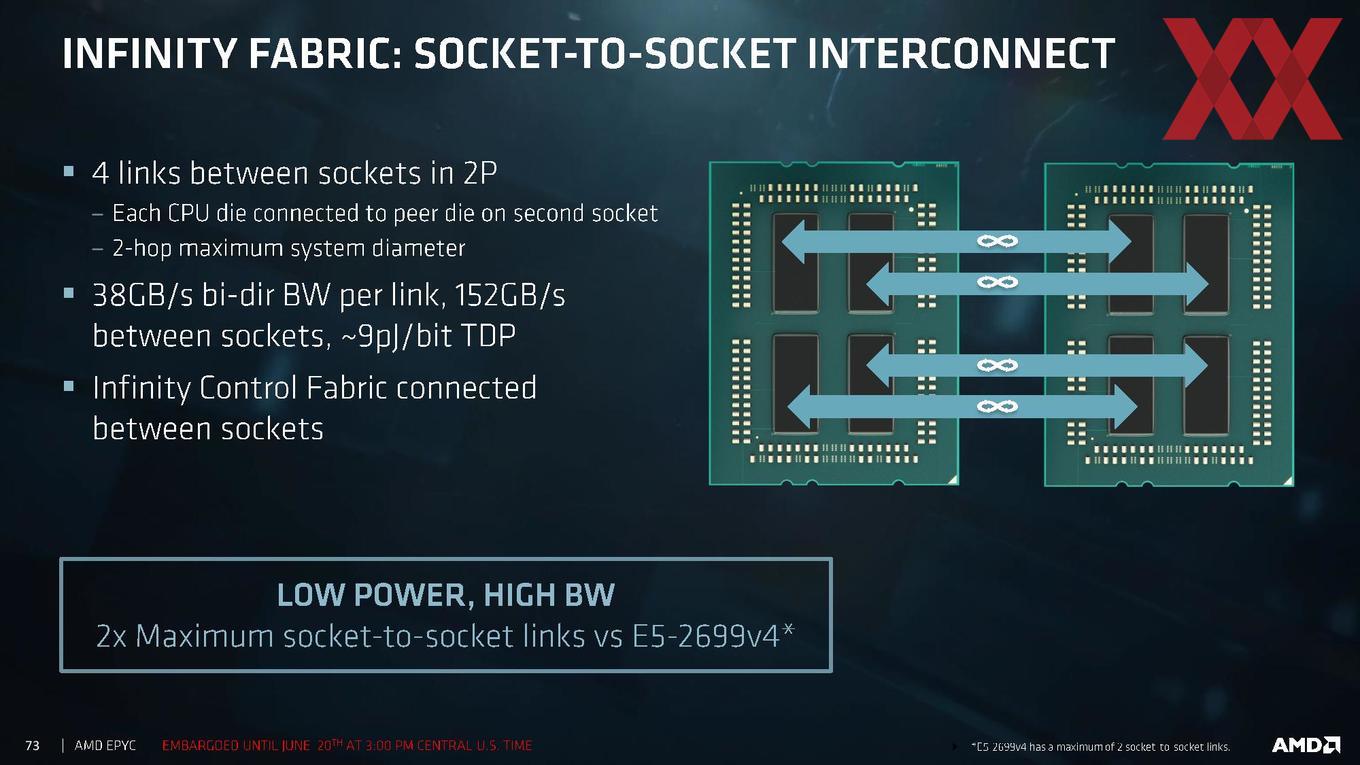

Der Infinity Fabric kommt auch für die Verbindung zwischen zwei Prozessoren im einem Dual-Socket-Server zum Einsatz. Hier verfügen beiden Prozessoren nur noch über jeweils 64 PCI-Express-Lanes, weil die die übrigen 64 Lanes dazu verwendet werden den Interconnect herzustellen. Insgesamt bietet ein solcher Server aber weiterhin 128 PCI-Express-Lanes, die komplett frei verwendet werden können. So können sechs GPU-Beschleuniger angesprochen werden oder aber die Lanes werden zur Anbindung von schnellem Massenspeicher verwendet.

90 bis 95 % des Marktes und Namensschema

Mit der Single- und Dual-Socket-Strategie verspricht sich AMD 90 bis 95 % des aktuellen Servermarktes anzusprechen. Quad-Socket-Varianten wird es laut AMD nicht geben. Der Markenname EPYC war ja nun bereits bekannt. Neben den einzelnen Modellen stellt AMD aber nun auch das Namensschema offiziell vor. Die Prozessoren gehören zur EPYC 7000 Serie und hören beispielsweise auf den Namen EPYC 7351P. Der Name setzt sich wie folgt zusammen:

- 7 = EPYC 7000 Serie

- 35 = Index für die Leistungseinordnung

- 1 = 1. Generation

- P = Single-Socket

In der Folge haben wir eine Aufstellung der Single-Socket-Varianten gemacht. Diese bieten allesamt 64 MB L3-Cache, Octa-Channel für DDR4-2666 sowie die erwähnten 128 PCI-Express-Lanes. Unterschiede gibt es bei der Taktung und Anzahl der Kerne. Den Takt gibt AMD mit Basis-Takt, Boost-Takt für alle Kerne und einem maximalen Takt für zwei Kerne an. Die unterschiedlichen TDP-Angaben ergeben sich unter Verwendung von DDR4-2400 für den niedrigeren oder DDR4-2666 für den höheren Verbrauch.

| Modell | Kerne / Threads | Takt | L3-Cache | Arbeitsspeicher | PCIe-Lanes | TDP | Preis |

| EPYC 7551P | 32 / 64 | 2,0 / 2,6 / 3,0 GHz | 64 MB | DDR4-2666 | 128 | 180 W | 2.000 US-Dollar |

| EPYC 7401P | 24 / 48 | 2,0 / 2,8 / 3,0 GHz | 64 MB | DDR4-2666 | 128 | 155 / 170 W | 1.000 US-Dollar |

| EPYC 7351P | 16 / 32 | 2,4 / 2,9 / 2,9 GHz | 64 MB | DDR4-2666 | 128 | 155 / 170 W | 700 US-Dollar |

Etwas größer ist die Auswahl bei den Dual-Socket-Prozessoren:

| Modell | Kerne / Threads | Takt | L3-Cache | Arbeitsspeicher | PCIe-Lanes | TDP | Preis |

| EPYC 7601 | 32 / 64 | 2,2 / 2,7 / 3,2 GHz | 64 MB | DDR4-2666 | 128 | 180 W | 4.000 US-Dollar |

| EPYC 7551 | 32 / 64 | 2,0 / 2,6 / 3,0 GHz | 64 MB | DDR4-2666 | 128 | 180 W | 3.200 US-Dollar |

| EPYC 7501 | 32 / 64 | 2,0 / 2,6 / 3,0 GHz | 64 MB | DDR4-2666 | 128 | 155 / 170 W | - |

| EPYC 7451 | 24 / 48 | 2,3 / 2,9 / 3,0 GHz | 64 MB | DDR4-2666 | 128 | 180 W | 2.400 US-Dollar |

| EPYC 7401 | 24 / 48 | 2,0 / 2,8 / 3,0 GHz | 64 MB | DDR4-2666 | 128 | 155 / 170 W | 1.700 US-Dollar |

| EPYC 7351 | 16 / 32 | 2,4 / 2,9 / 2,9 GHz | 64 MB | DDR4-2666 | 128 | 155 / 170 W | 1.100 US-Dollar |

| EPYC 7301 | 16 / 32 | 2,2 / 2,7 / 2,7 GHz | 64 MB | DDR4-2666 | 128 | 155 / 170 W | 800 US-Dollar |

| EPYC 7281 | 16 / 32 | 2,1 / 2,7 / 2,7 GHz | 64 MB | DDR4-2666 | 128 | 155 / 170 W | 600 US-Dollar |

| EPYC 7251 | 8 / 16 | 2,1 / 2,9 / 2,9 GHz | 64 MB | DDR4-2400 | 128 | 120 W | 400 US-Dollar |

An dieser Stelle sei noch angemerkt, wie AMD die Modelle mit weniger als 32 Kernen realisiert. Dazu wird pro CPU Complex ein Kern deaktiviert. Damit verbleiben sechs pro Zeppelin-Chip und bei vier dieser Chips im MCP kommen wir auf beispielsweise 24 Kerne. Beim 16-Kern-Modell werden zwei Kerne pro CPU Complex deaktiviert, beim Achtkerner bleibt nur ein CPU-Kern pro CPU Complex aktiv. Egal welche Konfiguration AMD anwendet, die Speicherkanäle und PCI-Express-Lanes bleiben davon unangetastet.

Bei der Thermal Design Power bietet AMD noch etwas Flexibilität. In den obigen Tabellen wird haben wir die regulären Werte angegeben, AMD ermöglicht aber auch noch einen Betrieb in einem sogenannten Low TDP und High TDP Mode.

| Low TDP | TDP | High TDP |

| 155 W | 180 W | 200 W |

| 140 W | 155 W | 175 W |

| 105 W | 120 W | - |

Damit bietet AMD den Anbietern eine gewisse Flexibilität bei der Gestaltung ihrer Systeme.

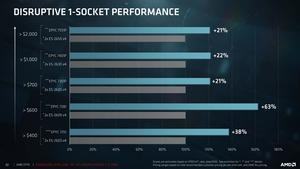

Erste Leistungswerte zeigen deutlichen Vorsprung

Natürlich hat AMD auch gleich weitere eigene Leistungswerte parat, nachdem man solche bereits zum RYZEN-Tech-Day Anfang März präsentierte. AMD muss derzeit noch mit aktuellen Xeon-Prozessoren vergleichen. Messen lassen müssen sich die EPYC-Prozessoren aber mit den Skylake-SP-Modellen, die Intel im Sommer vorstellen wird.

MCP, Infinity Fabric und NUMA

Bereits bei den RYZEN-Prozessoren war das Thema Interconnect bzw. dessen Geschwindigkeit und Latenzen zwischen den CPU Complexen ein wichtiges. Auch bei den Servern spielt es eine wichtige Rolle. Dabei wollen wir auf ein Thema verweisen, welches wir vor ein paar Tagen aufbrachten. Vergleicht man die Chipgröße der aktuellen Intel- und AMD-Prozessoren, fällt auf, dass beide unterschiedliche Strategien bei den größeren Chips anwenden. Während AMD auf einen modularen Aufbau setzt, verwendet Intel derzeit große monolithische Chips mit enormer Fläche.

Beides hat seine Vor- und Nachteile. Chips im MCP-Design lassen sich relativ einfach fertigen, sind jedoch von einem schnellen Interconnect abhängig. Große monolithische Chips hingegen erreichen inzwischen enorme Größen, sind entsprechend aufwändig zu fertigen, die Kommunikation innerhalb des Chips ist aber hinsichtlich der Bandbreite und vor allem Latenz berechenbarer.

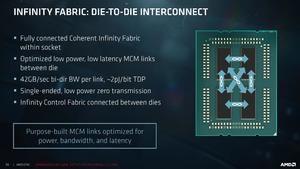

In einem EPYC-Prozessoren mit vier Zeppelin-Chips, ist jeder einzelne dieser Chips über drei Interconnects mit den jeweils drei anderen verbunden. Dieser jeweils einzelne Link erreicht eine Bandbreite von 42,6 GB/s bidirektional, also in beide Richtungen. Entscheidend ist dabei auch der Energieaufwand, der pro Bit notwendig ist, Daten darüber auszutauschen. AMD gibt ab, dass dieser 2 pJ pro Bit, oder 0,6672 W pro Link, 0,336W pro Zeppelin-Chip pro Link und damit ingesamt 4,032 W beträgt.

In einem Dual-Socket-System sind die beiden EPYC-Prozessoren ebenfalls über den Infinity Fabric miteinander verbunden. AMD verwendet vier Links mit einer Bandbreit von jeweils 37,9 GB/s. Damit ist diese Verbindung etwas langsamer, als die zwischen den Zeppelin-Kernen. Grund hierfür ist die größere Übertragungsstrecke zwischen den einzelnen Prozessoren, während die Zeppelin-Chips in einem Package deutlich enger zusammen liegen.

Insgesamt bietet diese Verbindung zwischen den Sockeln eine Bandbreite von 152 GB/s bei einem Energieaufwand von 10,94 W (9 pJ pro Bit, 5,48 W pro Prozessor und 1,368 W pro Zeppelin-Chip.

Neben der Bandbreite und der Energie die aufgewendet werden muss spielt aber vor allen die Latenz eine wichtige Rolle. AMD spricht hier nur von besonders niedrigen Latenzen, gibt aber keine Werte an. Von den RYZEN-Prozessoren kennen wir aber zumindest die Werte für den Kommunikation zwischen den CPU Complexen. PCPerspective hat dazu entsprechende Messungen vorgenommen.

Innerhalb eines CPU Complexes beträgt die Latenz 26 ns. Sollen Daten zwischen Kernen in einem CPU Complex ausgetauscht werden, beträgt die Latenz hier 42 ns. Zwischen zwei CPU Complexen beträgt die Latenz 142 ns. Messungen zur Latenz zwischen den Zeppelin-Chips gibt es derzeit nicht. Gleiches gilt auch für die Kommunikation zwischen zwei CPUs in einem Dual-Sockel-System.

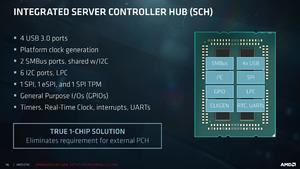

Server Controller Hub mit weiteren I/Os

Neben den 128 PCI-Express-Lanes pro Prozessor bietet dieser auch noch einen Server Controller Hub (SCH). Dieser bietet beispielsweise vier USB-3.0-Anschlüsse, stellt aber auch zahlreiche I2C-Ports sowie SMBus-Ports zur Verfügung. Hinzu kommen noch zahlreiche Taktgeber.

Die PCI-Express-Lanes lassen sich weitestgehend frei aufteilen. Allerdings macht AMD hier auch einige Vorgaben, denn komplett Flexibel ist die Konfiguration der Lanes nicht. 16 PCI-Express-Lanes lassen sich wie folgt verwenden:

- 1x Infinity Fabric

- 1x 16 Lanes

- 2x 8 Lanes

- 4x 4 Lanes

- 8x 2 Lanes

- 16x 1 Lane

- 8x SATA

Bis zu 64 einzelne Anbindungen externer Hardware sind möglich. Dazu gehört die Möglichkeit bis zu 32 NVMe-Massenspeicher zu verwenden.

Das Ende ist offen

Derzeit ist noch unklar, welche Auswirkungen diese Neuankündigungen auf den Servermarkt letztendlich haben werden. AMD arbeitet mit Herstellern wie Dell und HP zusammen und diese werden sicherlich auch entsprechende Server anbieten. Nicht abzuschätzen aber ist, welche Durchsetzungskraft AMD mit seinen neuen Prozessoren am schwierigen Servermarkt haben wird. Gegen Ende des Jahres sollen die EPYC-Prozessoren in größeren Stückzahlen verfügbar sein. Erst in einigen Monaten wird man also sehen, ob AMD den Markt wie mit den RYZEN-Prozessoren wird wiederbeleben können.