Werbung

Bereits mehrfach hatten wir über die geplanten Entwicklungen um den GDDR6-Grafikspeicher gesprochen. Samsung hat inzwischen konkrete Angaben zu den technischen Spezifikationen gemacht. Micron hat nun seinerseits dazu einige Angaben gemacht.

Geplant ist demnach zu Beginn Speicherchips mit einer Kapazität von 8 und 16 Gbit – demnach 1 und 2 GB. Diese sollen eine Speicherbandbreite von 12 bis 14 GB/s pro Pin erreichen. Die I/O-Konfiguration pro Channel liegt bei x8 oder x16. Anders als GDDR5X kommen bis zu zwei Channel zum Einsatz. Keine großen Unterschiede gibt es bei der Größe der Chips sowie deren Betriebsspannung. Zwar soll GDDR6 etwas sparsamer sein, denn werden auch hier 1,35 bis 1,8 V angegeben.

Zum Vergleich die Angaben von Samsung: Der hier angekündigte GDDR6 soll eine Kapazität von 2 GB pro Chip aufweisen. Dieser liefert die von Samsung bereits genannten 16 GBit/s pro I/O-Pin und kommt auf eine Speicherbandbreite von 64 GB/s. Ein typischer Speicherausbau von 8 GB und damit vier Chips ergäbe demnach 256 GB/s. Bei 16 GB Kapazität sprechen wir von 512 GB/s. Die notwendige Spannung soll bei nur 1,35 V liegen.

Signalintegrität als große Herausforderung

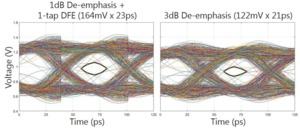

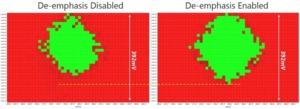

Bereits bei der Entwicklung von GDDR5X hat Micron eng mit NVIDIA zusammengearbeitet, denn bei den inzwischen erreichten Taktraten ist die Signalintegrität eine der großen Herausforderungen. Micron hat in seinem Blogpost ein paar Bilder veröffentlicht, welche die Probleme bei der Entwicklung aufzeigen sollen.

Das Auge in der Mitte sollte möglichst klar und deutlich sein. Ist es das nicht, kommt es zu fehlerhaften Übertragungen. Zu den Optimierungen gehört unter anderem, dass man Signale verwendet, die sich überlagern und derart ausgleichen, das ein klareres Signal dabei herauskommt.

Micron hat bereits mit dem Sampling von GDDR6 begonnen und will in der ersten Jahreshälfte 2018 mit der Massenfertigung beginnen. Intern arbeitet man bereits an höheren Taktraten, die bei 16 GB/s pro I/O liegen sollen. Dabei scheint man von den Erfahrungen mit GDDR5X zu profitieren.

Für 2018 sollen erste High-End-Grafikkarten mit GDDR6 bestückt werden. Hier soll GDDR5X ersetzt werden, der allerdings nur von NVIDIA eingesetzt wird. GDDR5 soll aber ebenfalls noch eine lange Zeit eine Rolle spielen, denn GDDR6 wird gerade zu Anfang sehr teuer sein.