Werbung

Advertorial / Anzeige

Generative KI eröffnet neue Möglichkeiten für PCs und Workstations. Aufgrund des hohen Innovationstempos im Bereich der KI fällt es der PC-Entwicklergemeinschaft oft schwer, hier mitzuhalten und sich auf die aktuellen Entwicklungen einzustellen. Die NIM-Mikrodienste von NVIDIA erleichtern den Einstieg, indem sie vorkonfigurierte, optimierte und einfach herunterladbare KI-Modelle bereitstellen, die über branchenübliche APIs angebunden werden können. Sie sind auf maximale Leistung auf RTX-AI-PCs und -Workstations ausgelegt und umfassen sowohl führende Community-Modelle als auch von NVIDIA entwickelte Lösungen.

Die dafür notwendige, leistungsstarke Hardware stellt NVIDIA nicht erst seit der GeForce-RTX-50-Serie auf Basis der Blackwell-Architektur bereit. GeForce RTX und die Nutzung von KI für Upscaling, Frame Generation, Ray Reconstruction und vieles mehr sind nur ein Teil dessen, was mit KI-Beschleunigung und Kreativ-Workflows möglich ist.

Die auf NIM-Mikrodiensten basierenden AI-Blueprints dienen als Referenzimplementierung für komplexe KI-Workflows. Sie unterstützen Entwickler dabei, verschiedene Bausteine – darunter Bibliotheken, Software-Development-Kits und KI-Modelle – in einer Anwendung zu verknüpfen. Diese Blueprints lassen sich anpassen und erweitern, um ihr Verhalten zu verändern, andere Modelle zu nutzen oder völlig neue Funktionen zu integrieren.

NVIDIA NIM

Der Name NIM oder NVIDIA Inferencing Microservices verrät es bereits: Es geht um die Arbeit mit bereits trainierten KI-Modellen. Diese wurden trainiert, das heißt konzeptionell entworfen, mit Daten gefüttert und damit angelernt. Dies ist eine der Voraussetzungen, um ein Inferencing überhaupt anbieten zu können. Zudem muss es eine Möglichkeit geben, mit dem Modell zu interagieren. Dies kann eine einfache Text-Eingabe (Prompt), aber auch eine Schnittstelle in der verwendeten Software sein. Zuletzt benötigt man natürlich die Hardware, auf der das Modell ausgeführt werden soll. Das Training setzt gewisse Anforderungen an die Hardware, die aber anders gelagert sind als beim Inferencing.

NVIDIA NIM-Mikrodienste stellen vorkonfigurierte, hochmoderne KI-Modelle bereit, die speziell für die NVIDIA-RTX-Plattform optimiert sind. Dadurch können Entwickler leistungsstarke KI-Funktionen einfacher nutzen und einsetzen.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen

Es wird ein breites Spektrum an Anwendungen abgedeckt – von Sprachmodellen über Bildgenerierung bis hin zu Computer-Vision. Etwa 250 Modelle aus zahlreichen Bereichen bietet NVIDIA bereits an:

- Code-Generierung

- Digital Twins

- Drug Discovery

- Image Classification

- Bilderzeugung

- Bild-zu-Text

- Medical Imaging

- Objekterkennung

- Optical Character Recognition

- Retrieval Augmented Generation

- Routenoptimierung

- Speech-to-Animation

- Speech-to-Text

- Synthetic Data Generation

- Text-to-Embedding

- Text-to-Image

- Text-to-Speech

- Wettersimulation

Zu jedem dieser Bereiche gibt es wiederum mindestens ein Modell, oft jedoch gleich mehrere, die auf unterschiedlichen Daten basieren. Die meisten sind für den Enterprise-Einsatz gedacht. Es gibt allerdings auch einige "Run-On-RTX"-NIMs, die auf GeForce-RTX-Karten ausgeführt werden können.

NVIDIA AI-Blueprints

Die NVIDIA AI-Blueprints sind fertige Referenzbeispiele und dienen als sofort einsetzbare Vorlagen, um generative KI-Workflows mit NIM-Mikrodiensten umzusetzen. Sie erleichtern die Entwicklung komplexer KI-Funktionen, indem der Aufbau generativer KI-Workflows deutlich überschaubarer wird. Durch die bereitgestellten Beispiele lässt sich die Entwicklung KI-gestützter Anwendungen deutlich beschleunigen.

Mit den NIMs sorgt NVIDIA also für die einfache Bereitstellung der KI-Modelle, die Blueprint für die Entwicklung kompletter KI-Workflows dienen.

Anwendungsbeispiel FLUX.1

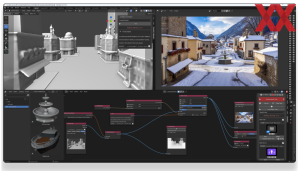

Ein Anwendungsbeispiel für die Nutzung eines kompletten KI-Workflows per NVIDIA Blueprint ist die 3D Guided Generative AI. Diese verwendet FLUX.1 in ComfyUI, was wiederum als Plug-In für Blender zur Verfügung gestellt wird.

Der 3D Guided Generative AI Blueprint ermöglicht eine bessere Kontrolle über die Bilderzeugung, indem er den Inhalt in Blender anordnet, um das Bildlayout zu steuern. Benutzer können mithilfe generativer KI schnell Assets in der 3D-Szene austauschen, und die Perspektive des Ausgabebildes wird durch einfaches Ändern des Kamerawinkels umgeschaltet.

Der Blueprint erzeugt Ergebnisse, indem er die FLUX.1-dev-Modellsuite von Black Forest Labs nutzt und ComfyUI bietet eine flexible und komfortable Benutzeroberfläche. Die Modelle werden auf NVIDIA-GPUs quantisiert und beschleunigt, um eine optimale Leistung zu gewährleisten. Durch die Verwendung von FP4-Quantisierung nutzt das Modell die RTX-50-Serie-Karten voll aus, reduziert den VRAM-Verbrauch und beschleunigt den Generierungsprozess.

Unterstützt wird die folgende Hardware:

- NVIDIA GeForce RTX 5090

- NVIDIA GeForce RTX 5080

- NVIDIAGeForce RTX 4090

- NVIDIAGeForce RTX 4080

- NVIDIA GeForce RTX 5090 Laptop GPU

- NVIDIA GeForce RTX 4090 Laptop GPU

- NVIDIA RTX 6000 Lovelace Generation

Wir haben für das Anwendungsbeispiel eine GeForce RTX 5090 verwendet.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen

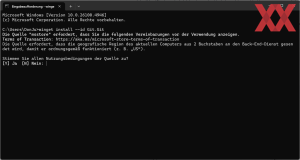

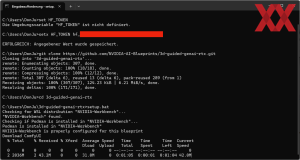

Bevor wir loslegen können, müssen wir ein paar Vorbereitungen treffen. Zu diesen gehört ein lauffähiges Windows Subsystem for Linux (WSL 2) sowie die NIM-Installers. In einer Anleitung beschreibt NVIDIA ausführlich, welche Schritte auszuführen sind.

Die Einrichtung umfasst einerseits die Installation einiger Software, aber es müssen auch API-Tokens eingeholt und Lizenzbestimmungen akzeptiert werden. Eben erwähnte Schritt-für-Schritt-Anleitung bietet alle notwendigen Informationen und Links.

Bei der ersten Verwendung von NIM Flux.1-dev müssen Modelle von NVIDIA NGC, dem Portal für Enterprise Services, Software und Management-Tools bei NVIDIA, heruntergeladen und der FLUX-NIM-Container eingerichtet werden. Dieser Vorgang kann je nach Verbindungsgeschwindigkeit bis zu 20 Minuten oder länger dauern.

Standardmäßig verwendet der Beispiel-Workflow die Viewport-Szene in Kombination mit der folgenden Eingabeaufforderung, um ein Bild zu generieren, das sowohl dem Gesamtbild der 3D-Szene als auch der Texteingabeaufforderung entspricht: "a stunning professional photo of a quaint village in the mountains in winter, a snow covered fountain is visible in the center of the town square".

Mit der Maus und den WASD-Tasten kann in der Szene navigiert und mit den Tasten E und F die Kamera nach oben und unten geschwenkt werden. Zudem können Objekte manipuliert und umpositioniert oder gar ganz ausgetauscht werden. Auf Wunsch findet dann ein erneutes, komplettes Rendering statt.

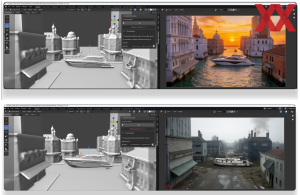

Aus dem Brunnen wird ein Boot. Aus den Straßenzügen Wasserkanäle und so kann der Phantasie freien Lauf gewährt werden.

Über einen neuen Prompt kann das komplette Szenario geändert werden: "a stunning profession photo of a modern luxury boat in the canals of Venice, classical buildings, at sunset" oder "an abandoned boat sitting between rows of warehouses".

Das erneute Rendering findet dann lokal, auf der RTX-GPU statt, ohne dass über die Cloud gearbeitet werden muss. Dies hat natürlich Vorteile in der Latenz sowie der Renderzeit. Bereits nach wenigen Sekunden ist das neue Bild berechnet.

Anwendungsbeispiel Microsoft TRELLIS

Ebenfalls auf FLUX.1 aufbauend bietet NVIDIA einem Workflow-Blueprint für 3D Guided Generative AI auf Basis des Llama 3.1 8B und dem Microsoft Trellis NIM. Künstler können mit einer einzelnen Szenenidee über einen einfachen Texteingabebefehl (z. B. "night market") starten, woraufhin das Blueprint bis zu 20 potenzielle Objekte konzipiert.

NVIDIA SANA erzeugt hochauflösende Previews und ermöglicht es den Künstlern, Objekte gezielt neu zu generieren, zu modifizieren oder zu verwerfen, bevor eine endgültige Auswahl getroffen wird. Die finalen Objekte lassen sich nahtlos nach Blender oder in andere 3D‑Anwendungen exportieren. Für 3D-Freelancer, die Hunderte von Assets für viele Szenen erstellen, führt dies zu erheblichen Leistungssteigerungen.

Microsoft TRELLIS NIM ist ein neuer Microservice, der das Text‑zu‑3D‑Modell von Microsoft Research direkt in das 3D‑Object‑Generation‑Blueprint integriert. Anstelle einer komplexen Einrichtung erhalten Künstler eine Drop‑in‑Lösung, die den Einsatz über GeForce‑RTX‑ und RTX‑PRO‑GPUs hinweg vereinfacht. Microsoft TRELLIS wird auf allen GeForce‑RTX‑50‑ und 40‑Series‑GPUs mit 16 GB oder mehr unterstützt – sowohl auf Desktop‑Systemen als auch auf Laptops.

Bei Verwendung im Blueprint ist der Microsoft TRELLIS NIM Microservice durch PyTorch‑Optimierungen um 20 % schneller und ermöglicht dadurch kürzere Iterationszeiten. Die durchschnittliche Zeitersparnis liegt bei rund 6 Sekunden pro generiertem Objekt auf einer NVIDIA GeForce RTX 5090 GPU. Für 3D‑Freelancer, die Hunderte von Assets über zahlreiche Szenen hinweg erstellen, ergibt sich daraus ein erheblicher Performance‑Gewinn.

Detaillierte Instruktionen zur Installation und alle notwendigen Dateien sind bei NVIDIA Build und GitHub zu finden.

Run-on-RTX Blueprints

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen

Aktuell finden sich bei NVIDIA gut ein Dutzend Blueprints, die mit Run-On-RTX lokal auf einer RTX-Grafikkarte ausgeführt werden können. Dazu gehören viele aus dem Bereich Bilderzeugung, also Text-to-Image, aber auch solche zur Ausführung eines lokalen Code-Assistenten, der Bilderkennung oder Transkription von Sprache zu Text.

Weitet man die Suche bei den Blueprints auf solche aus, die auch auf Server-Hardware wie den H100/H200- und B100/B200-Beschleunigern ausgeführt werden können, finden sich hier noch einige mehr.

Advertorial / Anzeige