barnacle2k

Enthusiast

Ziel und Thema dieses Threads:

Also hier ist er endlich: DER Thread für all die Leute, die sich einfach nicht mit 100 Mbyte/s zufrieden geben können oder wollen.

In diesem Thread geht es nicht darum, ob das sinnvoll ist oder nicht!

Es geht darum, wie man vorgeht wenn man nun einfach MEHR will.

Nach diesen einleitenden Worten nun zur Sache:

Wir wollen also die Grenze von klassischem Gigabit Ethernet (1 Gbit/s bzw. 1000 Mbit/s) durchbrechen. Dafür kann man sich verschiedener Technologien bedienen.

Dieser Thread beschäftigt sich hauptsächlich mit Infiniband (IB) und 10 Gbit Ethernet (10 GbE).

Es handelt sich dabei um konkurrierende Standards, die für verschiedene Anwendungen gedacht sind.

Die sonstigen Alternativen für Highspeed Netze:

1. Myrinet - Der Exot:

Gibts in 2 Gbit/s und 10 Gbit/s versionen, die 10 Gbit/s Karten machen auch gleichzeitig 10 GbE.

Die 2 Gbit/s Karten gibts nur im PCI-X Format und sind damit eher uninteressant.

Ich habe die 2 Gbit/s Variante mal getestet und festgestellt, dass im TCP/IP Betrieb die Systemlast sehr hoch ist, da keinerlei Offloading vorhanden ist.

Durchsatz lag bei etwa 190 Mbyte/s (bei 100% CPU Last).

Um natives Myrinet zu nutzen muss man sich seinen eigenen Code basteln.

Die API ist gut dokumentiert, aber ich denke das möchte sich niemand fürs Heimnetz antun.

2. FibreChannel - Das geht nicht!

FibreChannel Adapter sind ebenfalls günstig zu erwerben.

Datenraten: 1, 2, 4, 8 Gbit/s.

Es ist aber nicht ohne weiteres möglich diese für Ethernet einzusetzen.

Es gab mal einen Ethernet over FC Standard, dieser hat eine sehr geringe Verbreitung bzw. ist inzwischen tot.

Heutzutage geht man den umgekehrten Weg: FibreChannel over Ethernet, kurz FCOE.

Netzwerkkarten, die das beherrschen, bezeichnet man als CNA. Dazu später mehr.

Standard #1: Infiniband

Diese Sektion ist noch im Aufbau und ich sammle noch informationen!

Infiniband ist der De-Facto Forenstandard weil die Hardware für günstiges Geld in der Bucht erhältlich ist.

Karten:

Die Karten werden auch Host Channel Adapter, kurz HCA, genannt.

Übliche Hersteller sind z.B. Mellanox, Cisco und Voltaire. Es existieren aber viele OEM Karten von IBM, HP usw.

Man sollte sich auf jeden Fall VOR dem Kauf über die Karte informieren und beim Hersteller dann Treiber und OS Kompatibiltät checken.

Desktop Motherboards arbeiten normalerweise problemlos mit den Karten zusammen.

Infiniband Kabel:

Leider ist die Kabellänge auf 15 Meter begrenzt, ausserdem sind sie teuer.

Am billigsten scheinen sie über ebay in den USA zu haben zu sein.

Die Anschlüsse entsprechen dem SFF8470 Standard, auch CX4 genannt:

Die Stecker können nicht einfach wie bei RJ45 gecripmt werden.

Diese Kabel werden teilweise auch für 10 GbE und Serial Attached SCSI (SAS) benutzt.

Achtet darauf, dass es sich um Stecker mit Laschenbefestigung handelt nicht um solche mit Schraubbefestigung.

Es gibt auch Glasfaser-Konverter für diese Anschlüsse, die sind aber kaum bis gar nicht verfügbar.

Ein SDR Infiniband Kanal erreicht 2,5 Gbit/s Signalrate. Wie viele andere aktuellen Interfaces (z.B. SATA) wird ein 8B/10B Code verwendet. Das heisst, dass von zehn übertragenen Bits acht Bits Nutzdaten sind. Mit anderen Worten, der konzeptionell bedingte Overhead beträgt 20%.

Diese Rechnung beinhaltet noch nicht den zusätzlichen Overhead durch andere Protokolle, die man über IB nutzt. In unserem Fall zumindest TCP/IP, zusätzlich vielleicht noch FTP usw.

Neben SDR ist auch DDR (5 Gbit/s Signalrate pro Kanal) und QDR (10 GBit/s Signalrate pro Kanal) spezifiziert, die auch alle einen 8B/10B Code nutzen. Entsprechende Hardware ist auch noch zu akzeptablen Preisen zu bekommen.

Darüber hinaus ist noch FDR und EDR spezifiziert, die mit einem 64B/66B Code den Overhead massiv verkleinern, auf die wird hier jedoch erstmal nicht weiter eingegangen auf Grund mangelnder Verfügbarkeit.

Man kann auch davon ausgehen, dass SDR, DDR und QDR im Heimbereich noch lange ausreichen wird.

In auf dem Markt erhältlicher, gängiger IB Hardware werden immer mindestens vier Kanale gebündelt.

Das ergeben sich folgende, effektive Signalraten:

SDR: 10 GBit/s

DDR: 20 GBit/s

QDR: 40 Gbit/s

Bedenkt, dass davon mindestens 20% für Overhead draufgehen werden!

Software:

IP over Infiniband (IPoIB) ist das Stichwort, wenn man normale Netzwerkanwendungen darüber laufen lassen möchte.

Dabei ist darauf zu achten, dass die Karten IP Offloading unterstützen, denn sonst ist mit hoher CPU last zu rechnen.

Für iSCSI gibt es RDMA, welches die Daten direkt zwischen den Hauptspeichern der beteiligten PCs ohne CPU Beteiligung transferiert.

Das funktioniert, soweit ich weiß, nur unter Linux/Solaris vernünftig.

Schlingel_INV hat ein wunderbares "How To" zur Einrichtung einer Infiniband Verbindung verfasst:

>>Infiniband How To<<

Standard #2: 10 Gbit Ethernet

Planung und Aufbau:

Da die Retailpreise sich einfach nicht bewegen wollen kommt nur ein Gebrauchtkauf in Frage.

Switche mit 10 Gbit sind unverhältnismässig teuer.

Daher wird der Heimanwender auf eine Punkt zu Punkt Verkabelung setzen.

Günstigerweise sind die meisten Karten, die verkauft werden, Dualport Karten.

Das vereinfacht die Sache! Man baut einfach eine Netzwerkbrücke über diese beiden Ports. Damit lassen sich Theoretisch unbegrenzt viele PCs vernetzen, leider teilen sich diese auch die Bandbreite.

Das normale Heimnetz für Internet usw. bleibt natürlich physikalisch getrennt!

Die Verschiedenen Anschlüssen und Standards:

Glasfaser:

Transceiver:

Die Transceiver sind Module, die in die Karten gesteckt werden.

Es gibt SFP+ (klein), XFP (mittelgroß) und XENPAK (riesig)

Die tun im Allgemeinen das gleiche, nämlich elektrische Signale in optische wandeln. Die Großen verbrauchen aber mehr Strom und benötigen mehr Kühlung.

SFP+ ist das aktuellste Format.

Tranceiver sind im Allgemeinen nicht billig und man sollte besser nach Karten MIT Transceivern Ausschau halten. Damit ist garantiert, dass diese auch zusammen funktionieren.

Manche Kartenhersteller lassen nur Transceiver von einem bestimmten Hersteller zu!

Die mechnischen Stecker sind in allen Fällen vom Typ LC.

Lichtwellenleiter (LWL):

Oft auch Glasfaserkabel genannt, häufig findet man auch die falsche Bezeichnung FibreChannel-Kabel! Sehr billig gebraucht zu haben, auch neu noch problemlos erschwinglich. Preise werden weiter unten noch genau behandelt.

Für LWL gibt es gewisse Kenngrößen, die über Eigenschaften und Qualität Auskunft geben. Grundsätzlich unterscheidet man Multimode- und Singlemodefasern.

Üblicherweise sind Multimode-LWL orange, Singlemode-LWL sind gelb. Wir befassen und hauptsächlich mit Multimode-LWL, die für kurze und mittlere Übertragungslängen gedacht sind. Das sind immer noch mehrere 100 Meter, für den üblichen Heimgebrauch also ausreichend.

Außerdem unterscheidet mal die Faserkategorie, bei Multimode-LWL sind das die Kategorien OM1, OM2, OM3 und OM4. OM1 und 2 sind dabei hauptsächlich zur Anwendung mit LEDs als Lichtquelle gedacht, was früher häufig der Fall war. Damit war 10 Gbit/s technisch unmöglich, weswegen nun hauptsächlich Laser eingesetzt werden, wofür man OM3 oder 4 benötigt. Daher beim Kauf darauf achten, dass die LWL mindestens der Kategorie OM3 entsprechen!

Dritte und letzte Kenngröße sind die Durchmesser des Kerns und des Mantels der LWL. Dabei handelt es sich um die beiden inneren Schichten eines LWL, die dritte ist eine Schutzbeschichtung und die vierte die äußere Hülle.

Relevant sind jedoch nur Kern und Mantel.

Gängig sind 50 µm für den Kern und 125 µm für den Mantel, meist einfach als 50/125 erwähnt. In Kombination mit Kategorie OM3 und LC Steckern wird man auch nicht viel andere finden, trotzdem sollte man eben genau darauf achten. Man weiß ja nie.

Die Steckertypen sind für gewöhnlich im Produktnamen mit erwähnt und für beide Seiten des Kabels angegeben. Für Kabel mit LC Steckern an beiden Seiten, die wir ja haben wollen, wäre das meist LC-LC oder LC/LC.

Gesucht für unsere Zwecke sind also LWL mit LC-LC, OM3 und 50/125 µm!

Kostenpunkt für gängige Längen im Heimbereich liegen z.B. bei 6 bis 8 Euro für 0,5 bis 3,0 Meter. 10 Meter gibts für ca. 15 Euro, 20 Meter für ca. 25 Euro.

Glasfaserkabel sind empfindlicher als Kupferkabel, aber trotzdem sollte einen das nicht davon abhalten welche zu verlegen.

Sie sind dünner und teilweise flexibler als Kupferkabel, man muss aber gut auf die Biegeradien achten.

Optisch:

10Gbase-SR:

Meistverbreitete Art bei optischen Transceivern. Läuft über Multimode Kabel mit LC Verbindern.

Distanz: 300 Meter über 50 µm Multimode Kabel

10Gbase-LR:

Erfordert Singlemode Kabel, die sind nur bedingt teurer als Multimode Kabel.

Die SFPs für diesen Standard sind billig, aber nicht immer kompatibel.

Distanz: 10 Kilometer über Singlemode Fiber

Kupfer:

10Gbase-CX4:

Billig zu finden, recht verbreitet. Limitierung auf 15 Meter Kabellänge.

Verwendet die gleichen Kabel wie Infiniband.

Distanz: 15 Meter

10Gbase-T:

SEHR selten zu finden, ist der standard der über CAT6 und CAT7 Kabel mit RJ45 Steckern läuft.

Soll aber viel Strom brauchen und weniger zuverlässig sein als die optischen Alternativen.

Distanz: 100 Meter

SFP+ CU:

Der neueste Standard für Kurzstreckenverbindungen mit Kupferkabeln.

Es handelt sich um Kupferkabel mit SFP+ Modulen an den Enden.

Es gibt aktive und passive Kabel. Die passiven funktionieren bis etwa 7 Meter.

Aktive erreichen 15-20 Meter.

Preise fangen bei ca. 30 Euro für 3 Meter an.

Nicht alle Karten mit SFP+ Slots supporten SPF+ CU Verbindungen und nicht alle Hersteller supporten offiziell die maximale Kabellänge!

Distanz: 7-20 Meter

Jumbo Frames:

Es ist bei 10 Gbit/s SEHR vorteilhaft mit Jumboframes zu arbeiten.

Grund: 10 Gbit/s bei 1500 Byte pro Paket macht gigantisch viele Pakete in der Sekunde!

Diese verursachen beim Eintreffen Interrupts, die können aber nicht auf mehrere Kerne verteilt werden und daher flooden sie einen Kern bis er "voll" ist. Dann ist die maximale Datenrate für 1500er Frames erreicht.

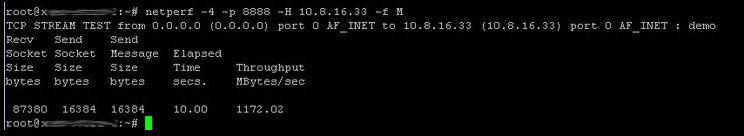

Bei meinen Benches ist das irgendwann bei 300-400 MByte/s der Fall.

Mit 9000 Byte Jumboframes wird die Interruptrate deutlich reduziert, weil die

Anzahl der Pakete um den Faktor 6 zurückgegangen ist.

Karten:

Nun kommen wir zu den Karten, die mir so über den Weg laufen/gelaufen sind:

Im Allgemeinen werden 10 Gbit/s Dualport CNA's aus neuen Servern ausgebaut, weil sie nicht verwendet werden.

Das sorgt für gute Preise und Verfügbarkeit.

Bei eBay werden CNAs häufig als 10 GB Fibre Channel oder FCOE Adapter oder ähnlich bezeichnet.

Es handelt sich dabei in 99% der Fälle um eine Karte die auch Ethernet kann. Man findet jedoch auch reine 10 GbE netzwerkkarten/NICs.

Die Information habe ich in mühsamer Kleinarbeit aus den Tiefen der Datenblätter und Handbücher zusammengeklaubt, basieren teilweise aber auch auf eigenen Erfahrungen mit den Adaptern (erster Teil der Auflistung).

Intel Pro/10GBE XF SR

Sehr gute 10 Gbit/s Karte von Intel, auch wenn inzwischen ein neuerer Chip draussen ist.

Basiert auf dem 82598EB Controller - 6.5W TDP, PCI-E 2.0 x8.

Externe SER/DES.

16 Virtuelle Cues VMDq (Vorteilhaft unter VMWARE)

Transceiver: XFP

Preis: ~220 Euro mit XFPs

Betriebsystemunterstützung: Windows, Linux, Solaris, BSD, ESX(I), MACOS

Pro: Guter Support, Treiberunterstüzung, VMDq

Kontra: Preis, XFP Tranceiver

Brocade BR1020

Ein sogenannter Converged Network Adapter/CNA.

Unterstützt FCOE in Hardware.

Singlechip Lösung mit integrierten SER/DES, 8.5W TDP, PCI-E 2.0 x8.

Achtung: Braucht zwingend elektrisch 8 Lanes!

OEM PNs: IBM: 42C1820

Transceiver: SFP+

Preis: 170 Euro mit SFPs

Warnung: benötigen Brocade SFP's!

Betriebsystemunterstützung: Windows, Linux, Solaris (keine Jumboframes), ESX(I)

Pro: Preis

Kontra: Kein!! Support, SFP Kompatibilität, Treiber

Emulex One Connect OCe11102

Ein "Unified Wire" Adapter, der FCOE und iSCSI beherrscht.

Singlechip Lösung mit externen SER/DES, PCI-E 2.0 x8 (Mechanisch x9-> x16 Port erforderlich).

Unterstützt Stateless Offload und iSCSI Offload (je nach Lizenz).

OEM PN: IBM:49Y4201 FRU: 49Y4202

Transceiver: SFP+

Preis: ~160 Euro

Betriebsystemunterstüzung: Windows, Linux, Solaris (nur mit Supportvertrag downloadbar), ESX(I)

Pro: Preis, iSCSI und FCOE Support, SFP Kompatibilität

Kontra: bei OEM Karten möglicherweise kein iSCSI

Achtung: Bei den Karten von IBM müssen auf der Rückseite die letzten vier Kontakte der PCI-E Kontaktleiste abgeklebt werden! Erklärung mit Bild in Post 255.

Chelsio S320E-CR

Chelsio Karten sind die wahren KILLER Netzwerkkarten.

Sie haben eine TCP Offload Engine. Das bedeutet, dass das komplette TCP/IP in der Netzwerkkarte läuft. Ausserdem wird iSCSI in Hardware unterstützt.

Multichip Lösung, 20W TDP, PCI-E 1.0 x8.

Wegen des hohen Stromverbrauchs ist die Karte vermutlich eher nichts für den 24/7 Homeserver.

Es gibt noch die N320E / N310E Karten, diese haben keine TOE und kein iSCSI!

Transceiver: XFP, SFP+

Preis: ~220 Euro

Betriebsystemunterstüzung: Windows, Linux, Solaris, BSD, ESX(i), MAC-OS

Pro: Performance, CPU-Last, iSCSI-Offload

Kontra: Preis, PCIe 1.0, Stromverbauch

Karten, die ich noch nicht persönlich in den Fingern hatte:

------------------------------------------------------

Qlogic QLE8142:

Dualport Converged Network Adapter

Kann Hardware FCOE, Singlechip Lösung, 7.4W TDP, PCI-E x8.

Transceiver: SFP+

Preis: ~170 Euro

Warnung: Die optischen Versionen benötigen Qlogic SFP's!

Betriebsystemunterstüzung: Windows, Linux, Solaris, BSD, ESX(i)

QLogic QLE 3242:

Dualport Intelligent Network Adapter.

Kann hardware FCOE, externe SER/DES, 7.4W TDP, PCI-E x8.

Varianten:

QLE3242-CU - SFP Kupferkabel

QLE3242-SR - Optisch Shortrange

QLE3242-LR - Optisch Longrange

QLE3240-CU - SFP Kupferkabel Singleport

QLE3240-SR - Optisch Shortrange Singleport

QLE3240-LR - Optisch Longrange Singleport

Transceiver: SFP+

Preis: ~170 Euro

Warnung: Die optischen Versionen benötigen Qlogic SFP's!

Besonderheiten: Kann 4 virtuelle NICs für VMWARE/HYPER-V erzeugen

Betriebsystemunterstüzung: Windows, Linux, Solaris, BSD, ESX(i)

INTEL E10G41AT2

Ein Vertreter der seltenen 10GBase-T Familie, 15.4W TDP!

Preis: ~400 Euro NEU!

Betriebsystemunterstüzung: Windows, Linux, Solaris, BSD, ESX(i), MACOS

Pro: VMDq, Treiber, Support, Kupferkabel

Kontra: Singleport, Stromverbrauch

HP NC524SFP

WARNUNG: Diese Karte ist nur eine Interface Karte.

Das bedeutet sie funktioniert nur auf in Kombination mit einer HP Riserkarte NC375i.

Preis: 250 Euro NEU!

Betriebsystemunterstüzung: kA

Switche:

Wie schon am Anfang geschrieben sind diese SEHR teuer:

Es gibt Switches mit 12-48 Gigabit Ports und 1-4 10 Gbit/s Uplink Ports.

Die modernen haben feste 10 GBit/s Uplink Ports (2-4), wo man dann einfach ein 10 GBit/s SFP+ Modul reinsteckt.

Hersteller schließen manchmal "fremd"-SFPs per Software aus!

Ältere haben ein oder zwei Erweiterungschächte, wo man ein Stacking Modul oder ein 10 GBit/s Modul einbauen kann.

In das Stacking Modul steckt man dann einen XFP oder Xenpak Transceiver.

Es gibt aber auch noch CX4 Module, die man natürlich nicht wirklich brauchen kann.

ACHTUNG: Ältere Switche schaffen über diese Modulports manchmal nicht die vollen 10 GBit/s!

Modelle:

3Com SC4200

12-48 Port Gbit Switch, kann mit 1-2 10 GBit/s Modulen aufgerüstet werden Transceiver: XFP

Foundry BigIron Core Switches

Diese wurden mir von TEGO3 nahegelegt.

Sind recht günstig in der Bucht zu haben und lassen sich mit 10Gbit Ports ausrüsten.

Die schlagen dann aber auch mit 400-500Eur zu Buche.

OEM Versionen sind z.B. der HP Procurve 9304 (9308).

Achten sollte man darauf die Richtigen Netzteile und eine Management Karte zu haben.

Linkliste:

Wikipedia Artikel über 10 GbE

Wikipedia Artikel über Infiniband

Vielen Dank an DunklerRabe für die Überarbeitung dieses Startbeitrags

[Changelog]

Stand: 16.11.2011

Also hier ist er endlich: DER Thread für all die Leute, die sich einfach nicht mit 100 Mbyte/s zufrieden geben können oder wollen.

In diesem Thread geht es nicht darum, ob das sinnvoll ist oder nicht!

Es geht darum, wie man vorgeht wenn man nun einfach MEHR will.

Nach diesen einleitenden Worten nun zur Sache:

Wir wollen also die Grenze von klassischem Gigabit Ethernet (1 Gbit/s bzw. 1000 Mbit/s) durchbrechen. Dafür kann man sich verschiedener Technologien bedienen.

Dieser Thread beschäftigt sich hauptsächlich mit Infiniband (IB) und 10 Gbit Ethernet (10 GbE).

Es handelt sich dabei um konkurrierende Standards, die für verschiedene Anwendungen gedacht sind.

Die sonstigen Alternativen für Highspeed Netze:

1. Myrinet - Der Exot:

Gibts in 2 Gbit/s und 10 Gbit/s versionen, die 10 Gbit/s Karten machen auch gleichzeitig 10 GbE.

Die 2 Gbit/s Karten gibts nur im PCI-X Format und sind damit eher uninteressant.

Ich habe die 2 Gbit/s Variante mal getestet und festgestellt, dass im TCP/IP Betrieb die Systemlast sehr hoch ist, da keinerlei Offloading vorhanden ist.

Durchsatz lag bei etwa 190 Mbyte/s (bei 100% CPU Last).

Um natives Myrinet zu nutzen muss man sich seinen eigenen Code basteln.

Die API ist gut dokumentiert, aber ich denke das möchte sich niemand fürs Heimnetz antun.

2. FibreChannel - Das geht nicht!

FibreChannel Adapter sind ebenfalls günstig zu erwerben.

Datenraten: 1, 2, 4, 8 Gbit/s.

Es ist aber nicht ohne weiteres möglich diese für Ethernet einzusetzen.

Es gab mal einen Ethernet over FC Standard, dieser hat eine sehr geringe Verbreitung bzw. ist inzwischen tot.

Heutzutage geht man den umgekehrten Weg: FibreChannel over Ethernet, kurz FCOE.

Netzwerkkarten, die das beherrschen, bezeichnet man als CNA. Dazu später mehr.

Standard #1: Infiniband

Diese Sektion ist noch im Aufbau und ich sammle noch informationen!

Infiniband ist der De-Facto Forenstandard weil die Hardware für günstiges Geld in der Bucht erhältlich ist.

Karten:

Die Karten werden auch Host Channel Adapter, kurz HCA, genannt.

Übliche Hersteller sind z.B. Mellanox, Cisco und Voltaire. Es existieren aber viele OEM Karten von IBM, HP usw.

Man sollte sich auf jeden Fall VOR dem Kauf über die Karte informieren und beim Hersteller dann Treiber und OS Kompatibiltät checken.

Desktop Motherboards arbeiten normalerweise problemlos mit den Karten zusammen.

Infiniband Kabel:

Leider ist die Kabellänge auf 15 Meter begrenzt, ausserdem sind sie teuer.

Am billigsten scheinen sie über ebay in den USA zu haben zu sein.

Die Anschlüsse entsprechen dem SFF8470 Standard, auch CX4 genannt:

Die Stecker können nicht einfach wie bei RJ45 gecripmt werden.

Diese Kabel werden teilweise auch für 10 GbE und Serial Attached SCSI (SAS) benutzt.

Achtet darauf, dass es sich um Stecker mit Laschenbefestigung handelt nicht um solche mit Schraubbefestigung.

Es gibt auch Glasfaser-Konverter für diese Anschlüsse, die sind aber kaum bis gar nicht verfügbar.

Ein SDR Infiniband Kanal erreicht 2,5 Gbit/s Signalrate. Wie viele andere aktuellen Interfaces (z.B. SATA) wird ein 8B/10B Code verwendet. Das heisst, dass von zehn übertragenen Bits acht Bits Nutzdaten sind. Mit anderen Worten, der konzeptionell bedingte Overhead beträgt 20%.

Diese Rechnung beinhaltet noch nicht den zusätzlichen Overhead durch andere Protokolle, die man über IB nutzt. In unserem Fall zumindest TCP/IP, zusätzlich vielleicht noch FTP usw.

Neben SDR ist auch DDR (5 Gbit/s Signalrate pro Kanal) und QDR (10 GBit/s Signalrate pro Kanal) spezifiziert, die auch alle einen 8B/10B Code nutzen. Entsprechende Hardware ist auch noch zu akzeptablen Preisen zu bekommen.

Darüber hinaus ist noch FDR und EDR spezifiziert, die mit einem 64B/66B Code den Overhead massiv verkleinern, auf die wird hier jedoch erstmal nicht weiter eingegangen auf Grund mangelnder Verfügbarkeit.

Man kann auch davon ausgehen, dass SDR, DDR und QDR im Heimbereich noch lange ausreichen wird.

In auf dem Markt erhältlicher, gängiger IB Hardware werden immer mindestens vier Kanale gebündelt.

Das ergeben sich folgende, effektive Signalraten:

SDR: 10 GBit/s

DDR: 20 GBit/s

QDR: 40 Gbit/s

Bedenkt, dass davon mindestens 20% für Overhead draufgehen werden!

Software:

IP over Infiniband (IPoIB) ist das Stichwort, wenn man normale Netzwerkanwendungen darüber laufen lassen möchte.

Dabei ist darauf zu achten, dass die Karten IP Offloading unterstützen, denn sonst ist mit hoher CPU last zu rechnen.

Für iSCSI gibt es RDMA, welches die Daten direkt zwischen den Hauptspeichern der beteiligten PCs ohne CPU Beteiligung transferiert.

Das funktioniert, soweit ich weiß, nur unter Linux/Solaris vernünftig.

Schlingel_INV hat ein wunderbares "How To" zur Einrichtung einer Infiniband Verbindung verfasst:

>>Infiniband How To<<

Standard #2: 10 Gbit Ethernet

Planung und Aufbau:

Da die Retailpreise sich einfach nicht bewegen wollen kommt nur ein Gebrauchtkauf in Frage.

Switche mit 10 Gbit sind unverhältnismässig teuer.

Daher wird der Heimanwender auf eine Punkt zu Punkt Verkabelung setzen.

Günstigerweise sind die meisten Karten, die verkauft werden, Dualport Karten.

Das vereinfacht die Sache! Man baut einfach eine Netzwerkbrücke über diese beiden Ports. Damit lassen sich Theoretisch unbegrenzt viele PCs vernetzen, leider teilen sich diese auch die Bandbreite.

Das normale Heimnetz für Internet usw. bleibt natürlich physikalisch getrennt!

Die Verschiedenen Anschlüssen und Standards:

Glasfaser:

Transceiver:

Die Transceiver sind Module, die in die Karten gesteckt werden.

Es gibt SFP+ (klein), XFP (mittelgroß) und XENPAK (riesig)

Die tun im Allgemeinen das gleiche, nämlich elektrische Signale in optische wandeln. Die Großen verbrauchen aber mehr Strom und benötigen mehr Kühlung.

SFP+ ist das aktuellste Format.

Tranceiver sind im Allgemeinen nicht billig und man sollte besser nach Karten MIT Transceivern Ausschau halten. Damit ist garantiert, dass diese auch zusammen funktionieren.

Manche Kartenhersteller lassen nur Transceiver von einem bestimmten Hersteller zu!

Die mechnischen Stecker sind in allen Fällen vom Typ LC.

Lichtwellenleiter (LWL):

Oft auch Glasfaserkabel genannt, häufig findet man auch die falsche Bezeichnung FibreChannel-Kabel! Sehr billig gebraucht zu haben, auch neu noch problemlos erschwinglich. Preise werden weiter unten noch genau behandelt.

Für LWL gibt es gewisse Kenngrößen, die über Eigenschaften und Qualität Auskunft geben. Grundsätzlich unterscheidet man Multimode- und Singlemodefasern.

Üblicherweise sind Multimode-LWL orange, Singlemode-LWL sind gelb. Wir befassen und hauptsächlich mit Multimode-LWL, die für kurze und mittlere Übertragungslängen gedacht sind. Das sind immer noch mehrere 100 Meter, für den üblichen Heimgebrauch also ausreichend.

Außerdem unterscheidet mal die Faserkategorie, bei Multimode-LWL sind das die Kategorien OM1, OM2, OM3 und OM4. OM1 und 2 sind dabei hauptsächlich zur Anwendung mit LEDs als Lichtquelle gedacht, was früher häufig der Fall war. Damit war 10 Gbit/s technisch unmöglich, weswegen nun hauptsächlich Laser eingesetzt werden, wofür man OM3 oder 4 benötigt. Daher beim Kauf darauf achten, dass die LWL mindestens der Kategorie OM3 entsprechen!

Dritte und letzte Kenngröße sind die Durchmesser des Kerns und des Mantels der LWL. Dabei handelt es sich um die beiden inneren Schichten eines LWL, die dritte ist eine Schutzbeschichtung und die vierte die äußere Hülle.

Relevant sind jedoch nur Kern und Mantel.

Gängig sind 50 µm für den Kern und 125 µm für den Mantel, meist einfach als 50/125 erwähnt. In Kombination mit Kategorie OM3 und LC Steckern wird man auch nicht viel andere finden, trotzdem sollte man eben genau darauf achten. Man weiß ja nie.

Die Steckertypen sind für gewöhnlich im Produktnamen mit erwähnt und für beide Seiten des Kabels angegeben. Für Kabel mit LC Steckern an beiden Seiten, die wir ja haben wollen, wäre das meist LC-LC oder LC/LC.

Gesucht für unsere Zwecke sind also LWL mit LC-LC, OM3 und 50/125 µm!

Kostenpunkt für gängige Längen im Heimbereich liegen z.B. bei 6 bis 8 Euro für 0,5 bis 3,0 Meter. 10 Meter gibts für ca. 15 Euro, 20 Meter für ca. 25 Euro.

Glasfaserkabel sind empfindlicher als Kupferkabel, aber trotzdem sollte einen das nicht davon abhalten welche zu verlegen.

Sie sind dünner und teilweise flexibler als Kupferkabel, man muss aber gut auf die Biegeradien achten.

Optisch:

10Gbase-SR:

Meistverbreitete Art bei optischen Transceivern. Läuft über Multimode Kabel mit LC Verbindern.

Distanz: 300 Meter über 50 µm Multimode Kabel

10Gbase-LR:

Erfordert Singlemode Kabel, die sind nur bedingt teurer als Multimode Kabel.

Die SFPs für diesen Standard sind billig, aber nicht immer kompatibel.

Distanz: 10 Kilometer über Singlemode Fiber

Kupfer:

10Gbase-CX4:

Billig zu finden, recht verbreitet. Limitierung auf 15 Meter Kabellänge.

Verwendet die gleichen Kabel wie Infiniband.

Distanz: 15 Meter

10Gbase-T:

SEHR selten zu finden, ist der standard der über CAT6 und CAT7 Kabel mit RJ45 Steckern läuft.

Soll aber viel Strom brauchen und weniger zuverlässig sein als die optischen Alternativen.

Distanz: 100 Meter

SFP+ CU:

Der neueste Standard für Kurzstreckenverbindungen mit Kupferkabeln.

Es handelt sich um Kupferkabel mit SFP+ Modulen an den Enden.

Es gibt aktive und passive Kabel. Die passiven funktionieren bis etwa 7 Meter.

Aktive erreichen 15-20 Meter.

Preise fangen bei ca. 30 Euro für 3 Meter an.

Nicht alle Karten mit SFP+ Slots supporten SPF+ CU Verbindungen und nicht alle Hersteller supporten offiziell die maximale Kabellänge!

Distanz: 7-20 Meter

Jumbo Frames:

Es ist bei 10 Gbit/s SEHR vorteilhaft mit Jumboframes zu arbeiten.

Grund: 10 Gbit/s bei 1500 Byte pro Paket macht gigantisch viele Pakete in der Sekunde!

Diese verursachen beim Eintreffen Interrupts, die können aber nicht auf mehrere Kerne verteilt werden und daher flooden sie einen Kern bis er "voll" ist. Dann ist die maximale Datenrate für 1500er Frames erreicht.

Bei meinen Benches ist das irgendwann bei 300-400 MByte/s der Fall.

Mit 9000 Byte Jumboframes wird die Interruptrate deutlich reduziert, weil die

Anzahl der Pakete um den Faktor 6 zurückgegangen ist.

Karten:

Nun kommen wir zu den Karten, die mir so über den Weg laufen/gelaufen sind:

Im Allgemeinen werden 10 Gbit/s Dualport CNA's aus neuen Servern ausgebaut, weil sie nicht verwendet werden.

Das sorgt für gute Preise und Verfügbarkeit.

Bei eBay werden CNAs häufig als 10 GB Fibre Channel oder FCOE Adapter oder ähnlich bezeichnet.

Es handelt sich dabei in 99% der Fälle um eine Karte die auch Ethernet kann. Man findet jedoch auch reine 10 GbE netzwerkkarten/NICs.

Die Information habe ich in mühsamer Kleinarbeit aus den Tiefen der Datenblätter und Handbücher zusammengeklaubt, basieren teilweise aber auch auf eigenen Erfahrungen mit den Adaptern (erster Teil der Auflistung).

Intel Pro/10GBE XF SR

Sehr gute 10 Gbit/s Karte von Intel, auch wenn inzwischen ein neuerer Chip draussen ist.

Basiert auf dem 82598EB Controller - 6.5W TDP, PCI-E 2.0 x8.

Externe SER/DES.

16 Virtuelle Cues VMDq (Vorteilhaft unter VMWARE)

Transceiver: XFP

Preis: ~220 Euro mit XFPs

Betriebsystemunterstützung: Windows, Linux, Solaris, BSD, ESX(I), MACOS

Pro: Guter Support, Treiberunterstüzung, VMDq

Kontra: Preis, XFP Tranceiver

Brocade BR1020

Ein sogenannter Converged Network Adapter/CNA.

Unterstützt FCOE in Hardware.

Singlechip Lösung mit integrierten SER/DES, 8.5W TDP, PCI-E 2.0 x8.

Achtung: Braucht zwingend elektrisch 8 Lanes!

OEM PNs: IBM: 42C1820

Transceiver: SFP+

Preis: 170 Euro mit SFPs

Warnung: benötigen Brocade SFP's!

Betriebsystemunterstützung: Windows, Linux, Solaris (keine Jumboframes), ESX(I)

Pro: Preis

Kontra: Kein!! Support, SFP Kompatibilität, Treiber

Emulex One Connect OCe11102

Ein "Unified Wire" Adapter, der FCOE und iSCSI beherrscht.

Singlechip Lösung mit externen SER/DES, PCI-E 2.0 x8 (Mechanisch x9-> x16 Port erforderlich).

Unterstützt Stateless Offload und iSCSI Offload (je nach Lizenz).

OEM PN: IBM:49Y4201 FRU: 49Y4202

Transceiver: SFP+

Preis: ~160 Euro

Betriebsystemunterstüzung: Windows, Linux, Solaris (nur mit Supportvertrag downloadbar), ESX(I)

Pro: Preis, iSCSI und FCOE Support, SFP Kompatibilität

Kontra: bei OEM Karten möglicherweise kein iSCSI

Achtung: Bei den Karten von IBM müssen auf der Rückseite die letzten vier Kontakte der PCI-E Kontaktleiste abgeklebt werden! Erklärung mit Bild in Post 255.

Chelsio S320E-CR

Chelsio Karten sind die wahren KILLER Netzwerkkarten.

Sie haben eine TCP Offload Engine. Das bedeutet, dass das komplette TCP/IP in der Netzwerkkarte läuft. Ausserdem wird iSCSI in Hardware unterstützt.

Multichip Lösung, 20W TDP, PCI-E 1.0 x8.

Wegen des hohen Stromverbrauchs ist die Karte vermutlich eher nichts für den 24/7 Homeserver.

Es gibt noch die N320E / N310E Karten, diese haben keine TOE und kein iSCSI!

Transceiver: XFP, SFP+

Preis: ~220 Euro

Betriebsystemunterstüzung: Windows, Linux, Solaris, BSD, ESX(i), MAC-OS

Pro: Performance, CPU-Last, iSCSI-Offload

Kontra: Preis, PCIe 1.0, Stromverbauch

Karten, die ich noch nicht persönlich in den Fingern hatte:

------------------------------------------------------

Qlogic QLE8142:

Dualport Converged Network Adapter

Kann Hardware FCOE, Singlechip Lösung, 7.4W TDP, PCI-E x8.

Transceiver: SFP+

Preis: ~170 Euro

Warnung: Die optischen Versionen benötigen Qlogic SFP's!

Betriebsystemunterstüzung: Windows, Linux, Solaris, BSD, ESX(i)

QLogic QLE 3242:

Dualport Intelligent Network Adapter.

Kann hardware FCOE, externe SER/DES, 7.4W TDP, PCI-E x8.

Varianten:

QLE3242-CU - SFP Kupferkabel

QLE3242-SR - Optisch Shortrange

QLE3242-LR - Optisch Longrange

QLE3240-CU - SFP Kupferkabel Singleport

QLE3240-SR - Optisch Shortrange Singleport

QLE3240-LR - Optisch Longrange Singleport

Transceiver: SFP+

Preis: ~170 Euro

Warnung: Die optischen Versionen benötigen Qlogic SFP's!

Besonderheiten: Kann 4 virtuelle NICs für VMWARE/HYPER-V erzeugen

Betriebsystemunterstüzung: Windows, Linux, Solaris, BSD, ESX(i)

INTEL E10G41AT2

Ein Vertreter der seltenen 10GBase-T Familie, 15.4W TDP!

Preis: ~400 Euro NEU!

Betriebsystemunterstüzung: Windows, Linux, Solaris, BSD, ESX(i), MACOS

Pro: VMDq, Treiber, Support, Kupferkabel

Kontra: Singleport, Stromverbrauch

HP NC524SFP

WARNUNG: Diese Karte ist nur eine Interface Karte.

Das bedeutet sie funktioniert nur auf in Kombination mit einer HP Riserkarte NC375i.

Preis: 250 Euro NEU!

Betriebsystemunterstüzung: kA

Switche:

Wie schon am Anfang geschrieben sind diese SEHR teuer:

Es gibt Switches mit 12-48 Gigabit Ports und 1-4 10 Gbit/s Uplink Ports.

Die modernen haben feste 10 GBit/s Uplink Ports (2-4), wo man dann einfach ein 10 GBit/s SFP+ Modul reinsteckt.

Hersteller schließen manchmal "fremd"-SFPs per Software aus!

Ältere haben ein oder zwei Erweiterungschächte, wo man ein Stacking Modul oder ein 10 GBit/s Modul einbauen kann.

In das Stacking Modul steckt man dann einen XFP oder Xenpak Transceiver.

Es gibt aber auch noch CX4 Module, die man natürlich nicht wirklich brauchen kann.

ACHTUNG: Ältere Switche schaffen über diese Modulports manchmal nicht die vollen 10 GBit/s!

Modelle:

3Com SC4200

12-48 Port Gbit Switch, kann mit 1-2 10 GBit/s Modulen aufgerüstet werden Transceiver: XFP

Foundry BigIron Core Switches

Diese wurden mir von TEGO3 nahegelegt.

Sind recht günstig in der Bucht zu haben und lassen sich mit 10Gbit Ports ausrüsten.

Die schlagen dann aber auch mit 400-500Eur zu Buche.

OEM Versionen sind z.B. der HP Procurve 9304 (9308).

Achten sollte man darauf die Richtigen Netzteile und eine Management Karte zu haben.

Linkliste:

Wikipedia Artikel über 10 GbE

Wikipedia Artikel über Infiniband

Vielen Dank an DunklerRabe für die Überarbeitung dieses Startbeitrags

[Changelog]

Stand: 16.11.2011

16.11.2011

+ DunklerRabe's Überarbeitete Version übernommen

05.11.2011:

+Schlingels How To eingefügt

29.10.2011:

+Layout geändert

+Infiniband Sektion eingeführt

07.07.2011:

+Qlogic QLE3242

+Update QLE82

+SFP+ Kupfer Kabel

22.07.2011:

+Infiniband überarbeitet

+Bilder eingefügt

+Linkliste angefügt

+ DunklerRabe's Überarbeitete Version übernommen

05.11.2011:

+Schlingels How To eingefügt

29.10.2011:

+Layout geändert

+Infiniband Sektion eingeführt

07.07.2011:

+Qlogic QLE3242

+Update QLE82

+SFP+ Kupfer Kabel

22.07.2011:

+Infiniband überarbeitet

+Bilder eingefügt

+Linkliste angefügt

Zuletzt bearbeitet: