Du bringst immer eine 6800 XT als Beispiel. Die hast du aber nicht. Eine XT ist noch mal um ~15-20 % schneller als eine normale 6800.

Hast evtl meinen Post nicht verstanden.

Ich erwähnte ja den Preis der 6800XT.

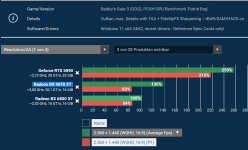

Und im Anhang 2 Bilder mit FPS vergleichen zwischen 6800XT und RX9070XT.

Und die daraus kalkulierende Preis Leistung gegenüber einer RX9070XT ist besser bei dem von mir erwähnten RX6800XT Preis von vor 2 Jahren.

Ich brachte meine normale RX6800 nicht als Bild Beispiel, weil PCGH die nicht mit getestet hat. Aber auch die RX6800 welche teilweise Neu für 330€ weg gingen, waren Mega Preis Leistung auf höchstem Niveau.

Das du jetzt auf einmal von deiner RTX 4090 und deinen 4K sprichst, um meine Karte schwach zu reden, erscheint mir eher wie Langeweile deinerseits.

Deine Karte ist Preis Leistung schlechter, um nicht zu sagen letzter Platz. Meine Karte mit das beste. Mir gings nur um Preis Leistung. Das ist alles.

Für mich Persönlich sind RTX 4090 Käufer wirklich die am wenigsten Intelligenten.

Für das Geld hätte ich mir 30 Jahre Mittelklasse Radeons kaufen können.

So sieht meine History die letzten 15 Jahre zumindest aus.

2011 HD6870 129€ Mindfactory

2016 Polaris 199€ Mindfactory

Dann zuletzt die RX6800 350€ Mindfactory

Macht 678€ von 2011 bis heute.

Und meine Karte wird noch Jahre genutzt.

Wird wohl erst 2028 durch die AT3 Mittelklasse ersetzt welche so viel kosten sollte wie eine RX9060XT 16GB heute (also ca 350€)

Und die Karte werde ich dann wieder mindestens 5 Jahre nutzen.

Wären dann 1000€ von 2011 bis 2033. Also über 22 Jahre und nur die hälfte des Geldes einer RTX 4090/5090 bezahlt.

Daher halte ich die Nvidia Kunden für weniger Intelligent.

PS: Ich Spiele zwar nicht in 4K. Aber 3440x1440 ist auch schön. Und da gibt es etwas, das nennt sich Optimierung.

Details mal von Ultra auf High runterschrauben. Frame Gen. Ich Spiele mit Star Citizen eines der Anspruchsvollsten Spiele würde ich sagen, und meine GPU reicht.

Ich habe sie sogar auf 150W gedrosselt (400mhz weniger Takt) weil die Leistung genug ist.

Wenn ich eines Tages mehr Leistung brauche, lasse ich die Karte für das Spiel dann einfach mal im Standard Takt laufen.

der Preis wird nur nicht auf GH ausgewiesen.

der Preis wird nur nicht auf GH ausgewiesen.