Induktor

Enthusiast

- Mitglied seit

- 03.11.2019

- Beiträge

- 3.544

- Laptop

- Lenovo Yoga Pro 7i - Intel-7 255H - 32GB LPDDR5x-8533 - 14,5" OLED (3000*1876) 120Hz - Samsung 990 Pro 2TB

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen-7 9800X3D (CO: +0/ -38)

- Mainboard

- MSI X870E Carbon Wifi (A7E)

- Kühler

- Arctic LF III 280 & 2x Toughfan 14 Pro + Noctua NA-IS1-14

- Speicher

- 32GB - 6200 MT/s (CL26-12-36-30 - tRFC 120ns)

- Grafikprozessor

- Gigabyte RTX 5080 Gaming OC (Shroud-Mod 3x T30)

- Display

- Alienware AW2725DF (OLED 360Hz)

- SSD

- Samsung 990 Pro & 990 Evo+

- Gehäuse

- Open Benchtable V2 (vertikal)

- Netzteil

- Corsair AX850 (Titanium)

- Sonstiges

- Thermal Grizzly AM5 Frame

Ich habe gestern Abend noch mal eine kleine Bench-Session gemacht und einiges ausgetestet. Erstmal flog der aktuelle Radeon Treiber (21.4.1) runter und wurde auf die Version 21.3.1 aktualisiert. Dieser hat sich zumindest in 3D-Mark als stabil und brauchbar erwiesen. Mit 21.4.1 hatte ich massive Probleme in Timespy und Firestrike. Port Royal lief noch einigermaßen gut durch. Dann habe ich mich wieder erneut am MPT versucht und glücklicherweise diesmal mit etwas mehr Erfolg. Folgendes Setting habe ich bei den Benchmarks benutzt:

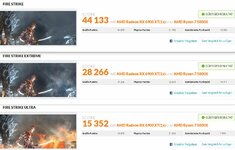

Die Ergebnisse sind wie folgt ausgefallen:

Keine Ahnung wie gut oder schlecht das Ergebnis jetzt insgesamt ist, aber ich habe mich doch schon stark gewundert wie einige hier ihre 6900XT unterhalb von 1100v durch den Benchmark prügeln können. Ich hatte alle möglichen Einstellungen ausprobiert, aber stabil waren nur die oben in der Tabelle. Vielleicht muss ich noch an anderen Stellschrauben drehen, weiß nicht. Immerhin weiß ich jetzt, dass der 21.4.1 Treiber für 3D-Mark nichts taugt.

Die Ergebnisse sind wie folgt ausgefallen:

Keine Ahnung wie gut oder schlecht das Ergebnis jetzt insgesamt ist, aber ich habe mich doch schon stark gewundert wie einige hier ihre 6900XT unterhalb von 1100v durch den Benchmark prügeln können. Ich hatte alle möglichen Einstellungen ausprobiert, aber stabil waren nur die oben in der Tabelle. Vielleicht muss ich noch an anderen Stellschrauben drehen, weiß nicht. Immerhin weiß ich jetzt, dass der 21.4.1 Treiber für 3D-Mark nichts taugt.

)

)