Werbung

Bis Anfang diesen Jahres fuhr Intel zweigleisig, wenn es um dedizierte Hardware für das Inferencing und Training von Deep-Learning-Netzwerken ging. Aber der Chipgigant hat Nervana aufs Abstellgleis geschickt und sich für Habana Labs entschieden. Die hier bereits begonnen Entwicklung von Hard- und Software soll in den kommenden Jahren den Pfad zu dedizierten AI-Beschleunigern ebnen.

Mit den genaueren Details zum Goya-Chip für das Inferencing und dem Gaudi-Chip für das Training von Deep-Learning-Netzwerken haben wir uns schon beschäftigt. Die Goya-Chips werden inzwischen ausgeliefert, für Gaudi spricht Habana Labs noch immer von einem Sampling. Die Fertigung beider Chips findet bei TSMC in 16 nm statt. Über zukünftige Produkte spricht man zum aktuellen Zeitpunkt noch nicht.

In einem Video aus dem Dezember des vergangenen Jahres erläutert Eran Dagan, Product Marketing bei Habana Labs, die Skalierung des Gaudi-Chips, was vor allem über die Netzwerkanbindung gelingen soll. Doch zunächst ein paar grundsätzliche Informationen zu den Chips:

Gaudi und Goya setzen auf spezielle Tensor Processing Cores (TPCs), die wie die Tensor-Cores von NVIDIA Vektor- bzw. Matrixberechnungen ausführen können und dabei gegebenenfalls geringere Genauigkeit wie INT4- und INT8-Berechnungen sowie geringere Komplexität wie durch Bflout16 setzen.

Für Gaudi sind 32 GB an schnellem HBM2 verbaut. Goya kommt mit DDR4-Speicher und einem 128 Bit breiten Speicherinterface aus. Der Gaudi-Chip bietet zudem ein On-Die 100-GbE-Fabric mit der Unterstützung von RDMA über Converged Ethernet (ROCE). Damit lässt sich die Hardware per Mellanox NIC in einen Datacenter-Interconnect einbinden und die Lösung skaliert für mehrere tausend Nodes.

Die Netzwerkanbindung im Detail

Der Gaudi-Chip wird in zwei unterschiedlichen Hardware-Varianten angeboten werden. Die HL-205 Mezzaine Card (ähnlich wie ein NVIDIA SMX2-Modul aufgebaut), darf sich bis zu 300 W genehmigen und bietet 10x 100-GBit/s- oder 20x 50-GBit/s-Netzwerkinterconnects an. Zusammengenommen sprechen wir also von 1 TBit/s an Netzwerkbandbreite.

Die HL-200/202 PCI-Express-Karte kommt etwas abgespeckter daher und bietet 8x 100-GBit/s- oder 16x 50-GBit/s-Netzwerkinterconnects – zusammengenommen also 800 GBit/s. Dies klingt nach extrem viel Netzwerkbandbreite für einen AI-Chip. Eine V100-GPU von Tesla bietet keine direkte Netzwerkschnittstelle. Stattdessen werden die GPU-Beschleuniger per PCI-Express oder NVLink an das restliche System angebunden. Im Falle von NVIDIA kann dies innerhalb eines Rechenknotens mit NVLink geschehen, darüber hinaus aber kommen Netzwerk-Adapter von Mellanox zum Einsatz. Nicht ohne Grund hat sich NVIDIA Mellanox einverleibt. Diesen Umweg, der zusätzliche Komplexität und Latenzen und damit Engpässe hinzufügt, umgeht Habana Labs mit einer direkten Integration.

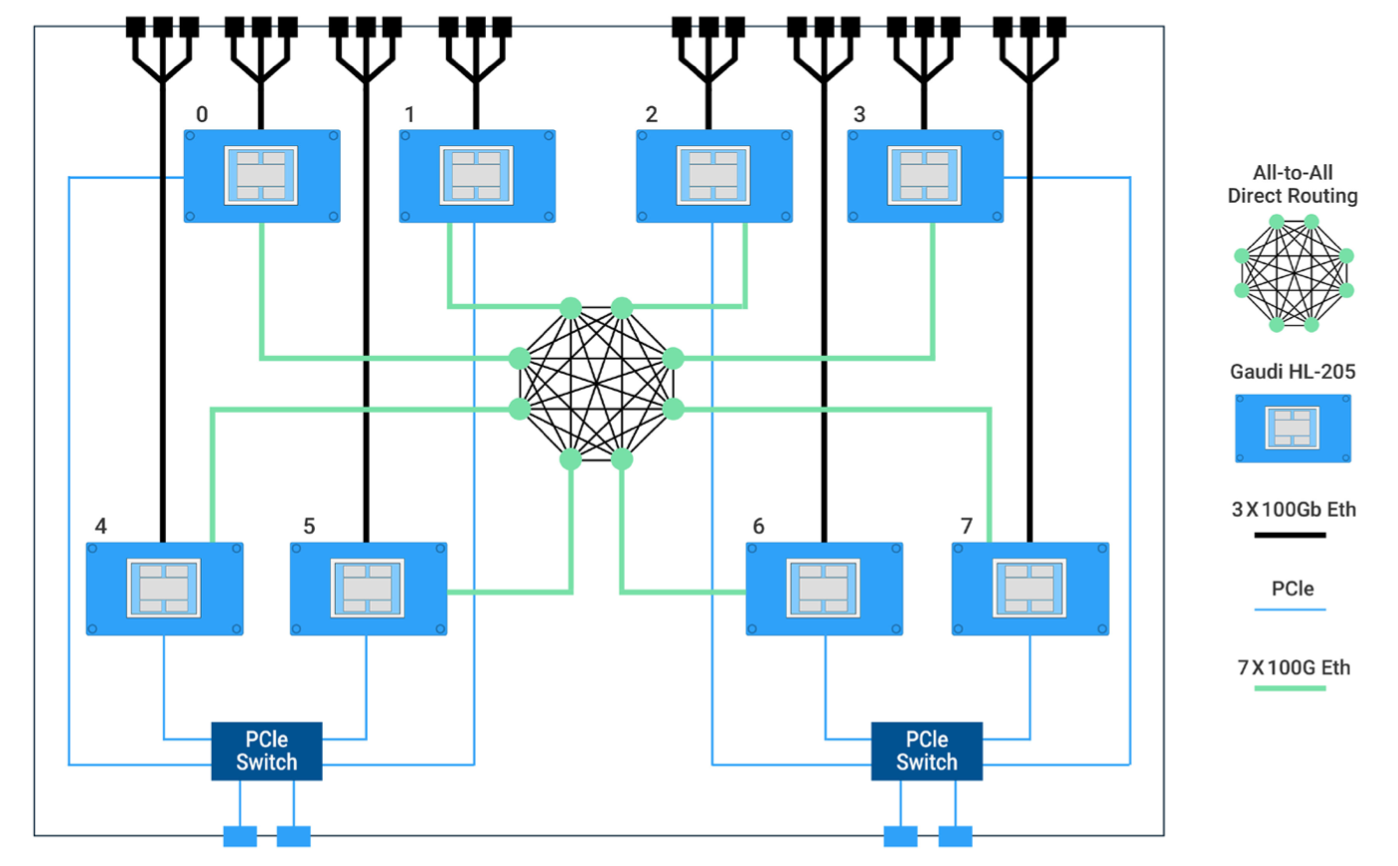

Wie man bei Habana Labs diese Netzwerkverbindungen nutzt, zeigt sich im Habana Labs System-1 (HLS-1). Das HLS-1 besteht aus acht HL-205 OAM-Modulen und zwei PCI-Express-Swichtes.

Im HLS-1 sind alle acht Gaudi-Module direkt miteinander verbunden. Dazu verwendet Habana Labs ein All-to-All Direct-Rounting auf PCB-Ebene. Alle acht Gaudi-Module sind also per 100GbE direkt miteinander verbunden. Die verbleibenden drei Ports pro Gaudi-Modul werden über Ethernet-Ports dazu verwendet, eine Außenanbindung sicherzustellen.

Es handelt sich bei der eben beschriebenen Lösung um die einfache System-Topologie für ein singuläres System. Wenn mehrere HLS-1 verwendet werden sollen, bietet Habana Labs anderen Lösungen an. So gibt es ein Gaudi-System mit einem On-Board Ethernet-Switch. Hier werden 7x 100GbE von jedem Gaudi-Modul an den Switch geliefert. Dieser Switch nimmt 64x 100GbE-Verbindungen entgegen. 8x 100GbE stehen zur Außenanbindung zur Verfügung.

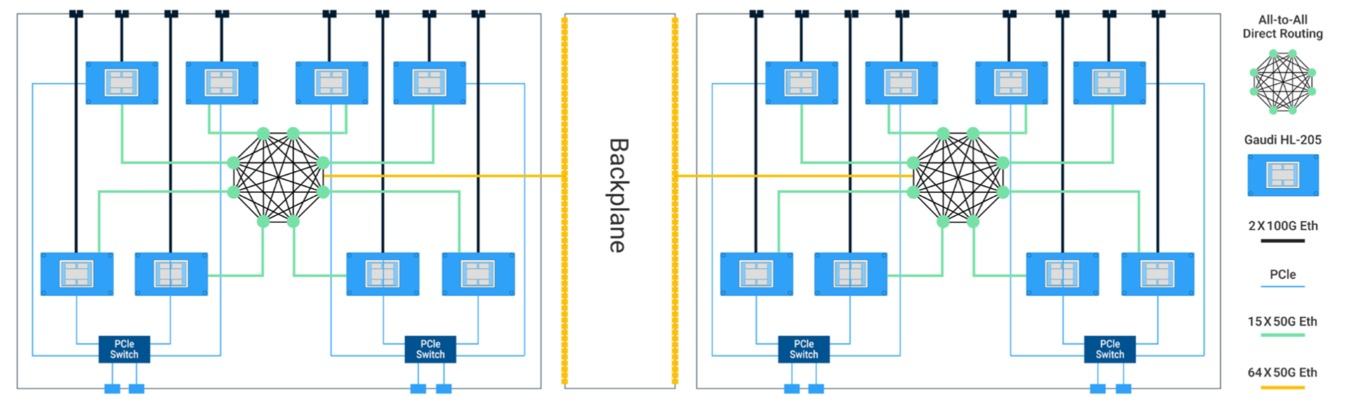

In der Hyper-Cube Mesh-System-Topologie wiederum gibt es wieder direkte Verbindungen zwischen den Gaudi-Modulen, aber in reduzierter Form. Eine möglichst schnelle Anbindung der HLS-1-Systeme untereinander ist ebenso wichtig, wie eine schnelle interne Kommunikation. Daher spricht Habana Labs hier eben von einem Mesh-System, welches einen hybriden Ansatz mit umfasst.

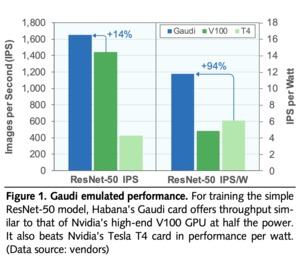

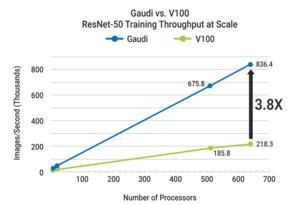

Je mehr HLS-1-Systeme zusammengefasst werden sollen, desto komplexer wird die Netzwerkinfrastruktur. HLS-1-Systeme werden mit 1,6 TBit/s untereinander angebunden – ein DGX-2-System von NVIDIA kommt auf die Hälfte an Netzwerkbandbreite. Die hohe Bandbreite ist dafür verantwortlich, dass die Leistung für das Training deutlich über dem liegt, was die Konkurrenz bieten kann. Auf die Leistungsaufnahme normiert will Habana Labs fast doppelt so schnell sein.

Die Netzwerkinfrastruktur ist ein wichtiger Punkt, die dazugehörige Software ein anderer. Habana Labs verwendet das Netzwerkprotokoll RDMA over Converged Ethernet (RoCE). Dazu werden InfiniBand-Transportpakete über Ethernet übertragen. Über verschiedenen Maßnahmen soll RoCE v2 vor allem hinsichtlich der Latenzen verbessert werden. Diese spielen in Infrastrukturen wie der für die HLS-1-Systeme eine wichtige Rolle. Auch die gegenseitigen Zugriffe auf den Speicher über das Netzwerk werden mit RoCE v2 deutlich verbessert.

Derzeit ist nicht bekannt, wann der Gaudi-Chip und die dazugehörigen Module ihre Sample-Status verlassen werden und Habana Labs die Hardware den zahlenden Kunden zur Verfügung stellt. Intel aber setzt auf die aktuelle und zukünftige Entwicklung bei Habana Labs und so werden wir sicherlich auch noch nach Goya und Gaudi Neuigkeiten aus Israel hören.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen