Werbung

Im Rahmen der Hotchips stellte ein Unternehmen namens Cerebras eine sogenannte Wafer Scale Engine (WSE) vor. Dabei handelt es sich um einen Chip, der aus mehreren Komponenten auf dem Wafer zusammengesetzt wird, aber als Gesamtkonstrukt auf dem Wafer gefertigt wird. Es handelt sich also nicht um ein Chiplet-Design im eigentlichen Sinne. WikiChip hat eine aktualisierte Analyse der WSE vorgenommen. Zur Supercomputing 19 soll es weitere Ankündigungen geben.

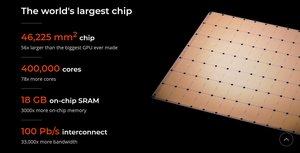

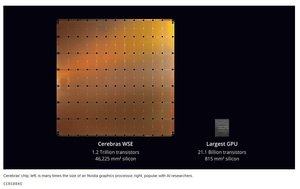

Aus der Zusammenarbeit mit TSMC entstanden ist dabei ein Chip, der die maximale Fläche für ein Rechteck aus einer 300-mm-Wafer herausholt. Ein Chip mit einer Fläche von 46.225 mm² – 215 x 215 mm. Eigentlich passt ein solcher gar nicht auf einen Wafer mit einem Durchmesser von 300 mm. Cerebras hat die Ecken einfach abgerundet, um dennoch eine solche Fläche nutzen zu können.

Auf dem Chip befinden sich 84 identische Dies, zwölf in der Horizontalen und sieben in der Vertikalen. Die einzelnen Dies haben eine Fläche von 507,9 mm². Mit diesem Verfahren umgeht Cerebras die aktuellen Limitierungen in der Größe eines einzelnen Chips. Diese liegt mit den neusten Tools und Masken bei 26 x 33 mm bzw. 858 mm² unter Verwendung des EUV-Verfahrens. Jeder der einzelnen Chips besitzt etwa 4.774 AI-Kerne. Bei 84 Dies kommen wir also auf knapp über 400.000 AI-Kerne.

Aus diesen Zahlen ergeben sich auch die Vergleiche, die Cerebras zur Hotchips anführte. Verglichen wird eine WSE gegen eine GV100-GPU von NVIDIA, die es auf 815 mm² bringt und 5.120 Shadereinheiten und 640 Tensor Cores besitzt. Ein weiterer Vergleich zielt auf den Speicher ab. Eine GV100-GPU bindet 32 GB an HBM2 über ein Speicherinterface mit 900 GB/s an. Die WSE hat keinen externen Speicher und verwendet stattdessen 18 GB an SRAM. Dieser wird von den AI-Kernen mit 9 PB/s angesprochen, was natürlich ein Vielfaches gegenüber einer externen Anbindung ist. Der Fabric spielt ebenfalls eine Rolle. Mittels NVLink erreicht NVIDIA 300 GBit/s zwischen den GV100-GPUs. Der Fabric auf dem WSE ist mit 100 PBit/s ebenfalls um ein Vielfaches schneller.

Fabric und Packaging

Die Fertigung eines Chips in der Größe eines Wafers hat natürlich Herausforderungen hinsichtlich der Ausbeute. Gefertigt wird der Chip von TSMC in 16 nm (16FF+). Es handelt sich also um eine ausgereifte Fertigung, bei der es möglichst wenig Fehler geben sollte. Bei dieser Größe kann es natürlich dennoch zu Fehlern kommen. Cerebras lässt 1,0 bis 1,5 % an zusätzlichen AI-Kernen fertigen. Kommt es also zu Fehlern in der Fertigung, hat man eben diese 1,0 bis 1,5 % als Sicherheit auf dem Chip.

Wie und wo genau diese zusätzlichen Kerne untergebracht sind, ist das große Geheimnis von Cerebras. Fällt einer der Kerne aus, wird der ebenfalls redundant vorhandene Fabric umgeleitet, um den defekten Kern auszusparen und einen der zusätzlichen Kerne zu verwenden.

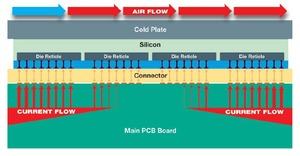

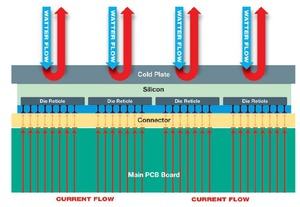

Neben der Fertigung ist die Stromversorgung und Kühlung eine Herausforderung. Eine spezielle Sandwich-Schicht zwischen dem Wafer und dem PCB soll die unterschiedlichen Ausdehnungskoeffizenten abfangen.

Im PCB befinden sich die Leiterbahnen für die Stromversorgung. Alleine aufgrund der Größe des Chips ist die Versorgung eine echte Herausforderung. Anstatt eines horizontalen Ansatzes befindet sich die Stromversorgung ebenfalls in einem horizontalen Aufbau im PCB. Dies alles muss im Packaging bedacht werden. Die Versorgung eines solchen Chips dürfte im Bereich von mehreren hundert Watt, wenn nicht sogar im Kilowatt-Bereich liegen.

Gleiches gilt für die Kühlung. Derzeit kennen wir noch keine konkreten Zahlen zur Abwärme eines WSE. Es kann jedoch von mehreren hundert Watt ausgegangen werden. Sogar 1 kW wären denkbar (analog zur Stromversorgung, denn nahezu jegliche Energie, die man in den Chip steckt, kommt am Ende als Abwärme heraus) und diese Abwärme muss natürlich abgeführt werden. Cerebras geht daher von einer Wasserkühlung des Chips aus.

Weitere Details in Kürze

Zur Supercomputing 19 will Cerebras Details zu einem Konkreten Produkt mit der WSE veröffentlichen. Ein einzelner Chip soll in eine Rack mit 15U verbaut sein. Dementsprechend muss sich ein solches System mit einem NVIDIA DGX-2 vergleichen. Dieser hat 10U. Darin verbaut sind 16 Tesla V100. Die weiteren Komponenten sind zwei Intel Xeon Platinum, 8x EDR IB/100 GbE, 1,5 TB Arbeitsspeicher, 30 TB an NVMe-SSDs und eine Stromversorgung von 10.000 W. Der Preis der DGX-2 liegt bei 399.999 US-Dollar.

Alles, was die WSE an weiteren Komponenten umgibt, ist derzeit noch unbekannt. Zur Supercomputing 19 soll es jedoch noch weitere Informationen geben.