Werbung

Derzeit findet in den USA die Hotchips-Konferenz statt. Auf dieser stellen die Hersteller ihre Neuerungen im Bereich der Chipentwicklung vor – darunter auch AMD, Intel, NVIDIA und viele mehr. Deren Präsentationen werden aber erst in den kommenden Tagen folgen.

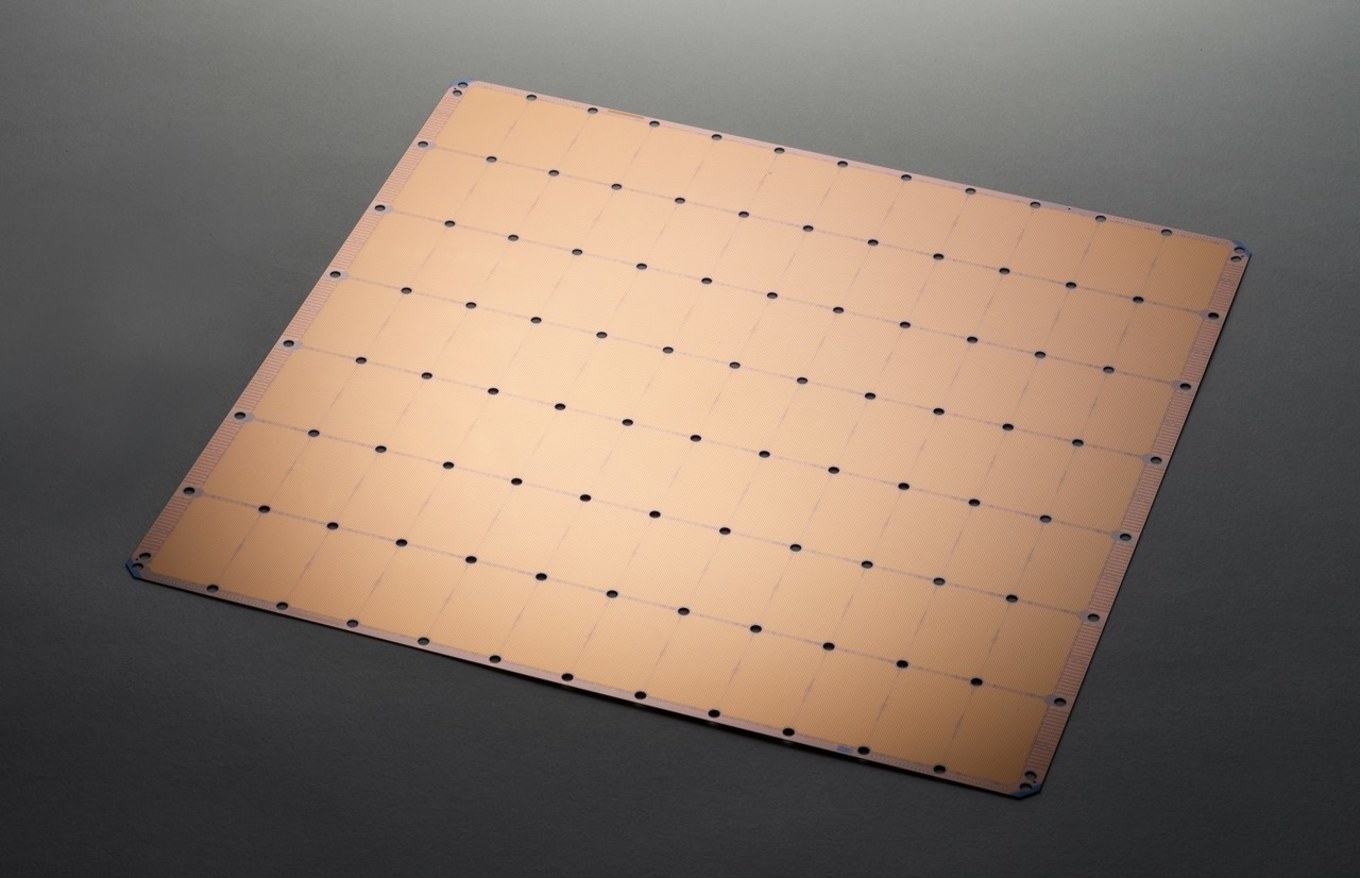

Im Rahmen der Hotchips hat aber auch ein Startup namens Cerebras seine ambitionierten Pläne veröffentlicht. Die von Cerebras geplante Hardware in Form eines Chips setzt das Chiplet-Design extrem um. Anstatt mehrere Chips auf einen Wafer zu packen, die dann voneinander getrennt werden, um möglicherweise später in einem Multi-Chip-System wieder zusammenzuarbeiten, behält Cerebras mit der Wafer Scale Engine (WSE) das Konstrukt der Wafer bei und fertig einen riesigen Chip auf einem Wafer.

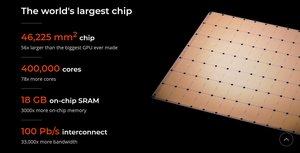

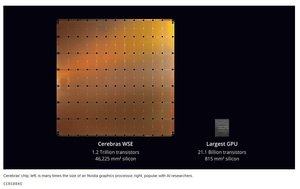

Der so entstandene Chip soll alle Rekorde brechen, die im Rahmen der Fertigung von Halbleiterchips derzeit vorhanden sind. So hat der Chip eine Fläche von 46.225 mm². Zum Vergleich: Die GV100-GPU von NVIDIA bringt es auf 815 mm² und die größten Xeon-Prozessoren von Intel auf etwa 700 mm². Ein aktueller EPYC-Prozessor (Rome) kommt mit neun Chiplets (8x CCD + 1x IOD) auf fast 1.000 mm², wird aber eben nicht als monolithischer Chip gefertigt. Mit 46.225 mm² ist der WSE der größte Chip, der aus einer 300-mm-Wafer geschnitten werden kann.

Weiterhin nennt Cerebras 1,2 Billion Transistoren, die im Chip verbaut sein sollen. Die größte GPU, wieder die GV100 von NVIDIA, kommt auf 21,1 Milliarden Transistoren und auch hier sei der Vergleich zu den EPYC-Prozessoren vollzogen, die auf etwa 33 Milliarden Transistoren kommen. Der WSE ist also auch hier um Größenordnungen größer und komplexer.

Der WSE ist ein AI-Beschleuniger, der entsprechende Berechnungen durchführen soll. Der Chip wird also nicht in der Lage sein, Standardberechnungen durchzuführen, wie dies für EPYC- oder Xeon-Prozessoren der Fall ist. Daher ist auch die Anzahl der Kerne nicht so leicht zu beurteilen, von denen der WSE aber 400.000 haben soll. Auch hier ein Vergleich: NVIDIAs GV100-GPU bringt es im Vollausbau auf 5.376 Shadereinheiten.

Als weitere Merkmale nennt Cerebras noch 18 GB an on-Chip SRAM, was ebenfalls außerordentlich viel ist. Der Interconnect zwischen den Kernen und dem Speicher sowie den weiteren Komponenten kommt auf eine zusammengenommene Bandbreite von 100 PB/s. Der Interconnect ist als 2D-Mesh ausgelegt und wurde auf den Namen Swarm getauft, was in gewisser Weise auch die Funktionsweise unterstreichen soll.

Möglichst viel Hardware auf ein Problem werfen

Die Wafer Scale Engine von Cerebras ist ein typischer Lösungsansatz für eine Problemstellung, die nach immer mehr Rechenleistung verlangt oder die nicht schnell genug berechnet werden kann. Das Training und Inferencing von Deep-Learning-Netzwerken ist von der Rechenleistung und möglichst schnellen Anbindung des Speichers abhängig. Nicht ohne Grund werden hier inzwischen riesige Netzwerke zusammengefasst und der Speicher wandert in Form von HBM immer näher an die eigentlichen Recheneinheiten.

Weiterhin arbeiten verschiedene Hersteller an spezieller Hardware, die immer einfach ausgelegte Datensätze immer schneller verarbeiten soll. Fast jeder Hersteller im Datacenter-Bereich arbeitet an solcher Hardware, das Startup Cerebras treibt diese Entwicklung nun auf die Spitze.

Ob und wann wir eine solche Hardware auch wirklich sehen werden, hängt von zahlreichen Faktoren ab. So wird Cerebras noch einige technische Hürden nehmen müssen. Neben der Fertigung werden dies auch Fragen der Stromversorgung und Kühlung eines solchen Chips sein.

Neben den Fragen der technischen Umsetzung eines solchen Chips muss auch an der Software gearbeitet werden, denn nur wenn die Software die Hardware möglichst gut auslasten kann, macht es auch Sinn, eine solche Hardware zu entwickeln.