Werbung

Auf der International Solid-State Circuits Conference 2018 (ISSCC 2018) hat Intel einen neuen Prototypen einer dedizierten GPU präsentiert. Es handelt sich dabei aber noch nicht um die vollständige Neuentwicklung unter der Leitung von Raja Koduri, die als Konkurrenz zu NVIDIA und AMD etabliert werden soll. Stattdessen scheint Intel beim namenlosen Prototypen verschiedene Technologien testen zu wollen.

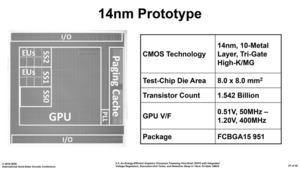

Der nun gezeigte Prototyp wird in 14 nm gefertigt und kommt bei einer Chipfläche von 64 mm² auf 1,542 Milliarden Transistoren. Zum Vergleich: Die aktuellen High-End-Lösungen von AMD und NVIDIA besitzen mehr als 10 Milliarden Transistoren, sind aber natürlich auch deutlich größer.

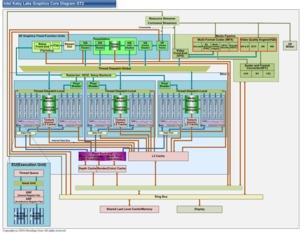

Die GPU-Architektur des Prototypen basiert auf der Gen9LP-Architekur. Diese wird derzeit mit 18 EUs (Execution Units) in den Gemini-Lake-Prozessoren verwendet. Diese 18 EUs werden auch beim Prototypen verwendet und damit bewegt sich dieser eher am unteren Ende des Ausbaus, denn bei der Iris Pro Graphics P580 kommen beispielsweise 72 EUs zum Einsatz.

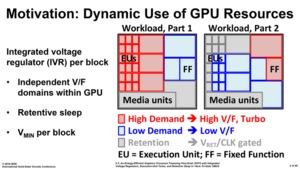

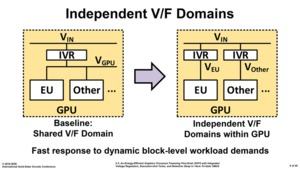

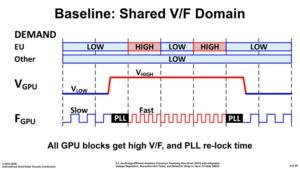

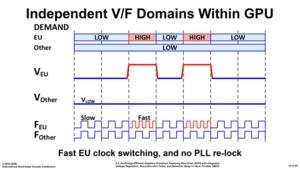

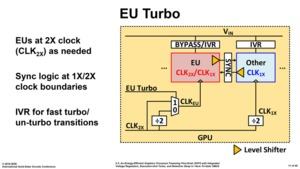

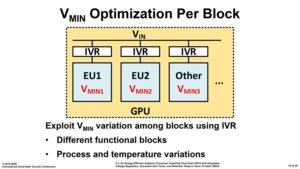

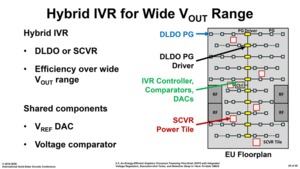

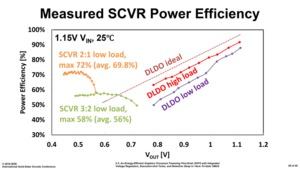

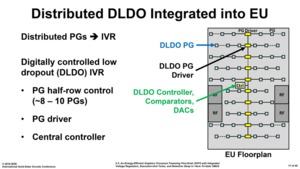

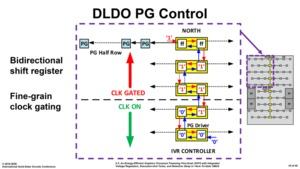

Wie gesagt, der Prototyp soll offenbar eine neuartige Strom- und Spannungsversorgung testen. Um die Effizienz zu steigern verwendet Intel gleich zwei: Digitally Controlled Low Dropouts (DLDO) sowie Switched Capacitor Voltage Regulators (SCVR).

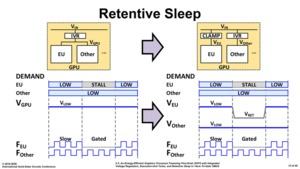

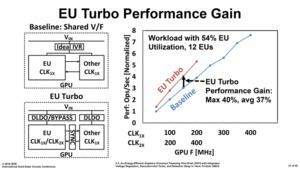

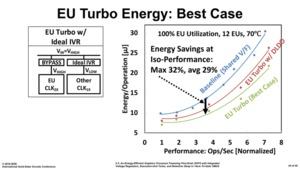

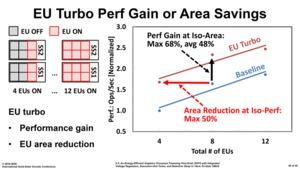

Mit dieser Maßnahme will Intel die einzelnen EUs getrennt voneinander takten und versorgen können. Das Power Gating sorgt dafür, dass nur die Bereiche des Chips versorgt werden, die gerade auch zum Einsatz kommen. Dies hilft Strombedarf und Abwärme zu verringern – macht die also GPU effizienter. Bei Verwendung von zwölf EUs will Intel mit dieser Maßnahme auch eine um bis zu 30 % höhere Leistung erreichen. Ein Power Gating in der GPU verwendet AMD seit der Polaris-Architektur und auch für Vega. Bei den Prozessoren ist dies ein übliches Vorgehen, um einzelne Bereich abzuschalten. Damit hat auch Intel schon einige Erfahrung sammeln können.

Wie auch bei den Prozessoren gilt bei diesem speziellen Gen9LP-Prototypen: Werden nur einige wenige EUs benötigt, können diese höher takten als bei der Verwendung der kompletten integrierten GPU. Dies kennen wir von den Prozessoren durch die All-Core-, bzw. abgestuften Boost-Taktraten für die Verwendung einzelner Kern-Paare.

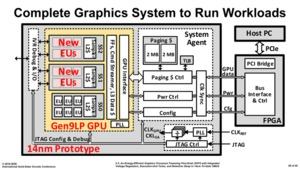

Etwas verdutzt waren wir aufgrund des FPGAs, welcher sich ebenfalls auf dem Package befindet. Allerdings scheint dies ein übliches Vorgehen von Intel für einen solchen Prototypen zu sein. Da die dedizierte GPU in ein ein System eingebettet werden muss, stellt Intel über die FPGA die notwendigen Verbindungen zur Ansteuerung bereit.

Man darf nun gespannt sein, in welcher Form die Entwicklungsergebnisse in den geplanten dedizierten GPUs von Intel auftauchen werden. Beim gezeigten Prototypen geht es nur darum die besagte Strom- und Spannungsversorgung zu testen. Bis wir hier die ersten Ergebnisse sehen, wird es aber noch einige Zeit dauern. Intel hat die Entwicklungsteams offenbar bereits zusammengestellt, einige Jahren werden aber sicherlich vergehen.

Update:

Wir wollen die Meldung rund um den Prototypen noch einmal etwas relativieren. Zunächst einmal sei gesagt, dass es sich bei dem Prototypen nicht um ein neues GPU-Design handelt. Er dient schlicht und ergreifend der Erprobung der Strom- und Spannungsversorgung und legt keinen Fokus auf die 3D-Leistung. Erkenntnisse aus der Entwicklung und Erprobung des Prototypens werden aber sicherlich bei zukünftigen dedizierten GPU-Designs eine Rolle spielen.

Intel hat zudem folgende Stellungnahme veröffentlicht:

"Last week at ISSCC, Intel Labs presented a research paper exploring new circuit techniques optimized for power management. The team used an existing Intel integrated GPU architecture (Gen 9 GPU) as a proof-of-concept for these circuit techniques. This is a test vehicle only, not a future product. While we intend to compete in graphics products in the future, this research paper is unrelated. Our goal with this research is to explore possible, future circuit techniques that may improve the power and performance of Intel products."