Werbung

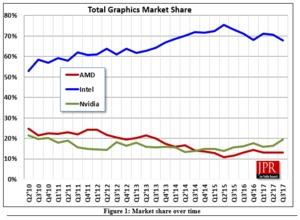

Geht es nach den neusten Entwicklungen im Grafikkartenmarkt, kann laut den Analysten von Jon Peddie Research ein Gesamtwachstum von satten 10 % gegenüber dem vorherigen Quartal verzeichnet werden. Vor allem NVIDIA scheint von der gestiegenen Nachfrage zu profitierten, denn der Marktanteil steigt im dritten Quartal auf 20 % und somit so stark wie bei keinem anderen Kontrahenten. Auch AMD kann seinen Anteil steigern, allerdings weniger stark. Der Marktanteil wird auf 16,1 % beziffert. Weiterhin an der Spitze ist Intel. Da das Unternehmen durch seine integrierte Grafikeinheit in den Prozessoren ein leichteres Spiel hat, wird hier ein Marktanteil von 68 % erreicht. Damit bleibt Intel weit vor den beiden Kontrahenten.

Für das Gesamtwachstum ist laut der Analysten vor allem die hohe Nachfrage aufgrund des Mining-Booms bei Kryptowährungen verantwortlich. Viele Nutzer hätten im dritten Quartal zu einer Grafikkarte gegriffen, um virtuelle Währungen zu generieren. Ob dieser Trend anhalten wird, entscheidet letztendlich lediglich der Kursverlauf der Kryptowährungen. Sollte der Kurs wieder deutlich fallen, wird das Mining wieder uninteressanter und die Nachfrage von Grafikkarten dürfte entsprechend zurückgehen.

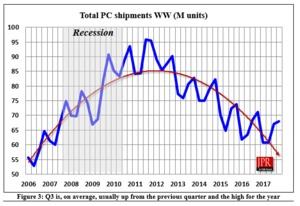

Trotz des Wachstums im Grafikkartenmarkt bleibt die Anzahl der verkauften 3D-Beschleuniger weit hinter den Ergebnissen von 2011. Seit 2011 ist ein Abwärtstrend in diesem Bereich zu erkennen, auch wenn es eine Erholung der Gesamtsituation gibt. Der negative Verlauf seit dem Jahr 2011 ist wohl vor allem auf den allgemeinen schwachen PC-Markt zurückzuführen. Insgesamt werden immer weniger PC-Systeme verkauft und somit nimmt auch die Nachfrage nach Grafikkarten ab.