Werbung

AMD verfolgt bereits seit einiger Zeit einen offenen Ansatz, wenn es um die Compute-Schnittstellen zur eigenen Hardware geht. GPUOpen richtet sich dabei vor allen an die Entwickler von Spielen und entsprechenden Engines und soll in diesem Bereich eine Open-Source-Alternative zu CUDA und GameWorks sein. Damit möchte AMD vor allem für die Entwickler weitere Anreize schaffen die eigene Hardware zu verwenden. Weite Teile der zur Verfügung stehenden Software sollen weiter verbessert und teilweise als Open-Source angeboten werden bzw. sind dies schon, damit diese Verbesserungen schneller und auch durch externe Entwickler getrieben eingebaut werden können.

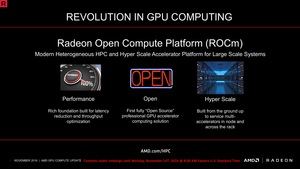

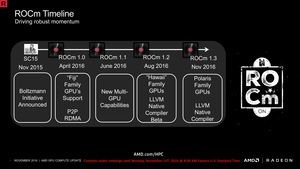

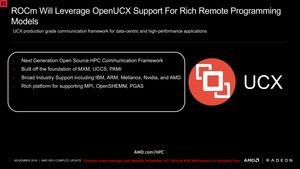

Nun wählt AMD einen ähnlichen Ansatz auch GPU-Computing-Bereich bzw. weitet die bisher bestehenden Anstrengungen, wie zum Beispiel die Bolzmann-Initiative, aus. Die Supercomputing Conference 2016 nutzt AMD zur Vorstellung der Radeon Open Compute Platform oder kurz ROCm. Sie soll Basis für moderne Heterogeneous-HPC-Strukturen im Zusammenspiel mit HSA (Hyper Scale Accelerator) für Großprojekte sein.

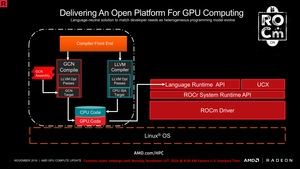

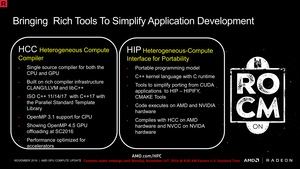

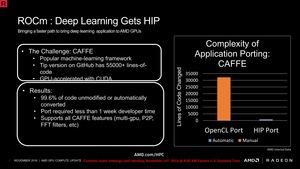

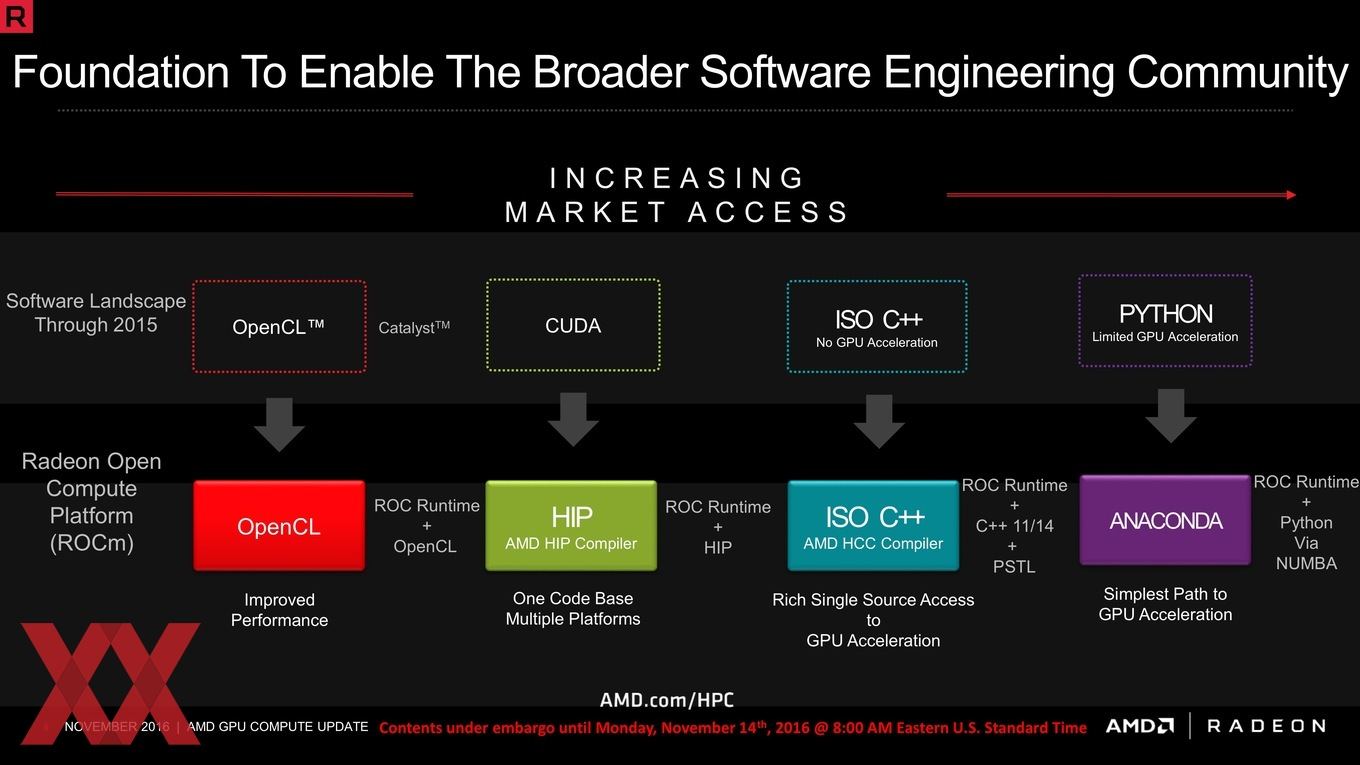

AMD sieht vier Bausteine für ROCm vor. Da wäre zunächst der sogenannte Graphics Core Next Headless Linux 64 Bit Treiber. Damit umschreibt AMD eine bereits angekündigte Entwicklung bei den Linux-Treibern, die eine geringe Latenz, weniger Overhead und damit schnelleres HSA für die diskrete GPU ermöglichen sollen. Die Ansätze hinsichtlich des Zugriffs auf die Ressourcen der Hardware sind mit denen moderner Grafik-APIs Mantle und DirectX 12 vergleichbar. Ein zweiter wichtiger Faktor ist die Unterstützung und Anpassung der Compiler auf die eigene Hardware. Auch hierzu präsentierte AMD vor genau einem Jahr bereits erste Ansätze – den Heterogenious Compute Compiler. Dabei handelt es sich um einen Open-Source-Compiler für C++, der Code für GPUs zusammenstellen soll. Unter anderem wird damit der sogenannte HIP realisiert. Dabei handelt es sich um einen Konverter, der CUDA-Code zu C++ konvertiert, der dann auch auf AMD-GPUs ausgeführt werden kann.

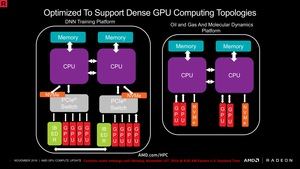

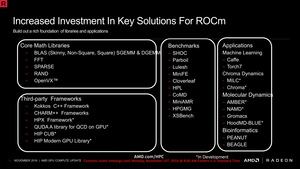

Die dritte Komponente ist die Integration weiterer und neuer HSA-Strukturen in Hard- und Software. Inzwischen wird HSA sowohl von den GPUs wie auch den APUs vollständig unterstützt, spielt aber noch immer keine allzu große Rolle in GPU-Compute-Segment. Dies soll sich durch eine tiefergehende Integration jedoch ändern. Vierter Punkt ist das Angebot an Open-Source-Tools, Programmen und Bibliotheken, die einen freuen und einfachen Zugang gewährleisten sollen.

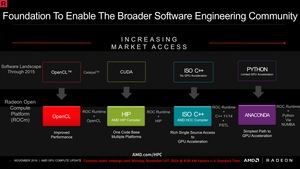

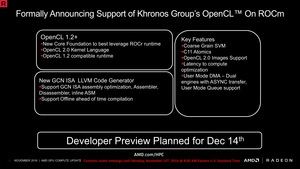

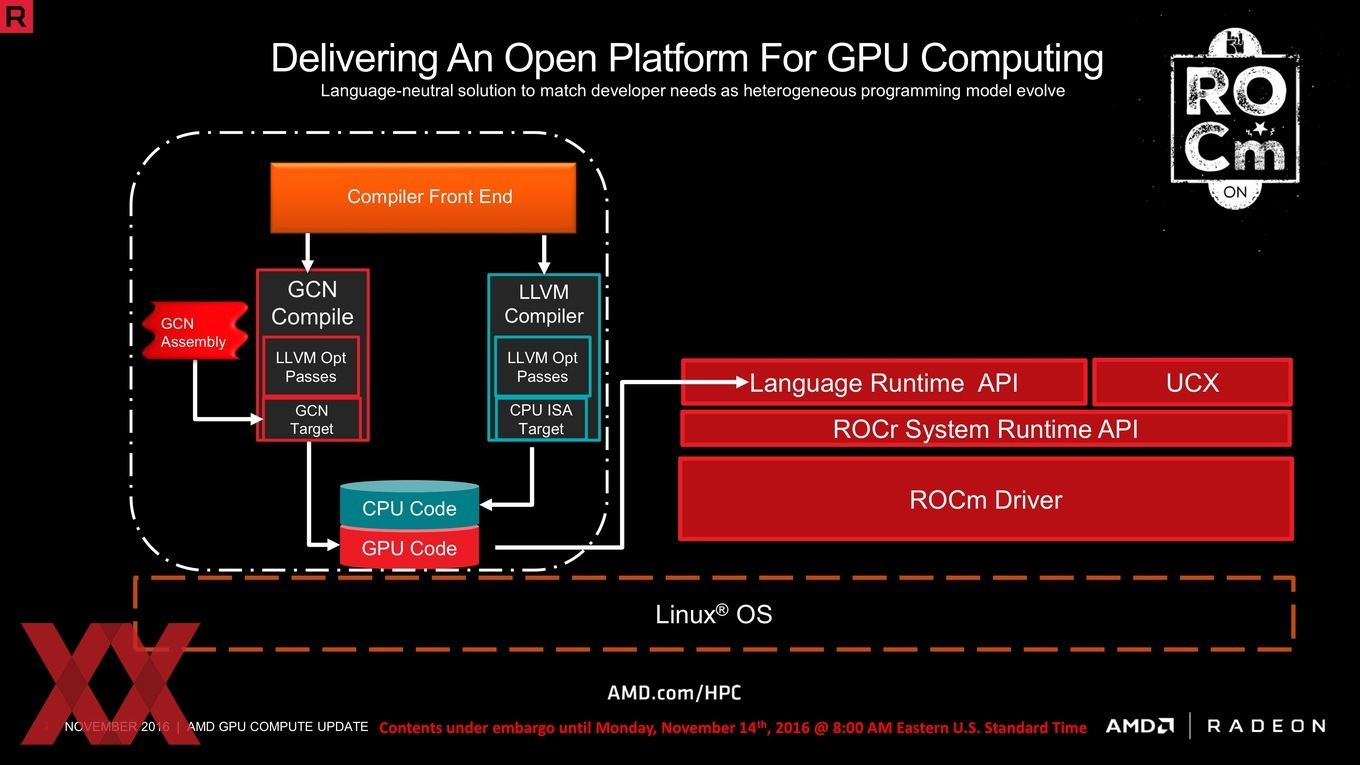

Eine große Rolle im Gesamtkonzept kommt dem Compilern zu, denn sie sollen beliebigen Code auf der eigenen Hardware schnellstmöglich ausführen können. Dazu hatte AMD bereits im vergangenen Jahr einen neuen LLVM-Compiler veröffentlicht, der für die CPU-Berechnungen den Code entsprechend aufarbeiten soll. Da die GPUs aber den wesentlich höheren und damit wichtigeren Anteil bei entsprechenden Berechnungen haben, sorgt ein GCN-Compiler für die Anpassungen am GPU-Code. Dieser ist speziell auf die Graphics-Core-Next-Architektur hin optimiert und wendet diese Optimierungen auch im Zielcode an. Für jeden Zielcode wie OpenCL, CUDA, ISO C++ oder Python hat AMD eine entsprechende Schnittstelle entwickelt.

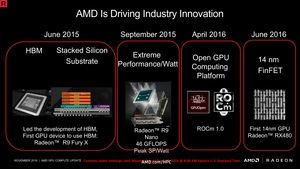

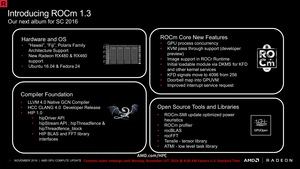

Die erste Version von ROCm wurde um April 2016 vorgestellt und bot unter anderen die Unterstützung für die Fiji-GPUs. Mit ROCm im August wurden dann auch die Unterstützung für die Hawaii-GPUs hinzugefügt und Version 1.3 im November soll nun auch den Support für die Polaris-GPUs bieten. Außerdem ist der LLVM-Compiler nun in einer finalen Version enthalten. Damit werden auch die ab November verfügbaren Karten wie die Radeon Pro WX 4100, 5100 und 7100 vollständig unterstützt.

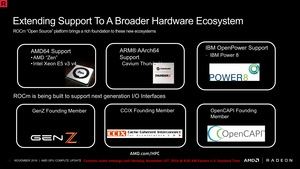

Der Open-Source-Gedanke soll aber auch dazu beitragen, dass mehr und mehr andere Hersteller auf den Zug aufspringen. Zunächst einmal aber will man die eigene Zen-Architektur ab dem kommenden Jahr integrieren – natürlich erst, wenn auch die ersten Produkte verfügbar sind. Man ist aber offenbar auch mit Herstellern wie Cavium (ARM-Prozessoren), IBM (Power8-Prozessoren) sowie im I/O-Bereich mit GenZ, CCIX und der OpenCAPI Foundation in Gesprächen bzw. Gründungsmitglied der beiden erstgenannten Initiativen. Inzwischen scheint man sich bei AMD auch bewusst zu sein, dass Deep-Learning ein wichtiger Faktor in diesem Bereich ist und wird sich auch in diesem Segment entsprechend ausrichten.

Update:

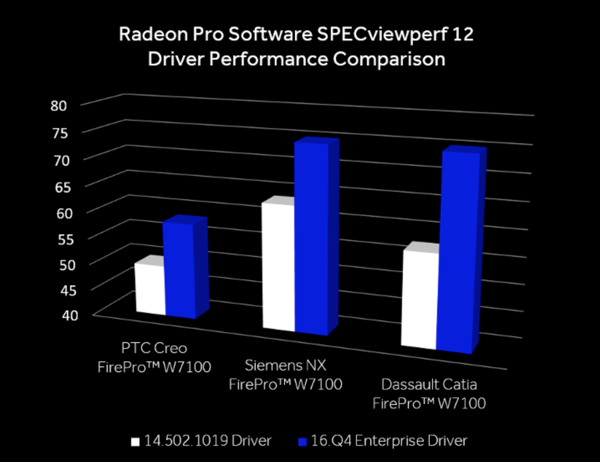

Heute hat AMD wie versprochen den Radeon Pro Software Enterprise-Treiber veröffentlicht, der die neuen Funktionen und Leistungsverbesserungen enthalten soll. Der 16.Q4 Enterprise Driver kann direkt bei AMD bezogen werden. Der Treiber ist kompatibel zur Radeon-Pro-WX-Serie, Radeon Pro Duo, AMD-FirePro-W-Serie und einigen AMD-FirePro-S-Karten und unterstützt Windows 7/10 sowie Linux.