Werbung

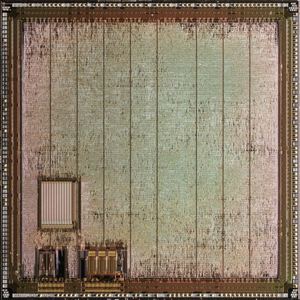

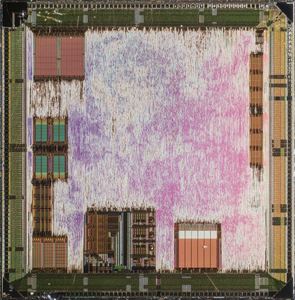

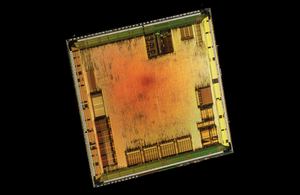

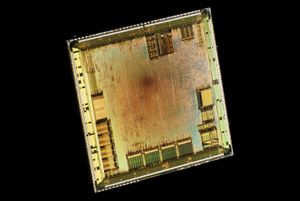

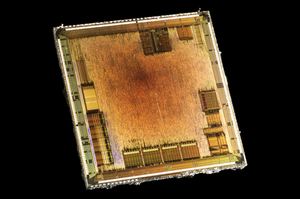

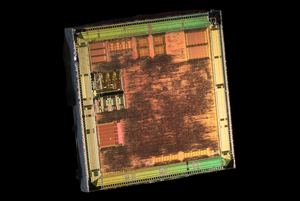

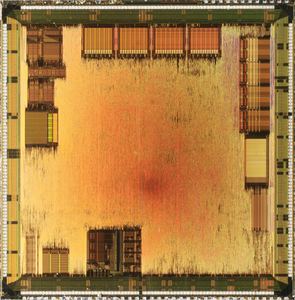

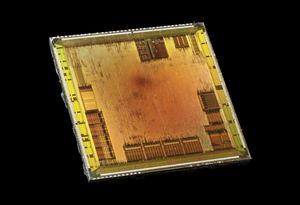

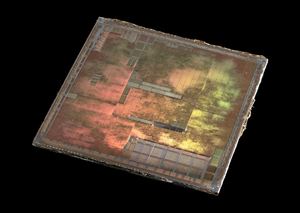

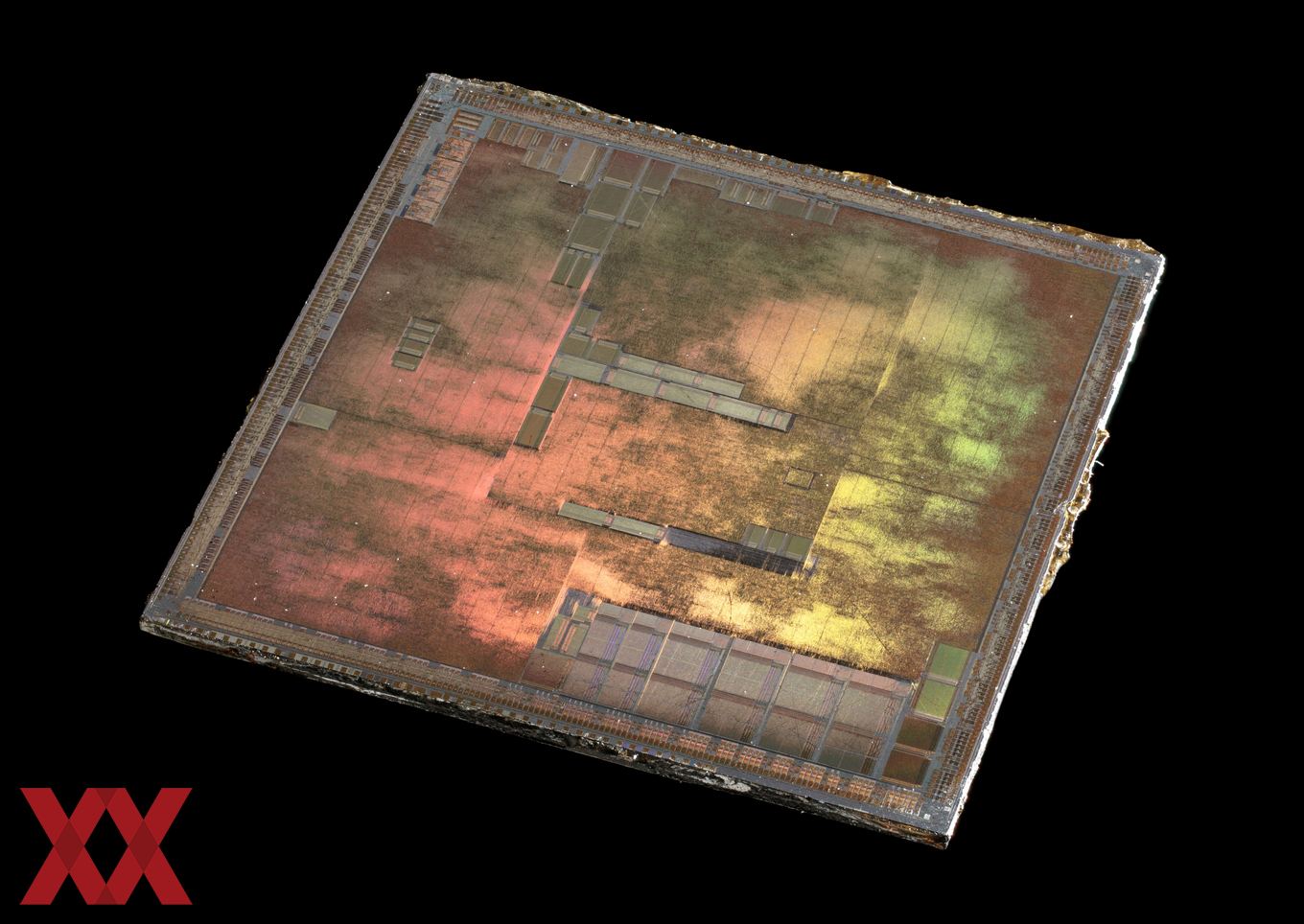

Bereits mehrfach haben wir in den News über die Arbeit unseres Foren-Mitglieds OC_Burner gesprochen. Dieser nimmt sich alte und aktuelle Grafikkarten, löst die GPUs von der Platine und sprengt das Package mittels Hitze auf. Danach erfolgt in mehreren Arbeitsschritten ein Abschleifen der verschiedenen Schichten, bis ein Blick auf die eigentliche GPU möglich ist. Über verschiedene Filter und mit etwas fotografischem Können entstehen dabei detaillierte Aufnahmen der GPUs, die wir so meist noch nicht einmal von den Herstellern bekommen.

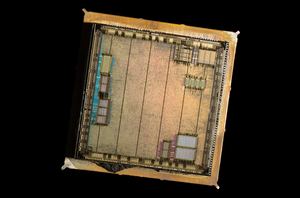

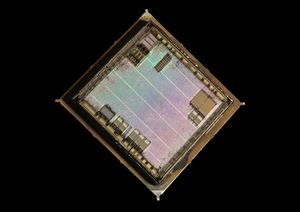

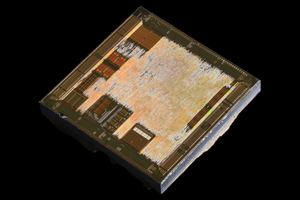

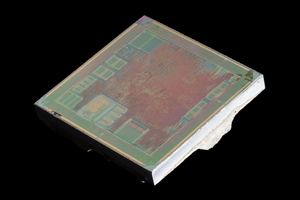

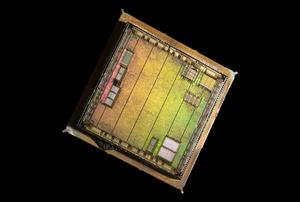

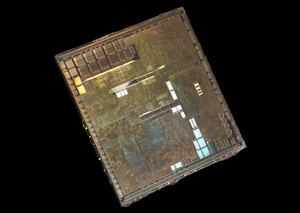

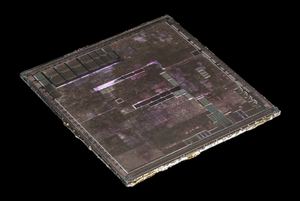

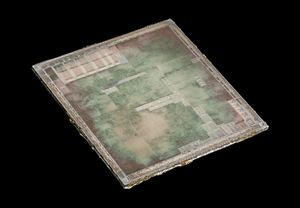

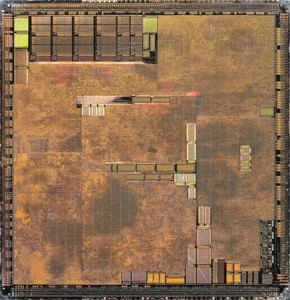

Bisher berichteten wir zumeist über aktuelle GPUs, wie zum Beispiel die Polaris-10-GPU von AMD, die Fiji-GPUs mitsamt High Bandwidth Memory im Package oder aber die letzten beiden Architekturen von NVIDIA (GM204 und GP104). Nun aber hat OC_Burner sich auch an älteren Karten versucht und katapultiert uns damit in die Zeiten von Fixed Rendering Pipelines und Fertigungsgrößen von 350, 500 oder gar 600 nm. Im Hinblick auf die aktuelle Fertigung in 14/16 nm liegen hier Welten dazwischen, die sich auch auf den Fotos erkennen lassen. Anstatt 8 Milliarden Transistoren kamen 1994 (am Beispiel der ATI Mach 64 GPU) noch nur ein paar Millionen Transistoren zum Einsatz.

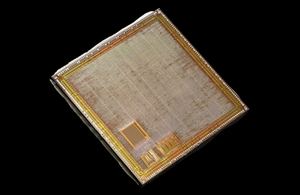

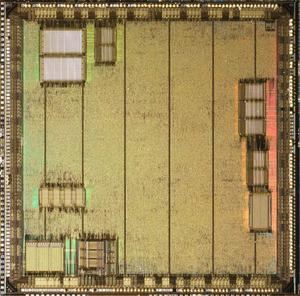

Anhand der Fotos wollen wir aber auch einmal erläutern, was damals Stand der Technik war. Wir sprechen hier von 1 oder 2 MB Grafikspeicher, der über ein 64 Bit breites Speicherinterface angebunden ist. Die Taktfrequenzen lagen noch bei ein paar dutzend MHz und nicht wie heute bei 1.000 MHz und mehr. Auf den Fotos zu sehen gibt es folgende GPUs:

- AMD Mach 64 (ATI 3D Rage, 600 nm, 8 Millionen Transistoren)

- NVIDIA NV10 (GeForce 256, 220 nm, 17 Millionen Transistoren, 4x4 Renderpipelines)

Die Mach-64-Architektur wurde von ATI allerdings über verschiedene Generationen und Ausbaustufen eingesetzt. Die Fertigung reichte von 600 bis 350 nm. Entsprechend komplex wurden auch die GPUs. Auf der Rage 128 waren bis zu 32 MB SDRAM vorhanden und anstatt 8 Bit konnten Farben bereits in 16 Bit ausgegeben werden. Sogar kleine Buffer für Texel und Pixel Caches waren bereits vorhanden.

[h2]Fixed Rendering Pipeline[/h2]

Wir wollen aber auch noch einmal zurück auf die Fixed Rendering Pipelines. Sie begleiteten die GPUs über zahlreiche Architekturen und limitierten die Fähigkeiten der GPUs, die heute flexibler als jemals zuvor sind. Shadereinheiten können verschiedene Aufgaben übernehmen und werden inzwischen auch für wissenschaftliche Anwendungen verwendet. Berechnungen können unterschiedlich komplex sein, reichen von einfacher bis doppelter Genauigkeit und selbst kleine 8-Bit-Operationen spielen für Deep-Learning-Netzwerke eine wichtige Rolle.

Früher war dies anders. Die Verdrahtung einer GPU und damit die Arten von Berechnungen, die durchgeführt werden konnten, war festgelegt und konnte nicht verändert werden. Eine bestimmte Beleuchtung, eine Rasterization, Texturen und fertig war die Ausgabe. Eigene Formen von Beleuchtungsberechnungen konnten nicht implementiert werden. Heute sind die Programmierer daran gewöhnt, deutlich flexibler mit der Hardware umgehen zu können.

Einen Blick in diese alte Zeiten machen die Die-Shots der alten GPUs möglich. Auf den Fotos sind die festen Verdrahtungen auch noch einmal sehr schön zu sehen.