Werbung

Neues Jahr, neues Testsystem – um für 2018 vorbereitet zu sein, haben wir unser Grafikkarten-Testsystem umgestellt. Neue Hardware und neue Software sollen dafür sorgen, dass wir für alles, was in diesem Jahr erscheinen soll vorbereitet sind. Wir wechseln beispielsweise von einem Intel-Prozessor auf ein AMD-Modell und haben darüber hinaus zahlreiche weitere Komponenten aktualisiert.

In den folgenden Abschnitten wollen wir die einzelnen Komponenten genauer vorstellen und nennen alle technischen Details. Zusammen mit der Hardware kommt natürlich auch eine aktuelle Softwarebasis zum Einsatz. Windows 10 mit dem Fall Creators Update sollte obligatorisch sein, hinzu kommen natürlich auch die neuesten Grafikkarten-Treiber.

Hier schon einmal eine erste Übersicht der verbauten Komponenten:

| Das Testsystem | |

|---|---|

| Prozessor | AMD Ryzen Threadripper 1950X, 16x 3,4 GHz |

| Kühlung | Noctua NH-U14S TR4-SP3 |

| Mainboard | ASUS ROG Strix X399-E Gaming |

| Arbeitsspeicher | G.Skill Flare X F4-3200C14Q-32GFX, 4x 8GB DDR4-3200 |

| SSD | Samsung SSD 960 Pro 512GB |

| HDD | Seagate FireCuda 2TB |

| Netzteil | Seasonic Prime Titanium Series 850W |

| Betriebssystem | Windows 10 64 Bit |

| Gehäuse | Fractal Design Define XL R2 |

Zu einem späteren Zeitpunkt werden wir uns noch etwas genauer der Software widmen. Natürlich sollten unter anderem die neuesten Treiber zum Einsatz kommen. Dies wären der Radeon Software Adrenalin Edition für alle AMD-Grafikkarten und der 390-Branch für alle NVIDIA-Grafikkarten.

Außerdem wird es natürlich Änderungen bei den Benchmarks geben. Einige ältere Spielen fliegen raus, einige aktuelle werden dazukommen. Dazu wird es aber wie gesagt noch eine gesonderte Meldung geben, in der wir den aktuellen Leistungsstand der Karten dann auch präsentieren können.

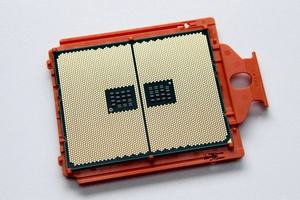

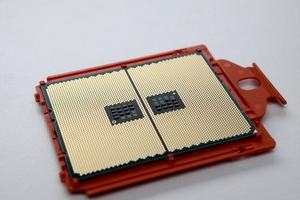

Prozessor: AMD Ryzen Threadripper 1950X

Wohl mit eine der wichtigsten Komponenten des neuen Systems ist der Prozessor. Wir haben uns für einen AMD Ryzen Threadripper 1950X entschieden. Dieser bietet 16 Kerne und kann 32 Threads verarbeiten. Der Turbotakt liegt bei bis zu 4,0 GHz und damit sollten eventuelle Flaschenhälse bei der CPU-Leistung ausgeschlossen sein. Zudem werden Spiele zunehmen von einer höheren Anzahl an CPU-Kernen profitieren.

Kühler: Noctua NH-U14S TR4-SP3

Zur Kühlung des Ryzen Threadripper 1950X setzen wir auf einen Noctua NH-U14S TR4-SP3. Es handelt sich dabei um einen Tower-Kühler mit der Möglichkeit 140-mm-Lüfter zu montieren. Auf eine AiO-Kühlung haben wir verzichtet. Im Falle der Messung der Idle-Lautstärke halten wir den Lüfter der CPU-Kühlung einfach an und haben damit keinerlei Störgeräusche zu befürchten.

Sechs vernickelte Heatpipes sollen die Abwärme abtransportieren. Der von Noctua verbaute Lüfter arbeitet mit 300 bis 1.500 Umdrehungen pro Minute kann dabei bis zu 140,2 m³/h fördern.

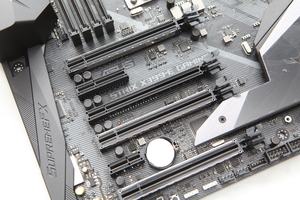

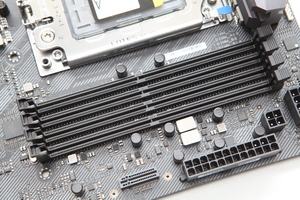

Mainboard: ASUS ROG Strix X399-E Gaming

Als passendes Mainboard für den AMD Ryzen Threadripper 1950X haben wir das ASUS ROG Strix X399-E Gaming auserwählt. Die Platine kommt im E-ATX-Formfaktor daher. Neben dem Sockel TR4 bietet das Board noch acht DIMM-Steckplätze für DDR4-3600. An Erweiterungssteckplätzen stehen 4x PCI-Express 3.0 x16 (2x x16, 2x x8), 1x PCI-Express 2.0 x4 und 1x PCI-Express 2.0 x1 zur Verfügung. Entsprechende SSDs können per 1x M.2/M-Key (PCI-Express 3.0 x4/SATA, 22110/2280/2260/2242) und 1x M.2/M-Key (PCI-Express 3.0 x4/SATA, 2280/2260/2242) sowie 1x U.2/SFF-8643 (PCI-Express 3.0 x4) angeschlossen werden. Für die klassischen Festplatten stehen noch 6x SATA 6 GBit/s zur Verfügung.

An USB-Anschlüssen stehen 1x USB-C 3.1 (ASM3142), 1x USB-A 3.1 (ASM3142) sowie 8x USB-A 3.0 bereit. Intern stehen zur Erweiterung noch 1x USB 3.1 (20-Pin Key-A, X399), 4x USB 3.0 und 4x USB 2.0 zur Verfügung.

Arbeitsspeicher: G.Skill Flare X F4-3200C14Q-32GFX

Um das Quad-Channel-Speicherinterface des Prozessors entsprechend ansprechen zu können, haben wir uns für ein entsprechendes Kit aus dem Hause G.Skill entschieden. Die G.Skill Flare X F4-3200C14Q-32GFX bieten ab Werk per Profil einen Takt von DDR4-3200 bei Timings von CL14-14-14-34. Mit 4x 8 GB und damit insgesamt 32 GB dürften wir auch hier für die Zukunft gerüstet sein.

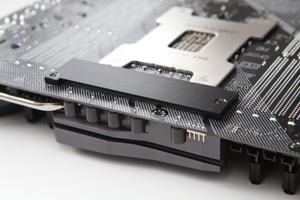

SSD: Samsung SSD 960 Pro 512GB

Wer derzeit das Maximum an Leistung im Bereich der SSDs bekommen möchte, der greift zum M.2-Format und verwendet ein Mainboard mit entsprechendem Slot der auch die vollen vier PCI-Express-Lanes bietet. Die Samsung SSD 960 Pro mit 512 GB kann mit den aktuell höchsten Übertragungsraten aufwarten.

Samsung verwendet den M.2-2280-Formfaktor und auf dem PCB die eigenen 3D-NAND MLC Speicherchips. Auch der Controller stammt aus eigenem Hause und hört auf den Namen Samsung Polaris. Dieser bietet acht Speicherkanäle und verwendet zusätzliche 512 MB LPDDR3 an Cache. Samsung gibt Übertragungsraten von 3.500 MB/s lesend und 2.100 MB/s schreibend an. Die IOPS 4K lesen/schreiben werden mit 330k/330k angegeben.

Festplatte: Seagate FireCuda 2TB

Da uns die 512 GB an SSD-Speicher für die Installation der aktuellen Spiele sicherlich nicht ausreichen, müssen wir natürlich auch auf eine Festplatte zurückgreifen. Wir verwenden daher eine Seagate FireCuda mit 2 TB an Speicherkapazität. Seagate verwendet hier Magnetplatten mit 7.200 Umdrehungen pro Minute, der Cache ist 64 MB groß und zudem kommen 8 GB SSD-Cache (MLC-NAND) zum Einsatz.

Netzteil: Seasonic Prime Titanium Series 850W

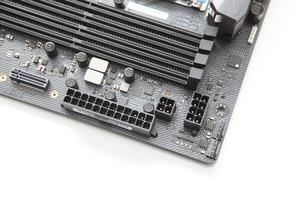

Zur Stromversorgung aller Komponenten verwenden wir ein Seasonic Prime Titanium Series mit einer Ausgangsleistung von 850 W. Das semipassive Netzteil verwendet einen 135-mm-Lüfter und ist mit einer durchschnittlichen Effizienz von 94 %, entsprechend 80 PLUS Titanium zertifiziert. Der semi-passive-Modus ist umschaltbar.

Das vollmodular Netzteil bietet: 1x 20/24-Pin, 2x 4/8-Pin ATX12V, 6x 6/8-Pin PCIe, 10x SATA, 5x IDE, 1x Floppy. Auf der +3.3-V-Spannungsschiene werden 20 A, geliefert, bei +5 V ebenfalls 20 A, auf +12 V dann satte 70 A und auf -12 V sind es 0,3 A. Seagate gibt eine Garantie von zwölf Jahren.

Gehäuse: Fractal Design Define XL R2

Schlussendlich müssen wir alle Komponenten natürlich auch in einem Gehäuse unterbringen, um möglichst praxisrelevant zu sein. Wir haben uns hier für ein Fractal Design Define XL R2 entschieden, da vor allem ausreichend Platz für ein E-ATX-Mainboard vorhanden sein muss. Daneben bietet es die Möglichkeit zahlreiche Laufwerke unterzubringen. Dies wären extern: 4x 5,25 Zoll, 1x 3,5 Zoll sowie intern: 8x 2,5 Zoll/3,5 Zoll (quer auf Laufwerksschienen). Das Frontpanel bietet die Möglichkeit 2x USB-A 3.0, 2x USB-A 2.0, 1x Mikrofon und 1x Kopfhörer anzuschließen.

Zur Belüftung des Gehäuses stehen ebenso zahlreiche Montagemöglichkeiten zur Verfügung. Möglich sind vorne 2x 140 mm, hinten 1x 140 mm, links und rechts 1x 140 mm sowie oben 2x 140 mm und unten 1x 140 mm. Das Gehäuse kommt in einem klassischen schwarz daher und auch wenn es bereits einige Jahre auf dem Markt ist, so gehört es in dieser Größe noch immer zu den besten.