Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Es wäre mir aber neu, dass die Auflösung jetzt einen Einfluss darauf hat, ob ein Monitor/TV den Test von NVIDIA besteht. Das beschriebene Problem wäre ja auch nicht auf VRR zurückzuführen, sondern eben auf 4K@120 und die dafür notwendige Rechenleistung. Die Zuspielung in 4K@120 würde ja dennoch gehen und auch VRR sollte wohl ohne zu flackern dargestellt werden. Dass viele Hersteller sich es sparen ihre TVs bei NVIDIA einzureichen wird eher an anderen Punkten liegen.

Sag das mal den 2019er OLED Besitzern, bei denen LG scheinbar kein Interesse mehr hat DV Gaming nachzurüsten

Sag das mal den 2019er OLED Besitzern, bei denen LG scheinbar kein Interesse mehr hat DV Gaming nachzurüsten

Wenn Panasonic den TV bei Nvidia Gsync zertifizieren will und die feststellen dass nur mit der halbierten Auflösung Gsync funktioniert, bezweifle ich dass Nvidia eine Freigabe dafür gibt.

Das DV Gaming kommt ja "angeblich nicht" weil 2019 eben noch ein anderer Chipsatz verwendet wurde, ob es Softwareseitig trotzdem machbar wäre und LG die alten Modelle künstlich beschneidet werden wir vielleicht nie erfahren, wobei ICH sagen muss dass kein DV Gaming mit 4k 120Hz für MICH vernachlässigbar ist da am PC momentan sowieso HDR der Standard ist und wenn man sich diverse HDR, HDR10+ und DV Vergleiche so ansieht wird man außer im direkten AB Vergleich mit freiem Auge sowieso keine gravierenden Unterschiede feststellen da die Content Anbieter halt auch vieles nur so dahin schluddern.

Kann denn der C9 DV @ 60HZ bei der Xbox ?

Ja, der wird sehr warm bei Benutzung und riecht dann etwas.Ich habe seit 2 Tagen den LG OLED55CX9LA. Ist das normal das der so stinkt ? Riecht wie verbranntes plaste

Heute hatte ich den TV am laufen und habe die PS5 eingeschaltet .

Bin auf den HDMI und Bild blieb Schwarz.

Ton war da und dann zurück auf Live TV und Bild war weiterhin Schwarz.

Einstellungen vom TV wurden angezeigt nur halt kein Bild ob TV oder Quelle HDMI .

TV ausgeschaltet und Stecker gezogen und etwas gewartet .

Wieder eingesteckt und auf HDMI Port 4 gegangen und Bild PS5 war da.

Schonmal Jemand gehabt ?

Dann guck dir mal die Sachen an die NVIDIA eigentlich nur testet.

Von irgendeiner Mindesauflösung oder einem"Auflösungsverlust" ist da nicht die Rede.

glaubst du nicht ernsthaft dass Ihnen eine z.b halbierte Auflösung nicht auffallen oder egal sein würde?

Dennoch ist das aber kein Punkt, der eine Rolle für das Zertifikat spielt spielt. Der Hintergedanke hinter des Tests eben die Prüfung ist, ob VRR ohne Flackern/Ausfälle klappt. Die Auflösung ist dabei halt latte. Als Bonus testen sie für manche Stufen dann eben noch HDR und anderen Kleinkram.

Worauf stützt sich deine Annahme/Aussage? Quelle?

wenn man Gsync Nutzt

Wo es angemekert .. eben an VRR liegt ..

G-sync-kompatibel hat ja keinen strikten Anforderungskatalog wie G-sync; ob die fehlende Zertifizierung deswegen nicht erteilt wurde?

Sony A90J hat den Mediatek MT5895 SoC, welcher von Haus aus diese Limitierungen mit sich bringt. Da kann Sony nichts machen.

Ach, der 2021er von Sony hat die Limitierung weiterhin? Spannend. Hatte eigentlich gehofft, dass die bei den 2021ern einen ordentlichen Chipsatz verwenden

www.tftcentral.co.uk

www.tftcentral.co.uk

pokde.net

pokde.net

Denke die HDR 1000 hat er wohl deswegen bekommen weil er mit 800 - 900 Nits mehr richtung HDR 1000 is als an HDR 600

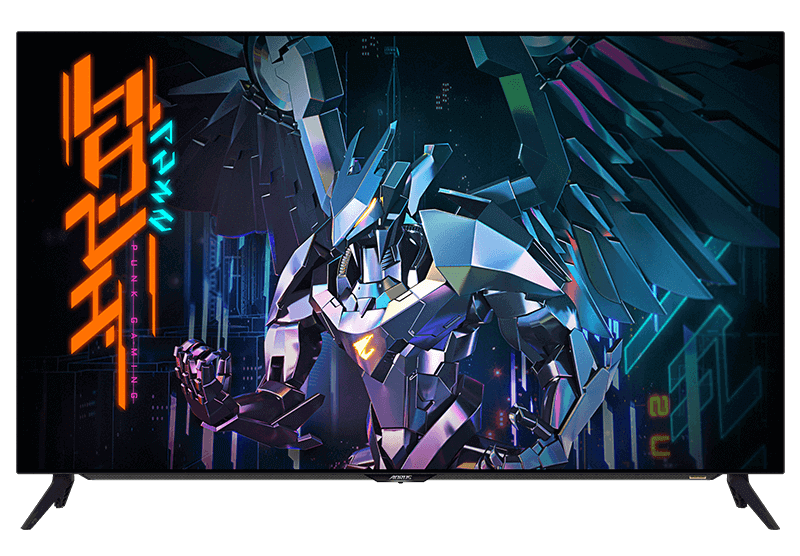

*HDMI2.1 supports PS5 and Xbox Series X at 4K UHD@120Hz (4:2:0)

Ja von 10%auf 25% Fläche bricht die Helligkeit schon fast um 400nits ein.

166-250nits ist halt schon wirklich extrem wenig.

Abends sogar nur auf 20. Wenn ich nicht überall wo es geht dark themes und reader nutzen würde, würde ich Abends die Helligkeit auf 0 stellen,