quotengrote

Profi

- Mitglied seit

- 30.10.2019

- Beiträge

- 146

Nett, das Gehäuse mit 4x3,5“ wäre ja fast mein Traumkandidat.

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Danke Dir - dann gehe ich das so an.Zur 2. Frage:

Ich persönlich habe bei mir Hyper-V am laufen mit einigen Windows VMs und einer Debian VM für Docker - fluppt einwandfrei

Bei mir ist zurzeit (leider) auch kein Handlungsbedarf mehr. Ich bin wirklich aktuell nahezu wunschlos happy, was man schon daran sehen kann, dass ich nicht einmal ein paar Schönheitskorrekturen angehe, zu denen ich den Server einmal herunterfahren und aufmachen müsste (zwei SSDs umstecken und bisserl Passthrough neu optimieren)…

Bei mir ist zurzeit (leider) auch kein Handlungsbedarf mehr. Ich bin wirklich aktuell nahezu wunschlos happy, was man schon daran sehen kann, dass ich nicht einmal ein paar Schönheitskorrekturen angehe, zu denen ich den Server einmal herunterfahren und aufmachen müsste (zwei SSDs umstecken und bisserl Passthrough neu optimieren)…

- PCIe Riser Card: C_Payne PCIe 16x ->8x, m.2, m.2

Bis auf die 24 verbleibenden Lanes von der CPU 😉. Bei ner richtigen Serverplattform wie 2011-3 würde ich mindestens auf FlexATX oder yATX gehen.Dann sind alle Lanes sinnvoll verteilt

Bis auf die 24 verbleibenden Lanes von der CPU 😉. Bei ner richtigen Serverplattform wie 2011-3 würde ich mindestens auf FlexATX oder yATX gehen.

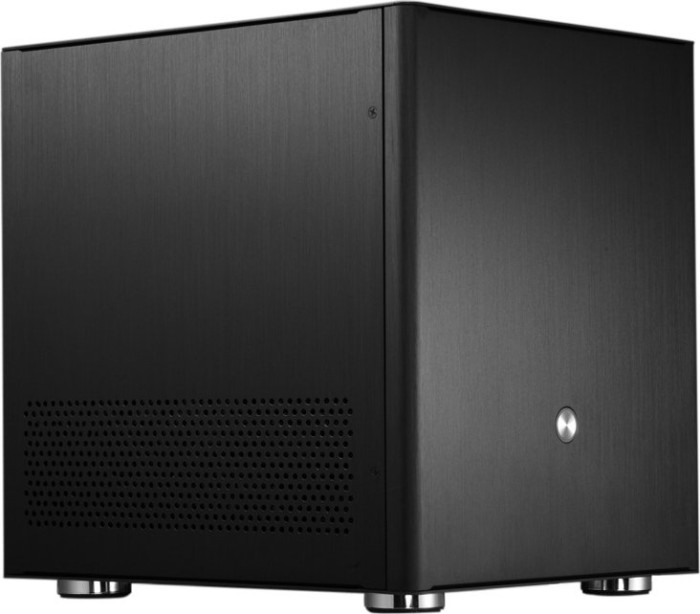

Mit 2011-3 wärst du mit yATX in einem dieser sub 20l Cases aber besser aufgehoben gewesen:Genau das wollte ich ja nicht mehr. Im ITX Faktor ist eben was spezielles.

. Mir ist das Build für ITX zu groß, ITX Boards sind imho eher für sub 10-15l Cases geeignet.

. Mir ist das Build für ITX zu groß, ITX Boards sind imho eher für sub 10-15l Cases geeignet.

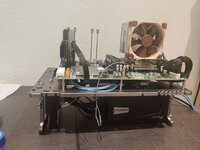

Bitteschön:

Bitteschön: Ist jetzt meine neue Testbench

Aber was bringt denn ne Gen4 NVMe, wenn der Server nur mit Gigabit angebunden ist.und trotzdem PCIe gen4. Daher kein LSI und auch keine 10G Karte drin.

Was sagt denn pveperf und mit sync disabled oder auf Standard.Die SN850 sind übrigens ziemlich gut Linux/BSD und damit "home ZFS"-tauglich bzgl. Durchsatz.