Am ehesten würden da 2 verschiedene Chips machen.

1. N21 = 80 CU + 16 GB HBM2 oder GDDR6 und 512-Bit SI.

2. N22 = 64 CU + 12 GB GDDR6 und 384-bit SI.

Ich erwarte nach wie vor kein 512Bit SI - mal gucken ob es doch kommt

Aktuell scheint sich zu bewahrheiten, dass die GPU ein GDDR6 und ein HBM Interface hat. Aber man munkelt, dass HBM nicht kommt. Vllt weil Profimarkt only oder für später oder whatever. Profimarkt only, quasi als Quadro Gegenspieler ergibt für mich durchaus Sinn in Szenarien, wo man entsprechend Szenarien hat, die nicht zwingend FP64 brauchen und mit niedrigerer Genauigkeit klar kommen, häufig skaliert der Spaß sehr gut auch über Bandbreite. Dann HBM drauf und ab dafür... Da spielt dann auch Geld eine eher untergeordnete Rolle bei den großen Modellen. Siehe auch NV mit 48GB und 24GB bei der Quadro Turing...

Das Ding ist, 512Bit SI, vllt niedriger getaktete Speicherchips hin oder her, säuft einfach Strom. Daran wird auch AMD nix ändern können. Und damit wäre Navi im Nachteil ggü. Turing, was irgendwie Aussage mit der Effizienz zumindest Steine in den Weg legt. Wahrscheinlicher wäre, das SI nicht unnötig aufzublähen. Die Speichermenge spielt dabei auch nicht sooo wirklich die entschiedende Rolle. Aber die Interfacebreite schon.

Ich denk allerdings, dass nach wie vor bei 12GB mit dem GDDR6 Interface Schluss ist. Oder halt 24GB.

Der Chip wird ziemlich sicher als N21 80 CUs haben. Zumindest deuten das die Leaks ganz klar an. Ob sie voll beschalten werden, abwarten... Denkbar wäre, 76 oder 72 CUs mit 384Bit SI für den Gamerbereich. Und 80 CU als FE mit HBM im Profibereich. Dann würde man sozusagen der Vega 20 folgen, die 60 anstatt 64 CUs aktiv hat. Die ist "nur" 330mm² groß ca. - N21 soll ja die 500 leicht knacken. Ob es stimmt, werden wir sehen, aber es wäre ein weiterer Indikator, dass nciht voll beschalten wird. Die Spekulationen zu 16GB schreibe ich aktuell eher dem HBM Unterbau zu. Denn das ergibt Sinn für mein Befürworten.

Meine Frage bleibt trotzdem, ob er das als hypothetisches Rechenbeispiel gemeint hat oder ob er tatsächlich davon ausgeht, dass BN die 2080 TI derart deutlich schlägt.

Das war im Bezug auf die Navi10 x2 Performance. Nach dem Computerbase UHD Perf. Index erreicht eine 5700XT mit doppelter Performance grob 30% mehr Leistung als eine 2080TI.

Rein rechnerisch passt das sehr gut zu den angekündigten +50% Effizienzsteigerung. Denn nimm die Leistungsaufnahme der Navi10 aus der 5700XT, rechne die Effizienz von 50% drauf und verdoppel die Leistung - und du landest bei ~280W. Über den Takt, Kühlung, Binning usw. lässt sich das dann noch bisschen hoch oder runter platzieren, wie die OEMs halt wollen bzw. wie es AMD zulässt. An deutlich über 300W glaube ich aktuell nicht. Weil das würde eben bedeuten, dass sie auch entsprechend mehr wie 50% Effizienz liefern müssten -> was sie nicht angekündigt haben. Vllt kommt es dennoch, weil man was gefunden hat - oder das wird so ein 300-350W Trümmer. Allerdings belegen sowohl Vega64 als auch die Radeon VII dass 300W und mehr bei AMD nicht in Leise gehen. Ich bin also der Meinung, wenn AMD dieses mal in einer derart komfortablen Position ist, dass sie den Takt nicht unbedingt auf Biegen und Brechen hoch rammeln müssen, weil ihnen gut 30% Performance fehlen zu Konkurrenz, wird man das auch nicht tun. Die negative Presse wäre unvermeidbar.

Auf der anderen Seite, Mr. Lederjacke lässt sich sicher nicht lumpen

Ich bin davon überzeugt, dass NV ihre Spitzenposition auf Biegen und Brechen wird versuchen einzuholen. Das macht es für AMD dann aber auch ein bisschen einfacher, vor allem, wenn NV obenraus auf die Effizienz pfeift.

Btw. ist das alles Spekulation, das möchte ich nochmal in aller Deutlichkeit anmerken

@fdsonne wenn Big N 30% schneller ist als die 2080ti und Ampere bis zu 40% schneller sein soll im angeblichen vollausbau bedeutet das für mich das BN entweder deutlich mehr IPC bekommen hat oder aber das BN ne schippe mehr takt hat als NV . weil AMD halt mit weniger shader nahezu mithält

Bei Taktgleichheit und annähernd 100% Skalierung bekommst du die ~30% über der 2080TI ja allein schon, wenn du Navi10 doppelst. Da sind wir noch bei unter 2GHz... Real wird das wahrscheinlich nicht 1:1 skalieren, allein, weil oben auch in UHD langsam aber sicher die CPU anfängt, ein Wörtchen mitzureden -> was blöderweise aber auch die Ergebnisse bisschen verfälscht. Aber gilt für beide Parteien. Also sei es drum.

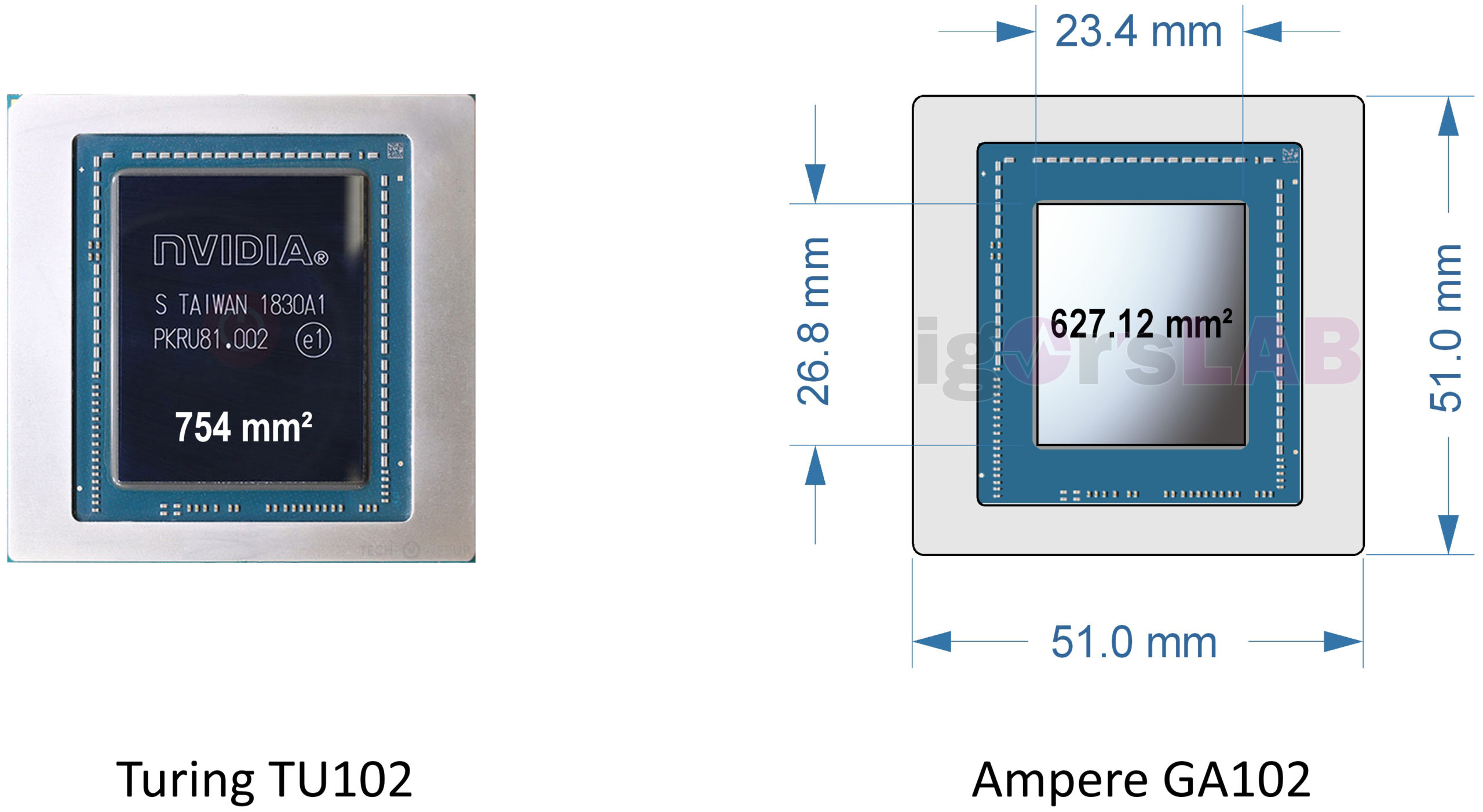

Die Frage ist halt, was macht NV? Ich bin nach wie vor unschlüssig, warum und wieso NV, die jetzt 2 Jahre Turing haben verwurstet ohne neuen Prozess, für so ne läppische Steigerung von 30% einen neuen Chip auflegen sollten!? Die 84 SMs, die man aktuell spekuliert, lieferten sie schon mit GV100. Da muss mMn mehr kommen und ich denke, irgend einen Haken gibt es da noch in der Spekulation. Rein rechnerisch kommt AMD auf die ~30% über der 2080TI, paar Prozent hoch, paar Prozent runter, eigentlich ohne Probleme, wenn man die 50%+ an Effizienz als Basis auf Navi10 drauf legt. Aber NV soll dann nur nen winzigen Sprung machen? Wohlwissentlich, dass sie seit effektiv 4 Jahren keinen Fortschritt mehr hatten in der Packdichte und mit Turing ein neues Maß an Die Size etabliert haben als TopDog?

Es kann halt sein, dass die Lederjacke Jensen Tantchen Lisa komplett unterschätzt... Aber mal ehrlich, ist das realistisch? Olle Jensen war immer für ne Überraschung gut. Und bis dato hat eigentlich jeder Release der letzten bestimmt 10 Jahre irgendwo überzeugt. Negative Ausnahme war die Holznummer mit Fermi. Von derartigen Problemen wie damals sind wir mMn aber heute weit weit entfernt.

www.pcgameshardware.de

www.pcgameshardware.de