Hallo zusammen,

ich suche nach einem etwas spezielleren Mainboard welches die folgenden Anforderungen abdeckt (Ziel ist ein relativ stromsparendes NAS System mit SAS HBA und Dual Port 10/25 NIC)

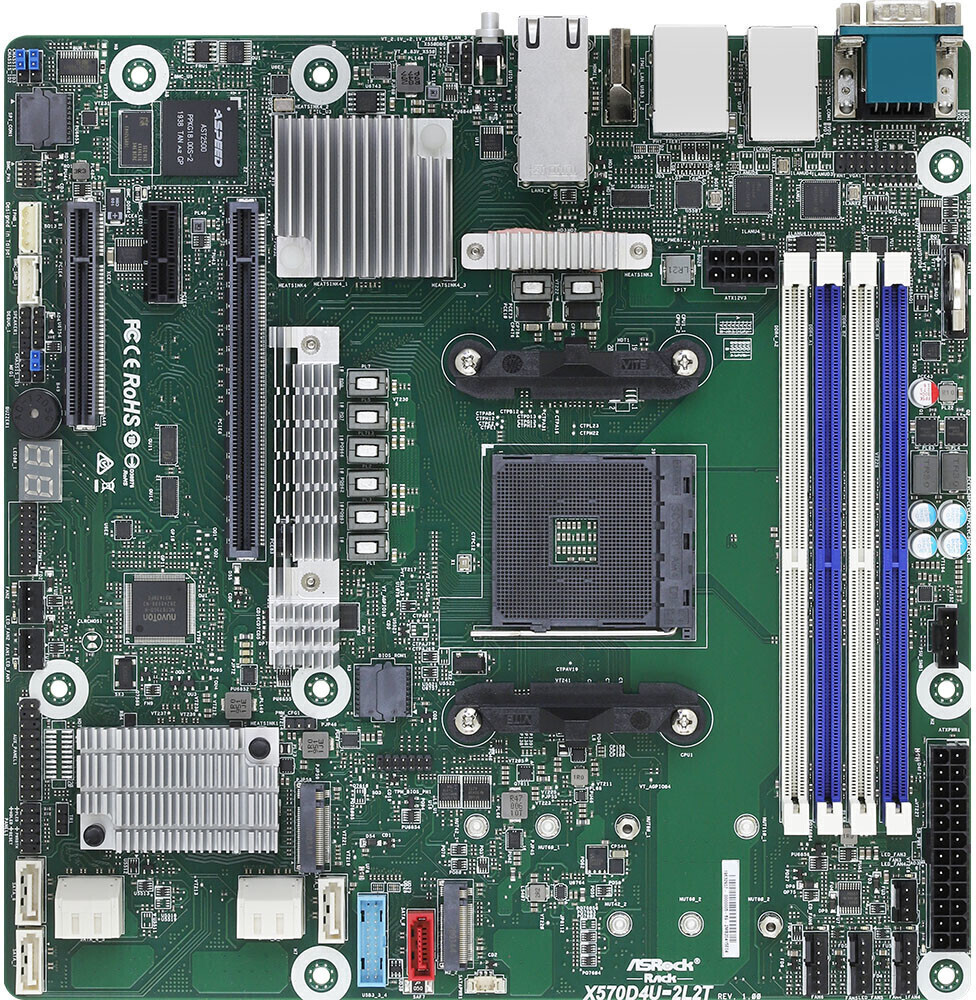

Gefunden habe ich eine Auswahl an X570 Boards (ASRock X570 Taichi oder MSI MEG X570 Unify), aber die sind alle super schwer zu bekommen... Falls jemand eine Idee hat würde ich mich sehr freuen.

ich suche nach einem etwas spezielleren Mainboard welches die folgenden Anforderungen abdeckt (Ziel ist ein relativ stromsparendes NAS System mit SAS HBA und Dual Port 10/25 NIC)

- Unterstützung für zwei PCIe 3.0 Karten, x8 mechanisch und elektrisch

- ein SAS HBA PCIe 3.0 x8

- ein Dual Port NIC, beispielsweise Intel X710, ebenfalls PCIe 3.0 x8

- Unterstützung für 2 NVMe PCIe Disks für Boot, Anbindung / Speed eigentlich egal

- GPU sollte idealerweise in CPU integriert sein

Gefunden habe ich eine Auswahl an X570 Boards (ASRock X570 Taichi oder MSI MEG X570 Unify), aber die sind alle super schwer zu bekommen... Falls jemand eine Idee hat würde ich mich sehr freuen.