Luckysh0t

Enthusiast

Privat wie auch beruflich checkmk, wenn auch beruflich keine PVE, sondern eine VMWare Umgebung.

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Nööö, sources list nicht okay. Mittlerweile ist alles ziemlich zerfummelt, da ich verschiedenste Dinge auspürobiert habe. Werde glaube ich neuinstallieren, hilft mir nur nicht beim großen... doof. Sehr unbefriedigend...sources.list ist ok?

dann "apt dist-upgrade" drüber jucken.

Ansonsten, für vorsichtige, kannst auch ein "apt install <liste der zurückgehaltenen pakete>" machen, das ist die minimalinvasive Methode.

Ich habe das mir über Homarr zusammengebaut (offizielle Doku über Homarr). Über Tablet/Smarphone reicht mir die native Proxmox App. Ist alles nur "Homelab" und mehr als eine E-Mail wenn was ausfällt reicht mir. Per VPN notfalls auf den Proxmox und Service neustarten oder schauen was los ist.Was nutzt ihr eigentlich zum Monitoring euer Proxmoxumgebung, der Gäste sowie andere externe HW-Komponenten um die verfügbarkeit von Services zu überwachen und über volle Festplatten/Mountpoints informiert zu werden?

Ich habe derzeit eine Icinga2 Instanz im Einsatz, die ich gerne druch was einfacherers Ablösen würde. Zusätzlich erfasse ich Performancedaten über Prometheus mit Anzeige im Grafana.

Anforderung wären Benachrichtigungen über voll werdene Disks und bei Ausfall von Services über Mail.

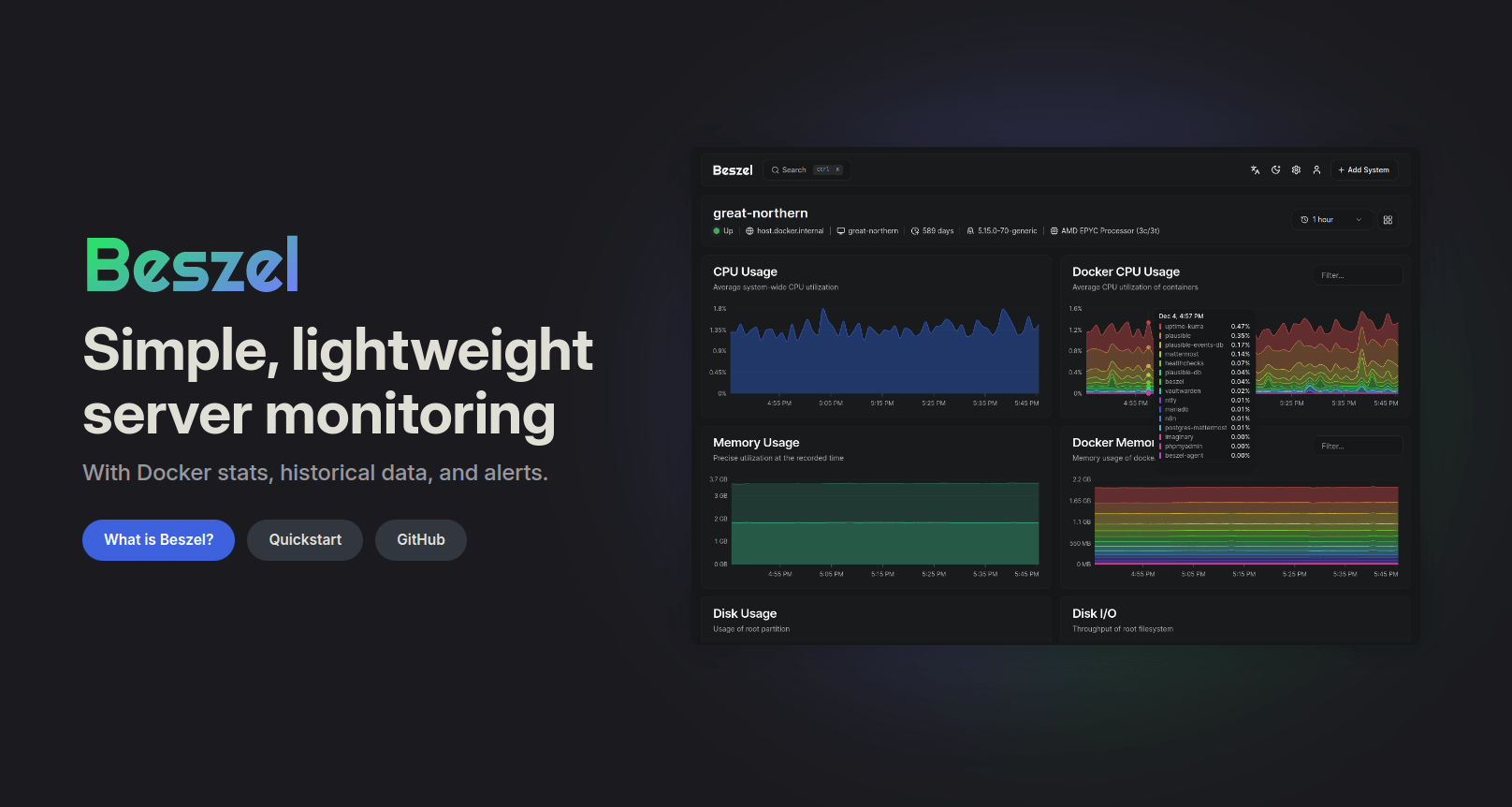

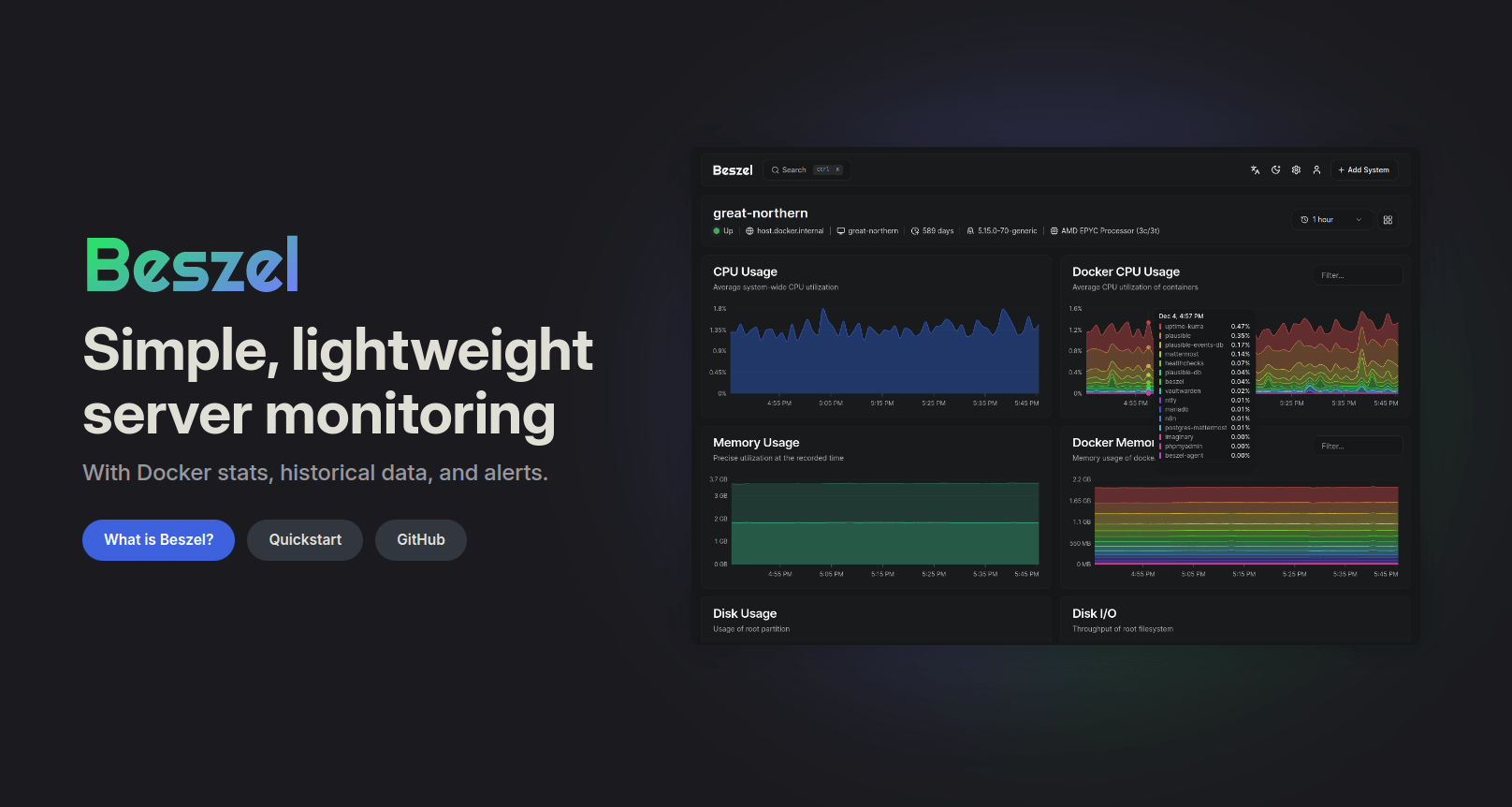

Cool. das muss ich auch ausprobieren.Moin, alles kannst du damit nicht abdecken aber Beszel ist ein guter Anfang

Beszel | Simple, lightweight server monitoring

Lightweight server monitoring with historical data, Docker stats, and alerts.beszel.dev

Nett, man kann auch seinen HA anbinden, na das kommt mal auf die Liste ^^Ich habe das mir über Homarr zusammengebaut

Hi Benny, ich kann Dir zumindest sagen was mir geholfen hatte. Nimm ein Server-OS an sich um anzufangen und die wichtigsten Befehle und Hürden zu kennen. Lass die Helper-Scripts, da lernst Du nicht viel. Die kann Du verwenden wenn Du weißt was Du ungefähr machst oder nachzulesen wie es umgesetzt wurde. Installiere Dir einen Samba Server (den braucht man eigentlich immer mal), verstehe die wichtigsten Befehle und gehe dann ein bestimmtes Projekt an. Nur so verstehst Du auch im Desasterfall was Du machen musst. Man lernt auch schnell das man mit Docker und Docker-Compose manchmal schneller einen Dienst hochfahren kann als man ein Script gefunden hat....

Ich stelle mir nun die blöde Frage, was kann ich noch mehr oder weniger Sinnvolles mit dem Elitedesk anstellen.

Was waren so zu beginn eure Do-s und vorallem Dont's?

Freu mich zu hören, Benny!

Das weiß ich nicht mehr... 🫨 Aber was ich jetzt immer mache (PVE läuft bei mir auf NAS-Hardware):Was waren so zu Beginn eure Do-s

Bei mir hat jedes "richtige" ZFS vor allem ein Special VDEV auf SSD.M2A_CPU: Optane P1600X (SLOG Mirror)

M2B_SB: Optane P1600X (SLOG Mirror)

M2D_SB: Optane P1600X (L2ARC)

Also ich nutze sync writes auf meinem PVE. Als SLOG nutze ich eine Optane P1600X. Als weiteres Schutzelement für das gesamte System. In meinem begrenzten Umfeld daheim, habe ich damit keine Nachteile.Und SLOG... niemand im HomeLab macht doch synchronous writes?

Bei mir hat jedes "richtige" ZFS vor allem ein Special VDEV auf SSD.

Statt L2Arc lieber RAM.

Und SLOG... niemand im HomeLab macht doch synchronous writes? Das machen wir ja noch nicht mal in der Firma; oder sonst irgendwer, der sich auf smb/cifs verlässt.

NFS hat defaultmässig sync, aber wer das nicht auf async stellt, dem scheint es nichts asuzumachen, Lebenszeit mit Warten zu verbringen.Spaß macht das jedenfalls nicht.

Das setzt ja voraus, jemand weiß, was in der VM passiert bzw. kann dort sync writes in seinen Apps einstellen. In 99+% der Fälle ist ja async der default.Slog mit sync für VMs unter Proxmox macht schon Sinn. ZFS garantiert mit CoW lediglich die eigene Unversehrtheit, nicht jedoch die Unversehrtheit für VM Dateisysteme.

Kann grad nicht beurteilen, wie ernst das gemeint ist. Aber nehmen wir es mal so, dann bedeutet das ja genau, was ich schrieb: Fehler sind so extrem unwahrscheinlich... also m.E. vernachlässigbar.Zieht man den Strecker beim Schreiben einer VM hundertmal oder wartet bei viel RAM ohne ECC ein Jahr, so hat man mit hoher Wahrscheinlichkeit eine Problem Ereignis.

Kann grad nicht beurteilen, wie ernst das gemeint ist. Aber nehmen wir es mal so, dann bedeutet das ja genau, was ich schrieb: Fehler sind so extrem unwahrscheinlich... also m.E. vernachlässigbar.

Mit async schreibt mein PVE locker mit 600+ MB/s in den PBS. Mit sync erreicht der noch nicht mal 1/10 davon. Ich kann mir nicht vorstellen, daß dieser (für mich unerträgliche) Nachteil durch noch so teure oder aufwendige SLOG-Lösungen auch nur annähernd ausgeglichen wird. 🤷♂️ Schon allein bei der geringen Größe z.B. der Optanes kann es ja niemals hinhauen, daß sie diese Datenmengen speichern können.

ZFS schreibt grundsätzlich immer alles async per RAM Schreibcache. Aktiviert man sync so wird zusätzlich jedes commit im Slog protokolliert. Im Endeffekt wird alles zweimal geshrieben, einmal als große Blöcke in recsize auf den Pool und einmal als kleiner Block je nachdem auf das ZIL oder Slog Protokoll.Oder denk ich da jetzt was falsch?Also wenn der Pool (wie bei mir) mit sync gerade mal 40-50 MB/s entgegennimmt, dann wäre eine 118 GB Optane nur für sehr sehr kleine Transfers nützlich. Also ja, ein PVE mit VMs im fast Idle-Betrieb vielleicht.

TrueNAS ScaleWas für ein BS in der VM willst insten?

Reichst du ne Graka durch?

Was ist die maximale Geschwindigkeit einer unbeladenen Schwalbe?